Windows下安装Spark

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Windows下安装Spark相关的知识,希望对你有一定的参考价值。

1. 安装Scala, 下载链接 https://downloads.lightbend.com/scala/2.12.3/scala-2.12.3.msi

创建系统变量 SCALA_HOME为C:\\Program Files (x86)\\scala, 然后添加%SCALA_HOME%\\bin到系统PATH变量中

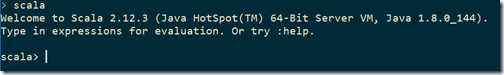

然后打开cmd窗口,运行scala,你应该看到如下信息

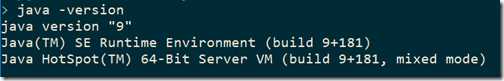

2. 安装JDK,下载链接,http://www.oracle.com/technetwork/java/javase/downloads/index.html, spark2.2要求jdk8,所以下载

Java SE 8u144

创建系统变量JAVA_HOME为C:\\Program Files\\Java\\jdk1.8.0_144, 然后添加%JAVA_HOME%\\bin到系统PATH变量中

创建系统变量CLASSPATH,内容为%JAVA_HOMT%\\lib;%JAVA_HOMT%\\lib\\tools.jar;

打开cmd窗口,输入 java -version,

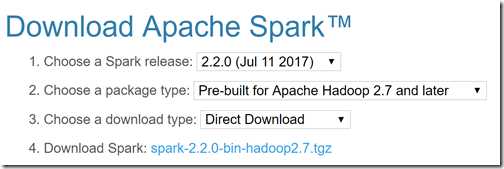

3. 安装spark, 下载链接 http://spark.apache.org/downloads.html

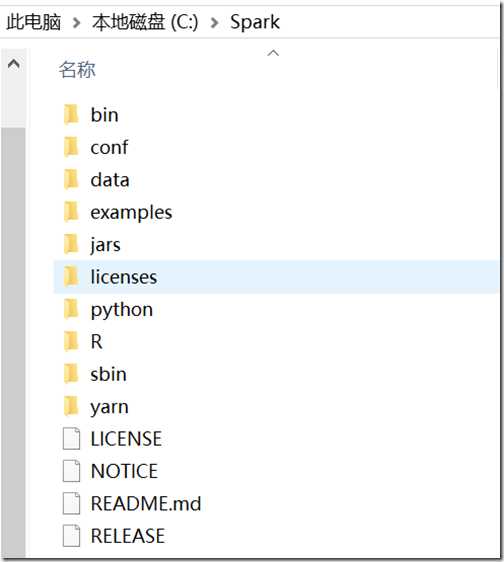

点击第4步的链接下载,之后把里面的内容解压缩到C:\\Spark文件夹中,

创建系统变量SPARK_HOME,内容为C:\\Spark\\bin,添加%SPARK_HOME% 和 %SPARK_HOME%\\sbin到系统变量PATH中

4. 安装hadoop winutils,下载链接https://github.com/steveloughran/winutils, 选择你要的hadoop版本号,比如2.8.1,你只需要下载winutils.exe,然后拷贝到C:\\Hadoop\\bin文件夹中。

创建系统变量HADOOP_HOME,为C:\\Hadoop,添加%HADOOP_HOME%\\bin到PATH变量中

5. 以管理员身份打开cmd,运行spark-shell,如果遇到访问权限等错误的话,运行 winutils.exe chmod 777 –R C:\\tmp\\hive

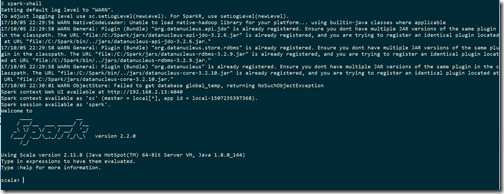

6. 以管理员身份打开cmd,运行spark-shell,你应该看到如下界面

最重要的,你要看到Spark context available as ‘sc‘ (master = local[*], app id = local-1507235397368).字样

7. spark hello world example

在Scala>提示符后依次输入运行

val textFile = sc.textFile(file:///Spark/README.md)

val tokenizedFileData = textFile.flatMap(line=>line.split(" "))

val countPrep = tokenizedFileData.map(word=>(word,1))

val counts = countPrep.reduceByKey((accumValue, newValue)=>accumValue+newValue)

var sortedCounts = counts.sortBy(kvPair=>kvPair._2,false)

sortedCounts.saveAsTextFile(file:///OutputData/ReadMeWordCount)

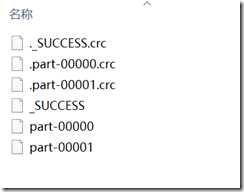

打开C盘,你应该看到OutputData文件夹,里面有ReadMeWordCount文件夹,里面的内容为

查看文件part-00000和part-00001,里面就是各个单词在README.md文件中出现的次数。

以上是关于Windows下安装Spark的主要内容,如果未能解决你的问题,请参考以下文章

Windows环境下在IDEA编辑器中spark开发安装步骤

Windows 下 Spark+Hadoop+Scala 安装