Windows 下 Spark+Hadoop+Scala 安装

Posted OkidoGreen

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Windows 下 Spark+Hadoop+Scala 安装相关的知识,希望对你有一定的参考价值。

整体流程可参考,但文中的版本较低

Spark学习笔记--Spark在Windows下的环境搭建 - 法号阿兴 - 博客园 (cnblogs.com) https://www.cnblogs.com/xuliangxing/p/7279662.html首先需要对应好 三者的版本,本文安装的版本如下

https://www.cnblogs.com/xuliangxing/p/7279662.html首先需要对应好 三者的版本,本文安装的版本如下

Spark

版本:spark-3.1.2-bin-hadoop3.2.tgz

链接:Apache Downloads https://www.apache.org/dyn/closer.lua/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz原因:尝试安装3.2.0,发现spark-shell启动后会报错,可参考:Spark安装问题:ERROR SparkContext: Error initializing SparkContext. java.lang.reflect.InvocationTargetException - codedogzlc - 博客园 (cnblogs.com)

https://www.apache.org/dyn/closer.lua/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz原因:尝试安装3.2.0,发现spark-shell启动后会报错,可参考:Spark安装问题:ERROR SparkContext: Error initializing SparkContext. java.lang.reflect.InvocationTargetException - codedogzlc - 博客园 (cnblogs.com) https://www.cnblogs.com/codedogzlc/p/15432124.html

https://www.cnblogs.com/codedogzlc/p/15432124.html

Hadoop

版本:hadoop-3.2.0.tar.gz

原因:与 Spark 版本后匹配的 Hadoop版本一致

1、hadoop单独启动时招不到JAVA_HOME,参考

(472条消息) Hadoop 找不到 JAVA_HOME 环境变量无法启动问题解决_z69183787的专栏-CSDN博客 https://blog.csdn.net/z69183787/article/details/1217921122、其中 Windows 中需要安装 winutils.exe文件,版本需与hadoop版本一一对应,可参考

https://blog.csdn.net/z69183787/article/details/1217921122、其中 Windows 中需要安装 winutils.exe文件,版本需与hadoop版本一一对应,可参考

github下载:

(471条消息) Hadoop3.2.1、Hadoop3.2.0还有之前的版本的winutils.exe和hadoop.dll_九天安属的博客-CSDN博客_hadoop3.2.2 winutils https://blog.csdn.net/qq_39238947/article/details/105382308hadoop本机运行 解决winutils.exe的问题 - 我的肉夹馍啊 - 博客园 (cnblogs.com)

https://blog.csdn.net/qq_39238947/article/details/105382308hadoop本机运行 解决winutils.exe的问题 - 我的肉夹馍啊 - 博客园 (cnblogs.com) https://www.cnblogs.com/roujiamo/p/10053674.html

https://www.cnblogs.com/roujiamo/p/10053674.html

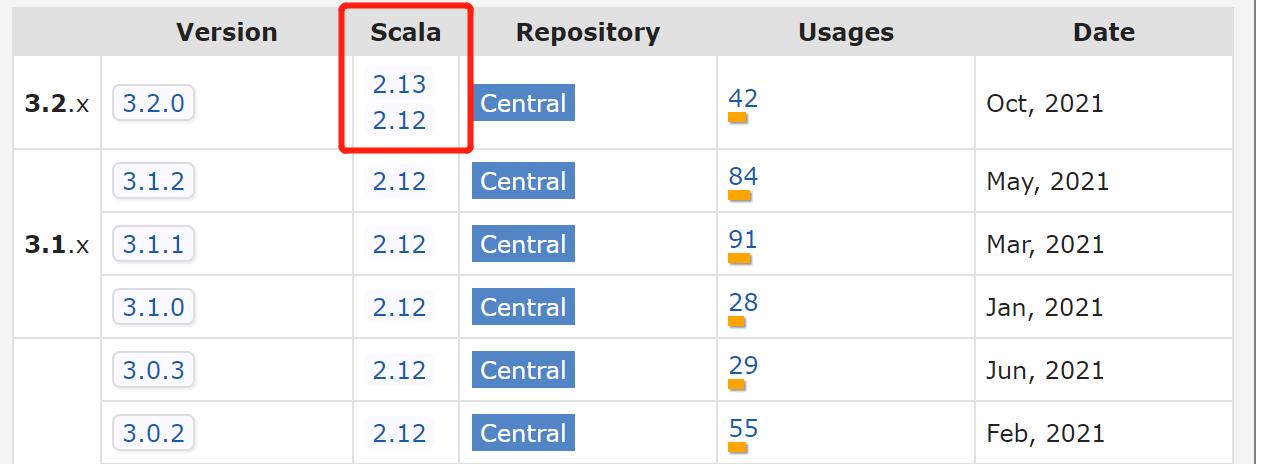

Scala

版本:2.12.0

原因:mvn仓库中会告知对应 Spark 版本 需要安装的 Scala 版本

实战

运行example项目,单机下命令如下:

spark-submit --class org.apache.spark.examples.JavaSparkPi --master local[*] C:\\Users\\zhoushun\\Desktop\\Spark\\examples\\jars\\spark-examples_2.12-3.1.2.jar

以上是关于Windows 下 Spark+Hadoop+Scala 安装的主要内容,如果未能解决你的问题,请参考以下文章

我可以在本地机器上的 python 上运行 spark 命令到 hadoop 吗?