Windows下安装Spark环境

Posted eng1ne-ty

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Windows下安装Spark环境相关的知识,希望对你有一定的参考价值。

根据博客总结 https://blog.csdn.net/nxw_tsp/article/details/78281533

需要的安装软件可以在网盘下载:

链接:https://pan.baidu.com/s/1BgtNERopcxUf7DwiultMnw

提取码:nvnv

一、安装Scala

下载地址:http://www.scala-lang.org/download/all.html

进入页面后选择一个Scala版本进行下载,我选择的是Scala2.12.0版本。特别注意的是看帖子又的说Scala版本与Spark版本之间是有一定关联的,比如说你的Scala版本是2.12.0,那么就应该下载Spark版本为从1.3.0到Spark 1.6.2之间的各个版本。这种说法不知道准不准确,但是还是注意一下比较好。

Scala安装好之后呢,它会自动在环境变量PATH里面配置。我们不需要进行手动配置了。下面就打开cmd输入Scala看下安装后控制台的输出效果。

如果出现一下信息,那么就证明Scala已经安装成功了。

需要注意的是:如果在控制台输入scala之后输出没有出现版本信息,那么就需要你手动替换掉安装Scala时自动配置的变量。

既然Scala已经安装成功了, 那么我们就可以继续安装我们的主角Spark了

二、安装Spark

同样的我会附上Spark下载地址:http://spark.apache.org/downloads.html

那么,当我们下载好之后,Spark是不需要进行安装的,直接解压到Spark目录,然后配置一下Path环境变量就可以了

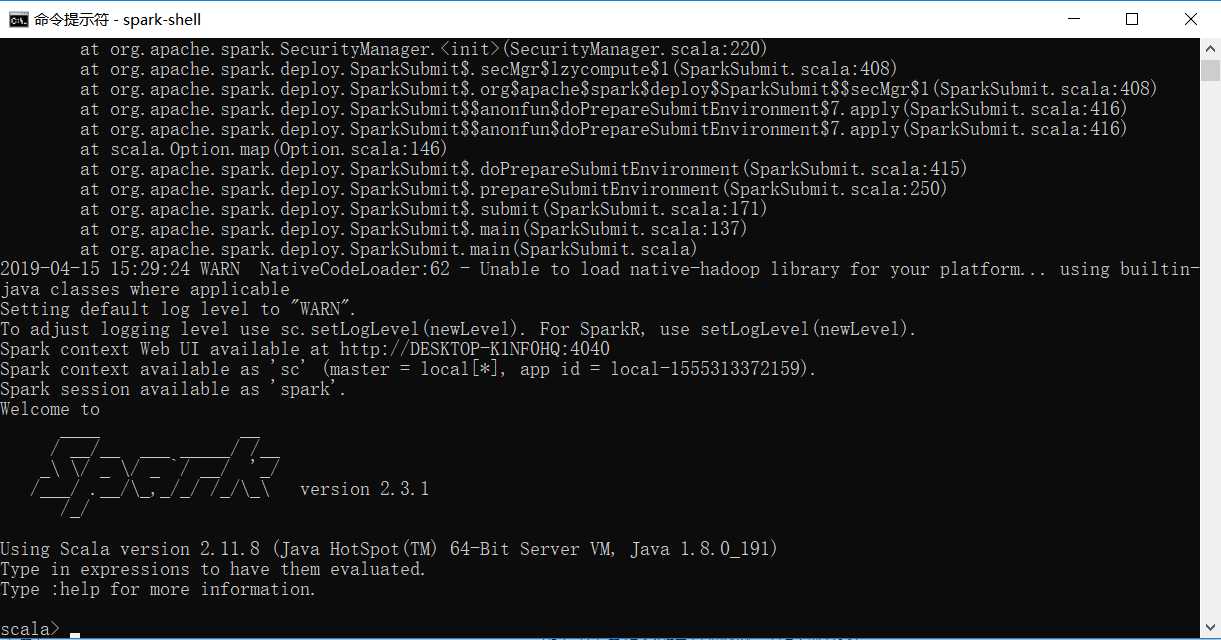

下面我们来验证一下看spark是否能正常启动。

在控制台输入一下命令:spark-shell

注意spark-shell之间是没有空格的,千万不要输错了。

情况看图片

如果你看到上图,那么,恭喜您,spark已经安装成功了!

以上是关于Windows下安装Spark环境的主要内容,如果未能解决你的问题,请参考以下文章