归一化指数函数:softmax loss function

Posted shiliuxinya

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了归一化指数函数:softmax loss function相关的知识,希望对你有一定的参考价值。

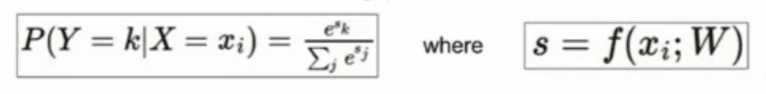

1. softmax 损失函数:归一化指数函数,可以将一个K维向量z“压缩”到另一个K维实向量σ(z)中,使每一个元素的范围在(0,1)之间,并且所有元素的和为1。

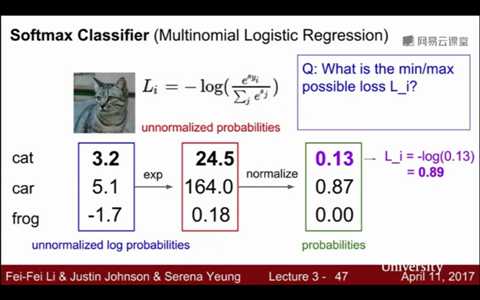

softmax loss包含三个部分:指数化、归一化、取-log(x)

①指数化:是指将一个样本中各个分类的得分指数化,使得各分类的得分都大于等于0,也就是将每个分数x变为e^x,而e^x函数大于0,即保证了非负性

②归一化:计算指数化后的各个分类的得分在所有分类的得分总和中所占的比例,所以最后得到的是一个分类的分数在总的得分中的比例 / 概率,所以每个元素都在(0,1)之间,各个元素之和为1 (就是把所有分类的得分相加得到S,然后计算各个分类的分数比上S)

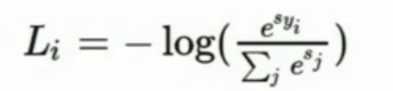

③取-log(x):将归一化得到的概率x,通过对数函数取负得到损失值Li

(为什么用对数函数+取负的方式?因为logx单调递增且x>0,然后我们又希望损失值减小,然后取负,单调递减)

指数化得到e^x;归一化得到概率;取-log(x)得到损失值Li

指数归一化:

-log(x):

![]()

样本损失值 Li:

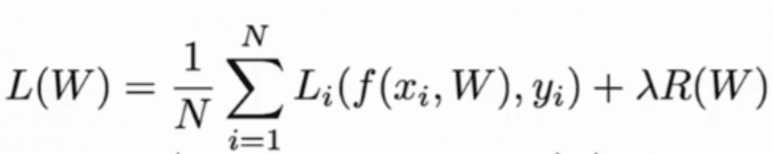

总体损失值 L:

2. 例子

注意:这里处理的是样本中的每一个数据,而不只是真实分类的数据或其他分类的

以上是关于归一化指数函数:softmax loss function的主要内容,如果未能解决你的问题,请参考以下文章