OpenPAI:大规模人工智能集群管理平台介绍及任务提交指南

Posted xyniu

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了OpenPAI:大规模人工智能集群管理平台介绍及任务提交指南相关的知识,希望对你有一定的参考价值。

产品渊源:

随着人工智能技术的快速发展,各种深度学习框架层出不穷,为了提高效率,更好地让人工智能快速落地,很多企业都很关注深度学习训练的平台化问题。例如,如何提升GPU等硬件资源的利用率?如何节省硬件投入成本?如何支持算法工程师更方便的应用各类深度学习技术,从繁杂的环境运维等工作中解脱出来?等等。

产品定位:

为深度学习提供一个深度定制和优化的人工智能集群管理平台,让人工智能堆栈变得简单、快速、可扩展。

产品优势:

● 为深度学习量身定做,可扩展支撑更多AI和大数据框架

通过创新的PAI运行环境支持,几乎所有深度学习框架如CNTK、TensorFlow、PyTorch等无需修改即可运行;其基于Docker的架构则让用户可以方便地扩展更多AI与大数据框架。

● 容器与微服务化,让AI流水线实现DevOps

OpenPAI 100%基于微服务架构,让AI平台以及开发便于实现DevOps的开发运维模式。

● 支持GPU多租,可统筹集群资源调度与服务管理能力

在深度学习负载下,GPU逐渐成为资源调度的一等公民,OpenPAI提供了针对GPU优化的调度算法,丰富的端口管理,支持Virtual Cluster多租机制,可通过Launcher Server为服务作业的运行保驾护航。

● 提供丰富的运营、监控、调试功能,降低运维复杂度

PAI为运营人员提供了硬件、服务、作业的多级监控,同时开发者还可以通过日志、SSH等方便调试作业。

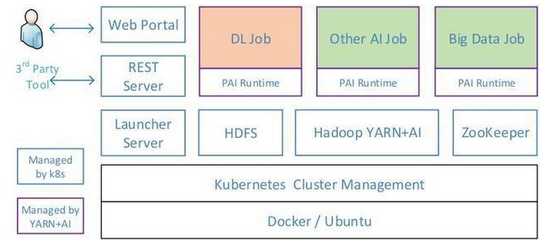

OpenPAI的架构如下图所示,用户通过Web Portal调用REST Server的API提交作业(Job)和监控集群,其它第三方工具也可通过该API进行任务管理。随后Web Portal与Launcher交互,以执行各种作业,再由Launcher Server处理作业请求并将其提交至Hadoop YARN进行资源分配与调度。可以看到,OpenPAI给YARN添加了GPU支持,使其能将GPU作为可计算资源调度,助力深度学习。其中,YARN负责作业的管理,其它静态资源(下图蓝色方框所示)则由Kubernetes进行管理。

提交作业:Web Portal

交互中间件:Launcher

作业、资源管理:Hadoop YARN

静态资源管理:Kubernetes

任务提交指南

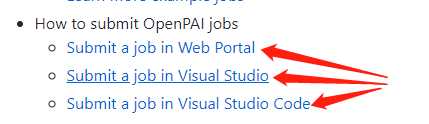

提交任务的方式主要有三种,但对于centos系统只有web端的提交形式

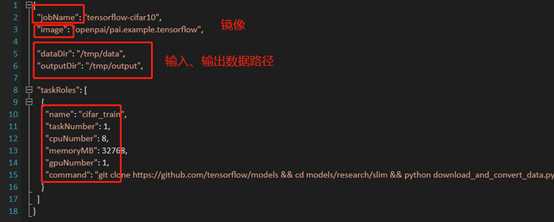

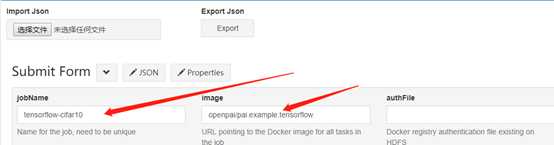

在web端通过json配置文件的形式进行job提交

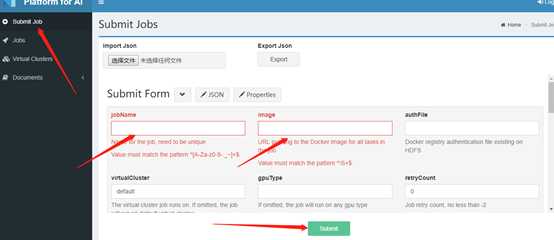

配置文件编辑完成后,进行配置文件上传

配置文件上传后,相关配置在web端显示

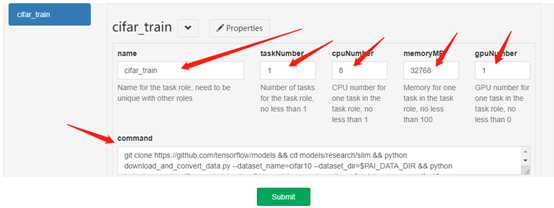

任务提交

确认信息无误后,点击Submit,完成任务提交

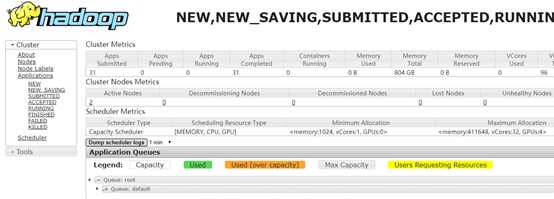

Hadoop yarn进行任务调度

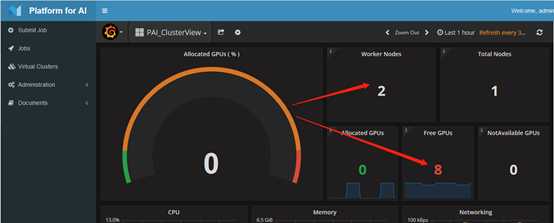

集群现状:

以上是关于OpenPAI:大规模人工智能集群管理平台介绍及任务提交指南的主要内容,如果未能解决你的问题,请参考以下文章