论文泛读165量化 NLP 中的可解释性和分析性能-可解释性权衡的算法

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读165量化 NLP 中的可解释性和分析性能-可解释性权衡的算法相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

论文链接:《Quantifying Explainability in NLP and Analyzing Algorithms for Performance-Explainability Tradeoff》

一、摘要

医疗保健领域是机器学习最令人兴奋的应用领域之一,但缺乏模型透明度导致行业内采用滞后。在这项工作中,我们使用 MIMIC-III 临床笔记中的死亡率预测任务,探索了临床文本分类案例研究中当前的可解释性和可解释性艺术。我们展示了用于完全可解释的方法以及与模型无关的事后归因的各种可视化技术,并且我们提供了一种通用的方法来评估使用不忠和局部 Lipschitz 跨模型类型(从逻辑回归到 BERT 变体)的解释质量。通过这些指标,我们引入了一个框架,通过该框架,从业者和研究人员可以评估模型之间的边界” s 预测性能及其可用解释的质量。我们提供代码以鼓励对这些方法的持续改进。

二、结论

在这项工作中,我们在临床文本分类的案例研究中探索了可解释和可解释的最大似然方法的实际方面。我们展示了一些可供医疗保健NLP从业者使用的可解释性工具,讨论了可解释性和可解释性的现有定义,并引入了一个框架,该框架可以跨文本分类模型评估解释的质量,包括所呈现属性的不真实性和相对敏感性。我们表明,该评估框架可以与首选模型评估指标结合使用,以提供一个帕累托前沿,说明模型测试集性能和可用解释方法质量之间的权衡。对于许多领域的从业者来说,这可能是一个非常有用的工具,包括医疗保健,在医疗保健中,数据科学家的任务是基于期望的人类可解释性水平来构建和识别最佳模型,这种可解释性水平因问题而异。它对AutoML解决方案的开发人员也很有用——引入解释质量的量化指标,除了原始模型性能之外,还提供了联合优化这些指标的机会。

我们表明,可解释的最大似然技术虽然具有可解释的特性,但其性能并不理想,通常不用于文本分类。在某些情况下,出于完全模型可解释性的目的,模型质量的恶化是可以接受的,尽管用于产生稀疏模型的其他方法(例如LASSO回归)可能提供更好的性能。通过莱姆、SHAP和真正的局部解释之间的直接比较,我们表明莱姆在这种高维任务上有所欠缺,稀疏的属性不一定反映模型的真正底层行为。我们还展示了当前在可视化BERT风格模型的底层行为方面的工作,这些工作试图为这些黑盒模型建立一种可解释的感觉。

三、框架

几个具有不同复杂程度和可解释性的分类器:

- 逻辑回归 Logistic Regression (LR)

- 随机森林 Random Forest (RF)

- DL8.5

- 增强规则集 Boosted Rule Sets

- 贝叶斯规则列表 Bayesian Rule Lists

- 最优分类树 Optimal Classification Trees

- CORELS

- BigBird

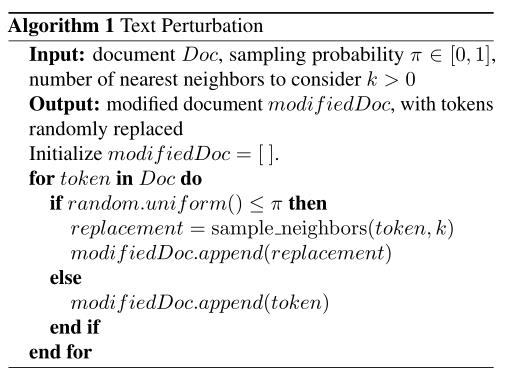

Text Perturbation 算法:

以上是关于论文泛读165量化 NLP 中的可解释性和分析性能-可解释性权衡的算法的主要内容,如果未能解决你的问题,请参考以下文章

论文泛读186QA 数据集爆炸:用于问答和阅读理解的 NLP 资源分类

论文泛读186QA 数据集爆炸:用于问答和阅读理解的 NLP 资源分类

论文泛读167使用 BERT 语言模型的大规模新闻分类:Spark NLP 方法