论文泛读87自解释卷积神经网络的文本分类

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读87自解释卷积神经网络的文本分类相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

论文链接:《Self-interpretable Convolutional Neural Networks for Text Classification》

一、摘要

用于自然语言处理(NLP)的深度学习模型本质上是复杂的,并且在自然界中通常被视为黑匣子。本文通过利用ReLU-DNN中固有的局部线性模型,开发了一种用于解释卷积神经网络的文本分类问题的方法。CNN模型结合了通过卷积层嵌入单词的功能,使用最大池对它们进行过滤,并使用ReLU-DNN进行优化以进行分类。为了获得整体可解释的模型,来自ReLU DNN的局部线性模型系统通过最大池过滤器映射回适当的n-gram。我们在实验数据集上的结果表明,我们提出的技术可生成可自我解释的简约模型,并且与更复杂的CNN模型相比,它们具有可比的性能。

二、结论

本文提出了一种基于卷积神经网络建立简化的自解释非线性规划模型的新技术。该技术包括三个基本步骤:模型建立、模型简化和模型解释。所提出的方法产生了一个模型,该模型实现了与其他复杂模型相似的性能,并且具有更好的质量和更容易的解释。通过实验研究,比较了特征工程层和ReLU DNN层对模型性能的影响。此外,我们评估了L1正则化对模型性能和模型解释复杂性的影响。我们引入了在Aletheia中使用合并算法来进一步简化CNN的分类器层。最后,我们获得了按区域排列的最重要的过滤器,并通过检查该区域内样本的过滤器n-grams为模型提供了解释。通过对前正后反实例的分析,给出了基于合并模型的解释。通过使用Yelp数据集的模型简化实验的一个重要发现是,具有简单逻辑分类器的CNN文本分类模型对于该特定数据集表现良好。

三、model

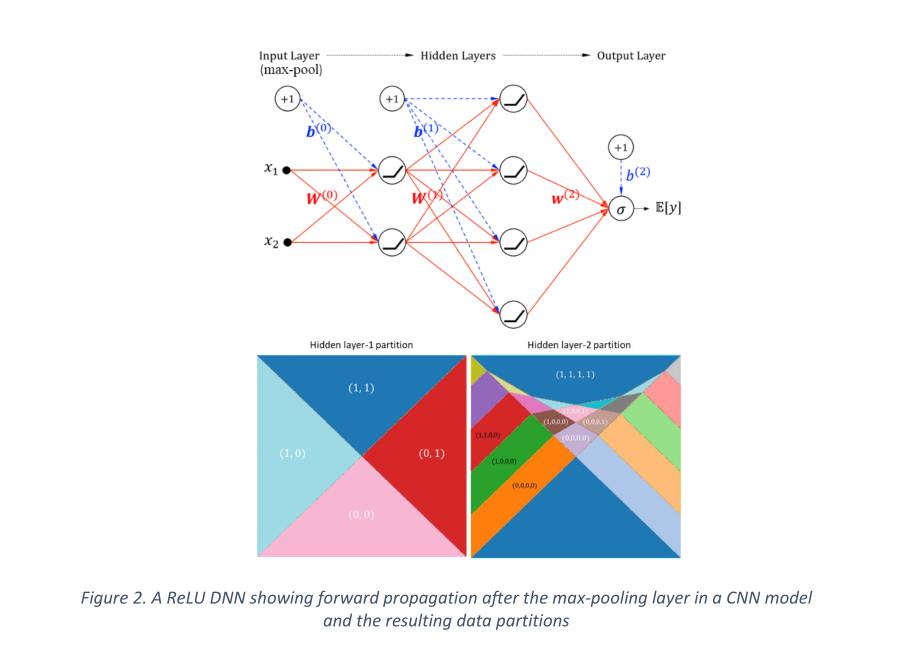

提出了一种新的技术来开发基于自解释卷积神经网络的文本分类模型。所提出的方法由卷积滤波器和ReLU DNN分类器组成。我们使用图2。显示了在CNN模型中最大汇集层之后的前向传播的ReLU DNN,以及在ReLU DNN上6个L1/L2正则化分区的结果数据,以简化模型,同时保持可比的模型性能。然后,我们将阿列西亚(Sudjianto,Knauth,Singh,Yang,and Zhang,2020)应用于ReLU层,并为提取的特征提供解释,这些特征可以映射到输入文本中的n-grams。

滤波器:卷积层+激活函数+最大池层

滤波器大小:1D卷积的内核大小,它直接决定了馈入滤波器的ngrams的大小。

提取的特征:最大池层输出。

特征工程层:产生可解释文本特征的卷积层。

ReLU分类器:通过ReLU激活在最大池层输出上构建的前馈层。

对CNN这块也不是特别感兴趣,如果后面对文本分类这一块有兴趣的话,倒是可以翻一翻这篇文章,看看对应的实现。

以上是关于论文泛读87自解释卷积神经网络的文本分类的主要内容,如果未能解决你的问题,请参考以下文章