2023-Pytorch-检测教程手把手教你使用YOLOV5做电线绝缘子缺陷检测

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了2023-Pytorch-检测教程手把手教你使用YOLOV5做电线绝缘子缺陷检测相关的知识,希望对你有一定的参考价值。

随着社会和经济的持续发展,电力系统的投资与建设也日益加速。在电力系统中,输电线路作为电能传输的载体,是最为关键的环节之一。而绝缘子作为输电环节中的重要设备,在支撑固定导线,保障绝缘距离的方面有着重要作用。大多数高压输电线路主要架设在非城市内地区,绝缘子在输电线路中由于数量众多、跨区分布,且长期暴露在空气中,受恶劣自然环境的影响,十分容易发生故障。随着大量输电工程的快速建设,传统依靠人工巡检的模式,已经越来越难以适应高质量运维的要求。随着国网公司智能化要求的提升,无人机技术的快速应用,采取无人机智能化巡视,能够大幅度减少运维人员及时间,提升质量,因此得到快速发展。

深度学习技术的大量应用,计算机运算性能的不断提高,为无人机准确识别和定位绝缘子,实时跟踪拍摄开辟了新的解决途径。本文对输电线路中绝缘子进行识别及定位,利用深度学习技术采取基于YOLOv5 算法的目标检测手段,结合绝缘子数据集的特点,对无人机拍摄图片进行训练,实现对绝缘子精准识别和定位,大幅提升无人机巡检时对绝缘子设备准确跟踪、判定的效率,具有十分重要的应用效果。

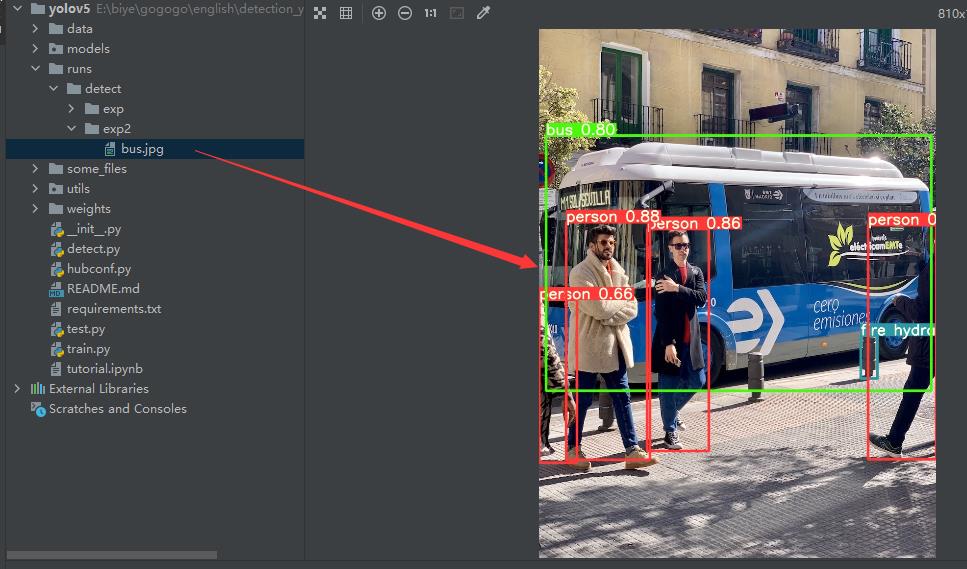

废话不多说,咱们先看两张实际效果。

注意事项

- 尽量使用英文路径,避免中文路径,中文路径可能会导致代码安装错误和图片读取错误。

- pycharm运行代码一定要注意左下角是否在虚拟环境中。

- 库的版本很重要,使用本教程提供的代码将会事半功倍

前期准备

电脑设置

大部分小伙伴使用的电脑一般都是windows系统,在windows系统下跑代码,难免会遇到各种各样的bug,首先是编码问题,为了防止代码在运行过程中,出现编码错误,我们首先要将我们电脑的语言设置为utf-8格式,具体如下。首先在搜索框搜索语言,点击这里。

找到管理语言设置。

勾选utf-8即可。

另外有的电脑初始设置的时候内存是由电脑自行分配的,很可能在运行训练代码的时候出现显存溢出的情况,为了防止该情况的出现,我们需要在高级系统设置中对虚拟内存进行设置,如下。

首先打开高级系统设置,点开性能中的设置。

在高级中找到虚拟内存的设置。

以d盘为例,这里我们将虚拟内存设置在4G到8G之间,其余操作一样。

其他盘也设置完成之后,点击确定之后按照电脑提示重启即可。

相关软件安装

- Nvidia驱动安装(可选)

首先是驱动的安装,这个小节主要是针对电脑带有Nvidia显卡的小伙伴,如果你的电脑没有Nvidia显卡,你直接跳过就可以了,你可以通过右下方的任务栏判断是是否具有这个显卡,如果是笔者这里的绿色小眼睛图标,说明你是具有Nvidia显卡的。

驱动下载的地址为:官方驱动 | NVIDIA

注意请按照你电脑具体的型号来选择驱动文件,不清楚的可以通过设备管理器来查看你显卡的具体型号。

下载exe文件之后,直接下一步下一步按照默认安装就好,注意这里最好按照默认目录安装,否则可能导致安装失败的情况如下,安装完毕之后重启电脑,在命令行中输入nvidia-smi,如果正常输出显卡的信息说明显卡驱动安装已经成功。

另外,这里多叭叭两句。

很多的远古教程会教你去安装cuda和cudnn,这个过程非常麻烦,并且需要你注册nvidia的账户,由于众所周知的原因,账户注册就很繁琐。其实,在新版本的驱动安装中,就已经自带最新版本的cuda,比如我上图所示的在笔者驱动安装完毕之后已经自带了12.0的cuda,cuda这个东西是向下兼容的,后续的cudnn那些我们直接通过anaconda来安装就可以了,这样真的省心很多。

- Anaconda安装

conda是一个开源的包、环境管理器,可以用于在同一个机器上安装不同版本的软件包及其依赖,并能够在不同的环境之间切换。我强烈推荐你使用他,他的作用类似于java中的maven和我们平时使用的虚拟机,他能够保证的项目之间互相是隔离的。举个简单的例子,如果你同时有两个项目,你一个使用的pytorch1.8,一个用的是pytorch1.10,这样一个环境肯定就不够了,这个时候anaconda就派上大用场了,他可以创建两个环境,各用各的,互不影响。

Anaconda有完全版本和Miniconda,其中完整版太臃肿了,我这边推荐使用miniconda,下载地址在:Index of /anaconda/miniconda/ | 北京外国语大学开源软件镜像站 | BFSU Open Source Mirror下滑到最下方,点击这个版本的下载即可。

同样的,下载之后安装即可,注意不要安装在C盘!!!,另外,添加到系统路径这个选项也请务必选上,后面使用起来会带来很多便捷,并且这里的安装位置请你一定要记得,后面我们在Pycharm中将会使用到。

- Pycharm安装

OK,Anaconda安装完成之后,我们还需要一个编辑器来写代码,这里推荐大家使用Pycharm,Pycharm有专业版和社区版,社区版是免费的,专业版如果你有教育邮箱的话也可以通过教育邮箱注册账户来使用,但是社区版的功能已经够绝大多数小伙伴来用了,Pycharm的下载地址在:Download PyCharm: Python IDE for Professional Developers by JetBrains

注意也是安装的时候不要安装在c盘,并且安装过程中这些可选的选项要勾上。

完成之后,比如我们用pycharm打开一个项目,在新版本的下方会出现命令行无法使用的情况。请使用管理员模型打开powershell。

然后执行执行指令set-ExecutionPolicy RemoteSigned,输入Y然后enter完成即可。

另外,在Pycharm的右下方是表示的是你所处的虚拟环境,这里先简单说下在pycharm中如何使用anaconda中创建的虚拟环境。

点击ok之后,右下角出现你的虚拟环境名称就表示成功了。

以上这些步骤完成之后,恭喜你,差不多一半的工作就完事了,剩下无非就是根据不同的项目来配置环境和执行代码了。

嗷,对这里我们也说一下,如何在Pycharm中选Anaconda的虚拟环境。

环境配置

OK,来到关键环境配置的部分,首先大家下载代码之后会得到一个压缩包,在当前文件夹解压之后,进入CMD开始我们的环境配置环节。

为了加快后期第三方库的安装速度,我们这里需要添加几个国内的源进来,直接复制粘贴下面的这些指令到你的命令行即可。

conda config --remove-key channels

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/pytorch/

conda config --set show_channel_urls yes

pip config set global.index-url https://mirrors.ustc.edu.cn/pypi/web/simple

执行完毕大概是下面这个样子,后面你就可以飞速下载这些库了。

创建虚拟环境

首先,我们需要根据我们的项目来创建一个虚拟环境,通过下面的指令创建并激活虚拟环境。

我们创建一个Python版本为3.8.5,环境名称为yolo的虚拟环境。

conda create -n yolo pythnotallow==3.8.5

conda activate yolo

切记!这里一定要激活你的虚拟环境,否则后续你的库会安装在基础环境中,前面的小括号表示你处于的虚拟环境。

Pytorch安装

注意Pyotorch和其他库不太一样,Pytorch的安装涉及到conda和cudnn,一般而言,对于30系的显卡,我们的cuda不能小于11,对于10和20系的显卡,一般使用的是cuda10.2。下面给出了30系显卡、30系以下显卡和cpu的安装指令,请大家根据自己的电脑配置自行下载。笔者这里是3060的显卡,所以执行的是第一条指令。

conda install pytorch==1.10.0 torchvision torchaudio cudatoolkit=11.3 # 30系列以上显卡gpu版本pytorch安装指令

conda install pytorch==1.8.0 torchvision torchaudio cudatoolkit=10.2 # 10系和20系以及mx系列的执行这条

conda install pytorch==1.8.0 torchvisinotallow==0.9.0 torchaudio==0.8.0 cpuonly # CPU的小伙伴直接执行这条命令即可

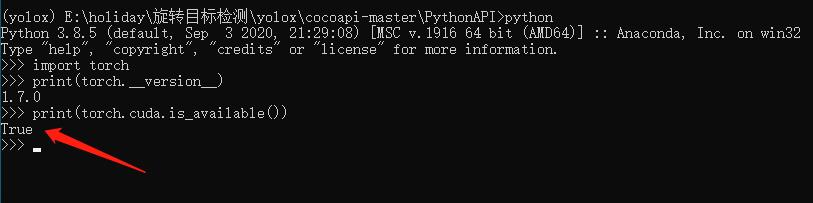

安装之后,可以和笔者一样,输入下面的指令测试以下gpu是否可用,如果输出的是true表示GPU是可用的。

其余库安装

其余库的安装就非常简单了,我们通过pip来进行安装,注意这里一定要确保你执行的目录下有requirements.txt这个文件,否则你将会遇到文件找不到的bug,你可以通过dir指令来查看是否有这个文件。

pip install -r requirements.txt

Pycharm中运行

一是为了查看代码方便,二是为了运行方便,这里我们使用Pycharm打开项目,点击这里右键文件夹直接打开项目即可非常方便。

打开之后你将会看到这样的一个界面,其中左侧是文件浏览器,中间是编辑器,下方是一些工具,右下角是你所处的虚拟环境 。

之后,我们就需要为当前的项目选择虚拟环境了,这一步非常重要,有的兄弟配置好了没选环境,你将会遇到一堆奇怪的bug,选环境的步骤如下。

首先点击,添加解释器。

三步走选择我们刚才创建的虚拟环境,点击ok。

之后你可以你可以右键执行main_window.py这个文件,出现下面的画面说明你就成功了。

数据集准备

数据集这里我放在了CSDN中,大家可以执行标注准备数据集,或者使用这里我处理好的数据集,数据集下载之后放在和代码目录同级的data目录下。

数据集打开之后你将会看到两个文件夹,images目录存放图片文件,labels目录存放标签文件。

之后记住你这里的数据集路径,在后面的训练中我们将会使用到,比如笔者这里的F:\\new_project\\sfid\\data\\target_sfid。

训练和测试

注:这里你可以选择去自己尝试以下,笔者在runs的train目录下已经放了训练好的模型,你是可以直接使用。

下面就是训练的过程,笔者这里已经将数据集和模型的配置文件写好了,你只需要将数据集中的数据路径替换成你的路径,执行go_train.py即可开始训练了。

执行go_train.py文件中,包含三条指令,分别表示yolov5中small模型、medium模型和large模型,比如我这里要训练s模型,我就将其他两个模型训练的指令注释掉就好了。

运行之后,下方会输出运行的信息,这里的红色只是日志信息,不是报错,大家不要惊慌。

以笔者这里的s模型为例,详细含义如下。

图形化程序

最后就是执行我们的图形化界面程序了。

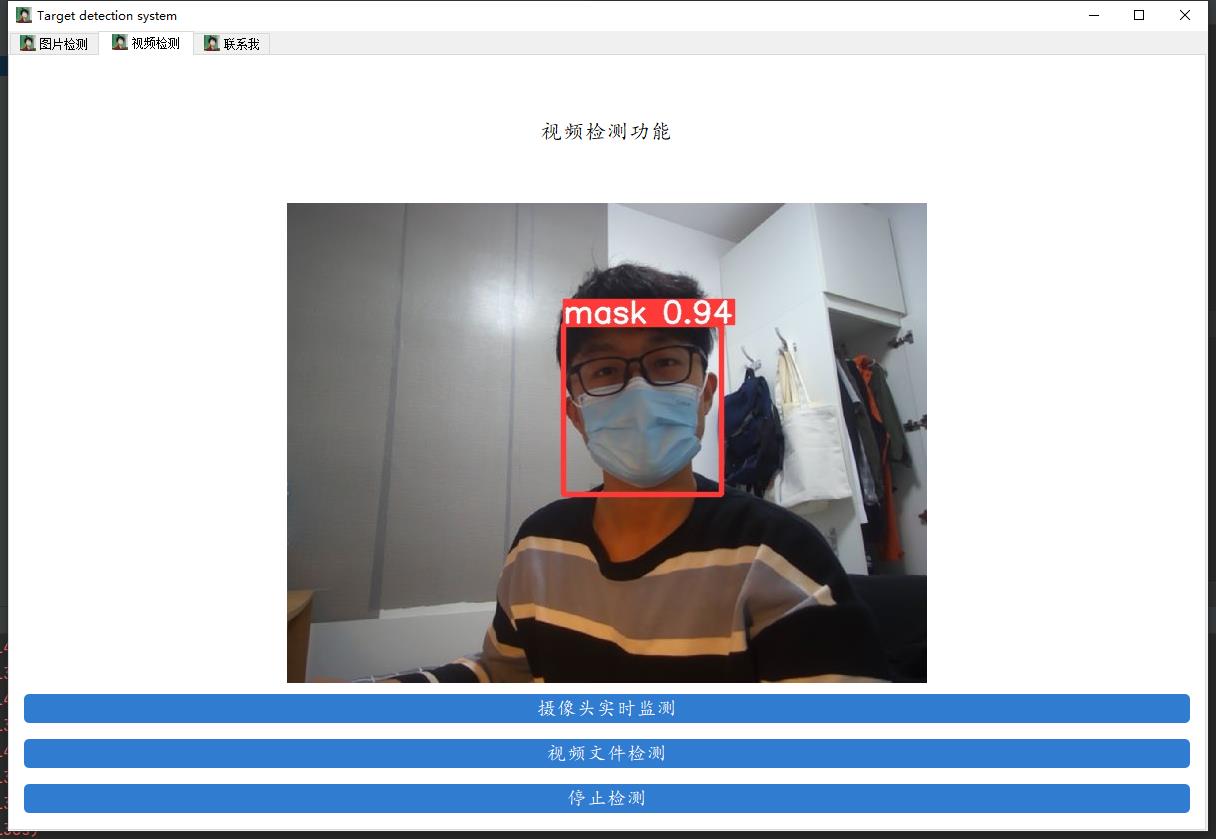

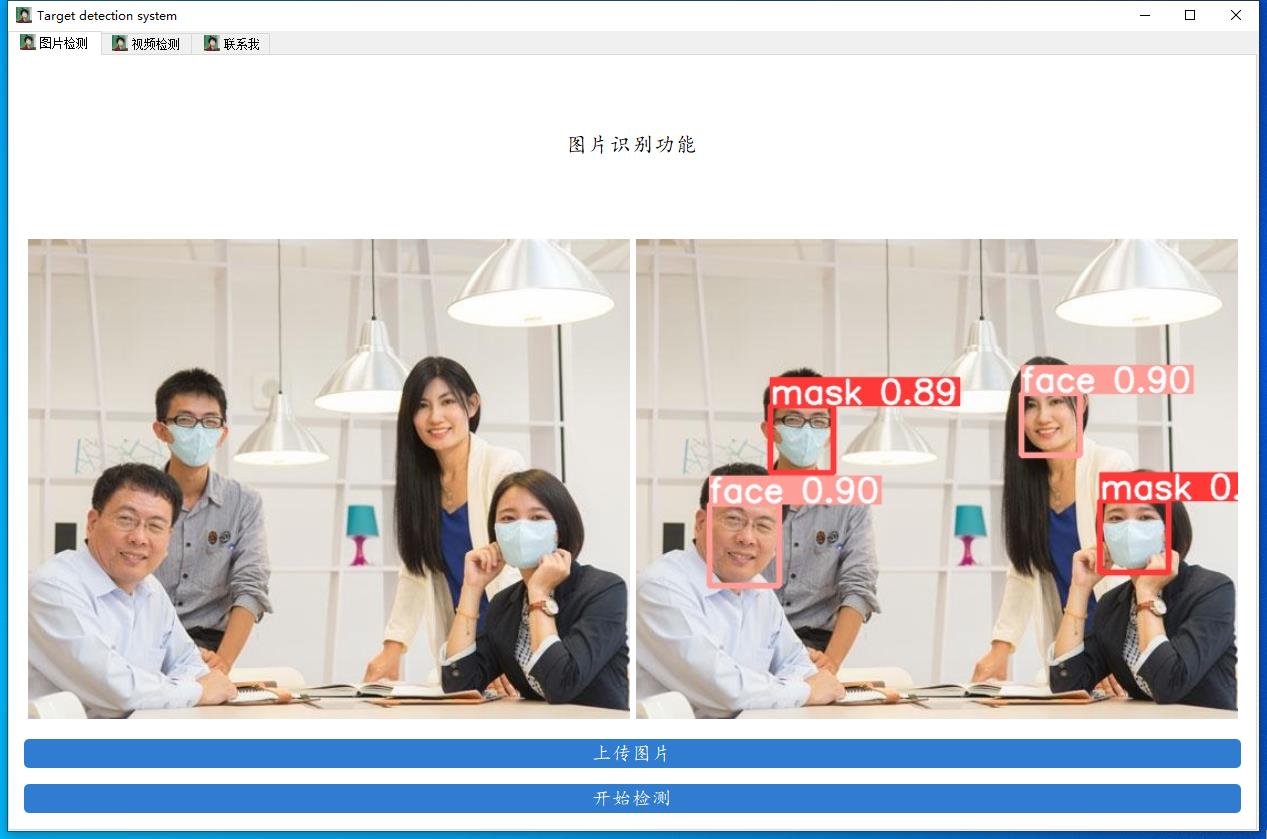

直接右键执行window_main.py执行即可,这里上两章效果图。

手把手教你使用YOLOV5训练自己的目标检测模型-口罩检测-视频教程

手把手教你使用YOLOV5训练自己的目标检测模型

大家好,这里是肆十二(dejahu),好几个月没有更新了,这两天看了一下关注量,突然多了1k多个朋友关注,想必都是大作业系列教程来的小伙伴。既然有这么多朋友关注这个大作业系列,并且也差不多到了毕设开题和大作业提交的时间了,那我直接就是一波更新。这期的内容相对于上期的果蔬分类和垃圾识别无论是在内容还是新意上我们都进行了船新的升级,我们这次要使用YOLOV5来训练一个口罩检测模型,比较契合当下的疫情,并且目标检测涉及到的知识点也比较多,这次的内容除了可以作为大家的大作业之外,也可以作为一些小伙伴的毕业设计。废话不多说,我们直接开始今天的内容。

B站讲解视频:手把手教你使用YOLOV5训练自己的目标检测模型_哔哩哔哩_bilibili

CSDN博客:手把手教你使用YOLOV5训练自己的目标检测模型-口罩检测-视频教程_dejahu的博客-CSDN博客

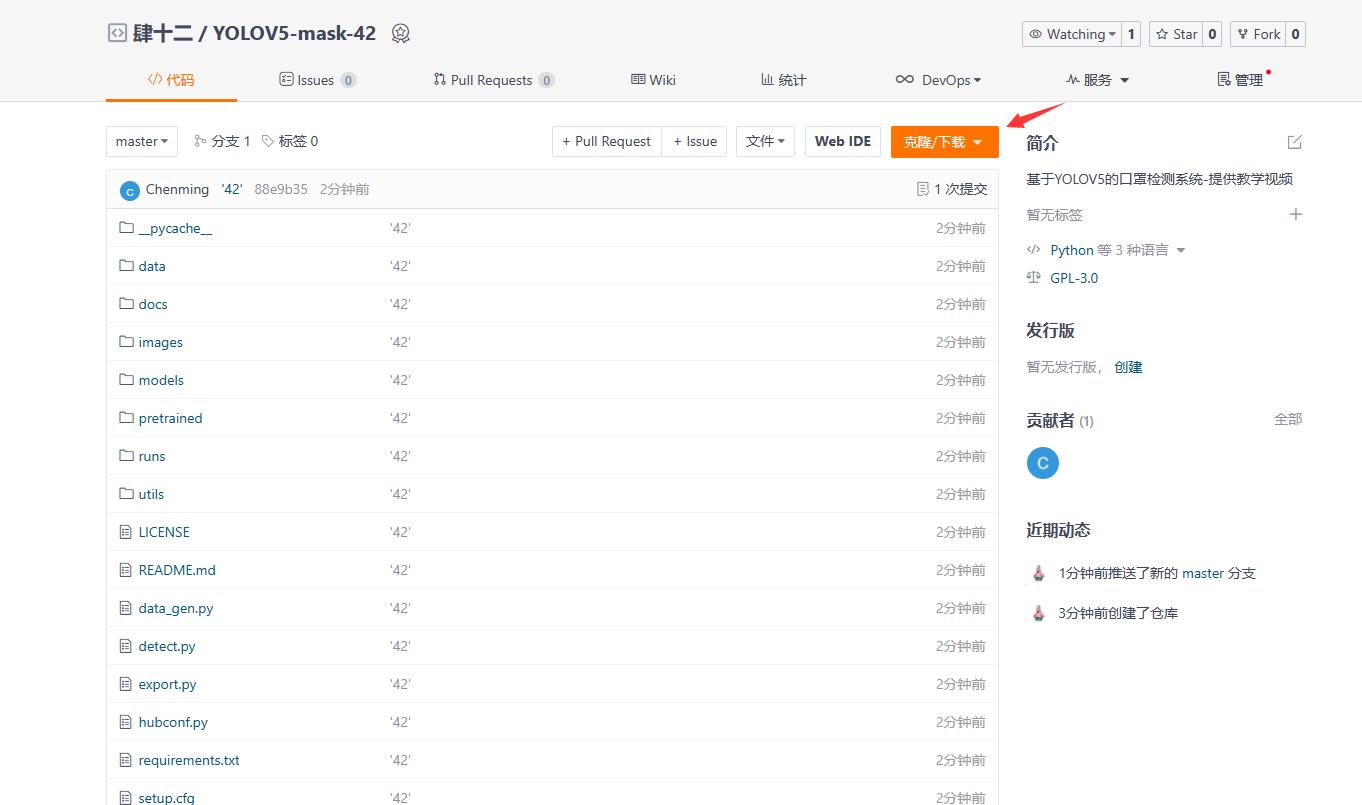

代码地址:YOLOV5-mask-42: 基于YOLOV5的口罩检测系统-提供教学视频 (gitee.com)

处理好的数据集和训练好的模型:YOLOV5口罩检测数据集+代码+模型2000张标注好的数据+教学视频.zip-深度学习文档类资源-CSDN文库

先来看看我们要实现的效果,我们将会通过数据来训练一个口罩检测的模型,并用pyqt5进行封装,实现图片口罩检测、视频口罩检测和摄像头实时口罩检测的功能。

下载代码

代码的下载地址是:[YOLOV5-mask-42: 基于YOLOV5的口罩检测系统-提供教学视频 (gitee.com)](https://github.com/ultralytics/yolov5)

配置环境

不熟悉pycharm的anaconda的小伙伴请先看这篇csdn博客,了解pycharm和anaconda的基本操作

如何在pycharm中配置anaconda的虚拟环境_dejahu的博客-CSDN博客_如何在pycharm中配置anaconda

anaconda安装完成之后请切换到国内的源来提高下载速度 ,命令如下:

conda config --remove-key channels

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/pytorch/

conda config --set show_channel_urls yes

pip config set global.index-url https://mirrors.ustc.edu.cn/pypi/web/simple

首先创建python3.8的虚拟环境,请在命令行中执行下列操作:

conda create -n yolo5 python==3.8.5

conda activate yolo5

pytorch安装(gpu版本和cpu版本的安装)

实际测试情况是YOLOv5在CPU和GPU的情况下均可使用,不过在CPU的条件下训练那个速度会令人发指,所以有条件的小伙伴一定要安装GPU版本的Pytorch,没有条件的小伙伴最好是租服务器来使用。

GPU版本安装的具体步骤可以参考这篇文章:2021年Windows下安装GPU版本的Tensorflow和Pytorch_dejahu的博客-CSDN博客

需要注意以下几点:

- 安装之前一定要先更新你的显卡驱动,去官网下载对应型号的驱动安装

- 30系显卡只能使用cuda11的版本

- 一定要创建虚拟环境,这样的话各个深度学习框架之间不发生冲突

我这里创建的是python3.8的环境,安装的Pytorch的版本是1.8.0,命令如下:

conda install pytorch==1.8.0 torchvision torchaudio cudatoolkit=10.2 # 注意这条命令指定Pytorch的版本和cuda的版本

conda install pytorch==1.8.0 torchvision==0.9.0 torchaudio==0.8.0 cpuonly # CPU的小伙伴直接执行这条命令即可

安装完毕之后,我们来测试一下GPU是否

pycocotools的安装

后面我发现了windows下更简单的安装方法,大家可以使用下面这个指令来直接进行安装,不需要下载之后再来安装

pip install pycocotools-windows

其他包的安装

另外的话大家还需要安装程序其他所需的包,包括opencv,matplotlib这些包,不过这些包的安装比较简单,直接通过pip指令执行即可,我们cd到yolov5代码的目录下,直接执行下列指令即可完成包的安装。

pip install -r requirements.txt

pip install pyqt5

pip install labelme

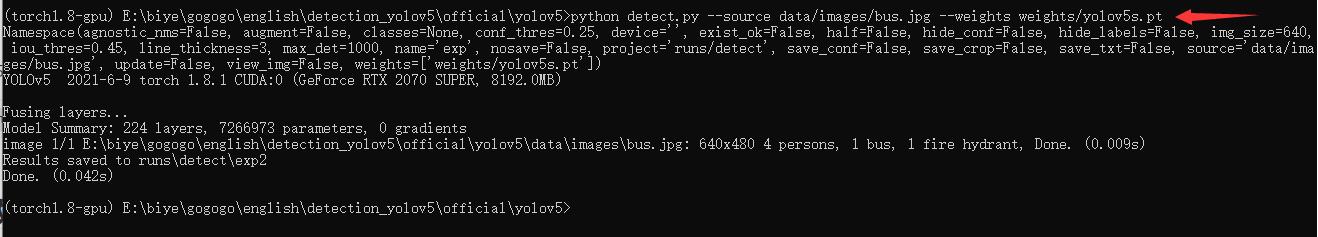

测试一下

在yolov5目录下执行下列代码

python detect.py --source data/images/bus.jpg --weights pretrained/yolov5s.pt

执行完毕之后将会输出下列信息

在runs目录下可以找到检测之后的结果

按照官方给出的指令,这里的检测代码功能十分强大,是支持对多种图像和视频流进行检测的,具体的使用方法如下:

python detect.py --source 0 # webcam

file.jpg # image

file.mp4 # video

path/ # directory

path/*.jpg # glob

'https://youtu.be/NUsoVlDFqZg' # YouTube video

'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream

数据处理

这里改成yolo的标注形式,之后专门出一期数据转换的内容。

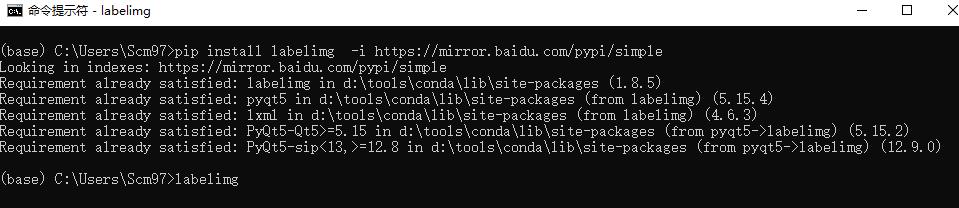

数据标注这里推荐的软件是labelimg,通过pip指令即可安装

在你的虚拟环境下执行pip install labelimg -i https://mirror.baidu.com/pypi/simple命令进行安装,然后在命令行中直接执行labelimg软件即可启动数据标注软件。

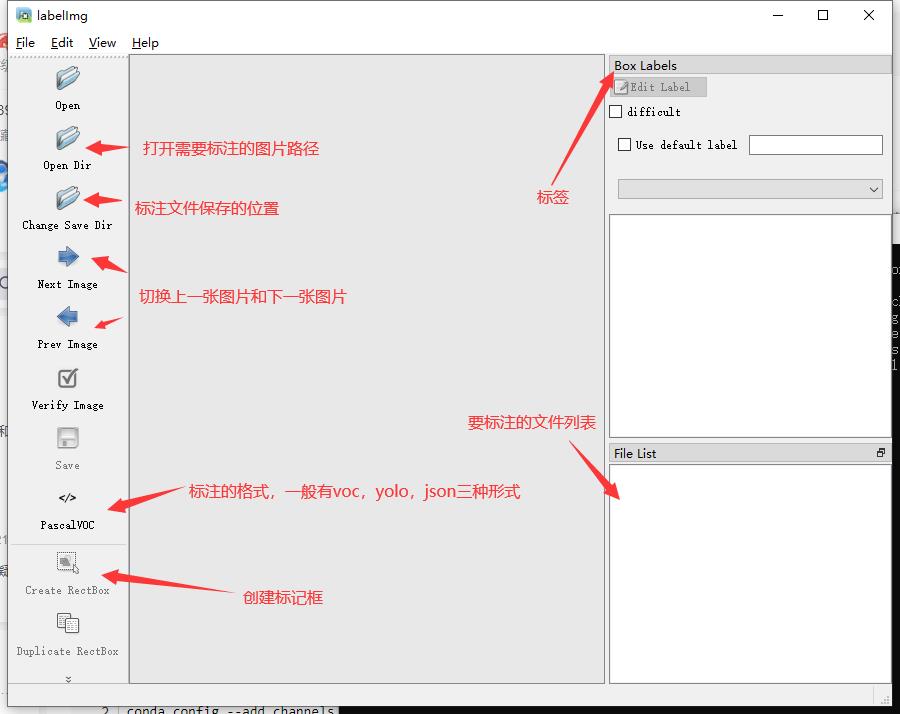

软件启动后的界面如下:

数据标注

虽然是yolo的模型训练,但是这里我们还是选择进行voc格式的标注,一是方便在其他的代码中使用数据集,二是我提供了数据格式转化

标注的过程是:

1.打开图片目录

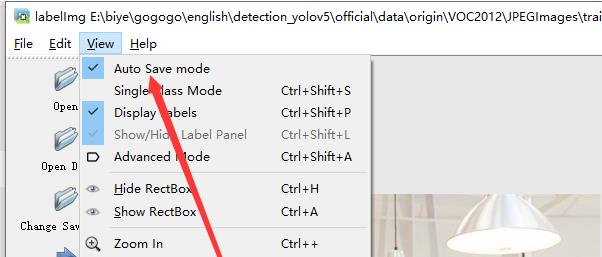

2.设置标注文件保存的目录并设置自动保存

3.开始标注,画框,标记目标的label,crtl+s保存,然后d切换到下一张继续标注,不断重复重复

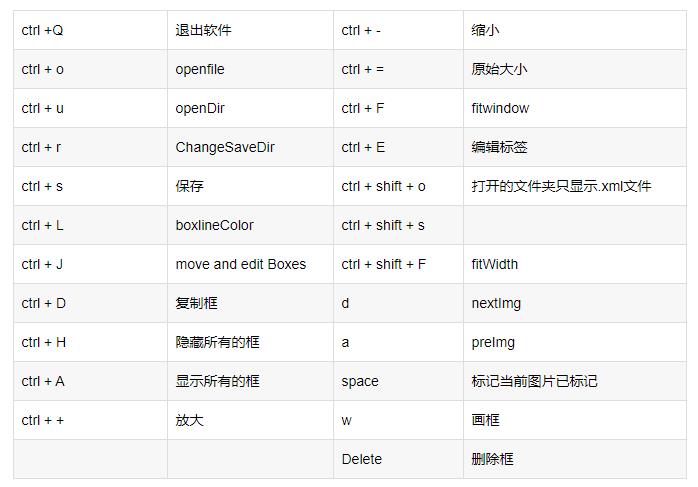

labelimg的快捷键如下,学会快捷键可以帮助你提高数据标注的效率。

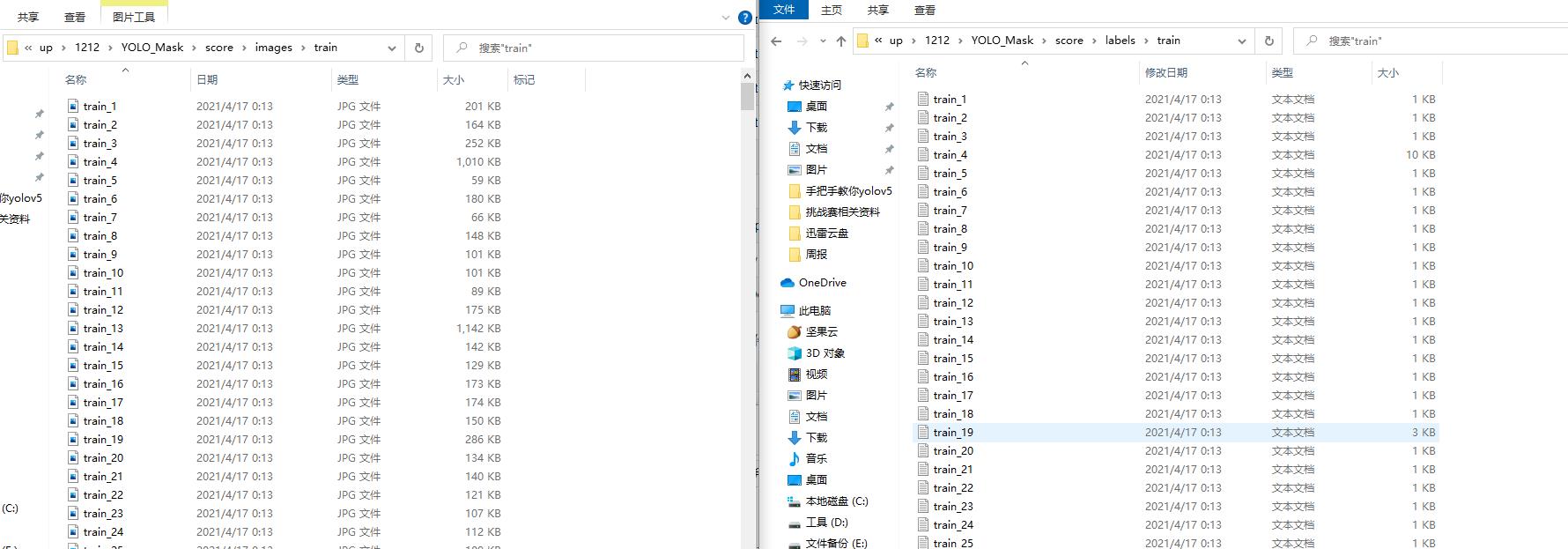

标注完成之后你会得到一系列的txt文件,这里的txt文件就是目标检测的标注文件,其中txt文件和图片文件的名称是一一对应的,如下图所示:

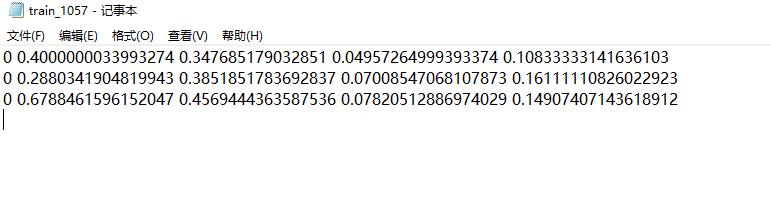

打开具体的标注文件,你将会看到下面的内容,txt文件中每一行表示一个目标,以空格进行区分,分别表示目标的类别id,归一化处理之后的中心点x坐标、y坐标、目标框的w和h。

4.修改数据集配置文件

标记完成的数据请按照下面的格式进行放置,方便程序进行索引。

YOLO_Mask

└─ score

├─ images

│ ├─ test # 下面放测试集图片

│ ├─ train # 下面放训练集图片

│ └─ val # 下面放验证集图片

└─ labels

├─ test # 下面放测试集标签

├─ train # 下面放训练集标签

├─ val # 下面放验证集标签

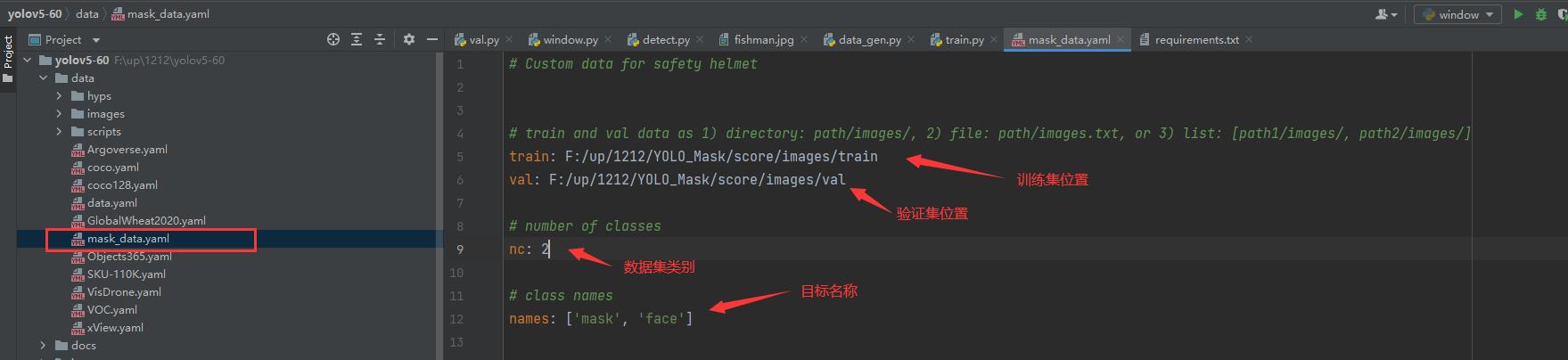

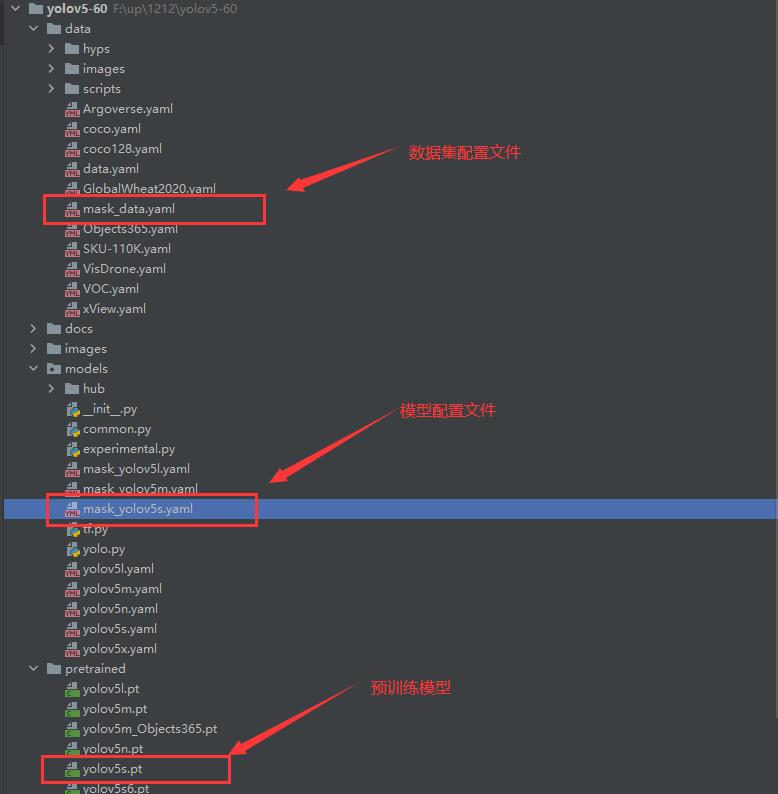

这里的配置文件是为了方便我们后期训练使用,我们需要在data目录下创建一个mask_data.yaml的文件,如下图所示:

到这里,数据集处理部分基本完结撒花了,下面的内容将会是模型训练!

模型训练

模型的基本训练

在models下建立一个mask_yolov5s.yaml的模型配置文件,内容如下:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qYQ5eEe6-1639544279066)(C:\\Users\\chenmingsong\\AppData\\Roaming\\Typora\\typora-user-images\\image-20211212174749558.png)]

模型训练之前,请确保代码目录下有以下文件

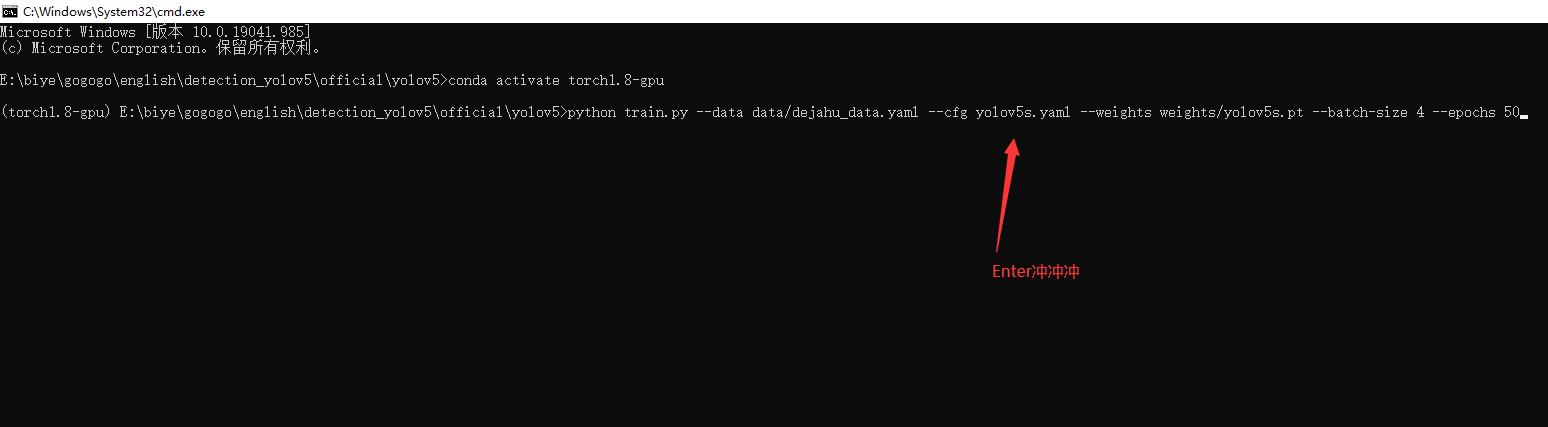

执行下列代码运行程序即可:

python train.py --data mask_data.yaml --cfg mask_yolov5s.yaml --weights pretrained/yolov5s.pt --epoch 100 --batch-size 4 --device cpu

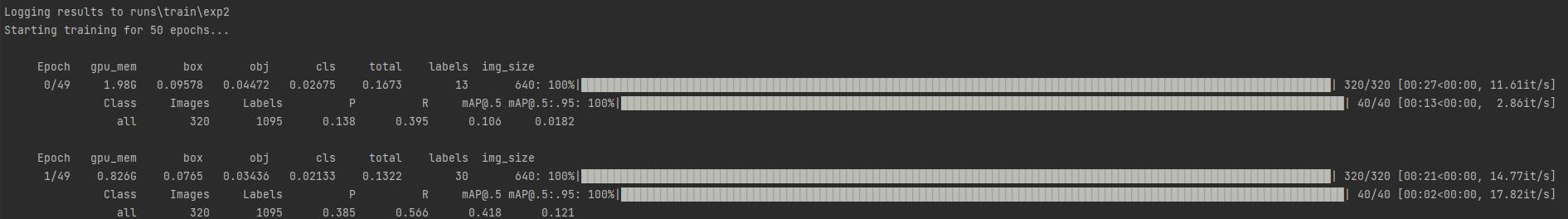

训练代码成功执行之后会在命令行中输出下列信息,接下来就是安心等待模型训练结束即可。

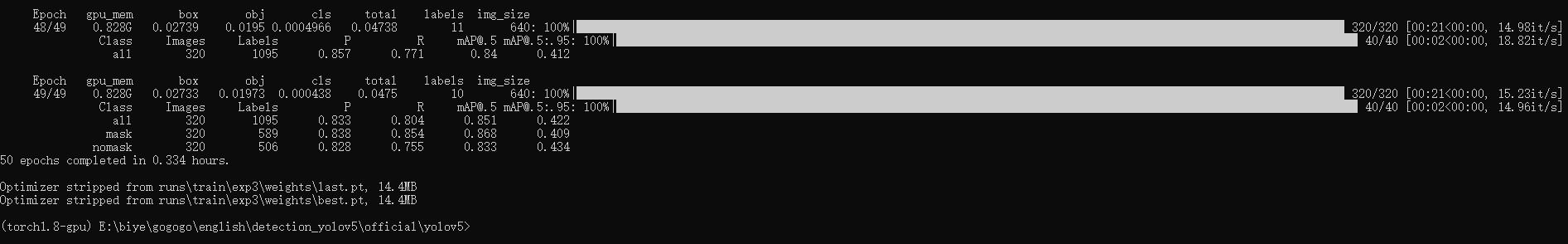

根据数据集的大小和设备的性能,经过漫长的等待之后模型就训练完了,输出如下:

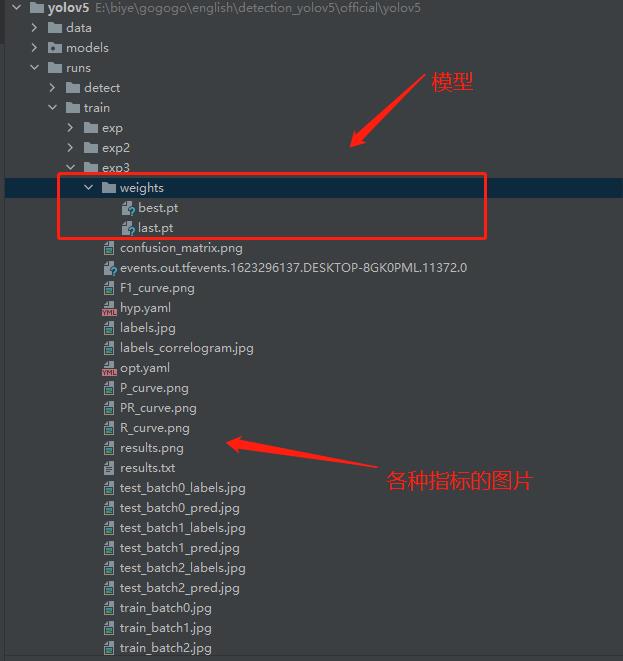

在train/runs/exp3的目录下可以找到训练得到的模型和日志文件

当然还有一些骚操作,比如模型训练到一半可以从中断点继续训练,这些就交给大家下去自行探索喽。

模型评估

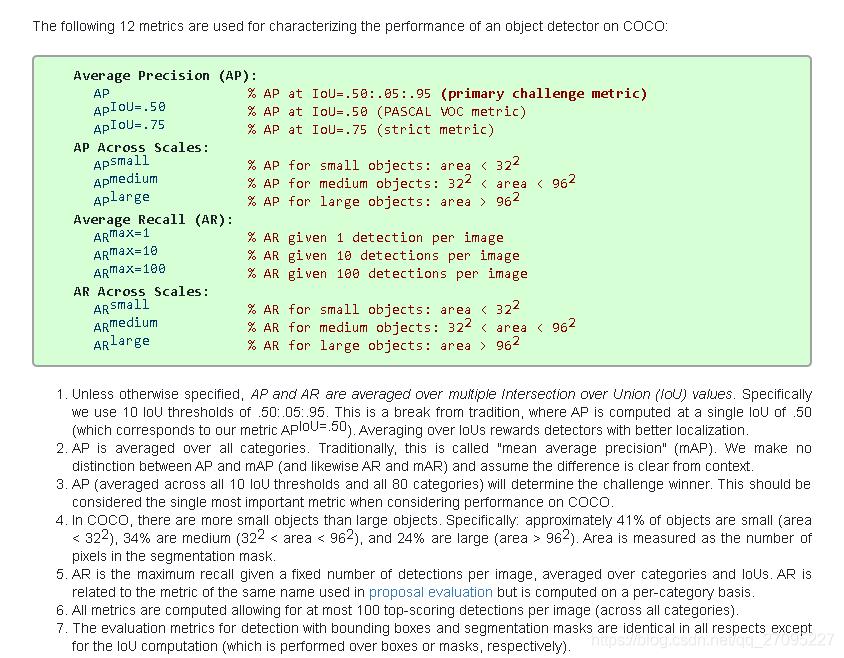

出了在博客一开头你就能看到的检测效果之外,还有一些学术上的评价指标用来表示我们模型的性能,其中目标检测最常用的评价指标是mAP,mAP是介于0到1之间的一个数字,这个数字越接近于1,就表示你的模型的性能更好。

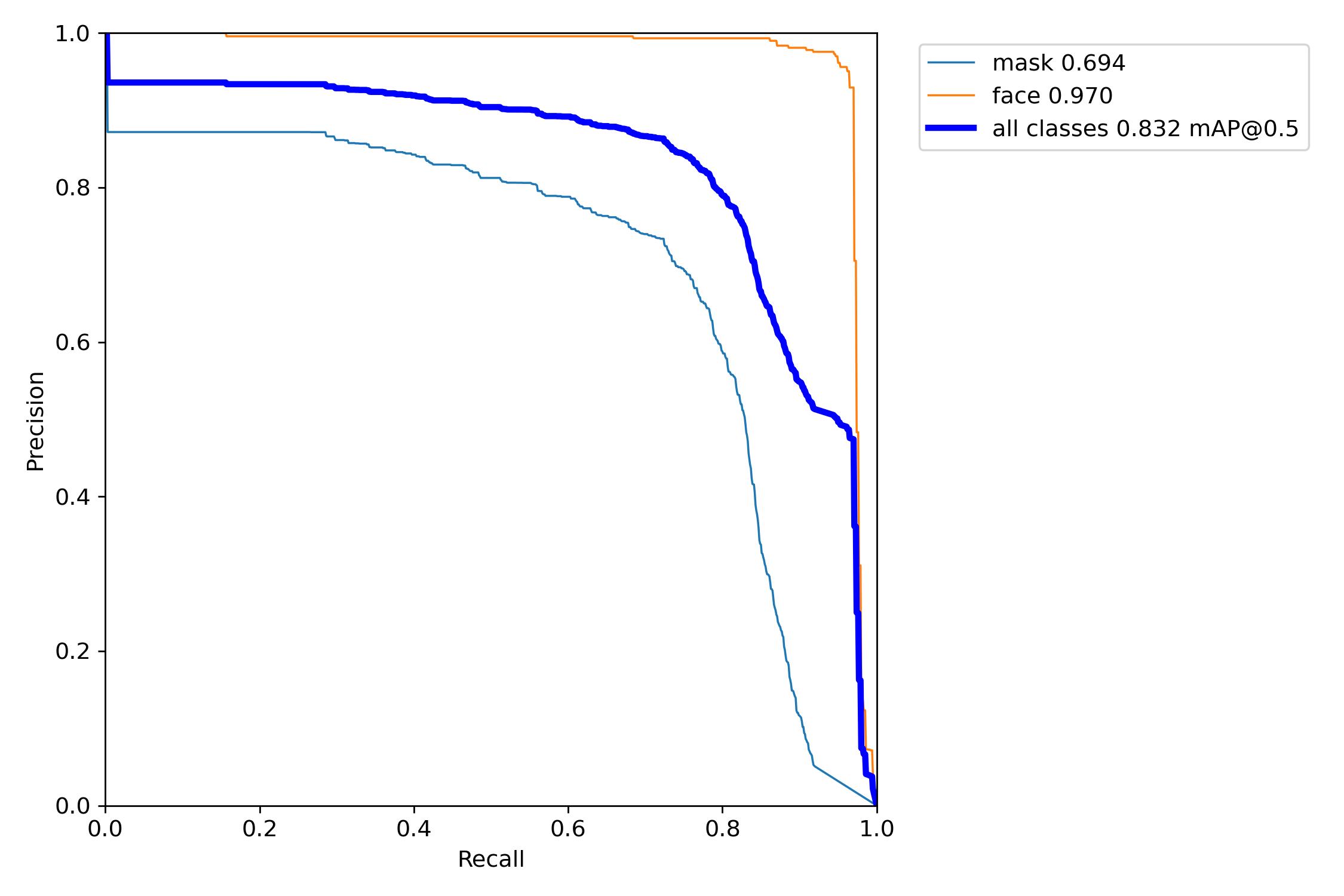

一般我们会接触到两个指标,分别是召回率recall和精度precision,两个指标p和r都是简单地从一个角度来判断模型的好坏,均是介于0到1之间的数值,其中接近于1表示模型的性能越好,接近于0表示模型的性能越差,为了综合评价目标检测的性能,一般采用均值平均密度map来进一步评估模型的好坏。我们通过设定不同的置信度的阈值,可以得到在模型在不同的阈值下所计算出的p值和r值,一般情况下,p值和r值是负相关的,绘制出来可以得到如下图所示的曲线,其中曲线的面积我们称AP,目标检测模型中每种目标可计算出一个AP值,对所有的AP值求平均则可以得到模型的mAP值,以本文为例,我们可以计算佩戴安全帽和未佩戴安全帽的两个目标的AP值,我们对两组AP值求平均,可以得到整个模型的mAP值,该值越接近1表示模型的性能越好。

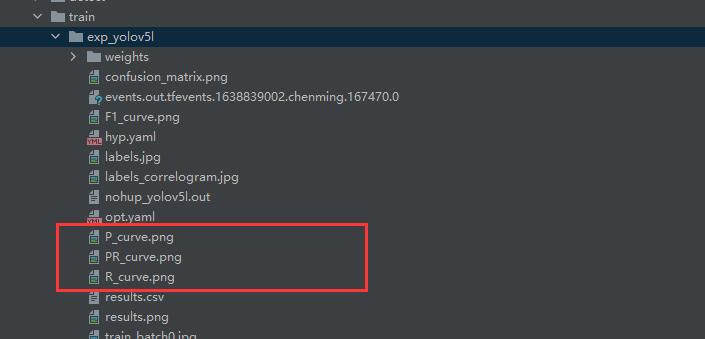

关于更加学术的定义大家可以在知乎或者csdn上自行查阅,以我们本次训练的模型为例,在模型结束之后你会找到三张图像,分别表示我们模型在验证集上的召回率、准确率和均值平均密度。

以PR-curve为例,你可以看到我们的模型在验证集上的均值平均密度为0.832。

如果你的目录下没有这样的曲线,可能是因为你的模型训练一半就停止了,没有执行验证的过程,你可以通过下面的命令来生成这些图片。

python val.py --data data/mask_data.yaml --weights runs/train/exp_yolov5s/weights/best.pt --img 640

最后,这里是一张详细的评价指标的解释清单,可以说是最原始的定义了。

模型使用

模型的使用全部集成在了detect.py目录下,你按照下面的指令指你要检测的内容即可

# 检测摄像头

python detect.py --weights runs/train/exp_yolov5s/weights/best.pt --source 0 # webcam

# 检测图片文件

python detect.py --weights runs/train/exp_yolov5s/weights/best.pt --source file.jpg # image

# 检测视频文件

python detect.py --weights runs/train/exp_yolov5s/weights/best.pt --source file.mp4 # video

# 检测一个目录下的文件

python detect.py --weights runs/train/exp_yolov5s/weights/best.pt path/ # directory

# 检测网络视频

python detect.py --weights runs/train/exp_yolov5s/weights/best.pt 'https://youtu.be/NUsoVlDFqZg' # YouTube video

# 检测流媒体

python detect.py --weights runs/train/exp_yolov5s/weights/best.pt 'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream

比如以我们的口罩模型为例,如果我们执行python detect.py --weights runs/train/exp_yolov5s/weights/best.pt --source data/images/fishman.jpg的命令便可以得到这样的一张检测结果。

构建可视化界面

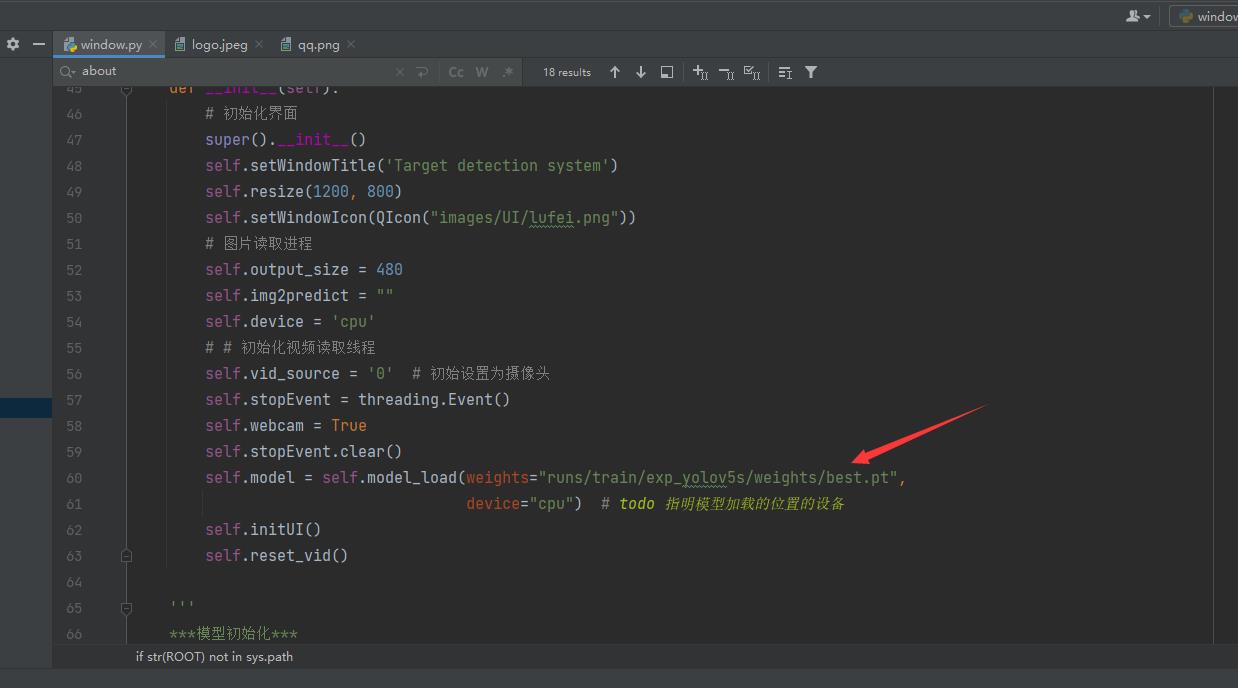

可视化界面的部分在window.py文件中,是通过pyqt5完成的界面设计,在启动界面前,你需要将模型替换成你训练好的模型,替换的位置在window.py的第60行,修改成你的模型地址即可,如果你有GPU的话,可以将device设置为0,表示使用第0行GPU,这样可以加快模型的识别速度嗷。

替换之后直接右键run即可启动图形化界面了,快去自己测试一下看看效果吧

找到我

你可以通过这些方式来寻找我。

B站:肆十二-

CSDN:肆十二

知乎:肆十二

微博:肆十二-

现在关注以后就是老朋友喽!

以上是关于2023-Pytorch-检测教程手把手教你使用YOLOV5做电线绝缘子缺陷检测的主要内容,如果未能解决你的问题,请参考以下文章

手把手教你使用YOLOV5训练自己的目标检测模型-口罩检测-视频教程

手把手教你使用LabVIEW OpenCV dnn实现物体识别(Object Detection)含源码