手把手教你使用 YOLOV5 训练目标检测模型

Posted AI科技大本营

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了手把手教你使用 YOLOV5 训练目标检测模型相关的知识,希望对你有一定的参考价值。

作者 | 肆十二

来源 | CSDN博客

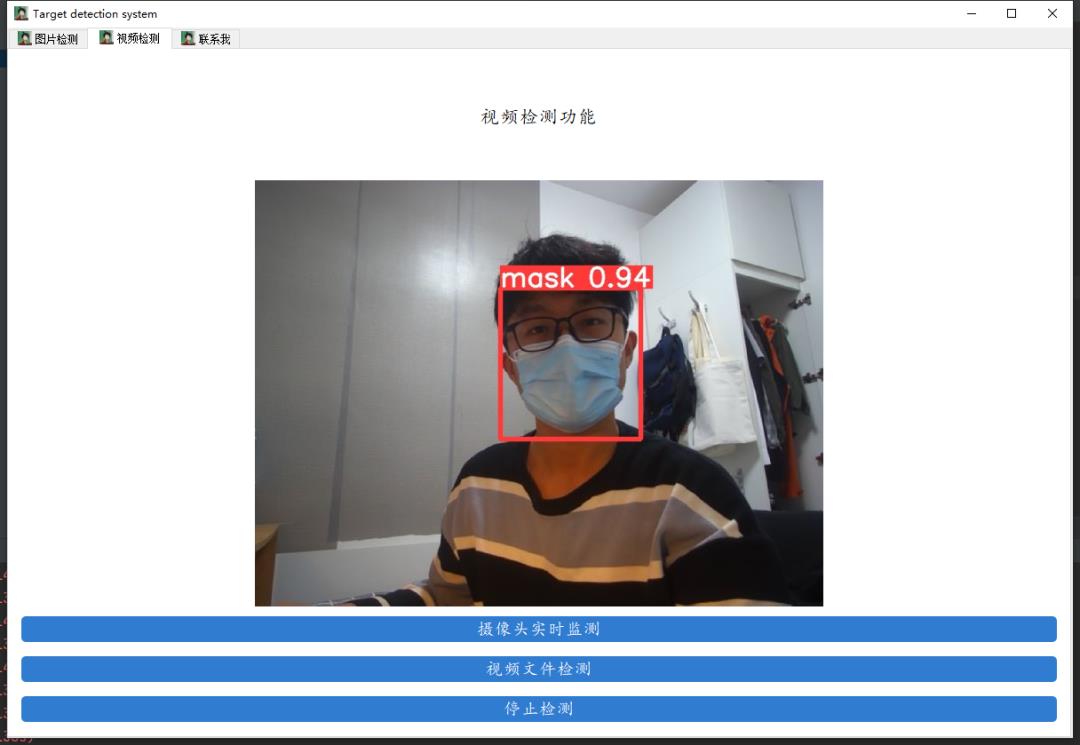

这次要使用YOLOV5来训练一个口罩检测模型,比较契合当下的疫情,并且目标检测涉及到的知识点也比较多。

先来看看我们要实现的效果,我们将会通过数据来训练一个口罩检测的模型,并用pyqt5进行封装,实现图片口罩检测、视频口罩检测和摄像头实时口罩检测的功能。

下载代码

代码的下载地址是:[YOLOV5-mask-42: 基于YOLOV5的口罩检测系统-提供教学视频 (gitee.com)](https://github.com/ultralytics/yolov5)

配置环境

anaconda安装完成之后请切换到国内的源来提高下载速度 ,命令如下:

conda config --remove-key channels

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/pytorch/

conda config --set show_channel_urls yes

pip config set global.index-url https://mirrors.ustc.edu.cn/pypi/web/simple首先创建python3.8的虚拟环境,请在命令行中执行下列操作:

conda create -n yolo5 python==3.8.5

conda activate yolo5pytorch安装(gpu版本和cpu版本的安装)

实际测试情况是YOLOv5在CPU和GPU的情况下均可使用,不过在CPU的条件下训练那个速度会令人发指,所以有条件的小伙伴一定要安装GPU版本的Pytorch,没有条件的小伙伴最好是租服务器来使用。

需要注意以下几点:

安装之前一定要先更新你的显卡驱动,去官网下载对应型号的驱动安装

30系显卡只能使用cuda11的版本

一定要创建虚拟环境,这样的话各个深度学习框架之间不发生冲突

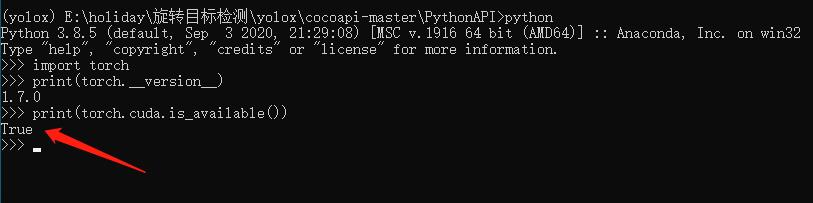

我这里创建的是python3.8的环境,安装的Pytorch的版本是1.8.0,命令如下:

conda install pytorch==1.8.0 torchvision torchaudio cudatoolkit=10.2 # 注意这条命令指定Pytorch的版本和cuda的版本

conda install pytorch==1.8.0 torchvision==0.9.0 torchaudio==0.8.0 cpuonly # CPU的小伙伴直接执行这条命令即可安装完毕之后,我们来测试一下GPU是否

pycocotools的安装

后面我发现了windows下更简单的安装方法,大家可以使用下面这个指令来直接进行安装,不需要下载之后再来安装

pip install pycocotools-windows其他包的安装

另外的话大家还需要安装程序其他所需的包,包括opencv,matplotlib这些包,不过这些包的安装比较简单,直接通过pip指令执行即可,我们cd到yolov5代码的目录下,直接执行下列指令即可完成包的安装。

pip install -r requirements.txt

pip install pyqt5

pip install labelme测试一下

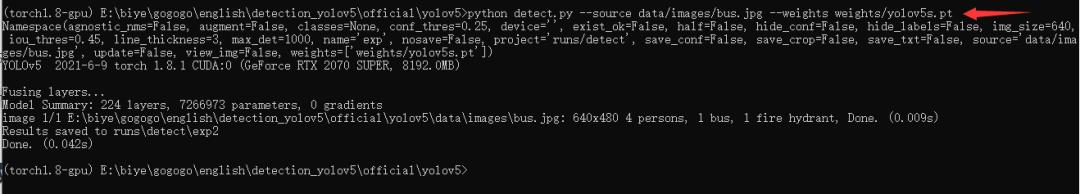

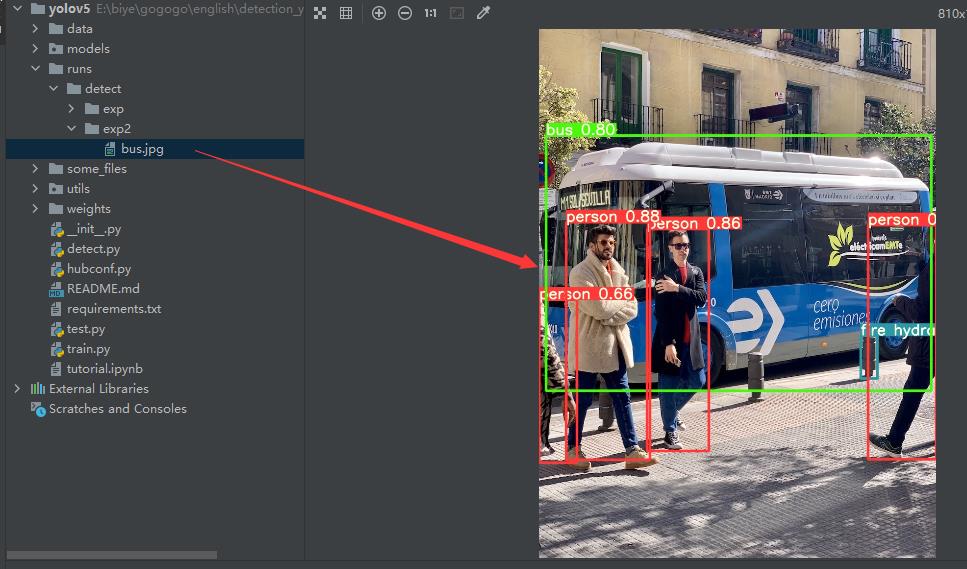

在yolov5目录下执行下列代码:

python detect.py --source data/images/bus.jpg --weights pretrained/yolov5s.pt执行完毕之后将会输出下列信息

在runs目录下可以找到检测之后的结果

按照官方给出的指令,这里的检测代码功能十分强大,是支持对多种图像和视频流进行检测的,具体的使用方法如下:

python detect.py --source 0 # webcam

file.jpg # image

file.mp4 # video

path/ # directory

path/*.jpg # glob

'https://youtu.be/NUsoVlDFqZg' # YouTube video

'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream数据处理

这里改成yolo的标注形式,之后专门出一期数据转换的内容。

数据标注这里推荐的软件是labelimg,通过pip指令即可安装

在你的虚拟环境下执行:

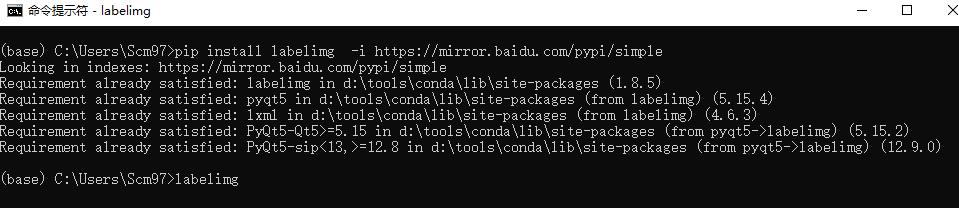

pip install labelimg -i https://mirror.baidu.com/pypi/simple命令进行安装,然后在命令行中直接执行labelimg软件即可启动数据标注软件。

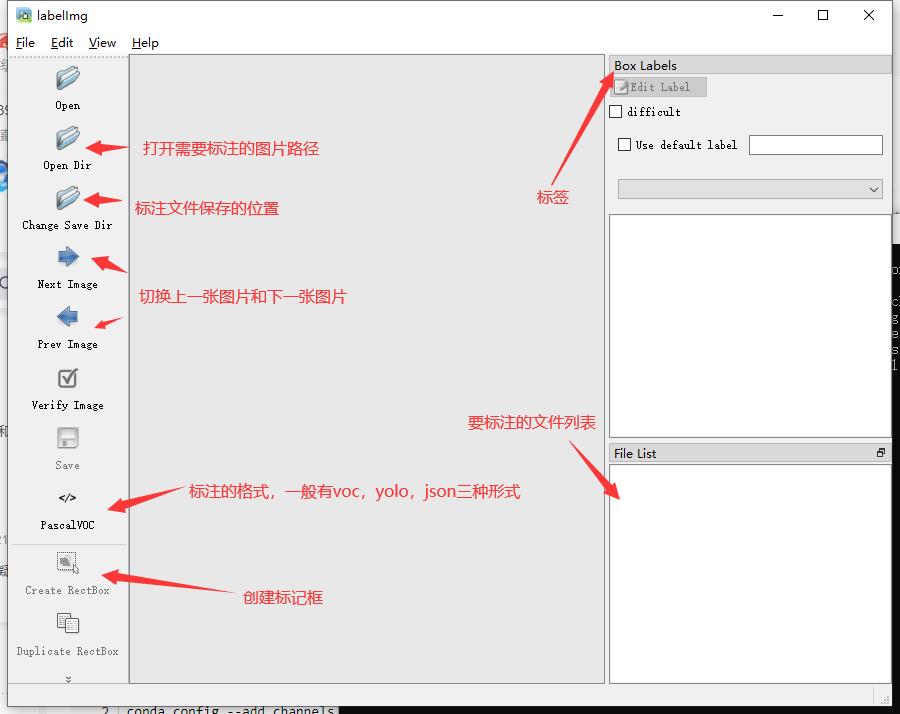

软件启动后的界面如下:

数据标注

虽然是yolo的模型训练,但是这里我们还是选择进行voc格式的标注,一是方便在其他的代码中使用数据集,二是我提供了数据格式转化

标注的过程是:

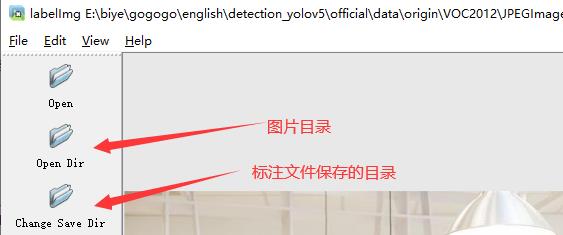

1.打开图片目录

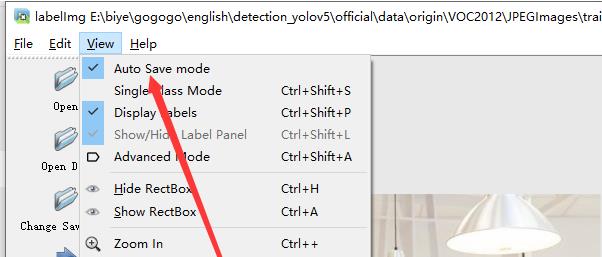

2.设置标注文件保存的目录并设置自动保存

3.开始标注,画框,标记目标的label,crtl+s保存,然后d切换到下一张继续标注,不断重复重复

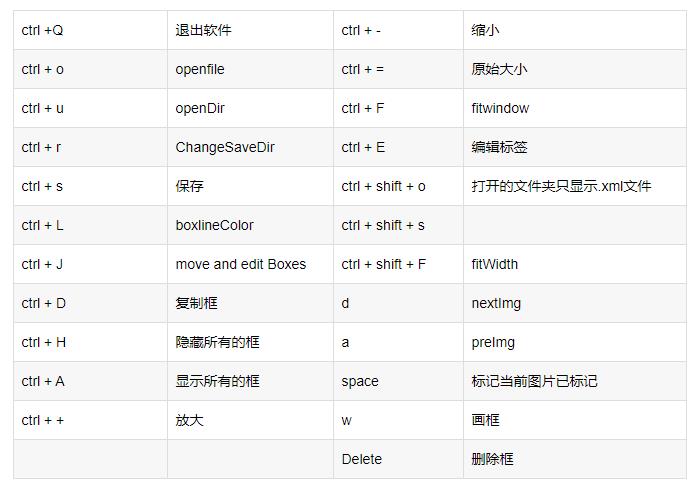

labelimg的快捷键如下,学会快捷键可以帮助你提高数据标注的效率。

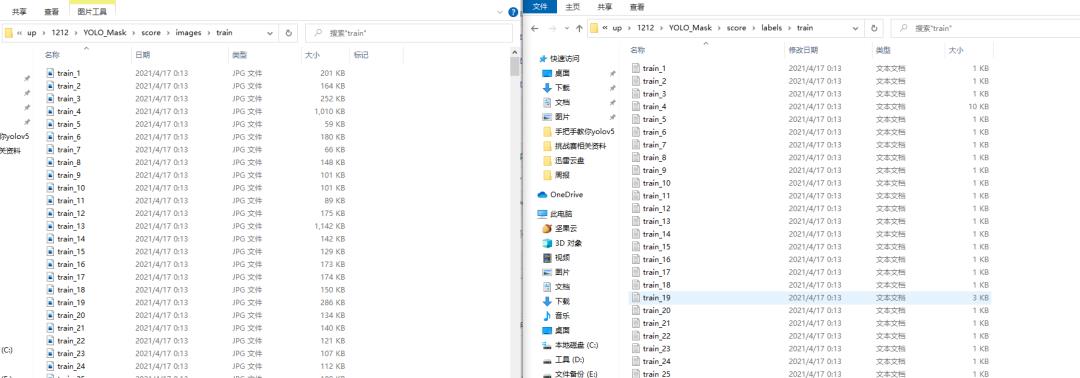

标注完成之后你会得到一系列的txt文件,这里的txt文件就是目标检测的标注文件,其中txt文件和图片文件的名称是一一对应的,如下图所示:

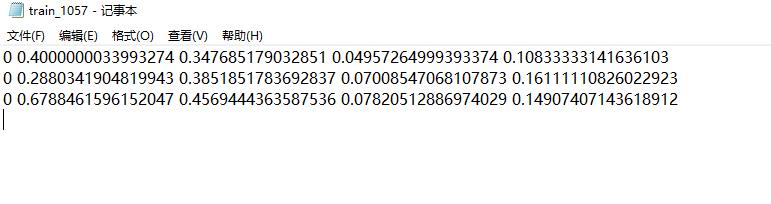

打开具体的标注文件,你将会看到下面的内容,txt文件中每一行表示一个目标,以空格进行区分,分别表示目标的类别id,归一化处理之后的中心点x坐标、y坐标、目标框的w和h。

4.修改数据集配置文件

标记完成的数据请按照下面的格式进行放置,方便程序进行索引。

YOLO_Mask

└─ score

├─ images

│ ├─ test # 下面放测试集图片

│ ├─ train # 下面放训练集图片

│ └─ val # 下面放验证集图片

└─ labels

├─ test # 下面放测试集标签

├─ train # 下面放训练集标签

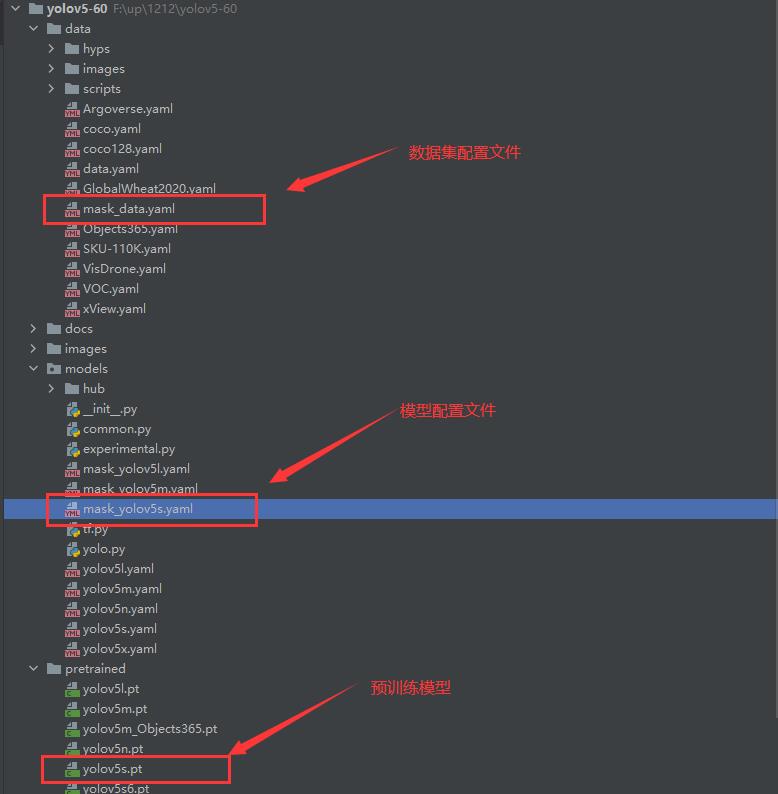

├─ val # 下面放验证集标签这里的配置文件是为了方便我们后期训练使用,我们需要在data目录下创建一个mask_data.yaml的文件,如下图所示:

到这里,数据集处理部分基本完结撒花了,下面的内容将会是模型训练!

模型训练

模型的基本训练

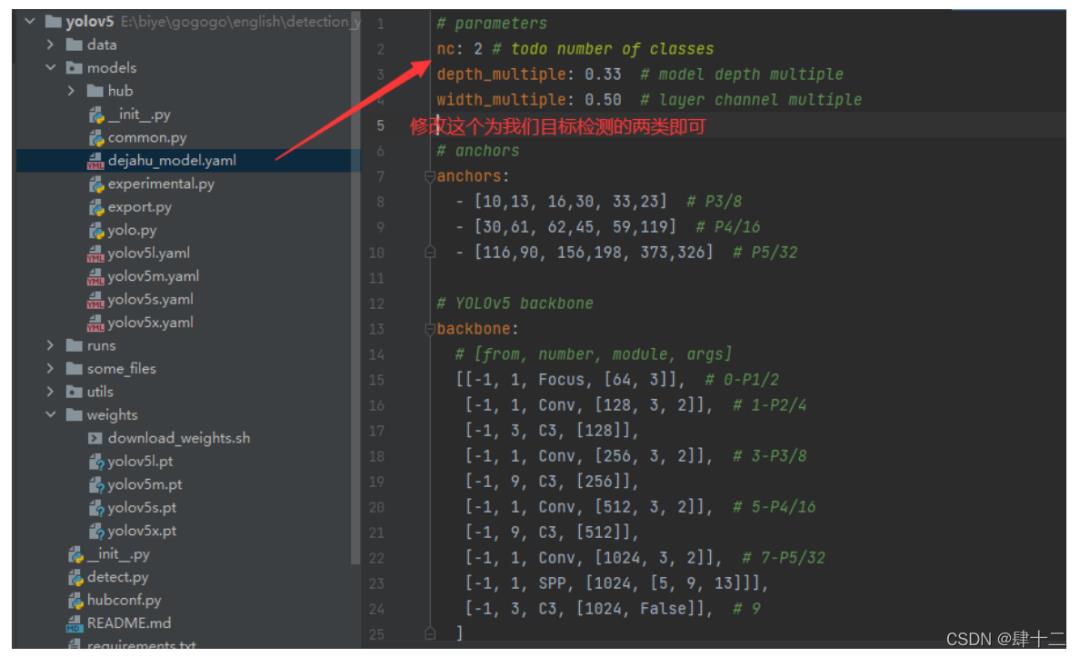

在models下建立一个mask_yolov5s.yaml的模型配置文件,内容如下:

模型训练之前,请确保代码目录下有以下文件

执行下列代码运行程序即可:

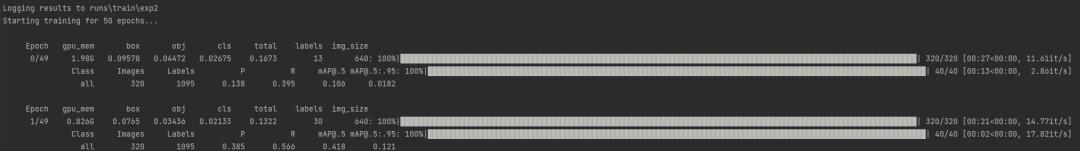

python train.py --data mask_data.yaml --cfg mask_yolov5s.yaml --weights pretrained/yolov5s.pt --epoch 100 --batch-size 4 --device cpu训练代码成功执行之后会在命令行中输出下列信息,接下来就是安心等待模型训练结束即可。

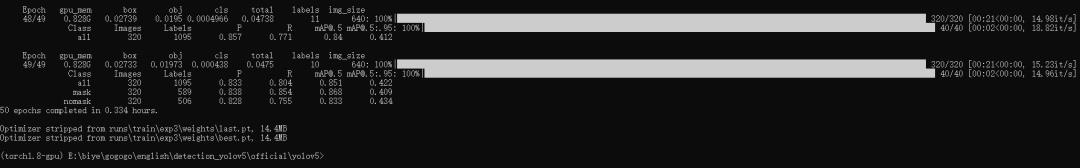

根据数据集的大小和设备的性能,经过漫长的等待之后模型就训练完了,输出如下:

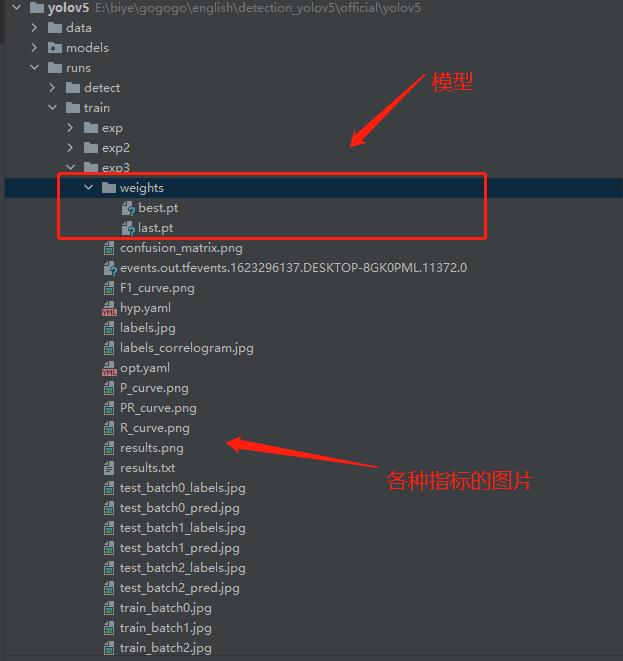

在train/runs/exp3的目录下可以找到训练得到的模型和日志文件

当然还有一些骚操作,比如模型训练到一半可以从中断点继续训练,这些就交给大家下去自行探索喽。

往

期

回

顾

技术

资讯

技术

资讯

分享

点收藏

点点赞

点在看

以上是关于手把手教你使用 YOLOV5 训练目标检测模型的主要内容,如果未能解决你的问题,请参考以下文章

手把手教你使用YOLOV5训练自己的目标检测模型-口罩检测-视频教程

深度学习目标检测---使用yolov5训练自己的数据集模型(Windows系统)

深度学习目标检测:YOLOv5实现红绿灯检测(含红绿灯数据集+训练代码)