Coursera-AndrewNg(吴恩达)机器学习笔记——第四周

Posted LoganGo

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Coursera-AndrewNg(吴恩达)机器学习笔记——第四周相关的知识,希望对你有一定的参考价值。

神经网络

1.神经网络发展的动力:在逻辑回归解决复杂的分类问题时,我们使用属性的一些组合来构造新的属性(x12,x1x2,x22...),这样就会造成属性的数目n过多,带来了大量的运算,甚至造成过拟合的现象。在计算机视觉中对物体进行识别,需要将图片的像素点作为属性,因此,属性的项目n将会十分的庞大。逻辑回归解决这类问题存在不足,这给神经网络提供了发展的动力。

2.神经网络的基础模型:

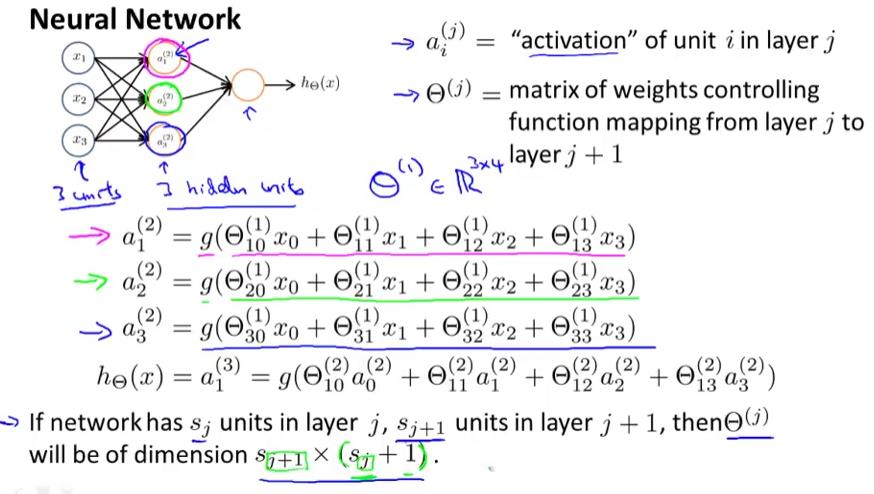

在神经网络模型中,第一层通常称为输入层,最后一层称为输出层,其它层称为隐藏层。如上图所示,在输入层中含有一个偏置x0,其值常为1.其他隐藏层对于其下一层来讲,也都存在一个常为1的偏置。我们通常用a(j)i表示第j层的,第i个神经元;用θ(j)表示第j层的参数(权重)矩阵,其维数为Sj+1*(Sj+1),其中,Sj+1表示为j+1层神经元的个数。维度的推到方式如下图所示:

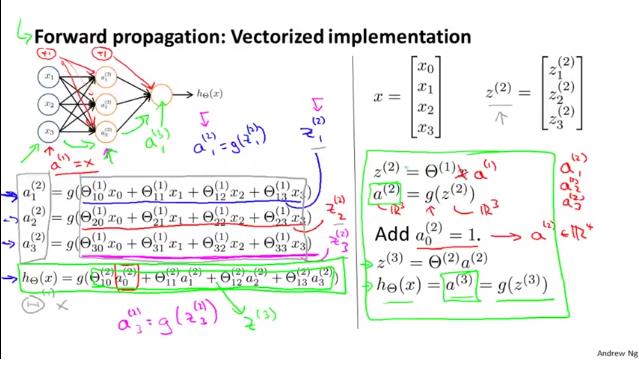

3.神经网络前向传播的向量化实现:注意除了输出层外,每一层都含有一个值为1的偏置!

每一次前向传播计算都是和逻辑回归方法相同,不同点在于,与逻辑回归的输入值不同,神经网络中的输入值,是上一层的输出值!每一隐藏层根据神经元的连接情况和θ值的设定,都实现了一个特定的功能。

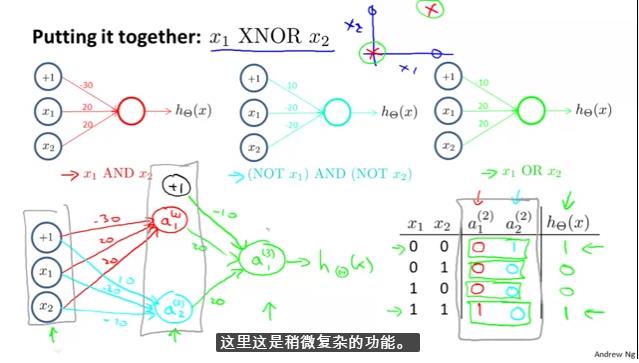

4.神经网络实现AND,NOR,OR运算,然后经过组合实现XOR运算!

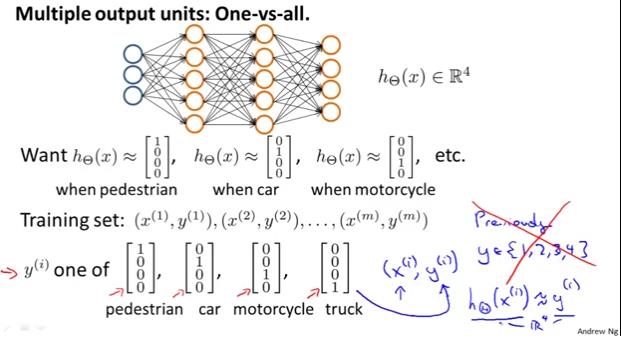

5.如何使用神经网络解决多分类问题?

本部分只是强调了,在多分类问题中,最终的预测值y(i)使用一个向量来表示,而不是一个单纯的数字。

以上是关于Coursera-AndrewNg(吴恩达)机器学习笔记——第四周的主要内容,如果未能解决你的问题,请参考以下文章

Coursera-AndrewNg(吴恩达)机器学习笔记——第四周

机器学习- 吴恩达Andrew Ng Coursera学习总结合集,编程作业技巧合集