为什么深度学习有效?(why deep learning works)

Posted 白菜hxj

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了为什么深度学习有效?(why deep learning works)相关的知识,希望对你有一定的参考价值。

总述:这篇文章是一次听讲座,吴大鹏教授做的why deep learning works,佛罗里达大学教授,很有名。自己对该讲座做个理解。

一、深度学习的背景相关介绍

1、machine learning:一般的ml只针对线性分类,即只是一个linear methods。

2、neural networks:第二代神经网络,是对ml的一个发展,更好地非线性分类。通过BP算法,调参数,以误差和真实值为导向,修改一系列参数,让误差趋近于0,逼近真实值。但是一般的神经网络只能到3-5层,层数多了就不行了,高层的误差就不能传递到低层去了,在中间的时候,误差被消耗。(the gradient becomes smaller and smaller in lower layers in back propagation)

3、kernel method:第三代就是核函数,这里最出名的就是高斯核函数了,对第一代的Ml算法,都加上核函数,效果要好的多。

3.5、deep learning:dp只能是第3.5代,还不能算成第四代,因为对里面的数学原理现在还没发强有力的解释。

a)dl是基于多层的神经网络

b) 是依赖kernel 和线性化的

c)更高层次的抽像能够帮助抓住相关和不变的特征。capture relevant and invariant

二、why it works?

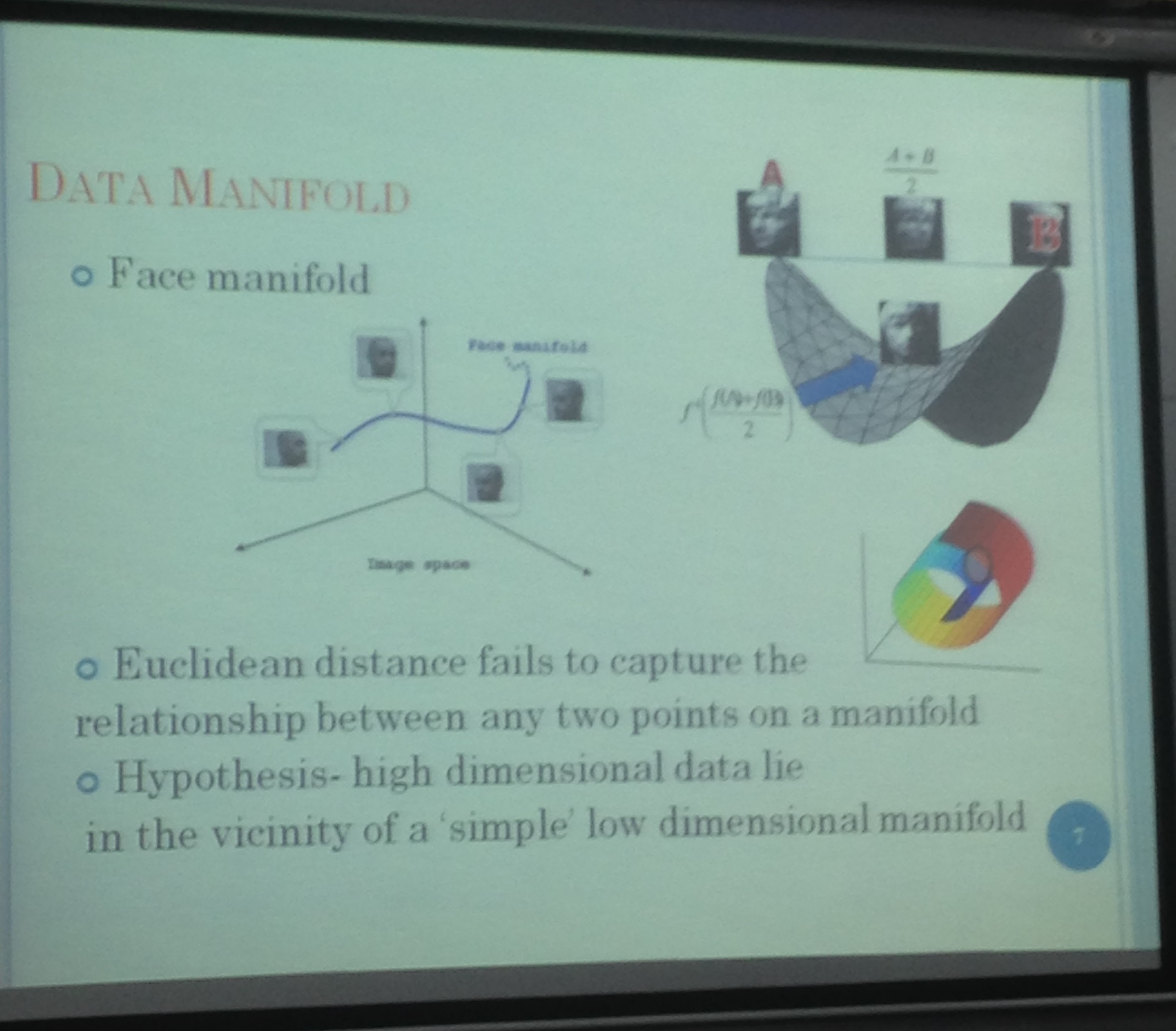

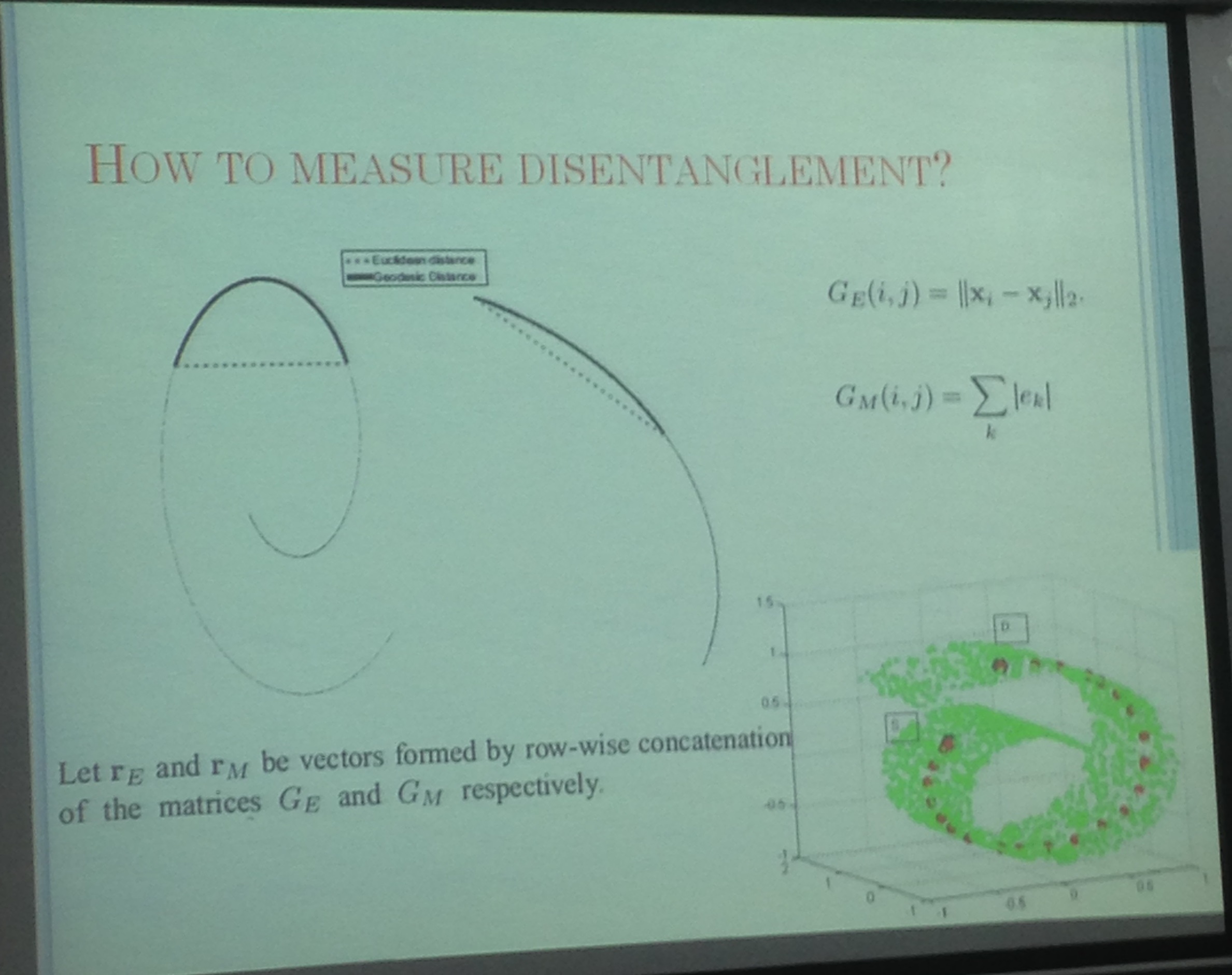

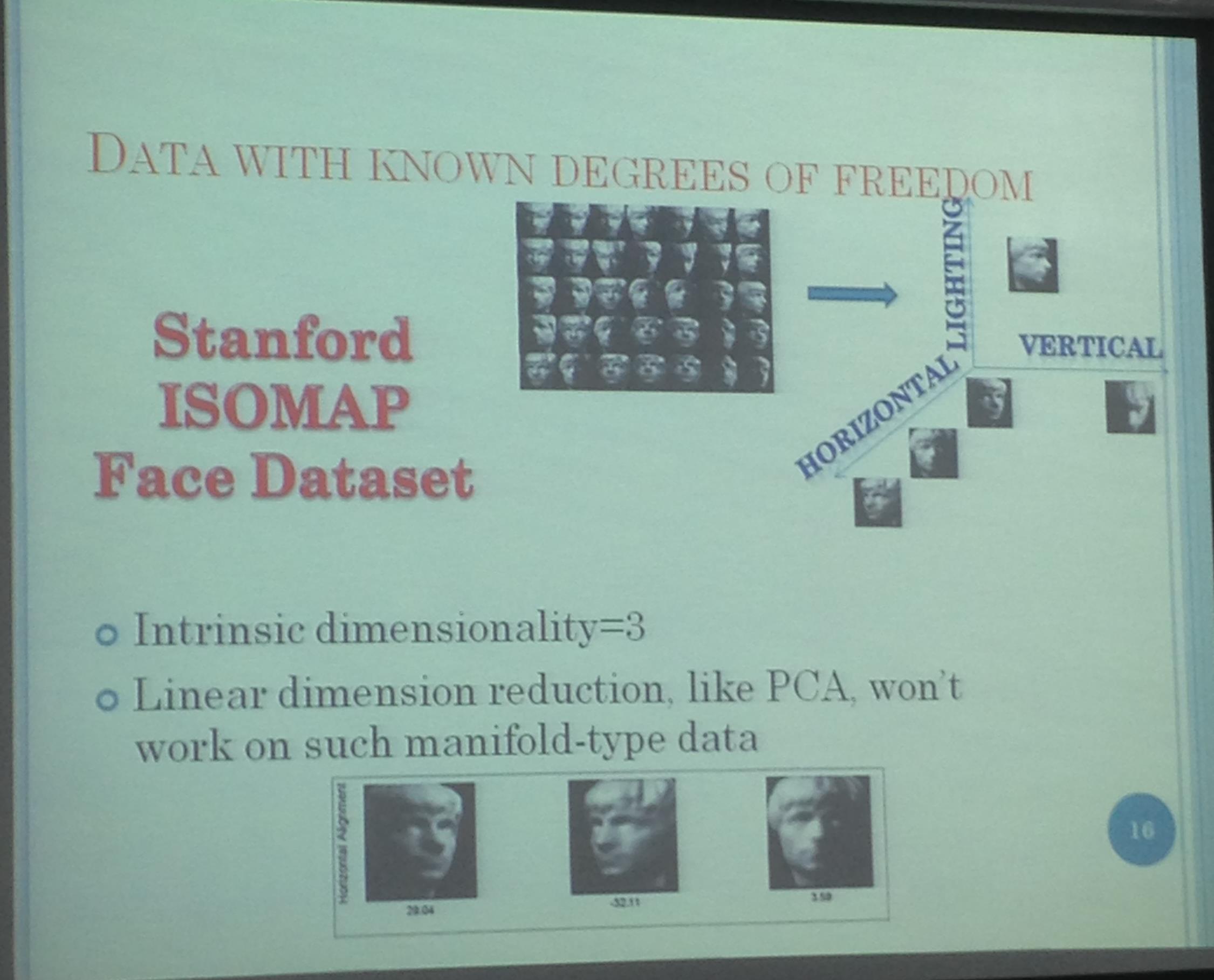

这涉及到微分几何里面的流行曲面。以人脸识别为例,一个人的各种表情,比如哭,笑,这些照片在多维空间里就组合成一个流行曲面,这是距离就不能用欧几何来算了。比如,从成都到北京,欧几何就是两点之间的距离,穿过地球,但是这时的距离应该是沿着地球表面经过的距离。

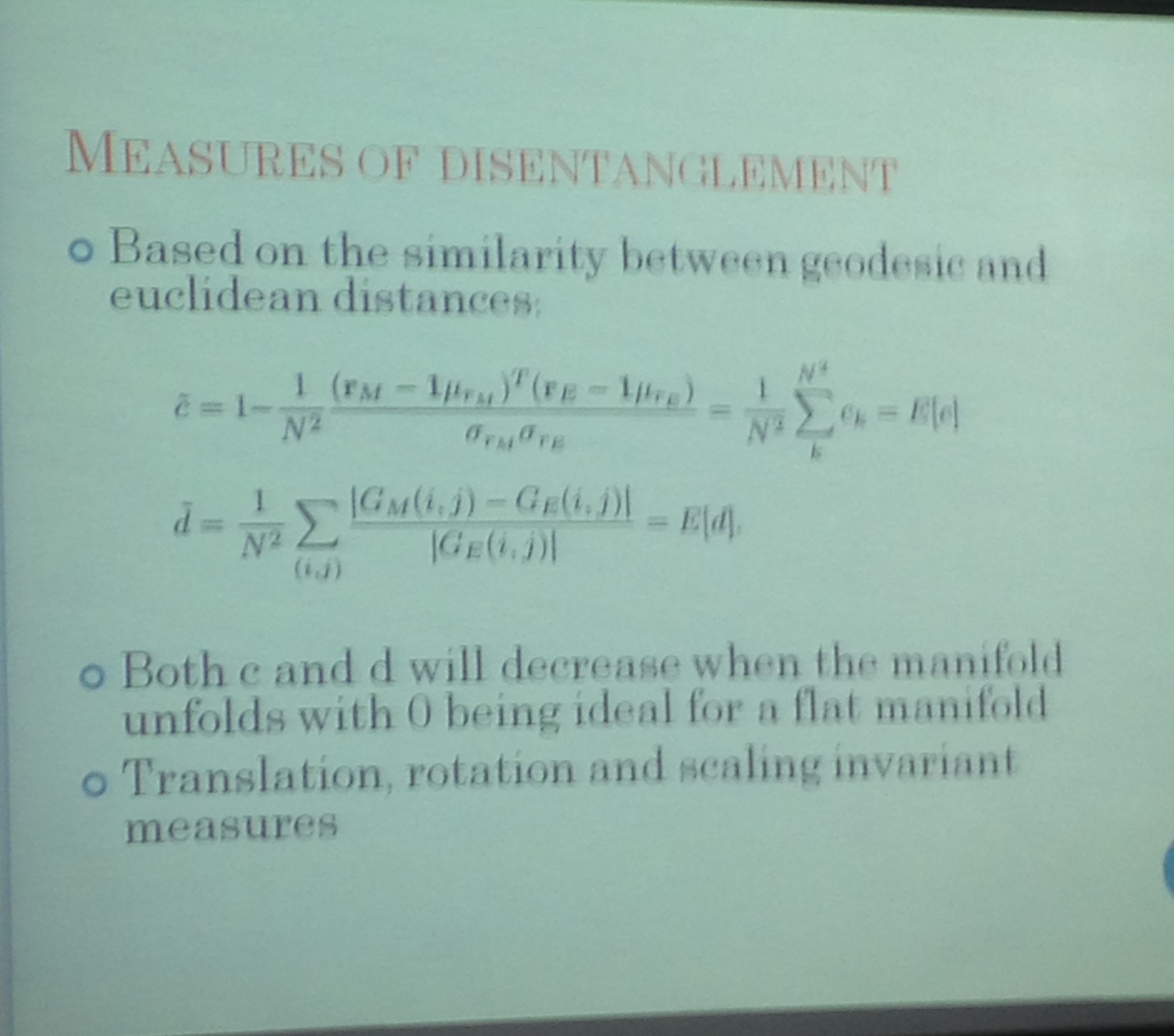

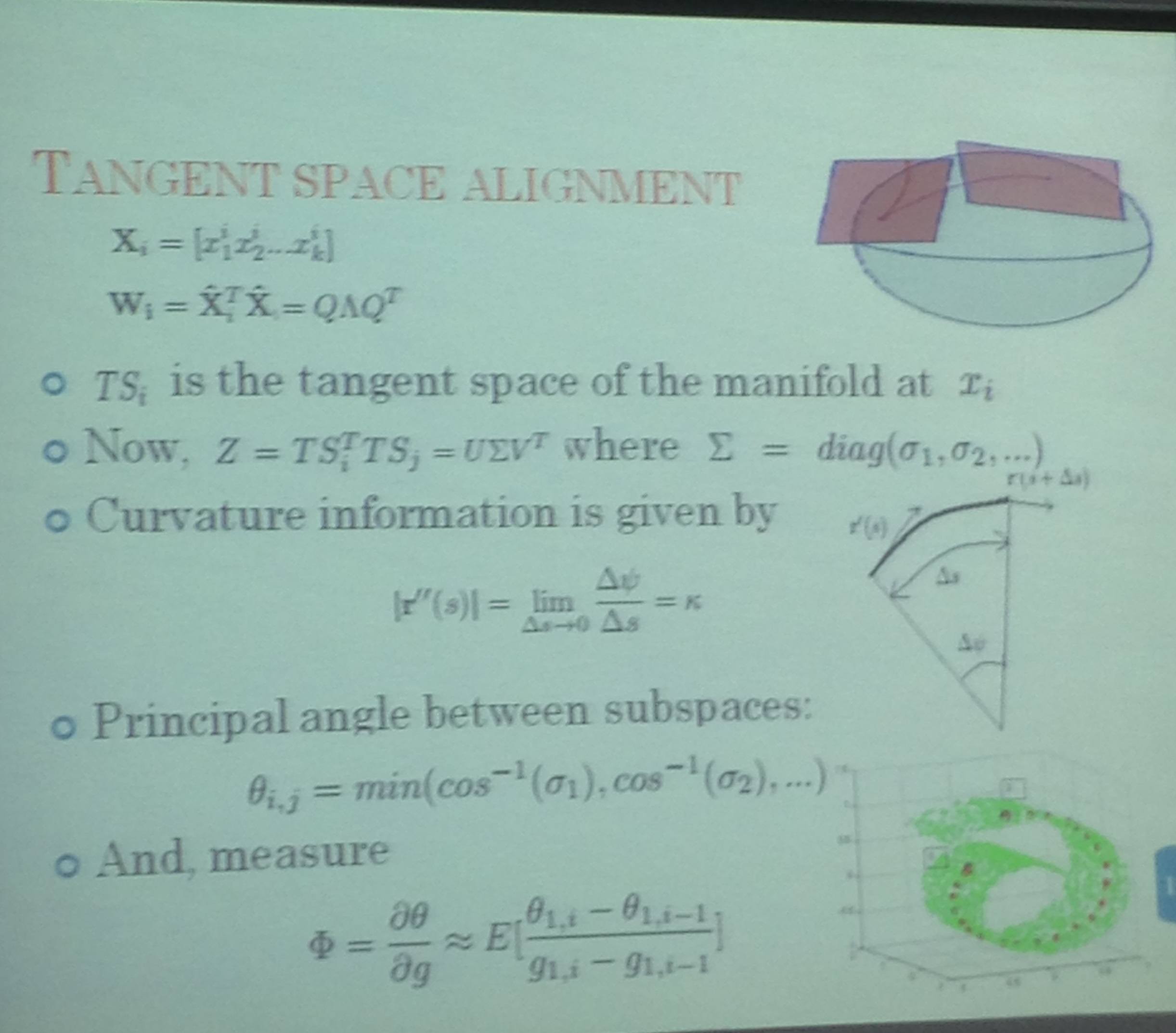

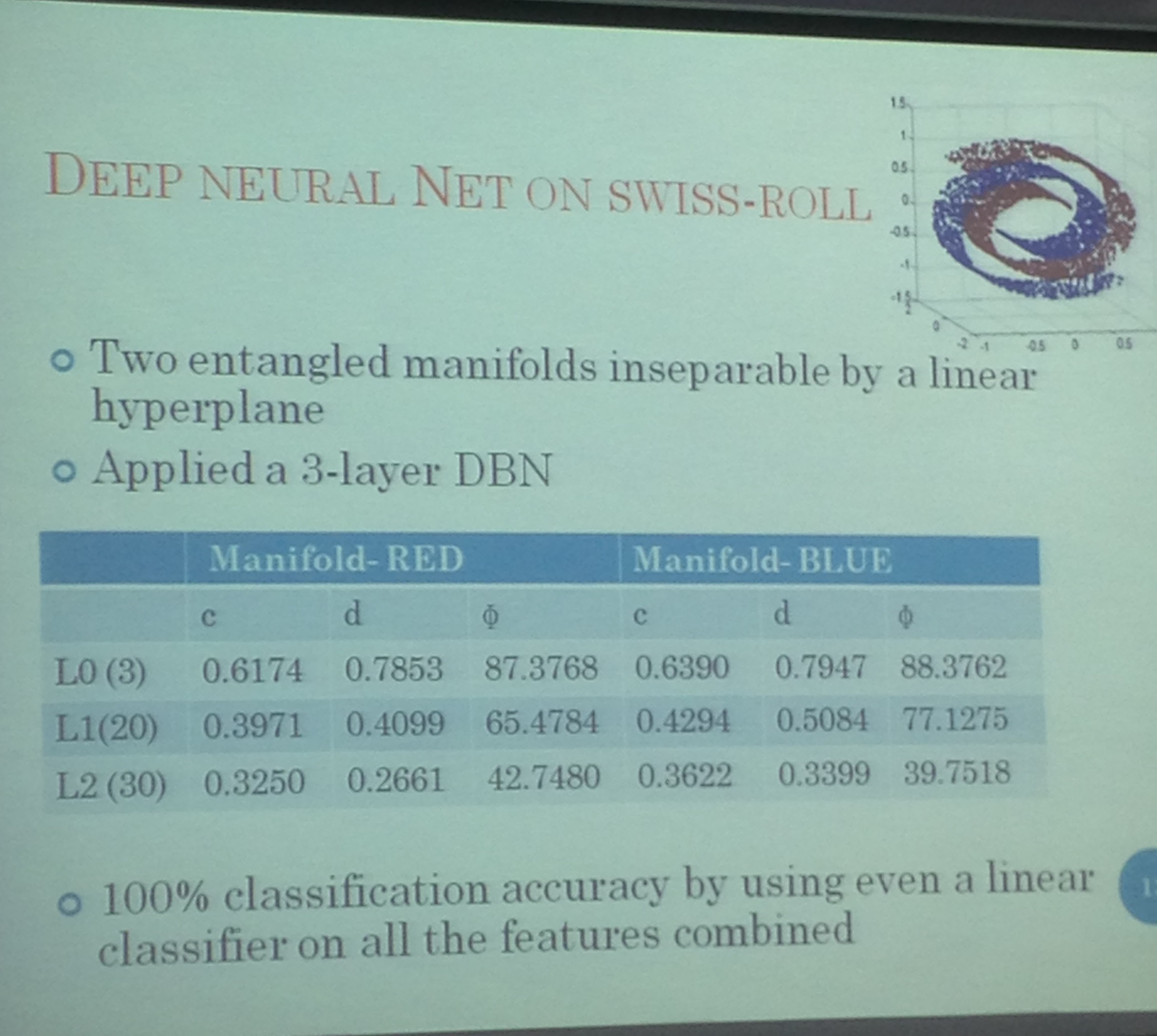

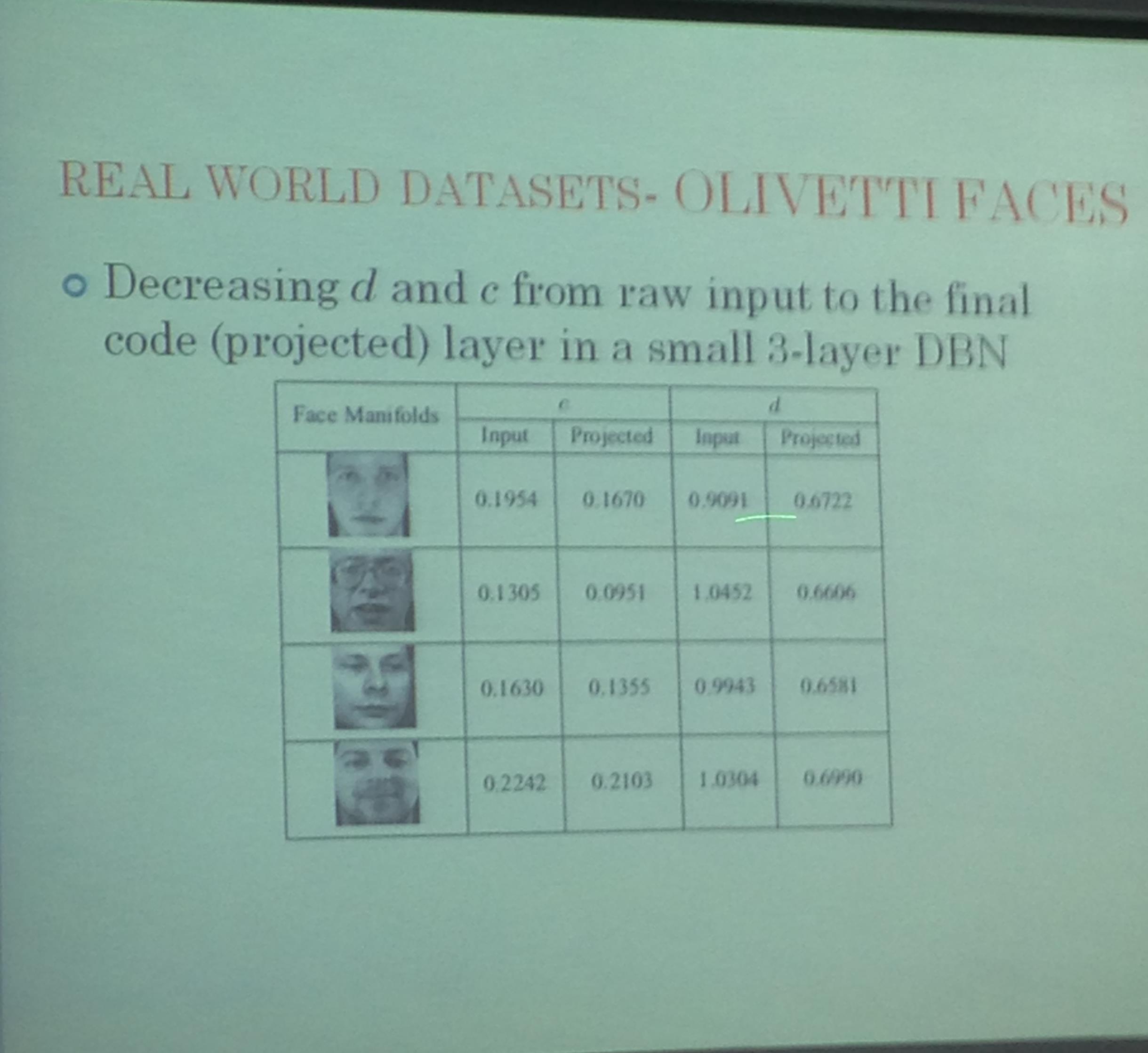

一系列的数学公式表示没看懂,大致的意思就是深度学习会将流行曲面的曲率降低,这样就便于分类。一个形象的例子就是卷心菜被展平,这样就好分类了。下图是一个结果图,用实验来证明曲率降低:

深度学习在训练的时候,先让数据自己学习一会儿,自己学习就会抓住一些不变量和数据本质特征,然后监督学习在高层发挥其效果。

先用deeping learning 展平,在用pca线性分类器

以上是关于为什么深度学习有效?(why deep learning works)的主要内容,如果未能解决你的问题,请参考以下文章

Deep Learning(深度学习)之Deep Learning学习资源

Spark MLlib Deep Learning Deep Belief Network (深度学习-深度信念网络)2.3