逐点互信息PMI(Pointwise mutual information)5发

Posted hanxuexi

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了逐点互信息PMI(Pointwise mutual information)5发相关的知识,希望对你有一定的参考价值。

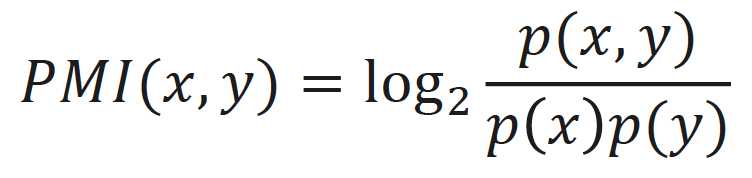

逐点互信息(PIM):用来衡量两个事物的相关性

定义如下:

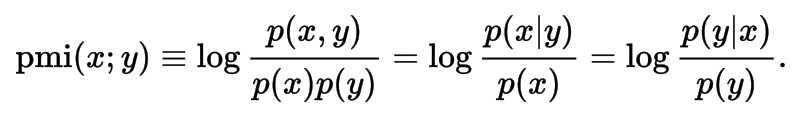

在概率论中,我们知道,如果x跟y不相关,则 P(x,y) = P(x)P(y)。二者相关性越大,则 P(x,y) 就相比于 P(x)P(y) 越大。根据条件概率公式,你还可以写成

这也很好理解,在y出现的情况下x出现的条件概率 p(x|y) 除以x本身出现的概率 p(x) ,自然就表示x跟y的相关程度。

这里的log来自于信息论的理论,而且 log 1 = 0 ,也恰恰表明P(x,y) = P(x)P(y),相关性为0,而且log是单调递增函数,所以 “P(x,y) 就相比于 P(x)P(y) 越大,x 和 y 相关性越大” 这一性质也得到保留

原文链接:https://blog.csdn.net/baimafujinji/article/details/6509820

以上是关于逐点互信息PMI(Pointwise mutual information)5发的主要内容,如果未能解决你的问题,请参考以下文章

机器学习特征筛选:互信息法(mutual information)