机器学习特征筛选:互信息法(mutual information)

Posted Data+Science+Insight

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习特征筛选:互信息法(mutual information)相关的知识,希望对你有一定的参考价值。

机器学习特征筛选:互信息法(mutual information)

互信息法多为分类问题的分类变量的筛选方法

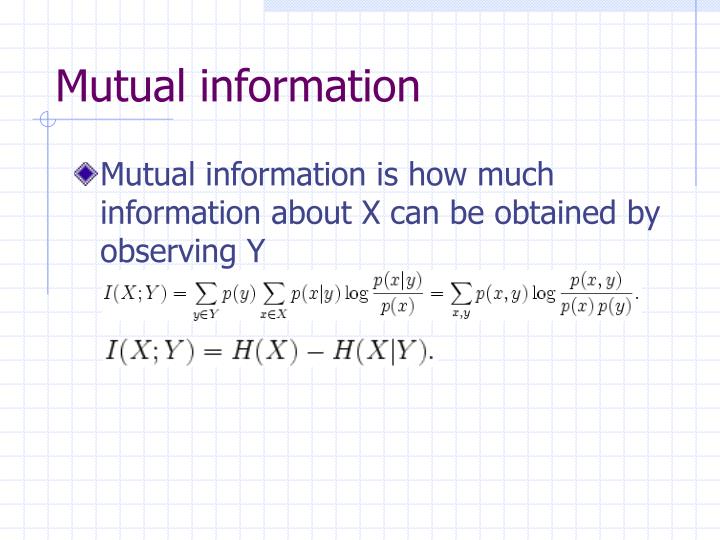

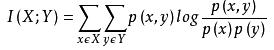

经典的互信息也是评价定性自变量对定性因变量的相关性的,为了处理定量数据,最大信息系数法被提出,互信息计算公式如下:

# mutual information

# 互信息法

# 自己手写理论公式实现功能

# np.where(condition, x, y)

# 满足条件(condition),输出x,不满足输出y。

# numpy.intersect1d(ar1, ar2, assume_unique=False) [资源]

# 找到两个数组的交集。

# 返回两个输入数组中已排序的唯一值。

# math.log(x[, base])

# x -- 数值表达式。

# base -- 可选,底数,默认为 e

def MI_and_NMI():

import math

from sklearn import metrics

A = np.array([1,1,1,1,1,1,2,2,2,2,2,2,3,3,3,3,3])

B = np.array([1,2,1,1,1,1,1,2,2,2,2,3,1,1,3,3,3])

N, A_ids, B_ids = len(以上是关于机器学习特征筛选:互信息法(mutual information)的主要内容,如果未能解决你的问题,请参考以下文章