机器学习-线性回归(基于R语言)

Posted grayling

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习-线性回归(基于R语言)相关的知识,希望对你有一定的参考价值。

基本概念

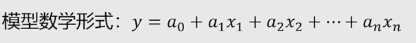

利用线性的方法,模拟因变量与一个或多个自变量之间的关系。自变量是模型输入值,因变量是模型基于自变量的输出值。

因变量是自变量线性叠加和的结果。

线性回归模型背后的逻辑——最小二乘法计算线性系数

最小二乘法怎么理解?

它的主要思想就是求解未知参数,使得理论值与观测值之差(即误差,或者说残差)的平方和达到最小。在这里模型就是理论值,点为观测值。使得拟合对象无限接近目标对象。

一元线性回归与多元线性回归

自变量只有一个的时候叫一元线性回归,自变量有多个时候叫多元线性回归。

R语言实现

bike.data <- read.csv("Shared Bike Sample Data - ML.csv")

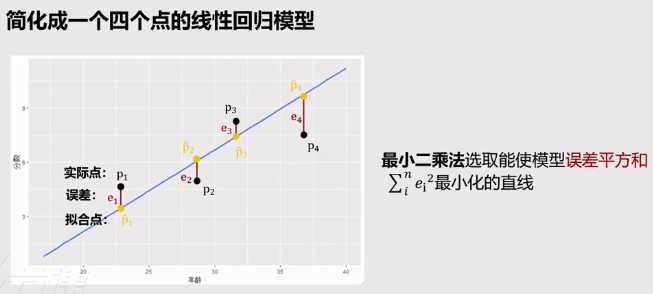

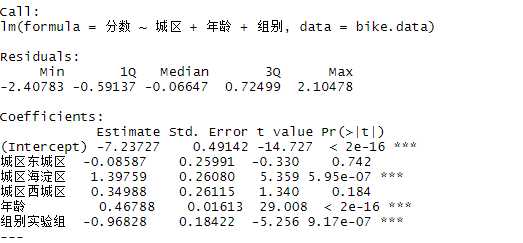

lm(formula = 分数 ~ 城区 + 年龄 + 组别, data = bike.data)

summary(lm_fit)

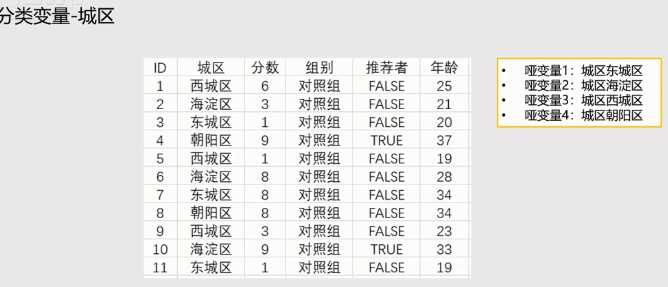

上面变量中城区 缺少 朝阳区,组别 缺少对照组。原因是由所有分类变量组成的哑变量中,有一个作为参考系不出现在线性回归结果中。

补充材料——哑变量

哑变量,取值为0或者1的变量,它将分类变量转换为数值变量,进而可以输入到线性回归模型中。在输入模型前将一个分类变量转换为多个哑变量。

在实际操作中遇到分类变量怎么办?

举例:

以上是关于机器学习-线性回归(基于R语言)的主要内容,如果未能解决你的问题,请参考以下文章

R语言基于线性回归(Linear Regression)进行特征筛选(feature selection)

R语言plotly可视化:使用plotly可视化简单线性回归模型的回归线对比不同参数设置下的同一机器学习模型算法的拟合曲线三维回归曲面可视化实际值和回归预测值的散点图残差分析