爬虫实战-疫情数据获取

Posted 程序员唐丁

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了爬虫实战-疫情数据获取相关的知识,希望对你有一定的参考价值。

前段时间南京疫情爆发,唐丁需要每天关注一下疫情数据,一想到还要打开app,然后翻到指定页面,还得查找对应城市的数据我就头疼。所以就写了一个爬虫程序。每天定时抓取江苏所有城市的疫情数据,然后将有新增病例的城市数据自动发到我的邮箱。感觉棒极了~~

废话不多说,下面讲解一下爬取的过程:

一、抓包获得数据接口

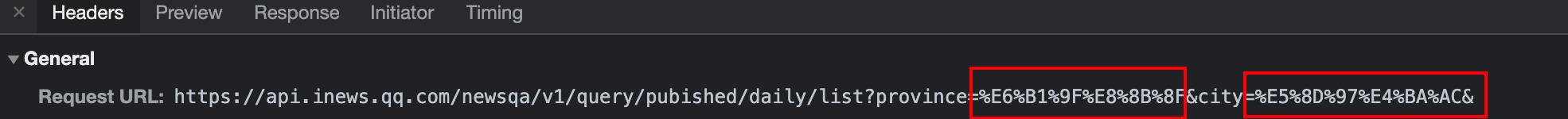

本次数据来源于腾讯新闻

经过分析,我找到了疫情数据返回的接口,红框部分对应我们需要查询的省份和城市。

嗯,返回的数据还是json格式的,那解析过程就很简单了~~

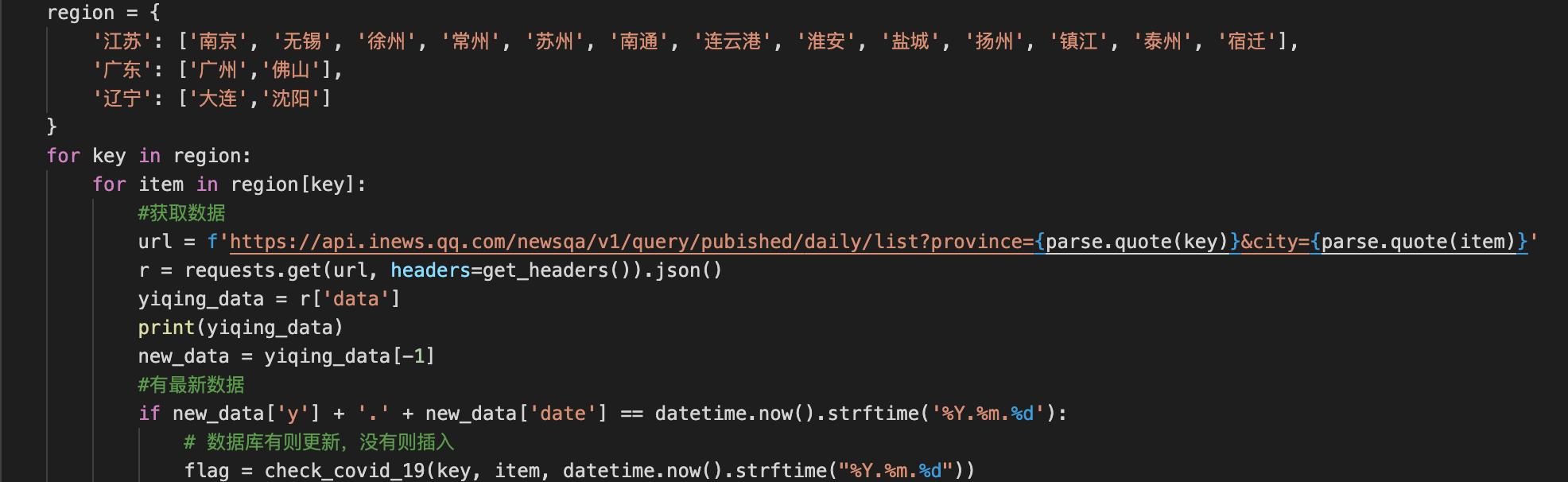

二、获取并解析数据

唐丁将江苏所有的城市放在字典里,分别向接口查询这些城市的信息,因为我发现返回的数据时相应城市一个月左右的数据,所以我每次只提取当天部分的数据。具体代码如下:

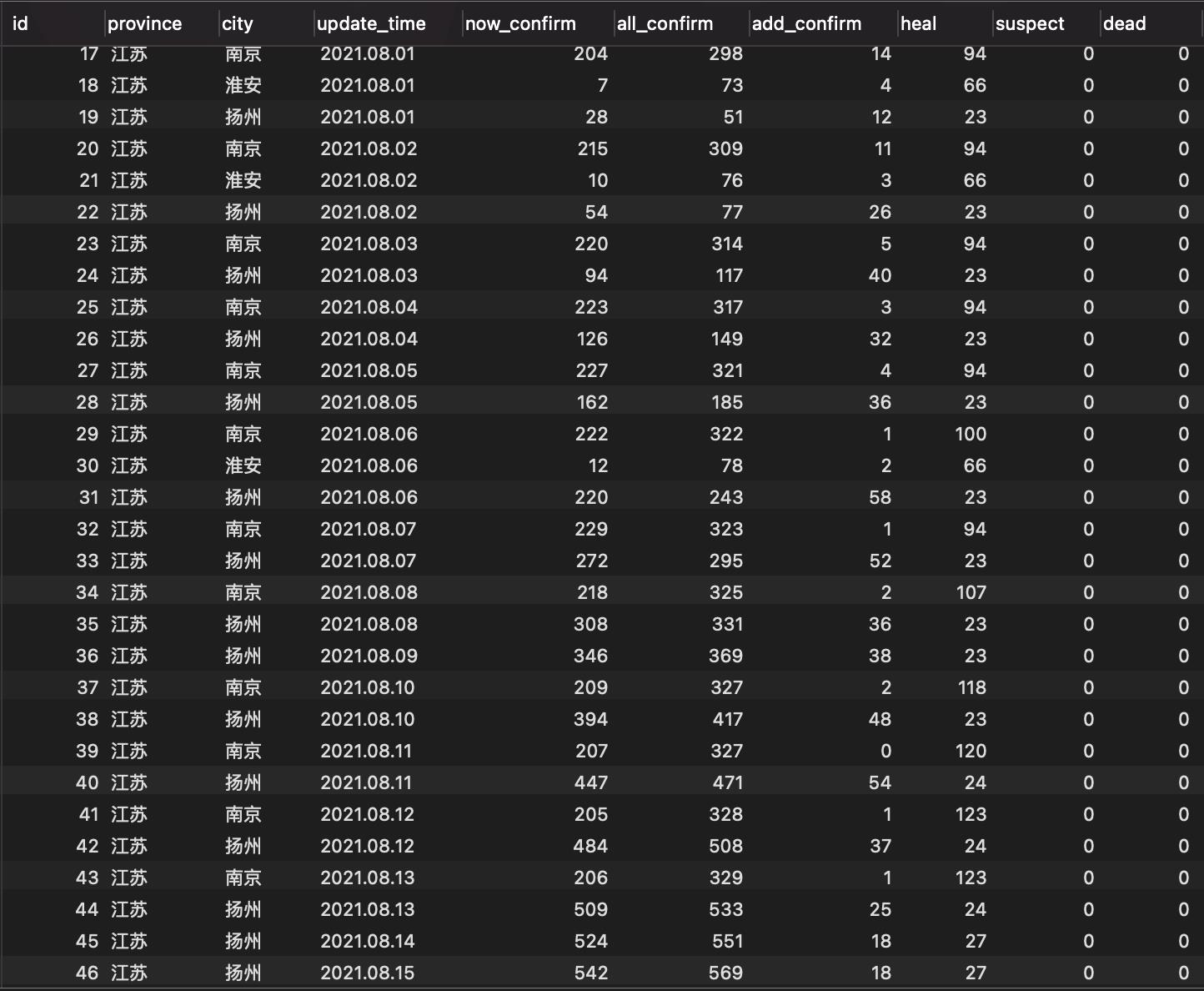

三、将数据分批存入数据库

由于接口返回的数据包括现有确诊数、死亡数、治愈数、疑似数等,因此唐丁在数据库的表中也建立了相应的字段用来存储这些数据:

这是唐丁从8月初以来获取的江苏疫情数据,后面我会将其用一些图表进行可视化展示。

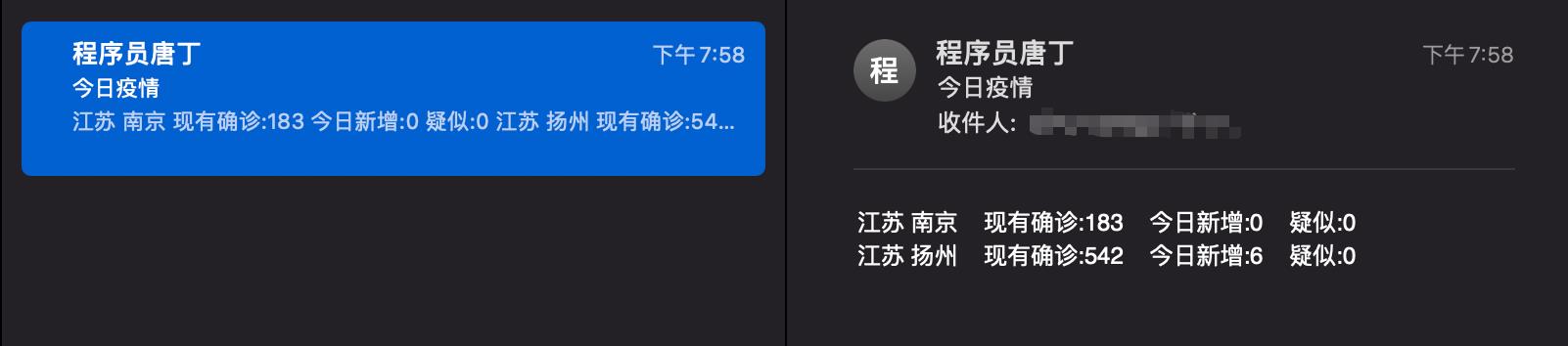

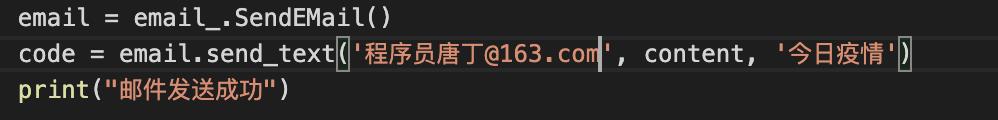

四、邮件自动发送疫情数据

唐丁将疫情数据爬取系统部署在了服务器,每天9点半、13点、20点定时获取更新数据。一旦有更新数据便会自动同步发送到我的邮箱,这样我就可以很方便的知道每天的疫情数据了~~

邮件发送的教程之前唐丁已经发布过了,有兴趣的伙伴可以自己再去看一下。今天就到这里了,更多实战项目唐丁后面会继续更新~~详细代码请在公众号发送“疫情代码”获得。

以上是关于爬虫实战-疫情数据获取的主要内容,如果未能解决你的问题,请参考以下文章