激活函数总结

Posted douliyoutang01

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了激活函数总结相关的知识,希望对你有一定的参考价值。

参考:

https://blog.csdn.net/weixin_42057852/article/details/84644348

https://blog.csdn.net/akenseren/article/details/80808527

激活函数的作用:

使用激活函数,添加了非线性因素,使得网络可以逼近任意非线性函数。

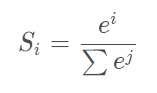

softmax函数

适用场景:多分类,类别间互斥

特点:输入为一维向量,输出映射到[0, 1],输出结果之和为1。可以简单的将输出结果值认为是概率。

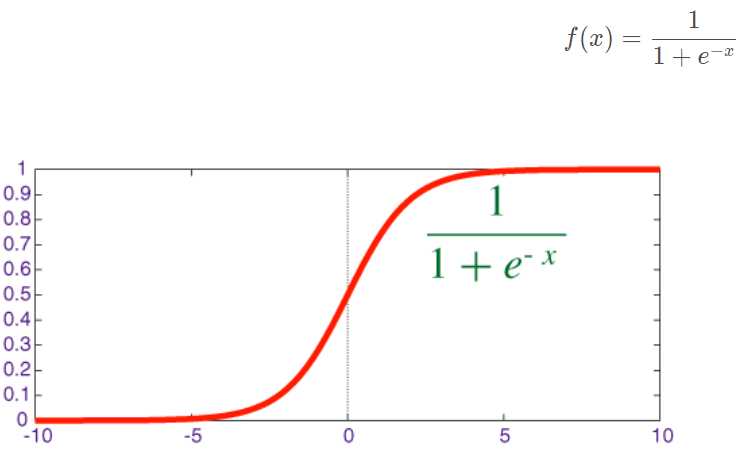

sigmoid函数(又称logistic回归)

适用场景:二分类

特点:输入为单个数值, 输出映射到(0, 1),输出均值大于0,结果之和为一个正数。

优点:在特征相差比较复杂或是相差不是特别大时效果比较好。

缺点:计算量大;反向传播的时候容易出现梯度消失的情况(软饱和性)。

现在不常用了

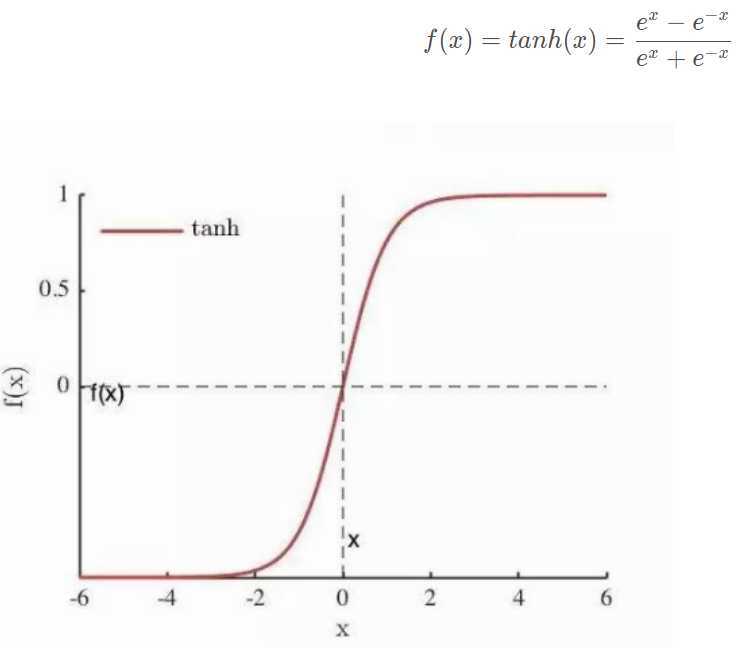

tanh函数

特点:输出映射到(-1, +1),均值为0。

优点:在特征相差明显时效果较好

缺点:当神经网络层数变多时,tanh函数(软饱和性)会出现梯度消失问题。

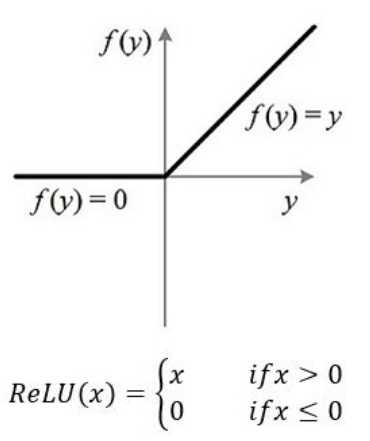

Relu函数

特点:输出映射到[0,+∞ )

优点:缓解了梯度消失问题。

缺点:随着训练的推进,会出现部分权重无法更新——神经元死亡的问题;输出均值大于0(偏移现象)。

现在经常使用,但是在设置学习率时应小心。

以上是关于激活函数总结的主要内容,如果未能解决你的问题,请参考以下文章