Pytorch中LayerNorm的使用

Posted 禾木呈风

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Pytorch中LayerNorm的使用相关的知识,希望对你有一定的参考价值。

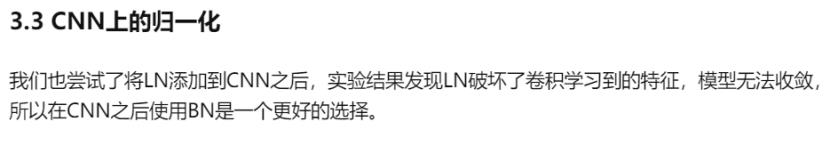

LayerNorm和BatchNorm相比,与一次传入网络的size大小无关,这一点与GroupNorm相似。

经过一番搜索以后,发现可能确实不适用于卷积神经网络中。

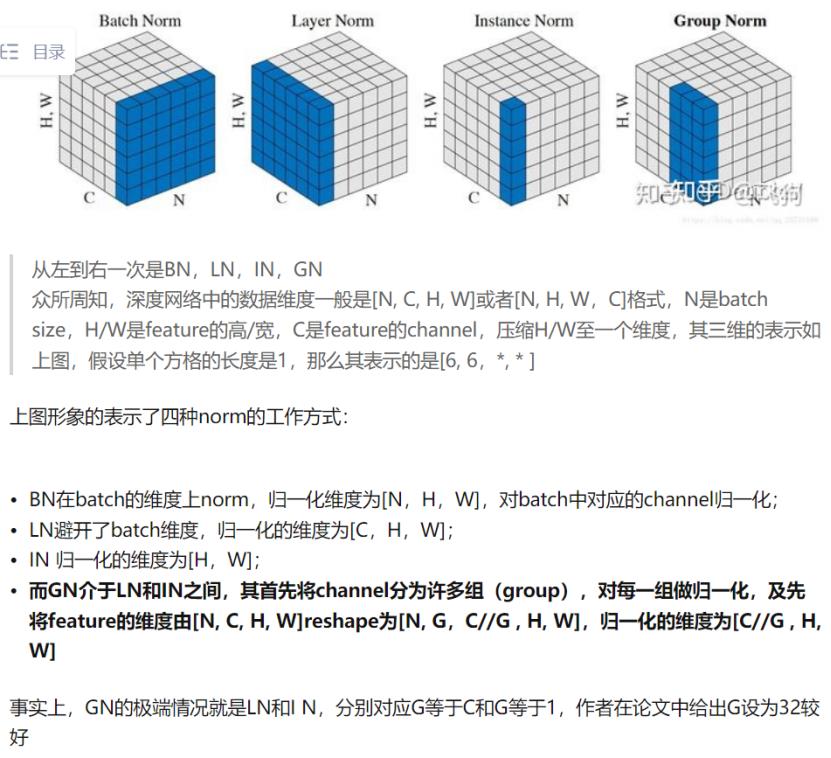

更直接的劝退原因是,最近不是很想学深度学习,只想毕业,所以三心二意之下搞不明白LayerNorm怎么使用。不是很能明白下图中的LayerNorm的参数,假设传入[3, 5, 5]的张量,设置为5可以,设置为[5, 5]也可以,不是特别能理解。而且我希望的是按照通道一层层的进行...不管了,大家都说不行肯定不行,就这样和老师汇报吧。

以上是关于Pytorch中LayerNorm的使用的主要内容,如果未能解决你的问题,请参考以下文章

pytorch 学习:layer normalization

deep_thoughts45_BatchNormLayerNormInstanceNormGroupNorm原理及pytorch手写实现API