机器学习K-邻近算法的python 实现

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习K-邻近算法的python 实现相关的知识,希望对你有一定的参考价值。

#!/usr/bin/python # -*- coding: utf-8 -*- from numpy import * import operator def createDataSet(): ‘创建数据集‘ group=array([[1.0,1.1],[1.0,1.0],[0,0],[0,1.1]]) labels=["A","A","B","B"] return group,labels def classify(inX,dataSet,labels,k): # 获取维度 dataSetSize=dataSet.shape[0] # 训练数据集数量 print dataSetSize print tile(inX,(dataSetSize,1)) diffMat=tile(inX,(dataSetSize,1))-dataSet # 测试样本的各维度的差值 print diffMat sqDiffMat=diffMat**2 # 平方计算 print sqDiffMat sqDistance=sqDiffMat.sum(axis=1) # 输出每行的值 print sqDistance distances=sqDistance**0.5 # 开方计算 print distances sortedDistances=distances.argsort() # 排序 按距离从小到大 输出索引 print sortedDistances classCount={} for i in range(k): voteIlabel=labels[sortedDistances[i]] classCount[voteIlabel]=classCount.get(voteIlabel,0)+1.0 sortedClassCount=sorted(classCount.iteritems(),key=operator.itemgetter(1),reverse=True) return sortedClassCount[0][0] group,labels=createDataSet() res=classify([1,1],group,labels,3) print res

一:什么是看KNN算法?

kNN算法全称是k-最近邻算法(K-Nearest Neighbor)

kNN算法的核心思想是如果一个样本在特征空间中的k个最相邻的样本中的大多数属于某一个类别,则该样本也属于这个类别,并具有这个类别上样本的特性。该方法在确定分类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。

下边举例说明:

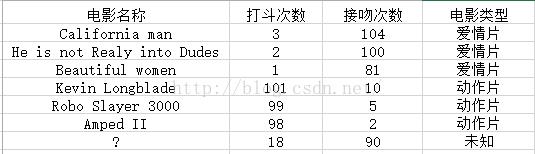

即使不知道未知电影属于哪种类型,我们也可以通过某种方法计算出来,如下图

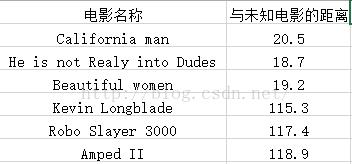

现在我们得到了样本集中与未知电影的距离,按照距离的递增顺序,可以找到k个距离最近的电影,假定k=3,则三个最靠近的电影是和he is not realy into Dudes,Beautiful women, California man kNN算法按照距离最近的三部电影类型决定未知电影类型,这三部都是爱情片,所以未知电影的类型也为爱情片

二:KNN算法的一般流程

step.1---初始化距离为最大值

step.2---计算未知样本和每个训练样本的距离dist

step.3---得到目前K个最临近样本中的最大距离maxdist

step.4---如果dist小于maxdist,则将该训练样本作为K-最近邻样本

step.5---重复步骤2、3、4,直到未知样本和所有训练样本的距离都算完

step.6---统计K-最近邻样本中每个类标号出现的次数

step.7---选择出现频率最大的类标号作为未知样本的类标号

三:距离公式

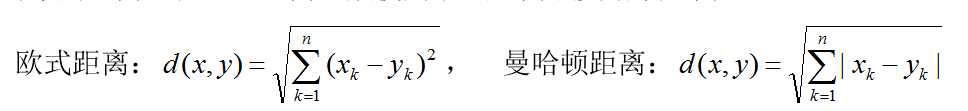

在KNN中,通过计算对象间距离来作为各个对象之间的非相似性指标,避免了对象之间的匹配问题,在这里距离一般使用欧氏距离或曼哈顿距离:

以上是关于机器学习K-邻近算法的python 实现的主要内容,如果未能解决你的问题,请参考以下文章