论文泛读188对抗自然语言词替换的鲁棒性

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读188对抗自然语言词替换的鲁棒性相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

论文链接:《Towards Robustness Against Natural Language Word Substitutions》

一、摘要

针对单词替换的鲁棒性具有定义明确且可广泛接受的形式,即使用语义相似的单词作为替换,因此它被认为是在自然语言处理中实现更广泛鲁棒性的基础。以前的防御方法通过使用l2-ball或超矩形来捕获向量空间中的单词替换,这导致扰动集不够包容或不必要的大,从而阻碍了鲁棒训练的最坏情况的模仿。本文介绍了一种新的对抗性稀疏凸组合(ASCC)方法。我们将单词替换攻击空间建模为凸包,并利用正则化项对实际替换实施扰动,从而使我们的建模更好地与离散文本空间相一致。基于ASCC方法,我们进一步提出了ASCC防御,它利用ASCC产生最坏情况的扰动,并结合了对抗训练的鲁棒性。实验表明,针对跨多模型架构的多种攻击,ASCC防御在情感分析和自然语言推理这两个主流自然语言处理任务上的鲁棒性优于当前技术水平。此外,我们还设想了一种新的针对自然语言处理鲁棒性的防御方法,在这种方法中,我们经过鲁棒训练的词向量可以插入到正常训练的模型中,并在不应用任何其他防御技术的情况下增强其鲁棒性。

二、结论

在本文中,我们提出了一种新的方法来使用凸包来捕获和防御对抗词替换。我们的方法产生的模型在数据集和架构上始终超越了现有技术。实验结果进一步表明,单词向量本身可能是脆弱的,我们的方法产生了健壮的单词向量,其可以在不应用任何其他防御技术的情况下增强鲁棒性。因此,我们希望这项工作可以成为NLP更广泛的稳健性的垫脚石。

三、模型

不同方法如何在向量空间中捕捉单词替换的可视化:

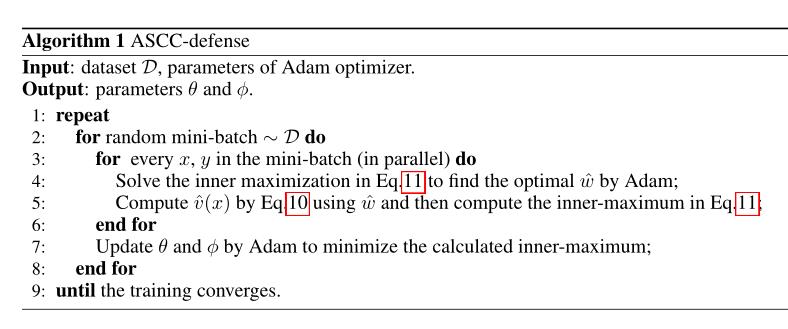

对抗训练过程:

- 制造对手

- 以对手为输入进行对抗训练

算法:

以上是关于论文泛读188对抗自然语言词替换的鲁棒性的主要内容,如果未能解决你的问题,请参考以下文章

论文泛读171具有对抗性扰动的自监督对比学习,用于鲁棒的预训练语言模型

论文泛读171具有对抗性扰动的自监督对比学习,用于鲁棒的预训练语言模型

论文泛读180反向翻译任务自适应预训练:提高文本分类的准确性和鲁棒性