论文泛读171具有对抗性扰动的自监督对比学习,用于鲁棒的预训练语言模型

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读171具有对抗性扰动的自监督对比学习,用于鲁棒的预训练语言模型相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

一、摘要

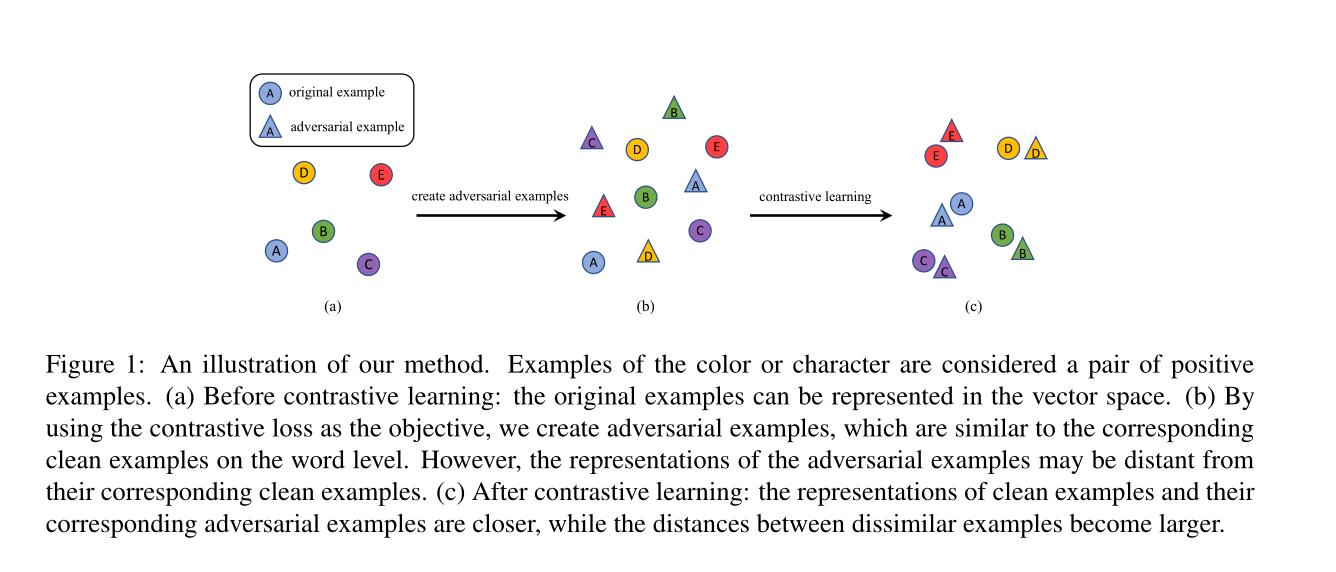

本文通过利用具有对抗性扰动的自监督对比学习,提高了预训练语言模型 BERT 对抗基于词替换的对抗性攻击的鲁棒性。与以前的工作相比,我们的方法的一个优点是它能够在不使用任何标签的情况下提高模型的鲁棒性。此外,我们还为 BERT 的词级对抗训练创建了对抗性攻击。这种攻击是有效的,允许对训练过程中动态生成的对抗性示例对 BERT 进行对抗性训练。在四个数据集上的实验结果表明,我们的方法提高了 BERT 对四种不同的基于词替换的对抗性攻击的鲁棒性。此外,为了理解为什么我们的方法可以提高模型对对抗性攻击的鲁棒性,我们在应用我们的方法之前和之后研究了干净示例及其相应对抗性示例的向量表示。由于我们的方法使用未标记的原始数据提高了模型的鲁棒性,它开辟了使用大型文本数据集来训练鲁棒语言模型的可能性。

二、结论

在本文中,我们提出使用自监督对比学习来提高预处理语言模型对基于词替换的对抗攻击的鲁棒性,在此过程中我们还利用对抗扰动。我们的方法不同于以前的工作,因为我们可以在不访问示例的注释标签的情况下提高模型的健壮性。此外,我们还对BERT进行了有效攻击的单词级对抗训练。我们的对抗性训练与以往作品的不同之处在于:(1)我们的对抗性训练是在词的层面上;(2)我们动态生成对抗性例子,而不是预先生成一组固定的对抗性例子。

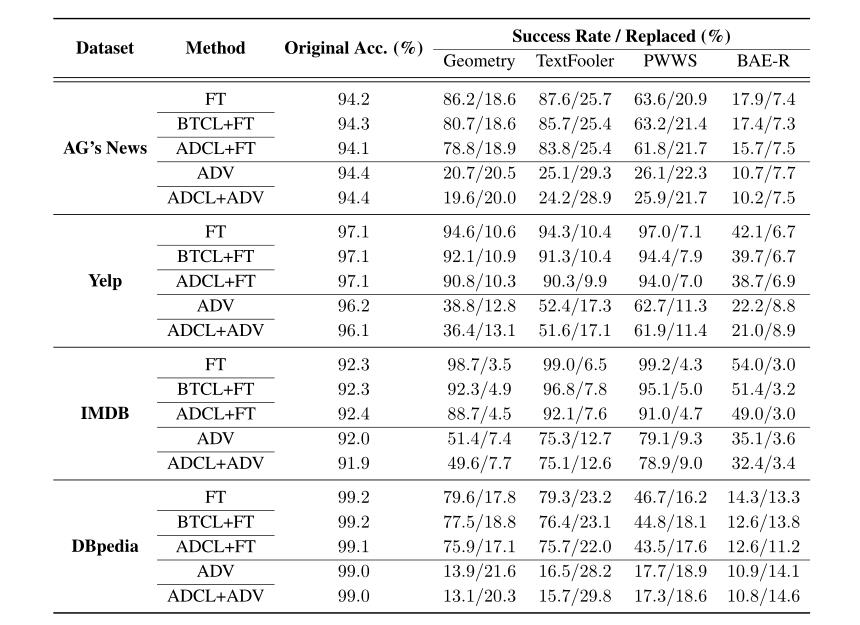

在四个数据集和四种攻击下的实验结果表明,该方法提高了模型的鲁棒性。我们还发现,将我们的方法与对抗训练相结合比单独进行对抗训练产生更好的鲁棒性。未来,我们计划将我们的方法扩展到更大的域外数据集,如维基百科。我们还计划通过利用其他对比学习方法来扩展我们的工作,如MoCoV2 (Chen等人,2020b),它不需要大批量来实现高性能。

- 通过利用自监督对比学习,我们提高了预训练语言模型BERT对基于单词替换的对抗性攻击的鲁棒性。

- 我们创建了一个对抗性攻击来为BERT进行单词级的对抗性训练。我们不是对预先生成的对抗性例子进行对抗性训练,而是通过为每一批即时生成对抗性例子来进行对抗性训练。

- 此外,我们对干净例子及其对应的敌对例子的向量表示的研究解释了为什么我们的方法提高了模型的鲁棒性。我们的研究还表明,自然语言处理对比学习受益于更大的批量。

- 域外实验证明了域外数据在自然语言处理对比学习中的有效性,这表明我们可以将我们的方法扩展到大规模的未标记数据集。

三、model

域内实验结果:

以上是关于论文泛读171具有对抗性扰动的自监督对比学习,用于鲁棒的预训练语言模型的主要内容,如果未能解决你的问题,请参考以下文章