论文泛读178通过对比对抗训练改进文本分类

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读178通过对比对抗训练改进文本分类相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

论文链接:《Improved Text Classification via Contrastive Adversarial Training》

一、摘要

我们提出了一种简单而通用的方法来规范基于Transformer的编码器的微调,用于文本分类任务。具体来说,在微调过程中,我们通过扰动模型的单词嵌入来生成对立示例,并对干净的和对立的示例执行对比学习,以便教导模型学习噪声不变的表示。通过对干净的和敌对的例子以及额外的对比目标的训练,我们观察到相对于干净例子的标准微调的一致改进。在几个GLUE基准测试任务中,我们的微调BERTaLarge模型的性能平均比BERTaLarge基线高1.7%,我们的微调RoBERTaLarge比RoBERTaLarge基线提高了1.3%。此外,我们还使用三个意向分类数据集在不同领域验证了我们的方法,其中我们的微调RoBERTaLarge比RoBERTaLarge基线平均高出1–2%。

二、结论

在本文中,我们描述了CAT,一种简单有效的方法,用于调整基于变压器的编码器的微调。通过利用对抗性训练和对比学习,我们的系统始终优于标准的文本分类微调方法。我们使用强基线模型,并在一系列GLUE基准任务和三个不同设置的意图分类数据集上评估我们的方法。样本效率和剔除测试显示了将我们的对抗性和对比性目标结合起来对改进文本分类的积极效果。未来,我们计划研究额外的单词级目标来补充句子级对比学习目标,以便将我们的方法扩展到其他自然语言处理任务。

三、架构

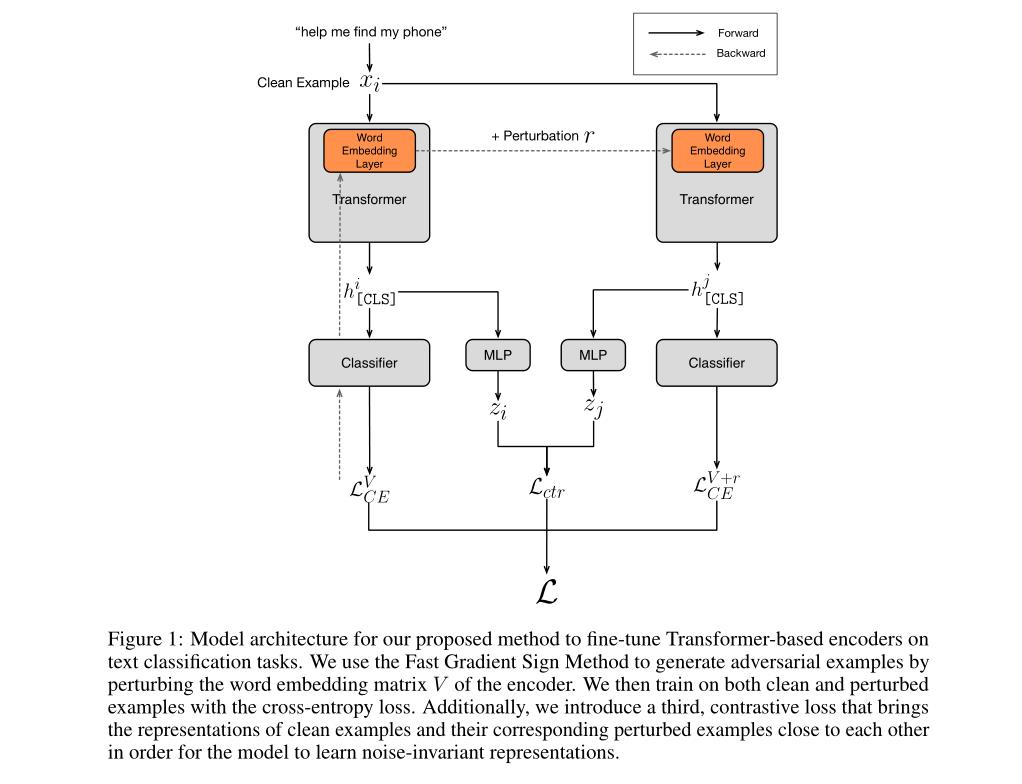

基于文本分类任务微调基于Transformer的编码器的方法的模型架构:

- 使用快速梯度符号方法,通过扰动编码器的单词嵌入矩阵V来生成对抗性例子。然后我们用交叉熵损失训练干净的和扰动的例子。此外,我们引入了第三种,对比损失,它使干净例子的表示和它们对应的扰动例子彼此接近,以便模型学习噪声不变的表示。

以上是关于论文泛读178通过对比对抗训练改进文本分类的主要内容,如果未能解决你的问题,请参考以下文章