如何阅读NLP论文

Posted LolitaAnn

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何阅读NLP论文相关的知识,希望对你有一定的参考价值。

Search papers and group them

检索工具

-

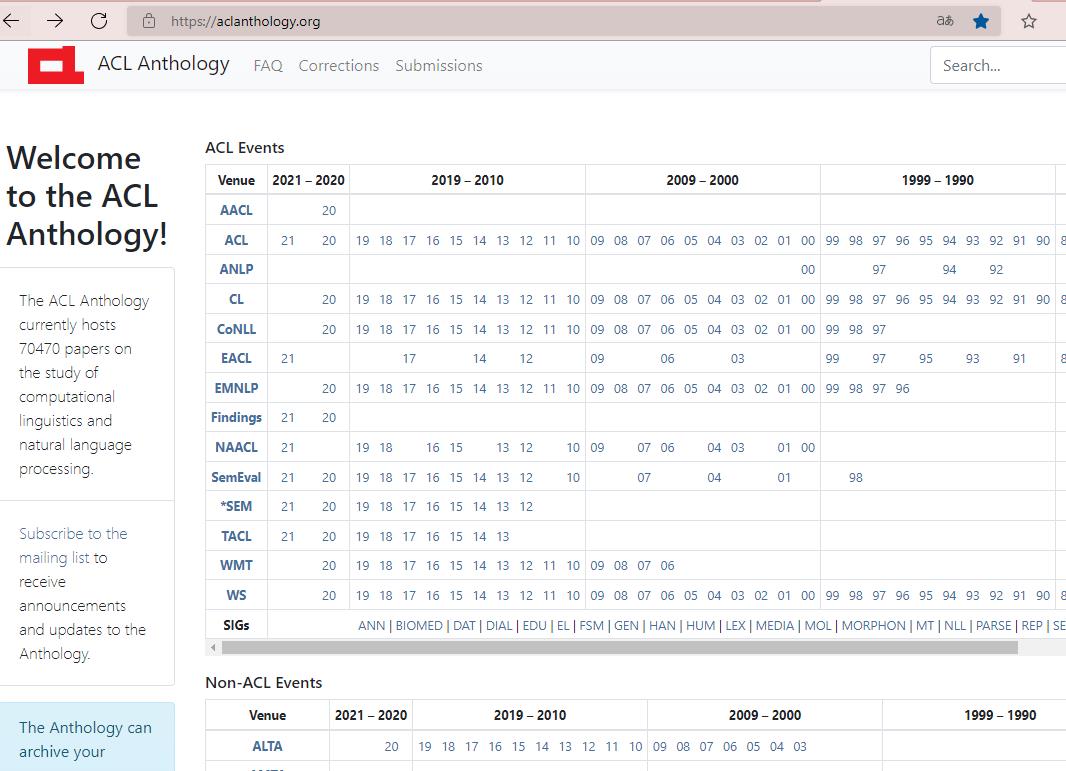

各种会议文章集合,连会议带年份。进去搜索自己需要的关键词即可。

当然会有延迟。并不是会议出来就直接能看到。 -

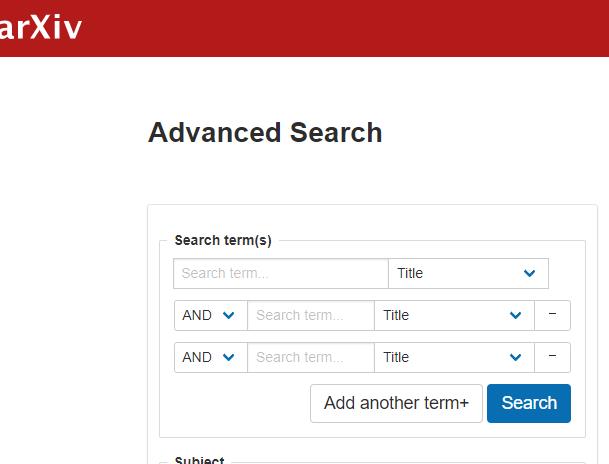

限定文献检索:arXiv

arXiv是由康奈尔大学运营维护的一个非盈利的数据库,由于免费,学术研究人员可以在其他顶会或者期刊没有录用之前,将自己最新的研究成果发布到该平台上,一方面是为了扩大宣传提升自己的影响力;另外一方面是为了保护自己的科研成果,因为无论会议和期刊从投出到最终可以检索,都需要长时间的等待,很难保证期间自己成果不被别人剽窃,arXiv可以证明论文的原创性。

-

知网啊、谷歌学术啊这些常用的一般都用不到了,因为ACL已经收录的比较完美了。

组织方法

通过一些方法将文章分类组织起来。安利一个文献管理软件:zotero

- By conferences 通过会议

- By preprint or not

需要及时更新,因为arxiv上预发表的文章你可以引用,但是文章被会议或者文献收录以后以后你需要引用它具体出自哪里。所以arxiv上找的那些预发表的文章需要定期更新。 - By problems 根据问题

- By methods(models) 根据方法

初学者可以这样分,但是当你看多了以后会发现这些方法下还是有很大差异。所以只建议初学者这样。- CNN

- RNN

- GNN

- Transformer

- Attention

- Reinforcement

- ……

- By dataset(text type) 根据数据集

- DUC

- LCSTS

- CNN/Daily

- ……

- By optimize methods(depends on your own idea)

Select the better paper

同样都是读文献,要把时间用在好文献上,就是所谓的好钢用在刀刃上。大致可以从以下几个指标来分辨文献好坏:

- conference

多看会议文章,少看期刊文章。因为会议文章比较新,而期刊上的文章一般都隔了一年以上了。下边安利几个会议:- NLP domain

- ACL

- COLING

- EMNLP

- NAACL

- General AI

- AAAI

- IJCAI

- NIPS

- ICLR

- Chinese NLP

- NLPCC

- CCKS

- CCIR

- NLP domain

- relation

跟你做的方向最最最相关的,不要什么都看,就算看也不要精读。没精力做那么多的。 - citation

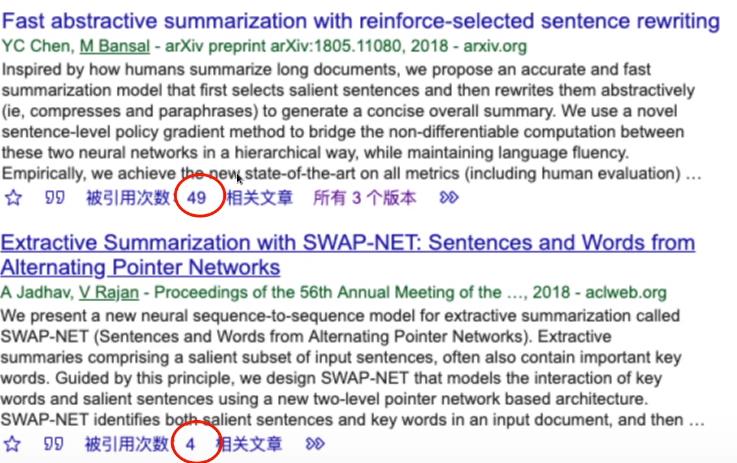

引用数量啊,肯定是引用数量越多质量肯定会好一点啊。

下图虽然两个文章都是顶会,但是优先看引用数量比较多的啊。

- influence

论文看多了以后会发现每年的论文都是这几个大组做的,找到这几个大佬之后,以后可以集中看他们写的。 - code

有没有代码开源。判断是不是ppt项目,最好选有代码的paper。

the reading order you should follow

不要只看题目标题啊!!!有的文献题目和内容可能差距挺大的。

- abstract

看文献一般先看摘要,通过摘要筛选,从摘要你一般可以获得下面的信息。- subarea

- problems

- proposal/method

- Datasets

- performance

- introduction

回顾前人成果,提出自己想解决的问题 - experiment + conclusion

实验和成果 - proposal

要精读的时候再看方法,不精读的文章可以跳过这段。- 看图

- 看创新性

- 看公式

Write down the notes

对每一个文章做好分类标记。到时候找起来也方便。至于怎么分类怎么标记就看你自己的喜欢了。

- From(Conferences/Journals/ArXiv)

- Institution

- Paper

- Topic

- Aim

- Problem to solve

- Solutions

- Strengths

- Limitations

- Datasets

- Evaluation scores

- Code

安利

最后安利一下fastNLP:fastNLP 中文文档,放在github上,主要是复现了一些NLP文章的代码。

以上是关于如何阅读NLP论文的主要内容,如果未能解决你的问题,请参考以下文章

论文泛读186QA 数据集爆炸:用于问答和阅读理解的 NLP 资源分类

论文阅读 | Energy and Policy Considerations for Deep Learning in NLP

论文阅读 | Universal Adversarial Triggers for Attacking and Analyzing NLP