「深度学习一遍过」必修12:激活函数池化归一化泛化正则化

Posted 荣仔!最靓的仔!

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了「深度学习一遍过」必修12:激活函数池化归一化泛化正则化相关的知识,希望对你有一定的参考价值。

本专栏用于记录关于深度学习的笔记,不光方便自己复习与查阅,同时也希望能给您解决一些关于深度学习的相关问题,并提供一些微不足道的人工神经网络模型设计思路。

专栏地址:「深度学习一遍过」必修篇

目录

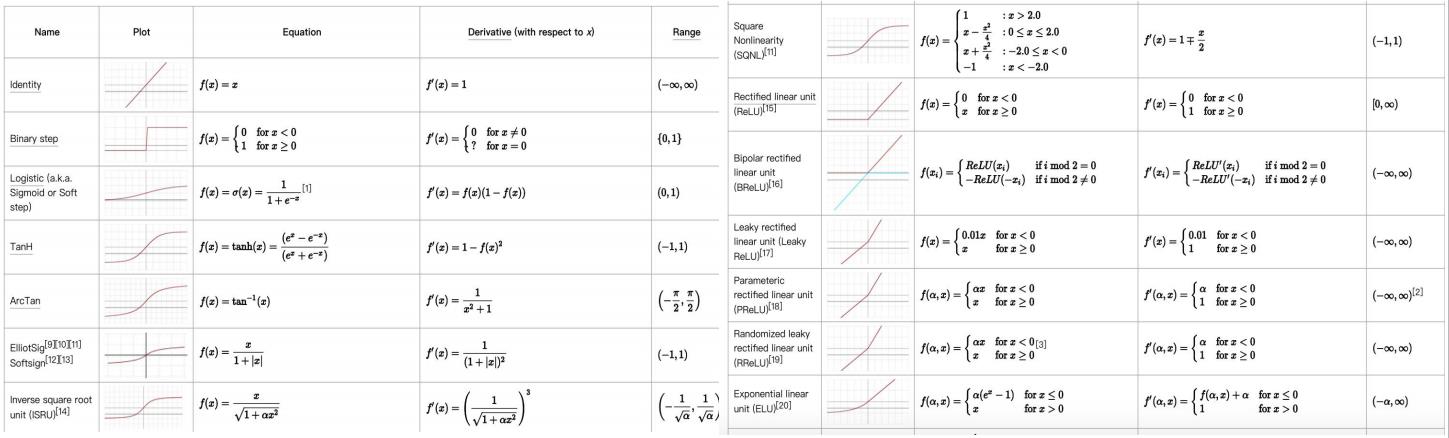

1 激活函数

如果没有非线性激活函数:增加网络层数模型仍然是线性的。

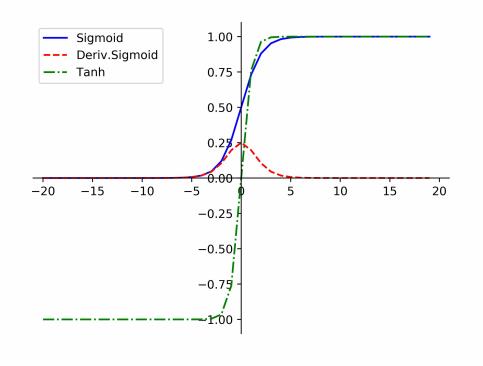

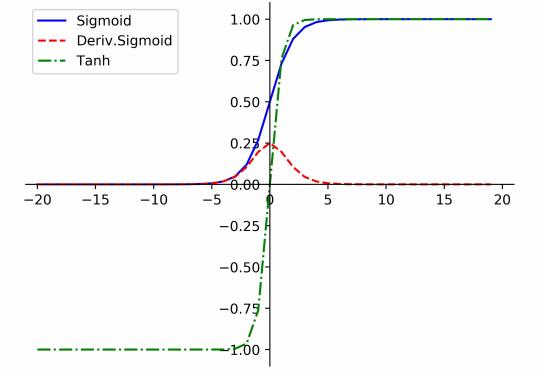

1.1 S 型激活函数

1.1 S 型激活函数

包 括  函数(常被代指

函数(常被代指  函 数 ) 与

函 数 ) 与  函 数。

函 数。

,

,

到

到

的平滑变换,也叫

的平滑变换,也叫

函数

函数

,

,

到

到

的平滑变换

的平滑变换

函数优缺点:

函数优缺点:

- 优点:输出0~1,映射平滑适合预测概率

- 缺点:不过零点,没有负值激活,影响梯度下降效率;饱和区梯度消失问题!

函数优缺点:

函数优缺点:

- 优点:映射到

之间,过零点,值域比

之间,过零点,值域比  更大

更大 - 缺点:饱和区梯度消失!

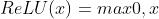

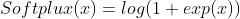

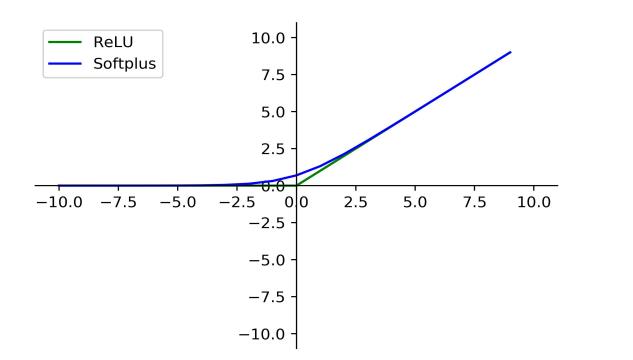

1.2 ReLU 激活函数

,修正线性单元

,修正线性单元

,正区间恒等变换,负区间

,正区间恒等变换,负区间

,

, 的平滑版本

的平滑版本

函数优缺点:

函数优缺点:

- 优点:计算简单,导数恒定;拥有稀疏性,符合人脑的神经元活跃特性

- 缺点:非零中心化,没有负激活值,影响梯度下降效率;如果一次不恰当的参数更新后,所有数据都不能使某个神经元激活,则其对应的参数梯度为

,以后也无法激活,陷入‘死亡’(

,以后也无法激活,陷入‘死亡’( )

)

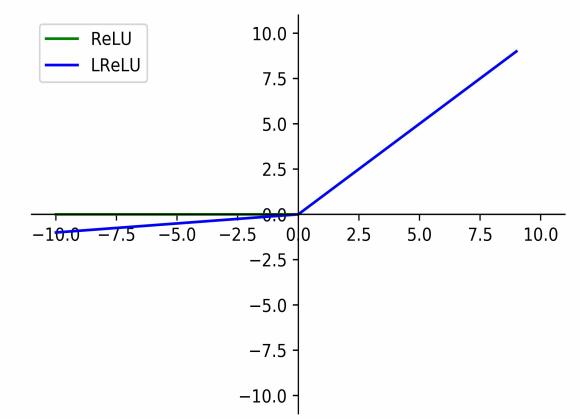

改进

解决

函数负区间的零激活问题。

휶

取固定值则为

函数负区间的零激活问题。

휶

取固定值则为

,为可以学习的参数则为

,为可以学习的参数则为

,为随机值则为

,为随机值则为  。

。

函数负区间的零激活问题。

휶

取固定值则为

函数负区间的零激活问题。

휶

取固定值则为

,为可以学习的参数则为

,为可以学习的参数则为

,为随机值则为

,为随机值则为  。

。

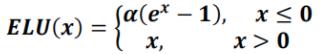

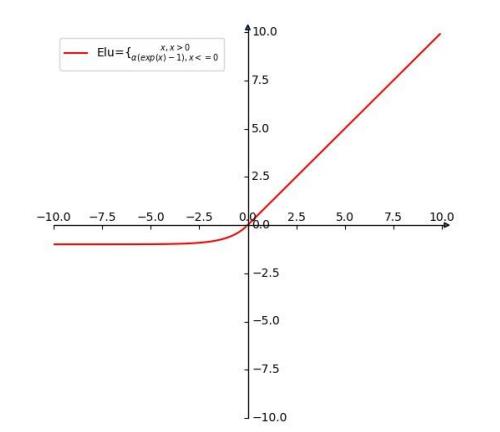

函数:有

函数:有  的所有优点,并且不会有

的所有优点,并且不会有 问 题

问 题 :网络的浅层尤其是第一层卷积中,学习到的

:网络的浅层尤其是第一层卷积中,学习到的  会比较大,而到了深层就比较小。这可以理解为网络的浅层学习到了 类似于

会比较大,而到了深层就比较小。这可以理解为网络的浅层学习到了 类似于  的浅层特征,更大的

的浅层特征,更大的  可以提取到更加稠密的特征,而随着网络深度的增加,特征变得更加的稀疏。

可以提取到更加稠密的特征,而随着网络深度的增加,特征变得更加的稀疏。  :当作一个正则项,用于增强网络的泛化能力。

:当作一个正则项,用于增强网络的泛化能力。

,将

,将  函数

函数  的那一端的函数取非线性函数。

的那一端的函数取非线性函数。

函数优点:

函数优点:

- 优点:被证实有较高的噪声鲁棒性,能够使得神经元的平均激活均值趋近为0。

- 缺点:由于需要计算指数,计算量较大。

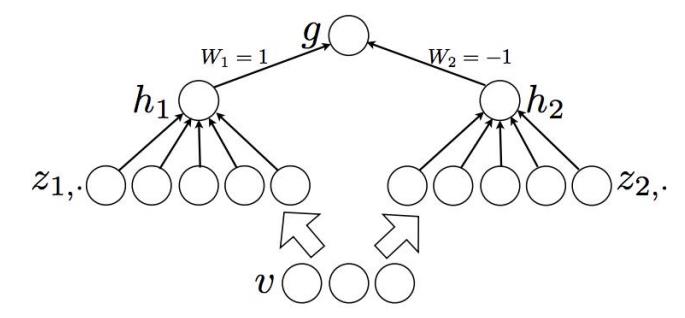

1.3 MaxOut激活函数

函数优缺点:

函数优缺点:

- 优点:整体学习输入到输出的非线性映射关系, 拟合能力非常强

- 缺点:计算量增加,增加了

个神经元

个神经元

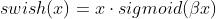

函数,

函数,

函数优点:

函数优点:

线性函数与  函数之间的非线性插值函数,无上界有下界、平滑非单调,从数据中学习参数

函数之间的非线性插值函数,无上界有下界、平滑非单调,从数据中学习参数  ,可以获得任务相关的激活机制。

,可以获得任务相关的激活机制。

函数之间的非线性插值函数,无上界有下界、平滑非单调,从数据中学习参数

函数之间的非线性插值函数,无上界有下界、平滑非单调,从数据中学习参数  ,可以获得任务相关的激活机制。

,可以获得任务相关的激活机制。

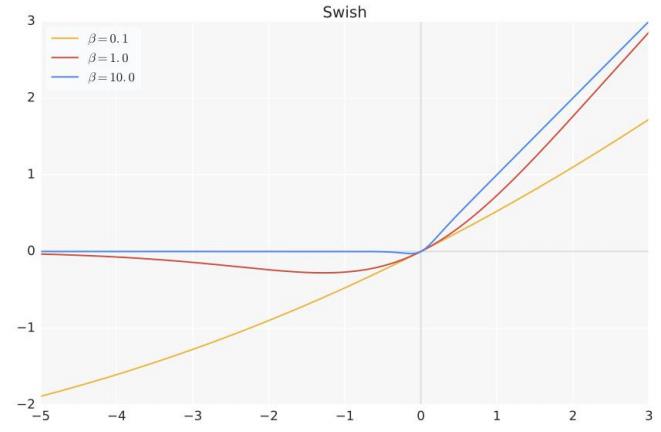

2 池化

,将一个区域的信息压缩成一个值,完成信息的抽象

,将一个区域的信息压缩成一个值,完成信息的抽象

依据步长和半径不同,可分为有重叠的池化和无重叠的池化。

最大池化:选取区域最大值(max pooling),能更好保留纹理特征。

平均池化:选取区域均值(mean pooling),能保留整体数据的特征。

随机池化:按照其概率值大小随机选择,元素被选中的概率与数值大小正相关

- 归一化

的输入,计算分布概率

的输入,计算分布概率  。

。 - 从基于

的多项式分布中随机采样位置。

的多项式分布中随机采样位置。

混合池化:max/average pooling中进行随机选择;增强泛化能力,类似于dropout机制

3 归一化

增强了信息的辨识度。

- 线性归一化

- 零均值归一化/Z-score标准化

- 直方图均衡化

作用:去除量纲干扰,保证数据的有效性,稳定数据分布

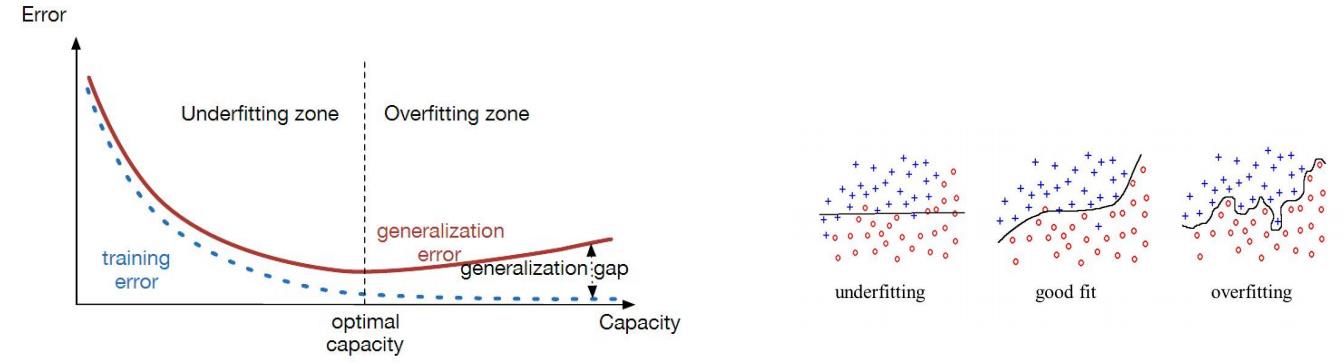

4 泛化

模型不仅在训练集表现良好,在未知的数据(测试集)也表现良好,即具有良好的泛化能力。

泛化不好的后果:模型性能不稳定,容易受到攻击

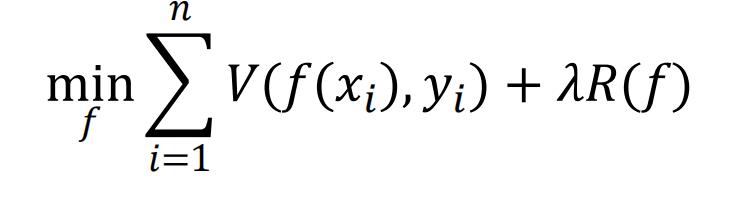

5 正则化

所谓正则化,它的目标就是要同时让经验风险和模型复杂度都较小,是对模型的一种规则约束。

即预测结果函数,

即预测结果函数, 即损失函数。

即损失函数。 跟模型复杂度相关的单调递增函数,用于约束模型的表达能力。

跟模型复杂度相关的单调递增函数,用于约束模型的表达能力。

正则化的分类:

- 显式正则化(经验正则化,参数正则化)

网络结构,损失函数的修改,模型使用方法的调整 - 隐式正则化

没有直接对模型进行正则化约束,但间接获取更好的泛化能力

欢迎大家交流评论,一起学习

希望本文能帮助您解决您在这方面遇到的问题

感谢阅读

END

以上是关于「深度学习一遍过」必修12:激活函数池化归一化泛化正则化的主要内容,如果未能解决你的问题,请参考以下文章