史诗级干货长文聚类算法

Posted ZSYL

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了史诗级干货长文聚类算法相关的知识,希望对你有一定的参考价值。

Clustering Algorithm

1. 聚类算法简介

学习目标

- 掌握聚类算法实现过程

- 知道K-means算法原理

- 知道聚类算法中的评估模型

- 说明K-means的优缺点

- 了解聚类中的算法优化方式

- 知道特征降维的实现过程

- 应用Kmeans实现聚类任务

1.1 认识聚类算法

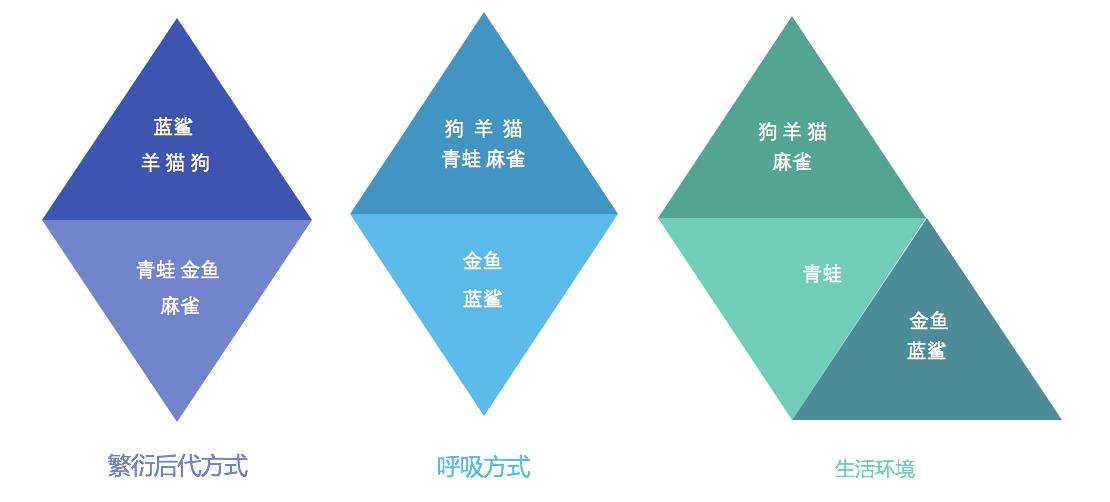

使用不同的聚类准则,产生的聚类结果不同。

1.1.1 聚类算法在现实中的应用

-

用户画像,广告推荐,Data Segmentation,搜索引擎的流量推荐,恶意流量识别

-

基于位置信息的商业推送,新闻聚类,筛选排序

-

图像分割,降维,识别;离群点检测;信用卡异常消费;发掘相同功能的基因片段

1.1.2 聚类算法的概念

聚类算法:

一种典型的无监督学习算法,主要用于将相似的样本自动归到一个类别中。

在聚类算法中根据样本之间的相似性,将样本划分到不同的类别中,对于不同的相似度计算方法,会得到不同的聚类结果,常用的相似度计算方法有欧式距离法。

1.1.3 聚类算法与分类算法最大的区别

聚类算法是无监督的学习算法,而分类算法属于监督的学习算法。

1.2 小结

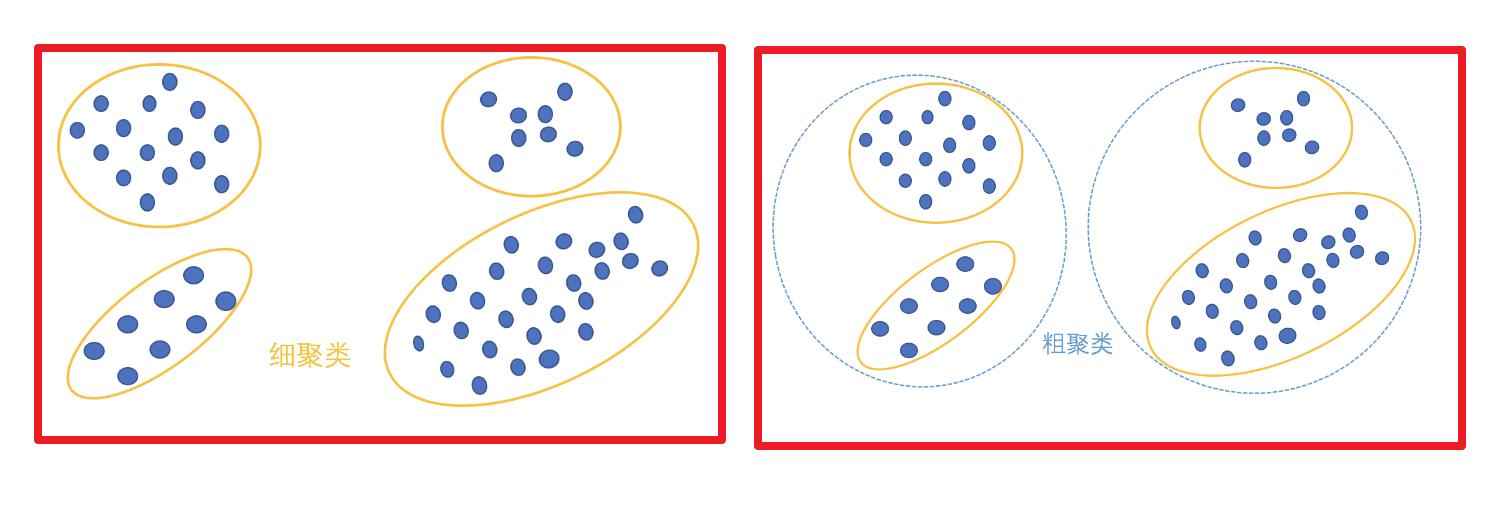

- 聚类算法分类

- 粗聚类

- 细聚类

- 聚类的定义

- 一种典型的无监督学习算法,

- 主要用于将相似的样本自动归到一个类别中

- 计算样本和样本之间的相似性,一般使用欧式距离

2. 聚类算法api初步使用

2.1 api介绍

-

sklearn.cluster.KMeans(n_clusters=8)- 参数:

- n_clusters:开始的聚类中心数量

- 整型,缺省值=8,生成的聚类数,即产生的质心(centroids)数。

- n_clusters:开始的聚类中心数量

- 方法:

- estimator.fit(x)

- estimator.predict(x)

- estimator.fit_predict(x)

- 计算聚类中心并预测每个样本属于哪个类别,相当于先调用fit(x),然后再调用predict(x)

- 参数:

2.2 案例

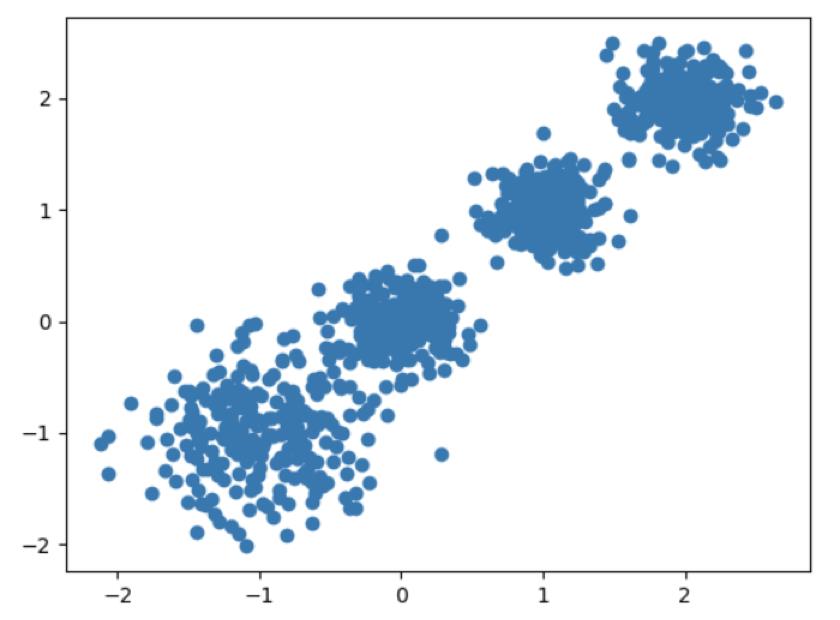

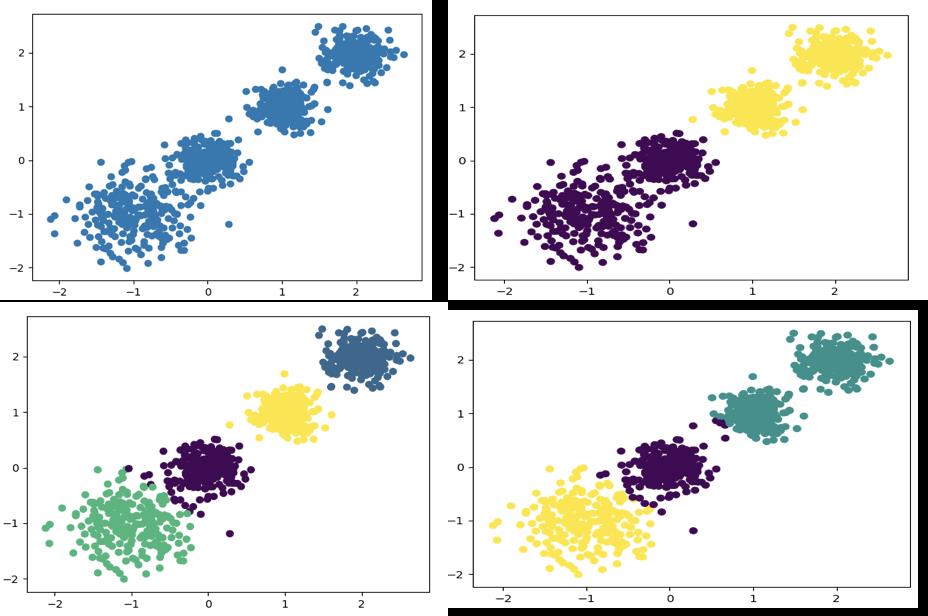

随机创建不同二维数据集作为训练集,并结合k-means算法将其聚类,你可以尝试分别聚类不同数量的簇,并观察聚类效果:

聚类参数n_cluster传值不同,得到的聚类结果不同

2.2.1 流程分析

2.2.2 代码实现

1.创建数据集

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs

from sklearn.cluster import KMeans

from sklearn.metrics import calinski_harabasz_score

# 创建数据集

# X为样本特征,Y为样本簇类别, 共1000个样本,每个样本4个特征,共4个簇,

# 簇中心在[-1,-1], [0,0],[1,1], [2,2], 簇方差分别为[0.4, 0.2, 0.2, 0.2]

X, y = make_blobs(n_samples=1000, n_features=2, centers=[[-1, -1], [0, 0], [1, 1], [2, 2]],

cluster_std=[0.4, 0.2, 0.2, 0.2],

random_state=9)

# 数据集可视化

plt.scatter(X[:, 0], X[:, 1], marker='o')

plt.show()

2.使用k-means进行聚类,并使用CH方法评估

y_pred = KMeans(n_clusters=2, random_state=9).fit_predict(X)

# 分别尝试n_cluses=2\\3\\4,然后查看聚类效果

plt.scatter(X[:, 0], X[:, 1], c=y_pred)

plt.show()

# 用Calinski-Harabasz Index评估的聚类分数

print(calinski_harabaz_score(X, y_pred))

# kmeans训练,且可视化 聚类=2

y_pre = KMeans(n_clusters=2, random_state=9).fit_predict(x)

# 可视化展示

plt.scatter(x[:, 0], x[:, 1], c=y_pre)

plt.show()

# 用ch_score查看最后效果

print(calinski_harabasz_score(x, y_pre))

3116.1706763322227

# kmeans训练,且可视化 聚类=3

y_pre = KMeans(n_clusters=3, random_state=9).fit_predict(x)

# 可视化展示

plt.scatter(x[:, 0], x[:, 1], c=y_pre)

plt.show()

# 用ch_score查看最后效果

print(calinski_harabasz_score(x, y_pre))

2931.625030199556

# kmeans训练,且可视化 聚类=4

y_pre = KMeans(n_clusters=4, random_state=9).fit_predict(x)

# 可视化展示

plt.scatter(x[:, 0], x[:, 1], c=y_pre)

plt.show()

# 用ch_score查看最后效果

print(calinski_harabasz_score(x, y_pre))

5924.050613480169

2.3 小结

-

api:

sklearn.cluster.KMeans(n_clusters=8)- 参数:

n_clusters:开始的聚类中心数量

- 方法:

estimator.fit_predict(x)- 计算聚类中心并预测每个样本属于哪个类别,相当于先调用

fit(x),然后再调用predict(x)

- 计算聚类中心并预测每个样本属于哪个类别,相当于先调用

- 参数:

3. 聚类算法实现流程

请参考:【聚类算法】实现流程

4. 模型评估

请参考:【聚类算法】模型评估

5. 算法优化

6. 特征降维

请参考:【机器学习】特征工程-特征降维

7. 案例:探究用户对物品类别的喜好细分

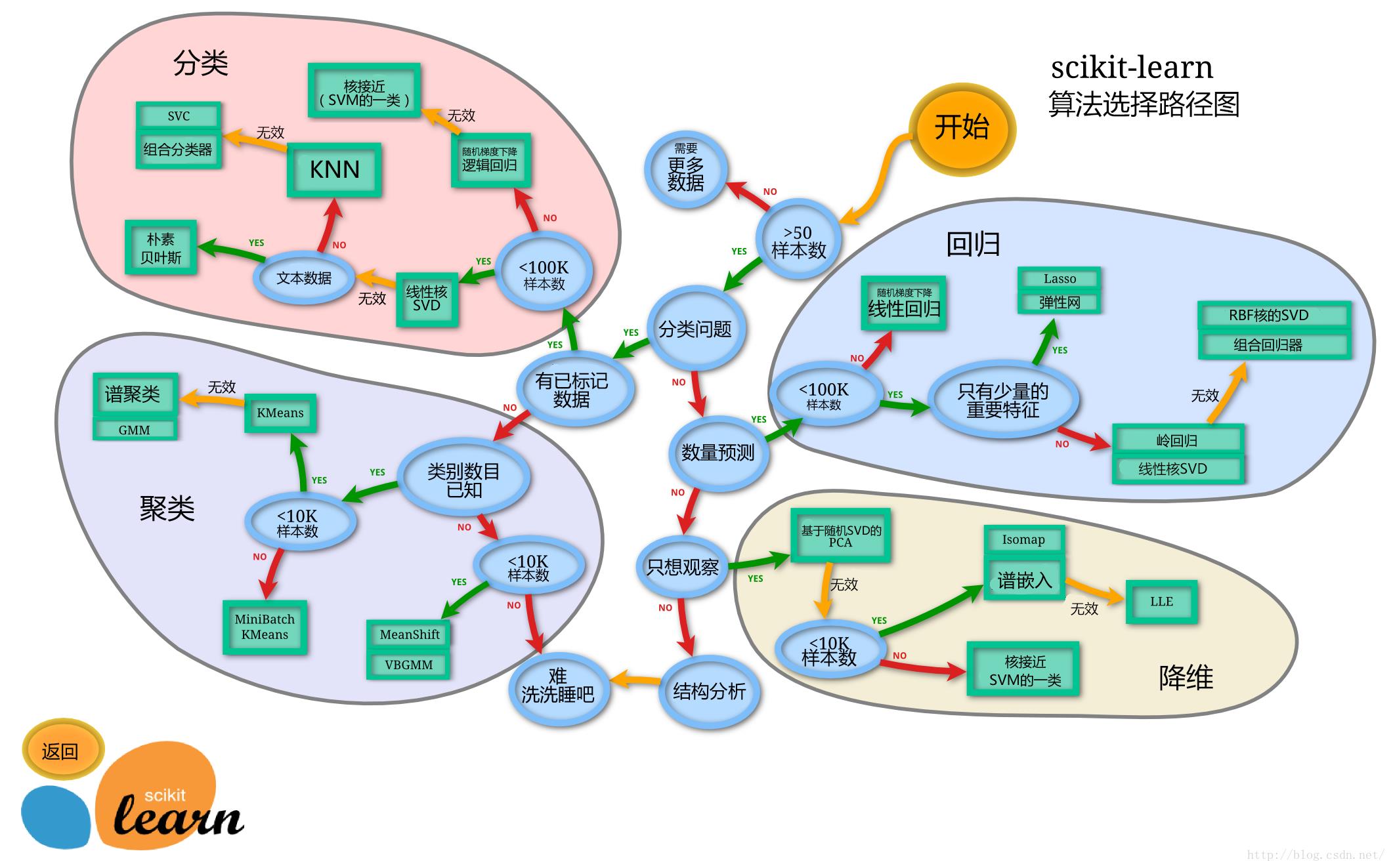

8. 算法选择指导

关于在计算的过程中,如何选择合适的算法进行计算,可以参考scikit learn官方给的指导意见:

加油!

感谢!

努力!

以上是关于史诗级干货长文聚类算法的主要内容,如果未能解决你的问题,请参考以下文章