Attention使用注意力机制的seq2seq 动手学深度学习v2

Posted AI架构师易筋

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Attention使用注意力机制的seq2seq 动手学深度学习v2相关的知识,希望对你有一定的参考价值。

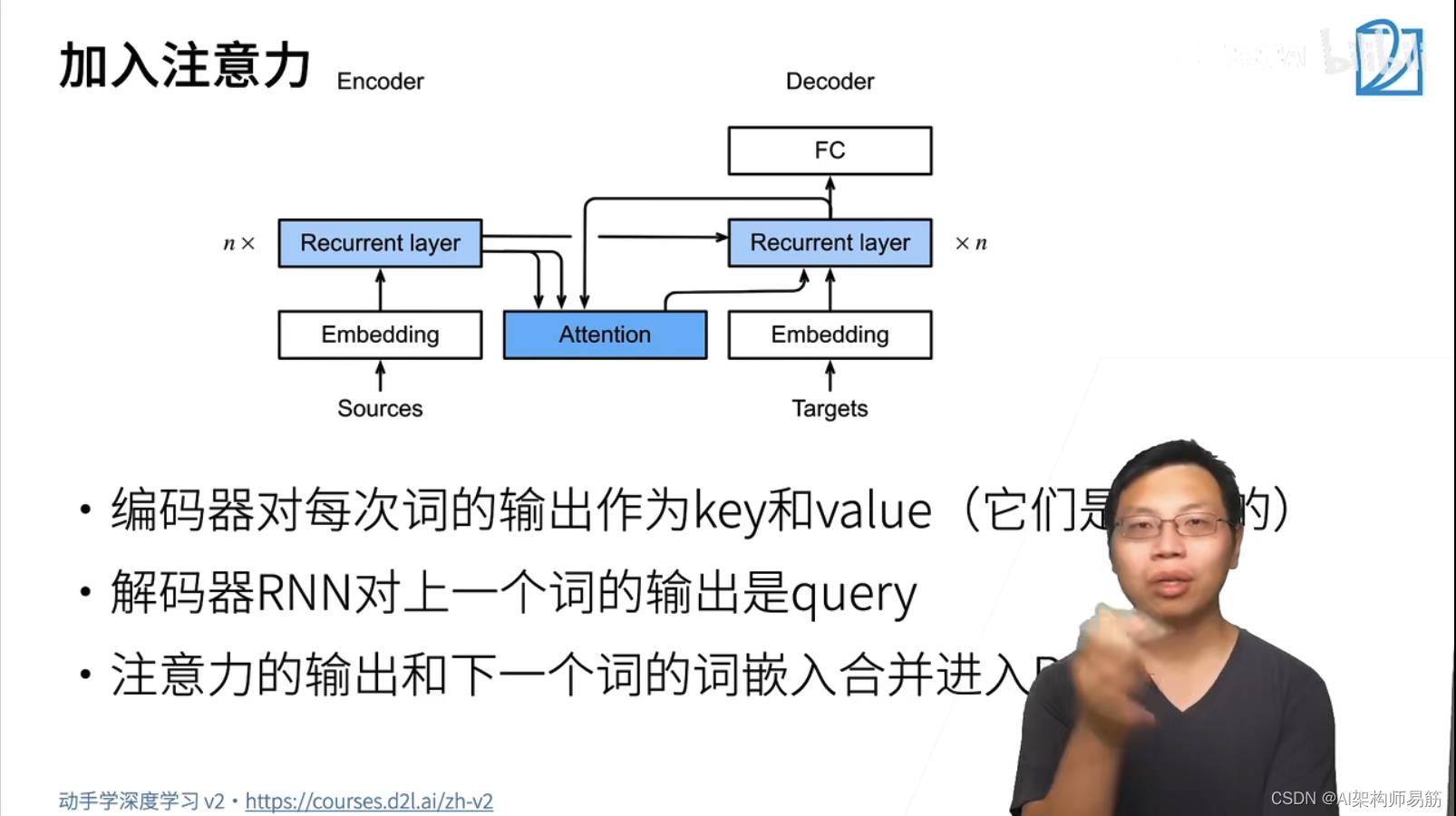

1. Attention使用注意力机制的seq2seq

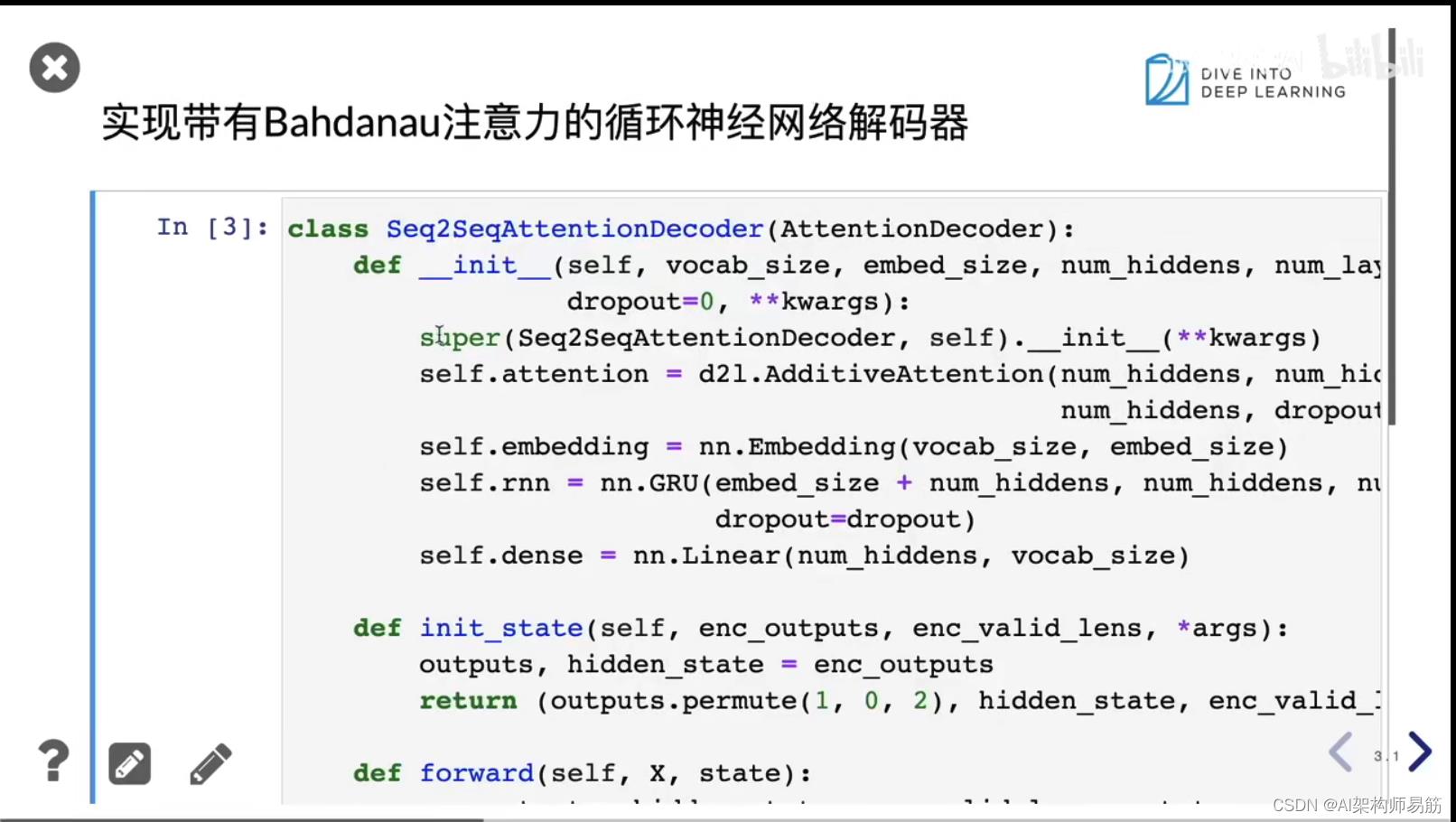

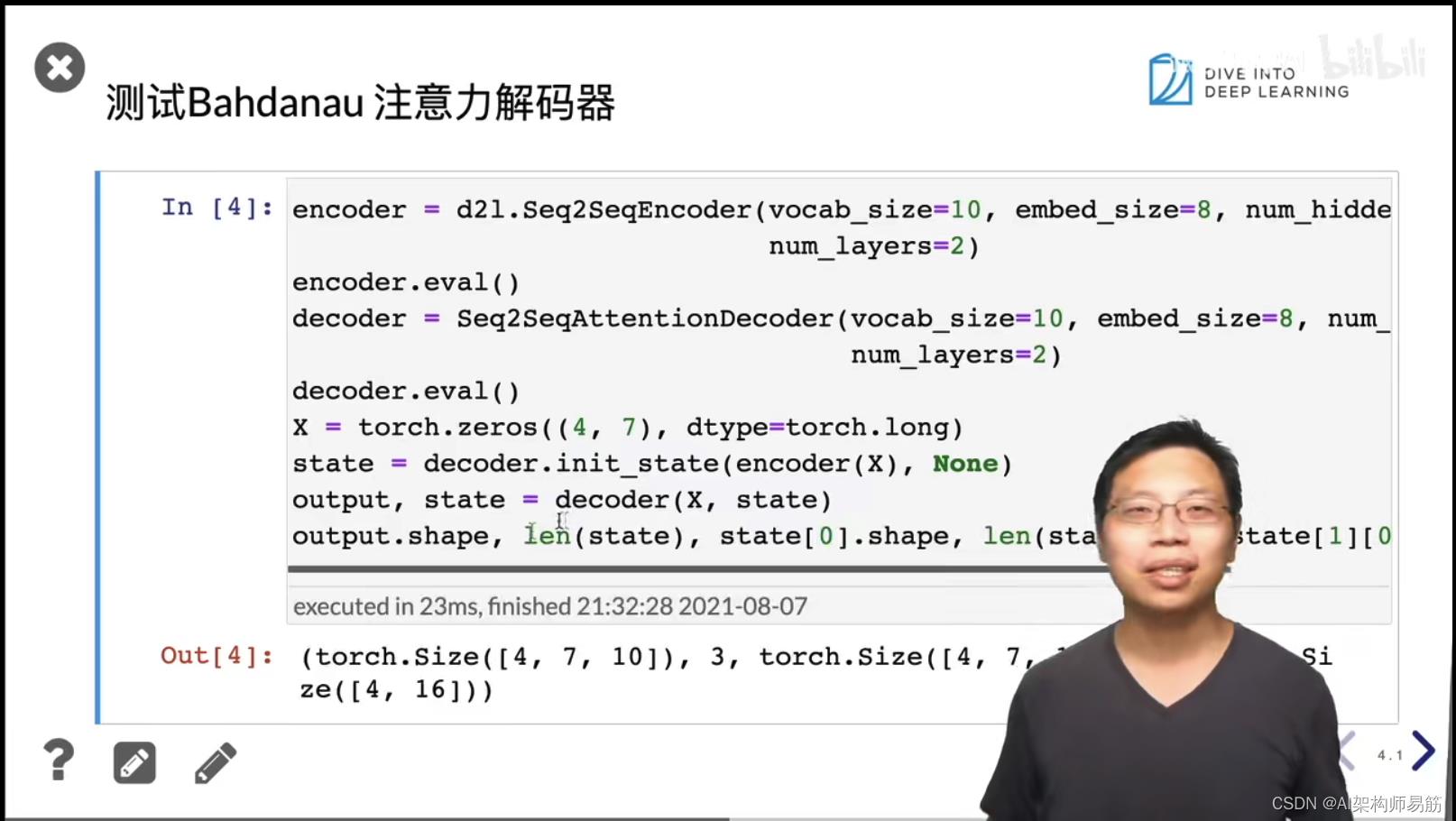

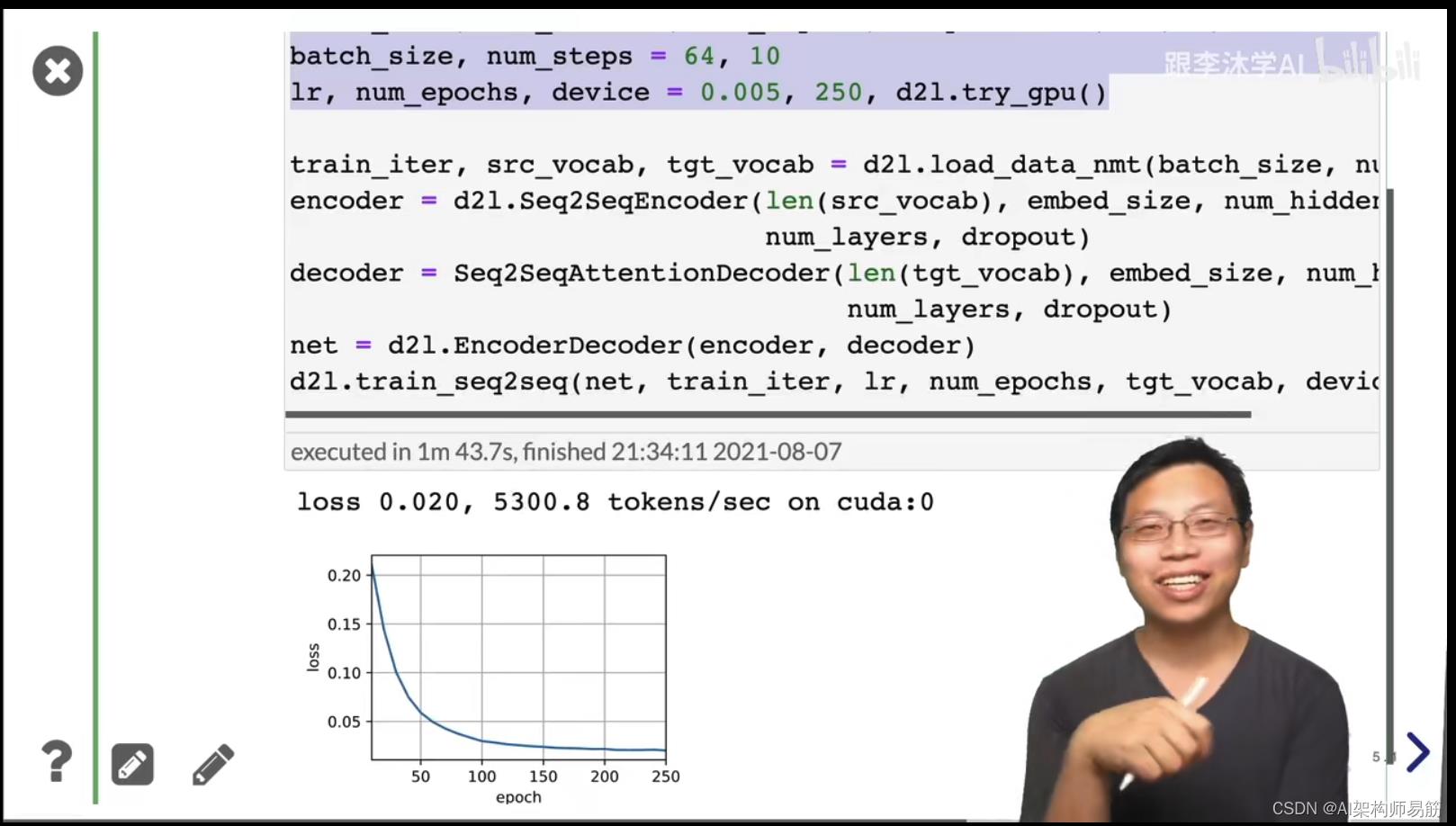

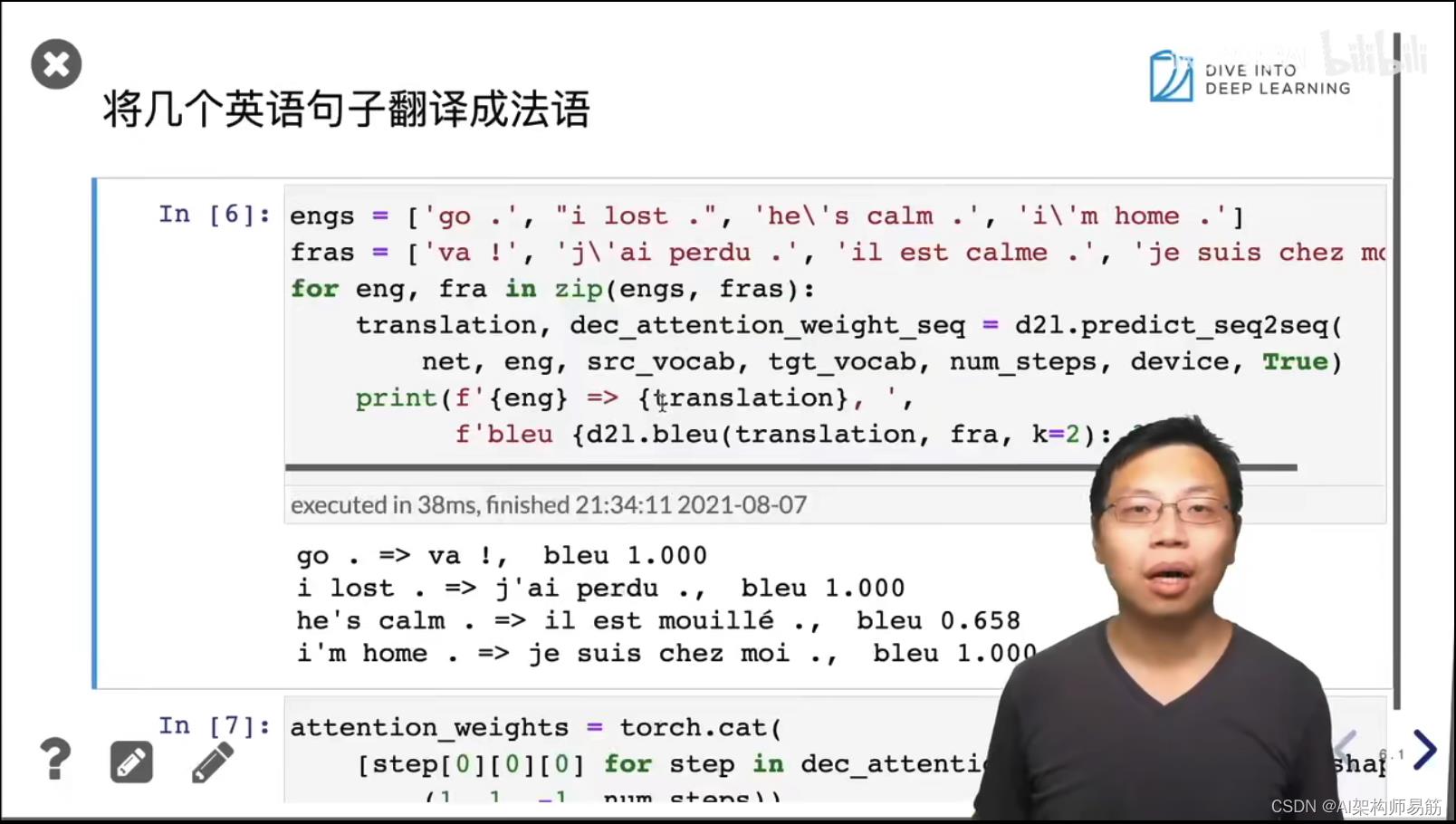

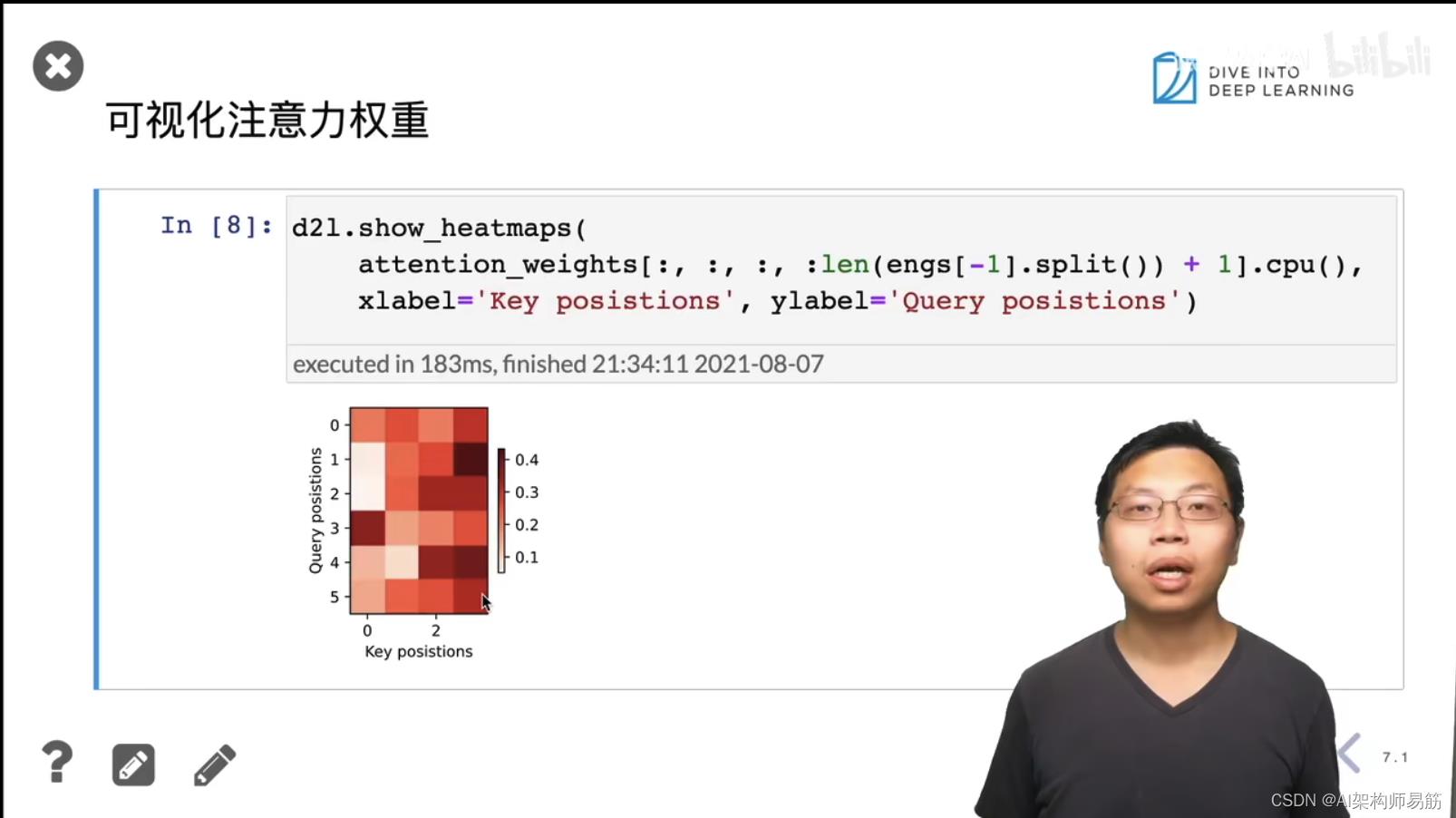

2. Attention使用注意力机制的seq2seq 代码实现

3. Q&A

-

- attention在搜索的时候,是在当前句子搜索。

-

- 一般都是在decoder加入注意力机制?不一定的,BERT就是在encoder中加入attention。

-

- 图像attention,就是从图片抽取patch,也就一小块一小块,作为attention。

参考

https://www.bilibili.com/video/BV1v44y1C7Tg?p=1

以上是关于Attention使用注意力机制的seq2seq 动手学深度学习v2的主要内容,如果未能解决你的问题,请参考以下文章