Attention 机制

Posted timhy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Attention 机制相关的知识,希望对你有一定的参考价值。

2019-09-10 19:46:07

问题描述:Seq2Seq模型引入注意力机制是为了解决什么问题?为什么选择使用双向循环神经网络模型?

问题求解:

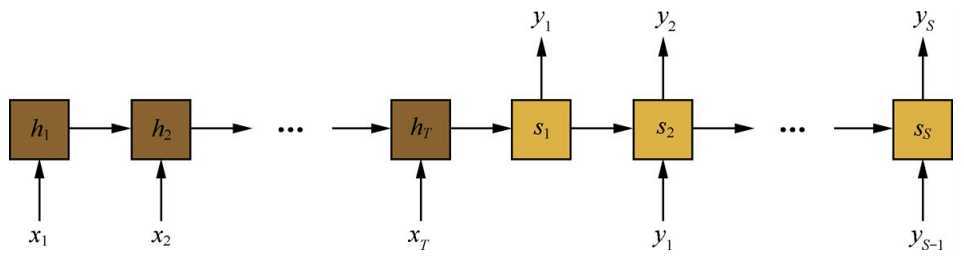

在实际任务中使用Seq2Seq模型,通常会先使用一个循环神经网络作为编码器,将输入序列编码成一个向量表示;然后再使用一个循环神经网络模型作为解码器,从编码器得到的向量表示里解码得到输出序列。

这里计算输出序列的时候只考虑了当前隐状态和上一个输出词。

这里有个问题,就是随着输入序列的增长,模型的性能发生了显著下降。这是因为编码时输入序列的全部信息压缩到了一个向量中表示。随着序列的增长,句子越前面的词的信息丢失就越严重。试想翻译一个有100个词的句子,需要将整个句子全部词的语义信息编码在一个向量中。

而在解码的时候,目标语言的第一个词大概率是

以上是关于Attention 机制的主要内容,如果未能解决你的问题,请参考以下文章