基础篇-spark集群搭建

Posted 野狼十三大数据

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基础篇-spark集群搭建相关的知识,希望对你有一定的参考价值。

说明:

版本:spark-2.3.0-bin-hadoop2.7

JDK:jdk1.8.0_161

免密、hostnname、hosts文件均已配置。

本文介绍spark standalone 集群模式、HA模式的安装方式

下载解压配置三部曲,重点讲配置

1、下载 (略)

2、解压 (略)

3、配置

Spark standalone集群

step1 配置spark-env.sh

cd conf/mv spark-env.sh.template spark-env.shvi spark-env.sh###在该配置文件中添加如下配置export JAVA_HOME=/usr/java/jdk1.8.0_161export SPARK_MASTER_IP=hadoop1export SPARK_MASTER_PORT=7077

进入到Spark安装目录 /opt/liupuxiang/install/spark-2.3.0/conf目录 重命名并修改spark-env.sh.template文件。

mv slaves.template slaves编辑内容

#把work节点名称写入文件hadoop2hadoop3

step3 分发给子节点

#分发 spark-env.sh 文件scp spark-env.sh root@hadoop2:/opt/liupuxiang/install/spark-2.3.0/conf/scp spark-env.sh root@hadoop3:/opt/liupuxiang/install/spark-2.3.0/conf/#分发 slaves 文件scp slaves root@hadoop3:/opt/liupuxiang/install/spark-2.3.0/conf/scp slaves root@hadoop3:/opt/liupuxiang/install/spark-2.3.0/conf/

step4 启动

进入到目录 /opt/liupuxiang/install/spark-2.3.0/

cd /opt/liupuxiang/install/spark-2.3.0/sbin/start-all.sh

step5 查看

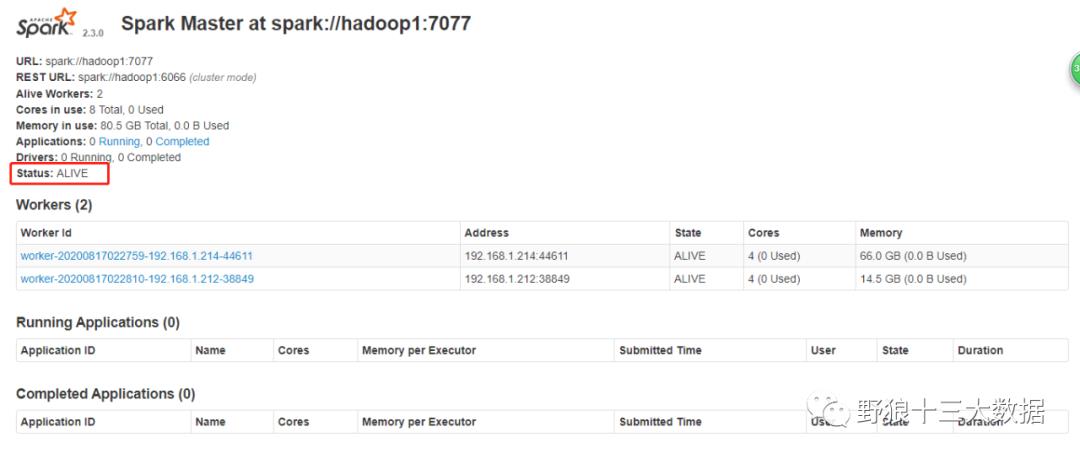

启动后执行jps命令,主节点上有Master进程,其他子节点上有Work进行,登录Spark管理界面查看集群状态(主节点):http://hadoop1:8080/

spark HA集群规划

| 规划 | haoop1 | hadoop2 | hadoop3 |

| zookeeper | √ | √ | √ |

| spark | master | work | work |

step1 停止集群服务 修改spark-env.sh 配置 分发启动

##停止cd /opt/liupuxiang/install/spark-2.3.0/sbin/stop-all.sh###修改spark-env.sh 配置##删除 SPARK_MASTER_IP 配置项##新增配置项export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=hadoop1:2181,hadoop2:2181,hadoop3:2181 -Dspark.deploy.zookeeper.dir=/spark"#分发 spark-env.sh 文件scp spark-env.sh root@hadoop2:/opt/liupuxiang/install/spark-2.3.0/conf/scp spark-env.sh root@hadoop3:/opt/liupuxiang/install/spark-2.3.0/conf/

hadoop1 节点

hadoop2 节点

以上是关于基础篇-spark集群搭建的主要内容,如果未能解决你的问题,请参考以下文章

Spark基础学习笔记06:搭建Spark On YARN模式的集群

Spark基础学习笔记05:搭建Spark Standalone模式的集群

原创 Hadoop&Spark 动手实践 5Spark 基础入门,集群搭建以及Spark Shell

Spark MLlib速成宝典基础篇01Windows下spark开发环境搭建(Scala版)

Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十三)定义一个avro schema使用comsumer发送avro字符流,producer接受avro字符流并解析(示例代码