Spark基础学习笔记05:搭建Spark Standalone模式的集群

Posted howard2005

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark基础学习笔记05:搭建Spark Standalone模式的集群相关的知识,希望对你有一定的参考价值。

文章目录

- 零、本讲学习目标

- 一、Spark集群拓扑

- 二、搭建集群

- 三、配置完全分布式Hadoop

- 四、配置Spark Standalone模式的集群

- 五、启动并使用Spark Standalone模式的集群

零、本讲学习目标

- 搭建Spark Standalone模式的集群

- 能够启动Spark Standalone模式的集群

- 学会Spark应用程序的提交

Spark的两种集群运行模式:Spark Standalone模式和Spark On YARN模式。Standalone模式需要启动Spark集群,而Spark On YARN模式不需要启动Spark集群,只需要启动YARN集群即可。先来搭建Spark Standalone模式的集群。

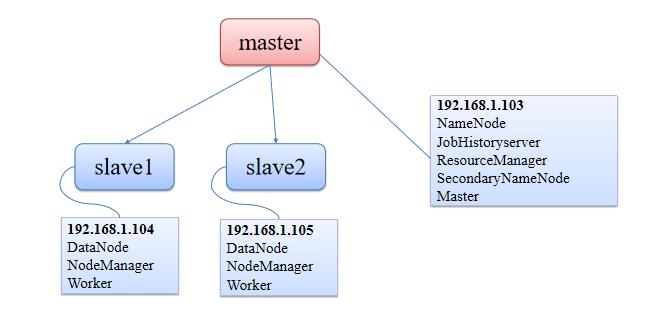

一、Spark集群拓扑

(一)集群拓扑

(二)集群角色分配

- Spark Standalone模式的集群搭建需要在集群的每个节点都安装Spark,集群角色分配如下表所示。

| 节点 | -角色 |

|---|---|

| master | Master |

| slave1 | Worker |

| slave2 | Worker |

二、搭建集群

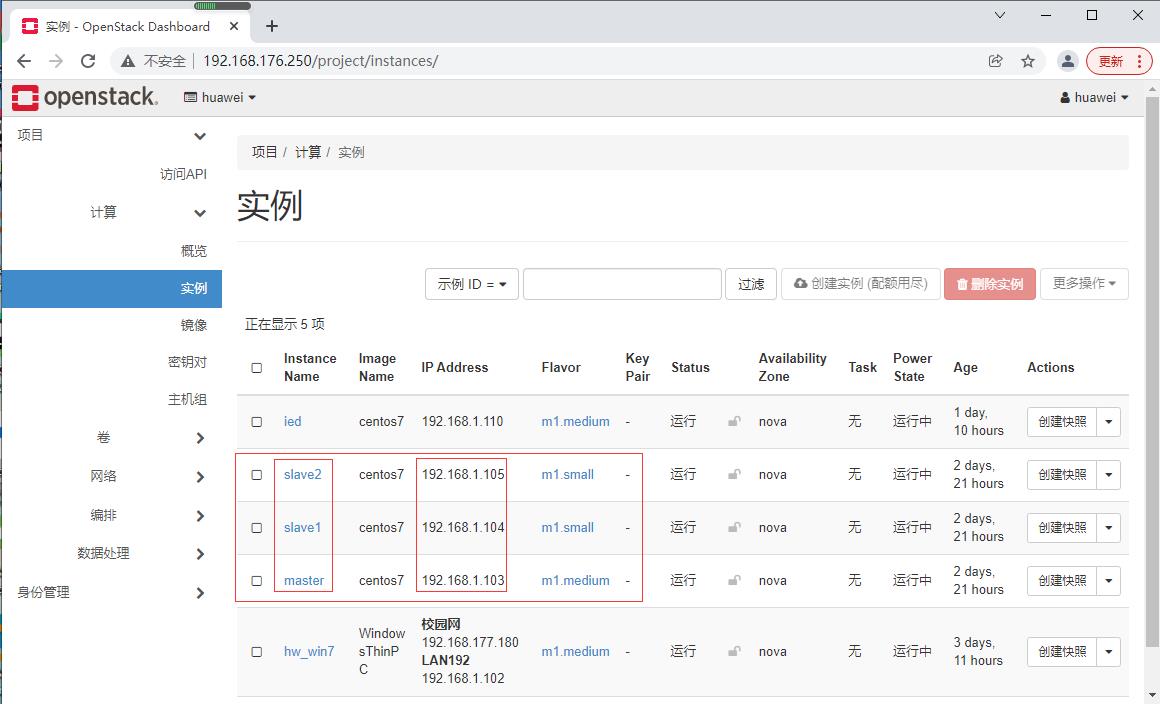

(一)私有云上创建三台虚拟机

- 创建配置过程,参看本博《 在私有云上创建与配置虚拟机》

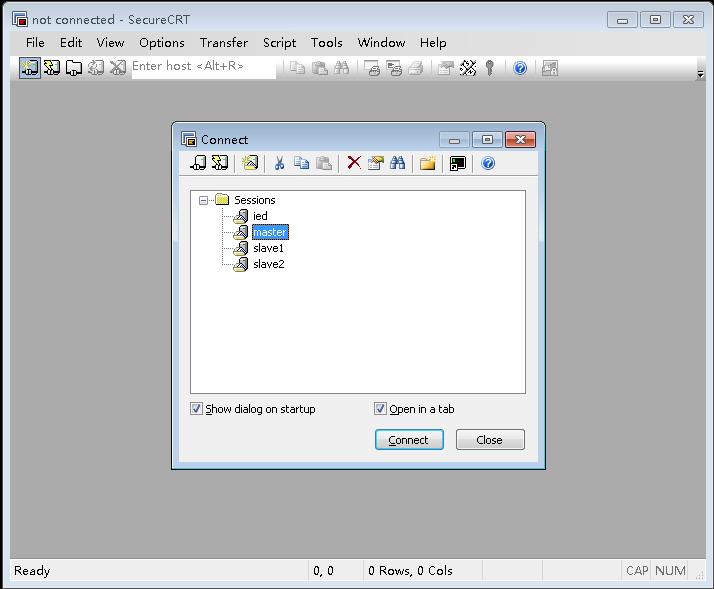

(二)利用SecureCRT登录三台虚拟机

- 打开连接对话框

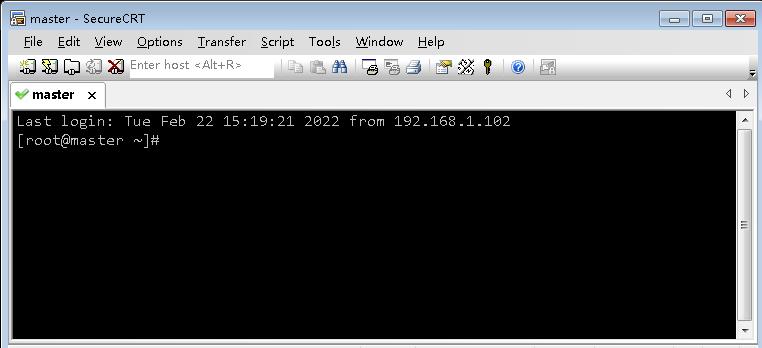

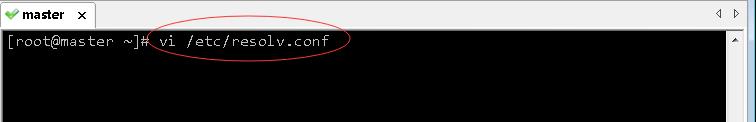

1、登录master虚拟机

- 单击连接对话框里的master,登录master虚拟机

- 参看本博《在CentOS7上安装vim编辑器》,在master虚拟机上安装

vim编辑器 - 执行命令:

vi /etc/resolv.conf,修改/etc/resolv.conf文件

- 添加两个域名服务器

- 存盘退出

- 执行命令:

yum -y install vim

- 解决在《在私有云上创建与配置虚拟机》遗留的问题

- 现在我们通过

/etc/resolv.conf文件添加了域名解析服务器,因此可以ping通域名了

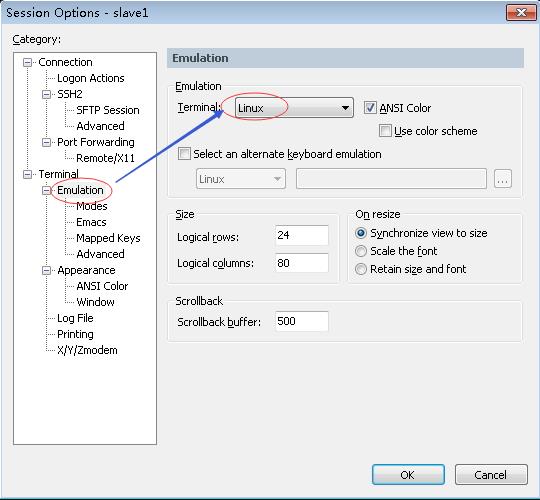

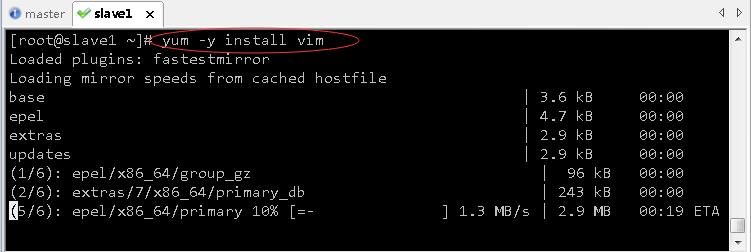

2、登录slave1虚拟机

- 单击连接对话框里的slave1,登录slave1虚拟机

- 修改选项

- 单击【OK】按钮

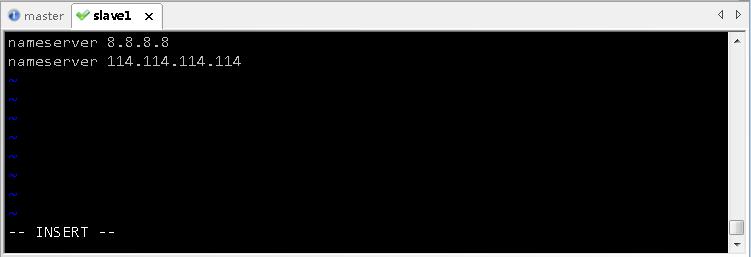

- 执行命令:

vi /etc/resolv.conf,添加域名解析服务器

- 存盘退出后,执行命令:

yum - install vim,安装vim编辑器

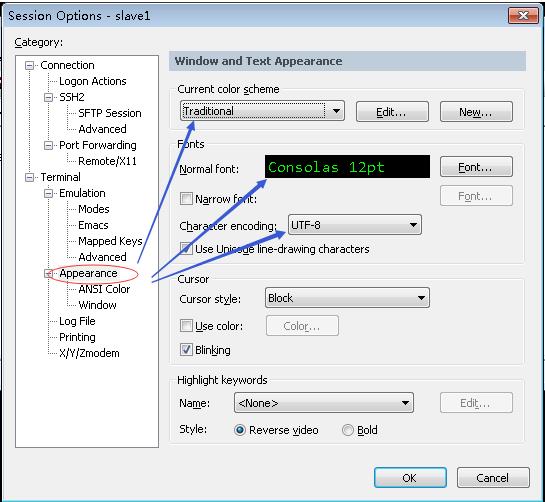

3、登录slave2虚拟机

- 单击连接对话框里的slave2,登录slave2虚拟机

- 仿照slave1虚拟机上的做法,修改选项,效果如下所示

- 配置域名解析服务器之后,安装vim编辑器

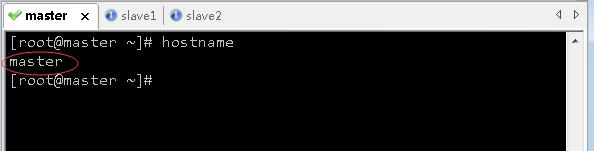

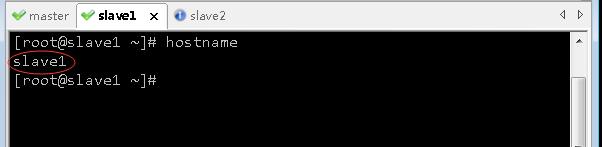

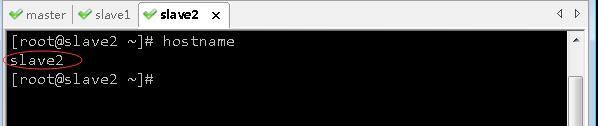

(三)查看三台虚拟机主机名

- 查看master虚拟机主机名

- 查看slave1虚拟机主机名

- 查看slave2虚拟机主机名

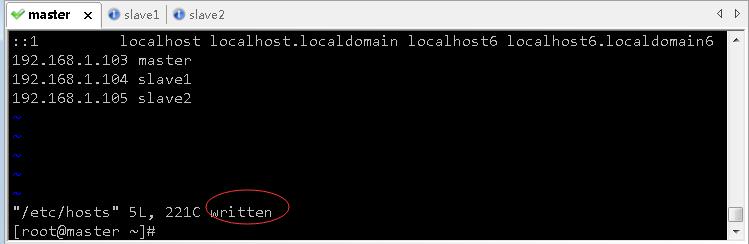

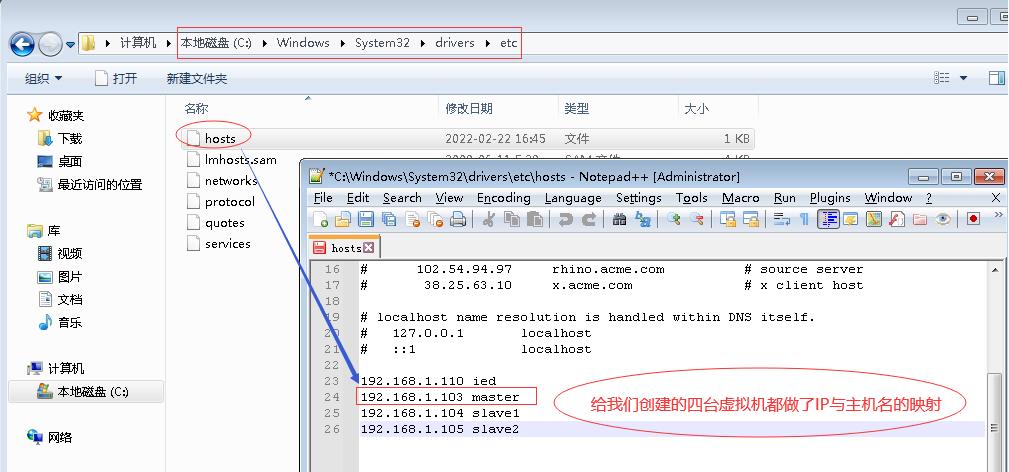

(四)配置三台虚拟机IP-主机名映射

192.168.1.103 master

192.168.1.104 slave1

192.168.1.105 slave2

1、配置master虚拟机IP-主机名映射

- 执行命令:

vim /etc/hosts

- 存盘退出

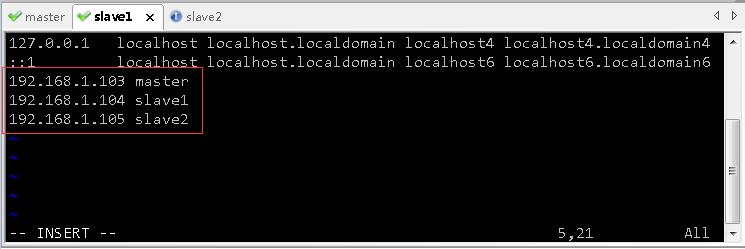

2、配置slave1虚拟机IP-主机名映射

- 执行命令:

vim /etc/hosts

- 存盘退出

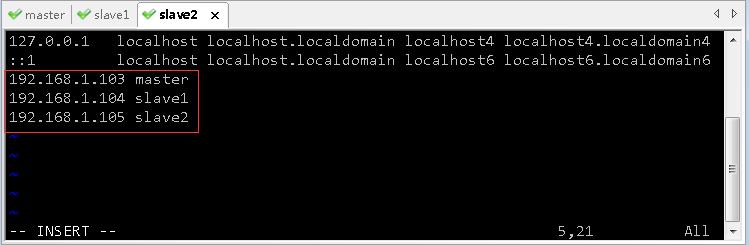

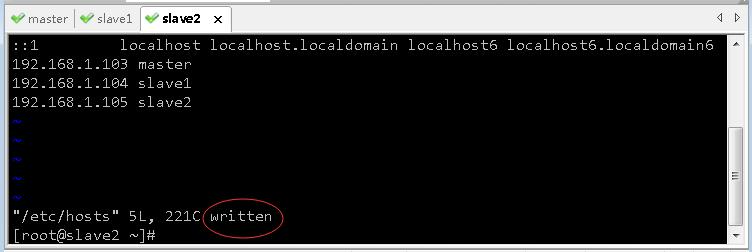

3、配置slave2虚拟机IP-主机名映射

- 执行命令:

vim /etc/hosts

- 存盘退出

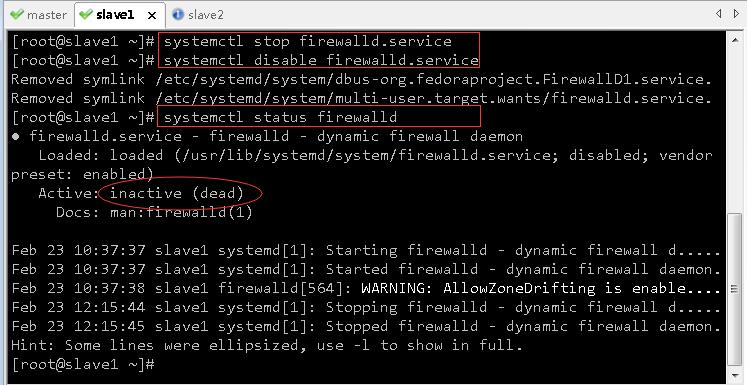

(五)关闭与禁用防火墙

- 关闭与禁用防火墙

systemctl stop firewalld.service # 关闭防火墙

systemctl disable firewalld.service # 禁用防火墙

- 查看防火墙状态

systemctl status firewalld.service

1、关闭与禁用master虚拟机的防火墙

2、关闭与禁用slave1虚拟机的防火墙

3、关闭与禁用slave2虚拟机的防火墙

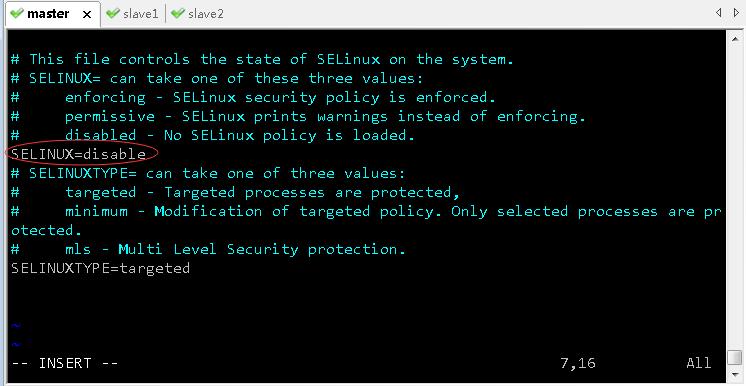

(六)关闭SeLinux安全机制

/etc/sysconfig/selinux文件里SELINUX=enforcing,将enforcing改成disable,就可以关闭SeLinux安全机制

1、在master虚拟机上关闭SeLinux安全机制

- 执行命令:

vim /etc/sysconfig/selinux

- 存盘退出

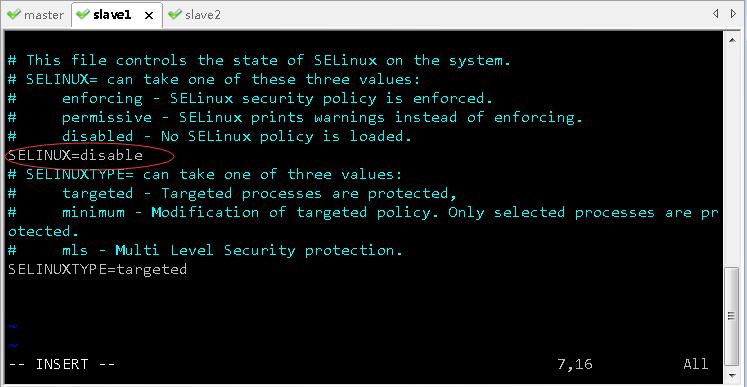

2、在slave1虚拟机上关闭SeLinux安全机制

- 执行命令:

vim /etc/sysconfig/selinux

- 存盘退出

3、在slave2虚拟机上关闭SeLinux安全机制

- 执行命令:

vim /etc/sysconfig/selinux

- 存盘退出

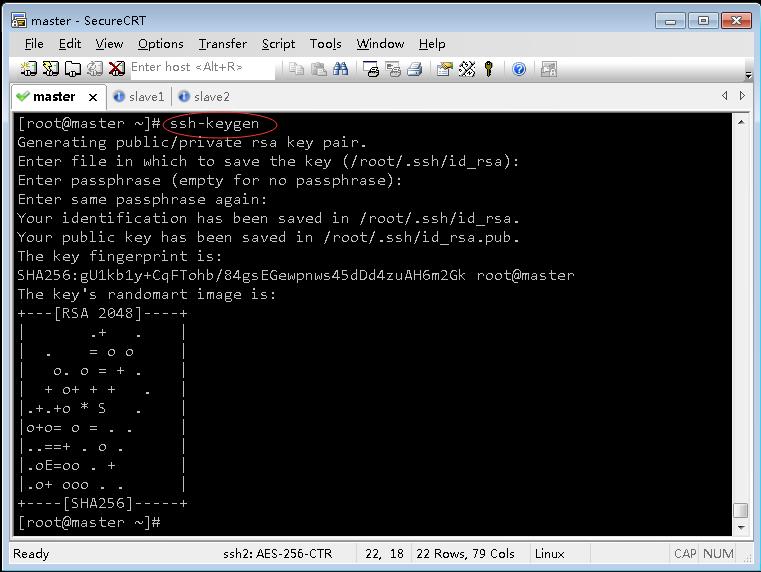

(七)设置三台虚拟机相互免密登录

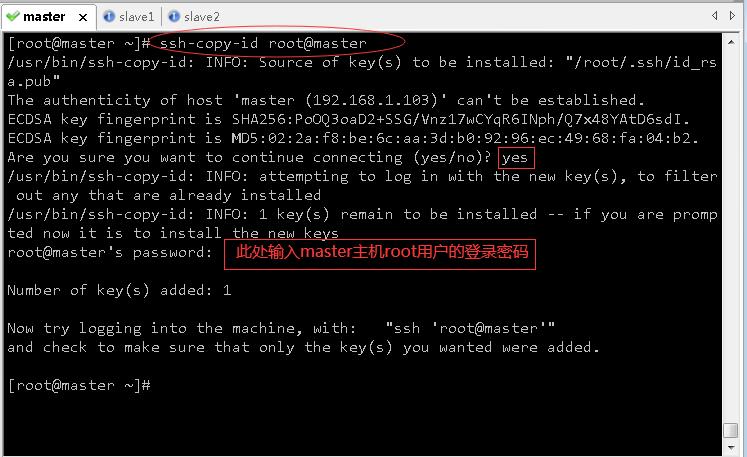

1、master虚拟机免密登录master、slave1与slave2

- 执行命令:

ssh-keygen,生成密钥对

- 执行命令:

ssh-copy-id root@master,将公钥拷贝到master

- 执行命令:

ssh-copy-id root@slave1,将公钥拷贝到slave1

- 执行命令:

ssh-copy-id root@slave2,将公钥拷贝到slave2

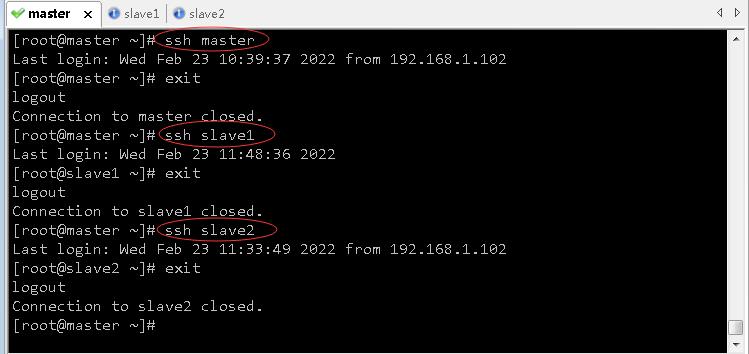

- 验证master是否可以免密登录master、slave1与slave2

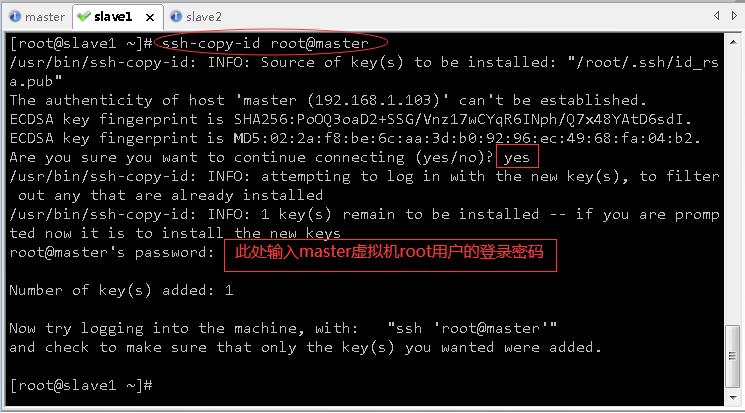

2、slave1虚拟机免密登录master、slave1与slave2

- 执行命令:

ssh-keygen,生成密钥对

- 执行命令:

ssh-copy-id root@master,将公钥拷贝到master

- 执行命令:

ssh-copy-id root@slave1,将公钥拷贝到slave1

- 执行命令:

ssh-copy-id root@slave2,将公钥拷贝到slave2

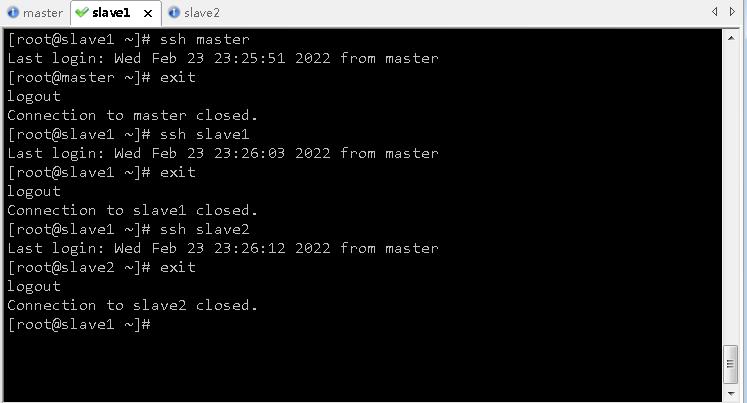

- 验证slave1是否可以免密登录master、slave1与slave2

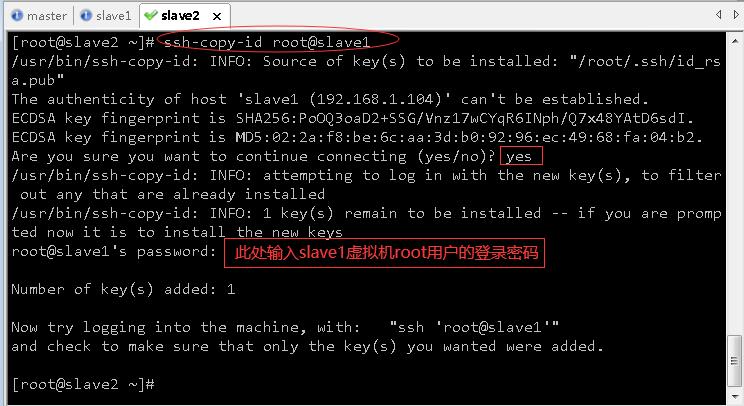

3、slave2虚拟机免密登录master、slave1与slave2

- 执行命令:

ssh-keygen,生成密钥对

- 执行命令:

ssh-copy-id root@master,将公钥拷贝到master

- 执行命令:

ssh-copy-id root@slave1,将公钥拷贝到slave1

- 执行命令:

ssh-copy-id root@slave2,将公钥拷贝到slave2

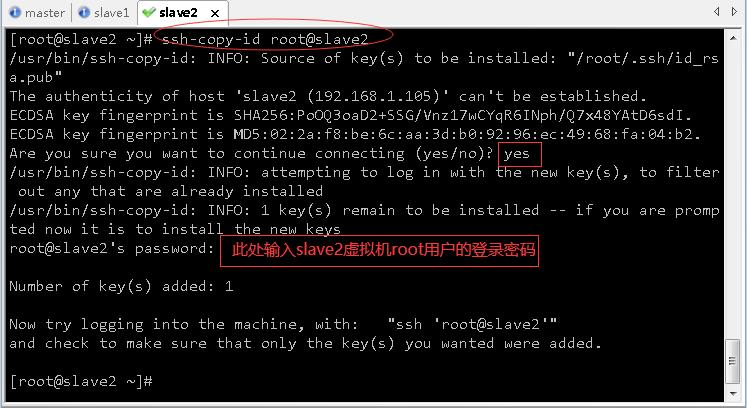

- 验证slave2是否可以免密登录master、slave1与slave2

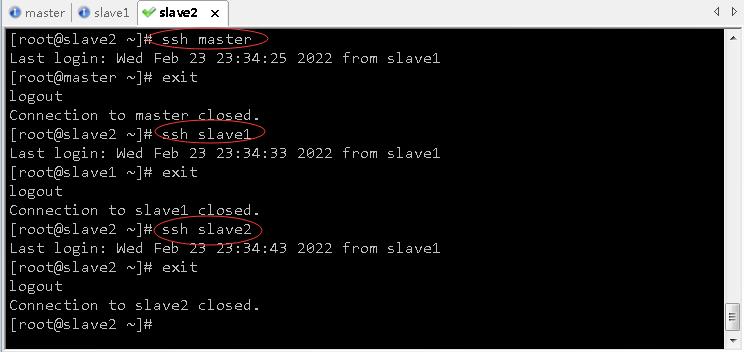

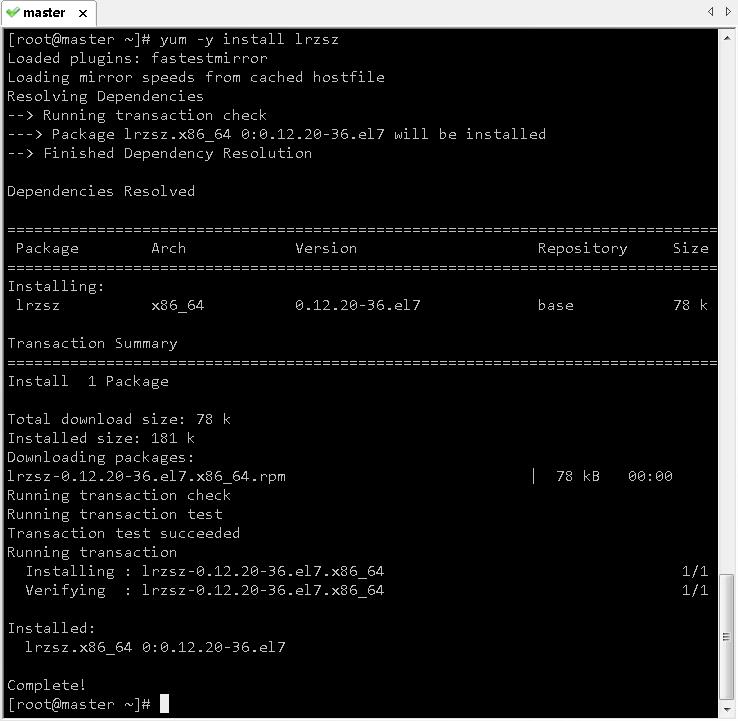

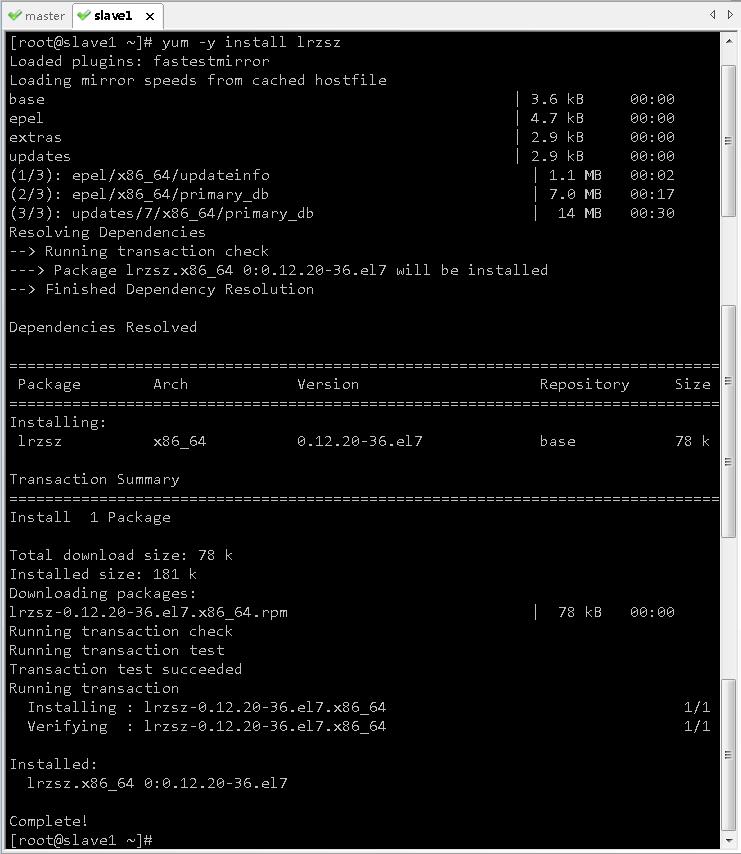

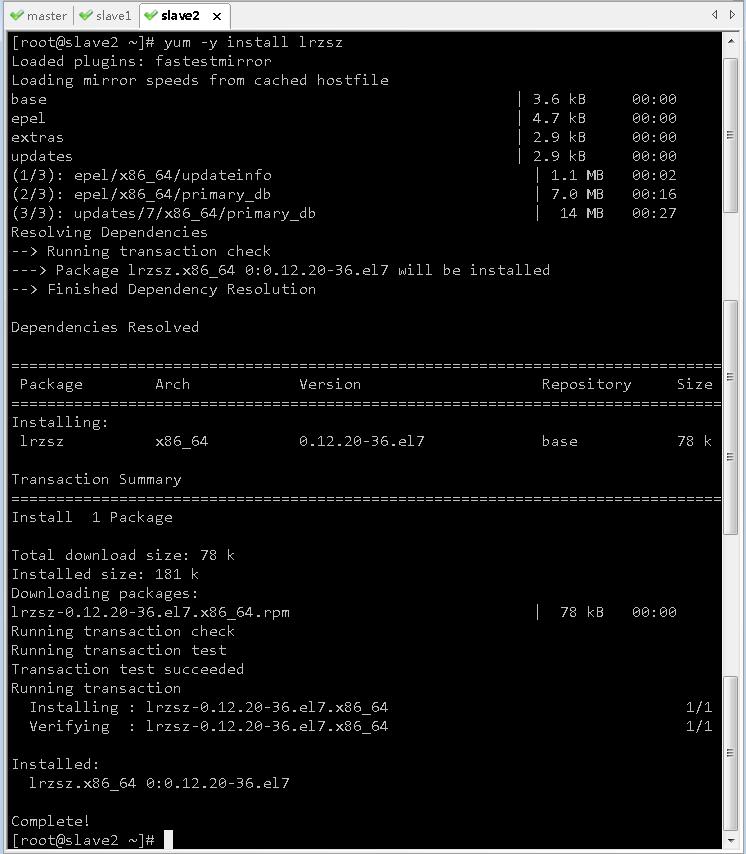

(八)在三台虚拟机上安装lrzsr

1、在master虚拟机上安装lrzsz

- 执行命令:

yum -y install lrzsz

2、在slave1虚拟机上安装lrzsz

- 执行命令:

yum -y install lrzsz

3、在slave2虚拟机上安装lrzsz

- 执行命令:

yum -y install lrzsz

(九)在三台虚拟机上安装配置JDK

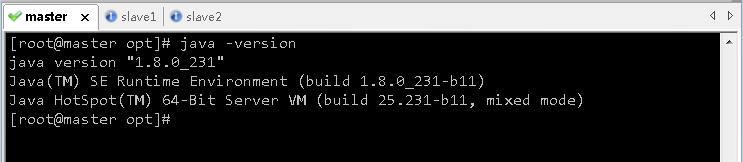

1、在master虚拟机上安装配置JDK

-

上传Java安装包到/opt目录

-

执行

tar -zxvf jdk-8u231-linux-x64.tar.gz -C /usr/local,将Java安装包解压到/usr/local

-

执行命令:

vim /etc/profile,配置环境变量

JAVA_HOME=/usr/local/jdk1.8.0_231

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

PATH=$JAVA_HOME/bin:$PATH

export JAVA_HOME PATH CLASSPATH

- 存盘退出,执行命令:

source /etc/profile,让配置生效

- 查看JDK版本

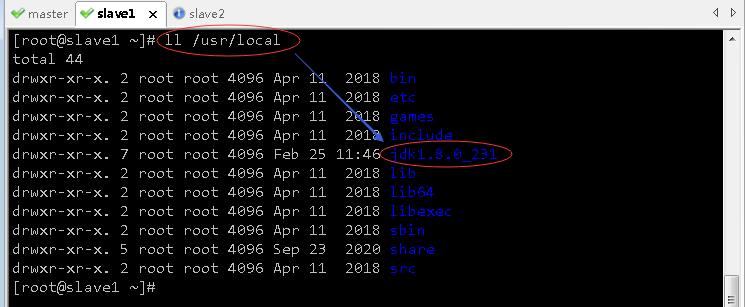

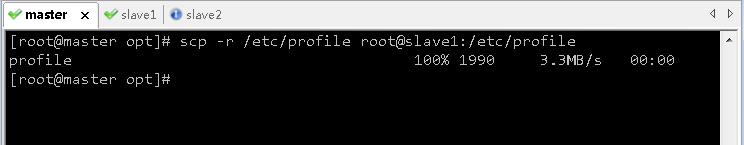

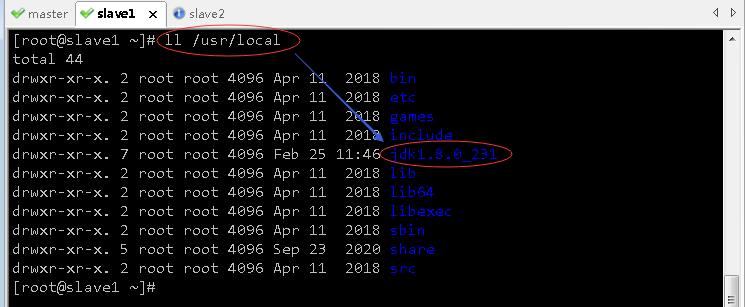

2、在master虚拟机上安装的JDK分发到slave1虚拟机

- 执行命令:

scp -r /usr/local/jdk1.8.0_231 root@slave1:/usr/local

- 在slave1虚拟机上查看Java是否拷贝成功

- 在master虚拟机上,执行命令:

scp -r /etc/profile root@slave1:/etc/profile

- 在slave1虚拟机上,查看从master虚拟机拷贝过来的配置文件profile

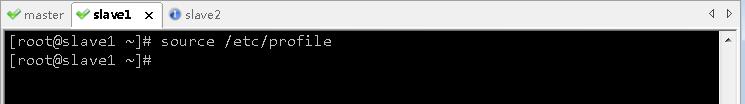

- 存盘退出,执行命令:

source /etc/profile,让配置生效

3、在master虚拟机上安装的JDK分发到slave2虚拟机

-

执行命令:

scp -r /usr/local/jdk1.8.0_231 root@slave2:/usr/local -

在slave2虚拟机上查看Java是否拷贝成功

-

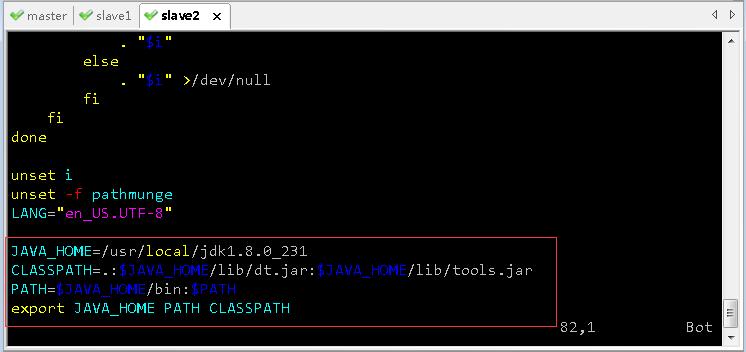

在master虚拟机上,执行命令:

scp -r /etc/profile root@slave2:/etc/profile

-

在slave2虚拟机上,查看从master虚拟机拷贝过来的配置文件profile

-

存盘退出,执行命令:

source /etc/profile,让配置生效

三、配置完全分布式Hadoop

(一)在master虚拟机上安装配置hadoop

1、上传hadoop安装包到/opt目录

- 利用rz命令上传hadoop-2.7.1.tar.gz

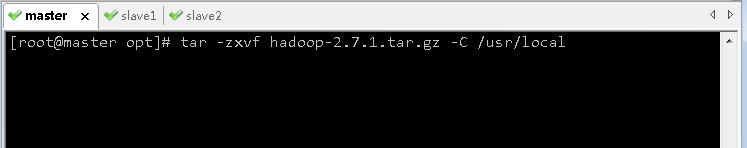

2、将hadoop安装包解压到指定位置

- 执行命令:

tar -zxvf hadoop-2.7.1.tar.gz -C /usr/local

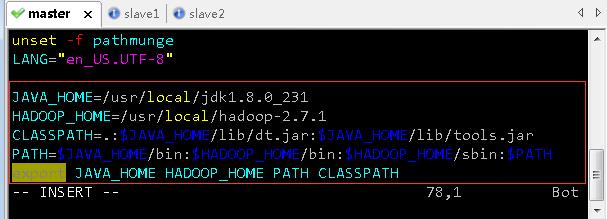

3、配置hadoop环境变量

- 执行命令:

vim /etc/profile

JAVA_HOME=/usr/local/jdk1.8.0_231

HADOOP_HOME=/usr/local/hadoop-2.7.1

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

export JAVA_HOME HADOOP_HOME PATH CLASSPATH

- 存盘退出,执行命令:

source /etc/profile,让配置生效

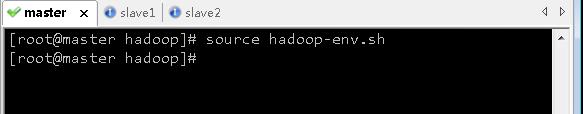

4、编辑环境配置文件 - hadoop-env.sh

- 执行命令:

cd $HADOOP_HOME/etc/hadoop,进入hadoop配置目录

- 执行命令:

vim hadoop-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_231

export HADOOP_HOME=/usr/local/hadoop-2.7.1

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

- 存盘退出后,执行命令

source hadoop-env.sh,让配置生效

- 查看三个配置的三个环境变量

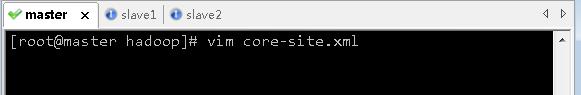

5、编辑核心配置文件 - core-site.xml

- 执行命令:

vim core-site.xml

<configuration>

<!--用来指定hdfs的老大-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<!--用来指定hadoop运行时产生文件的存放目录-->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.7.1/tmp</value>

</property>

</configuration>

- 存盘退出

- 由于配置了IP地址主机名映射,因此可用

hdfs://master:9000,否则必须用IP地址hdfs://192.168.1.103:9000

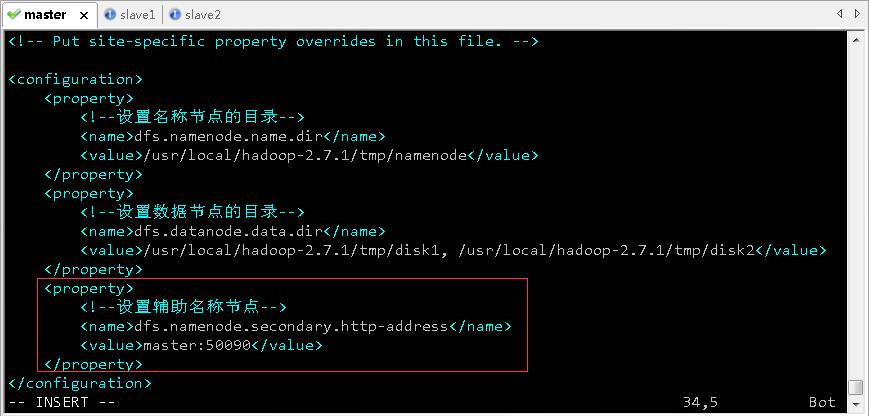

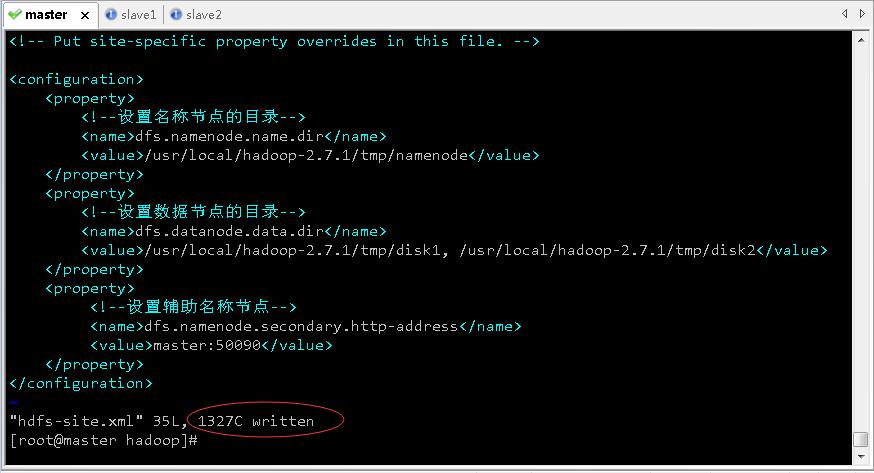

6、编辑HDFS配置文件 - hdfs-site.xml

- 执行命令:

vim hdfs-site.xml

<configuration>

<property>

<!--设置名称节点的目录-->

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop-2.7.1/tmp/namenode</value>

</property>

<property>

<!--设置数据节点的目录-->

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop-2.7.1/tmp/disk1, /usr/local/hadoo

p-2.7.1/tmp/disk2</value>

</property>

</configuration>

- 存盘退出

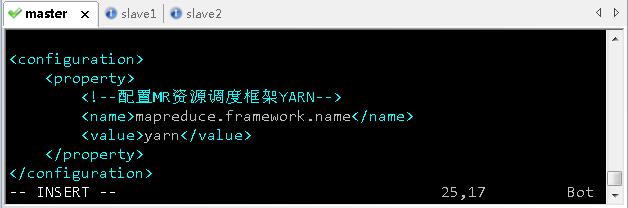

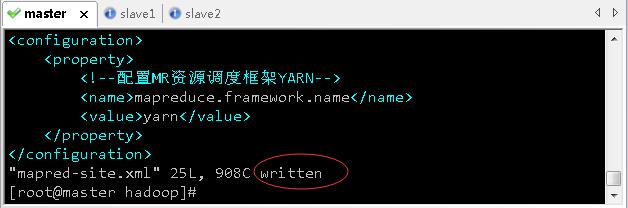

7、编辑MapReduce配置文件 - mapred-site.xml

- 基于模板生成配置文件,执行命令:

mv mapred-site.xml.template mapred-site.xml

- 执行命令:

vim mapred-site.xml

<configuration>

<property>

<!--配置MR资源调度框架YARN-->

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

- 存盘退出

8、编辑yarn配置文件 - yarn-site.xml

- 执行命令:

vim yarn-site.xml

<configuration>

<property>

<!--配置资源管理器-->

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<!--配置节点管理器-->

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

- 存盘退出

- 说明:在hadoop-3.0.0的配置中,

yarn.nodemanager.aux-services项的默认值是“mapreduce.shuffle”,但如果在hadoop-2.7 中继续使用这个值,NodeManager 会启动失败。

9、编辑slaves文件

- 通过slaves文件定义从节点,有两个:slave1与slave2

- 执行命令:

vim slaves

- 存盘退出

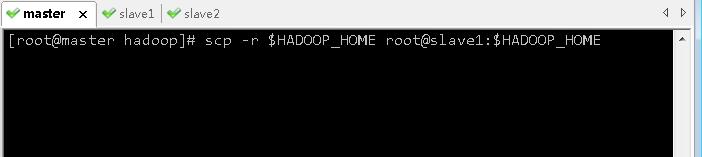

(二)在slave1虚拟机上安装配置hadoop

1、将master虚拟机上的hadoop分发到slave1虚拟机

- 执行命令:

scp -r $HADOOP_HOME root@slave1:$HADOOP_HOME

2、将master虚拟机上环境配置文件分发到slave1虚拟机

- 执行命令:

scp /etc/profile root@slave1:/etc/profile

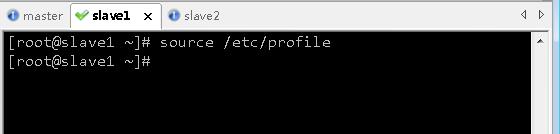

3、在slave1虚拟机上让环境配置生效

- 切换到slave1虚拟机,执行命令:

source /etc/profile

(三)在slave2虚拟机上安装配置hadoop

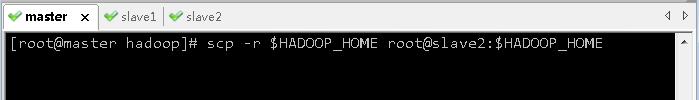

1、将master虚拟机上的hadoop分发到slave2虚拟机

- 执行命令:

scp -r $HADOOP_HOME root@slave2:$HADOOP_HOME

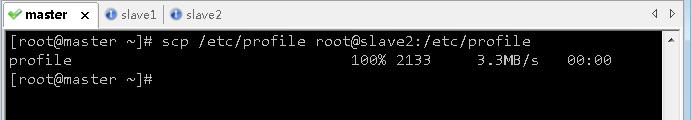

2、将master虚拟机上环境配置文件分发到slave2虚拟机

- 执行命令:

scp /etc/profile root@slave2:/etc/profile

3、在slave2虚拟机上让环境配置生效

- 切换到slave2虚拟机,执行命令:

source /etc/profile

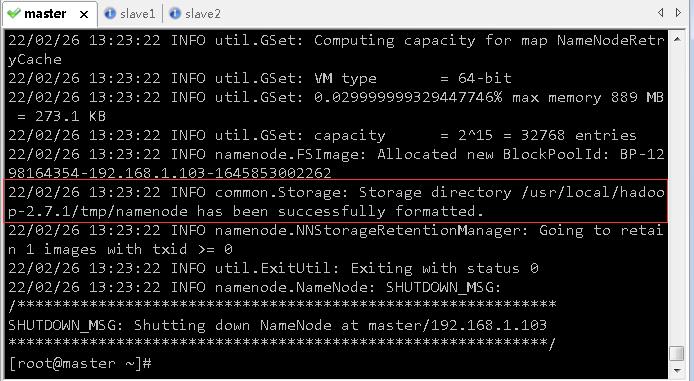

(四)在master虚拟机上格式化名称节点

- 在master虚拟机上,执行命令:

hdfs namenode -format

- 看到

22/02/26 13:23:22 INFO common.Storage: Storage directory /usr/local/hadoop-2.7.1/tmp/namenode has been successfully formatted.,表明名称节点格式化成功。

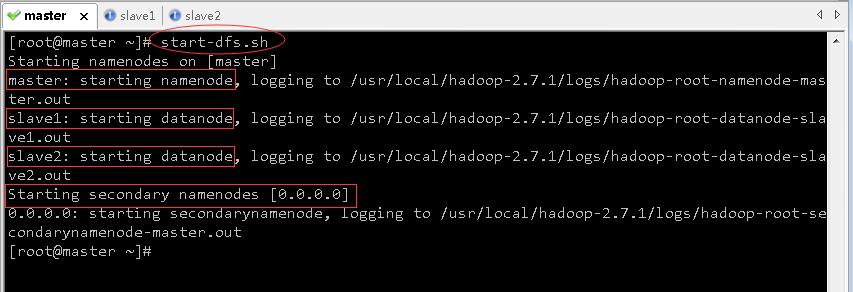

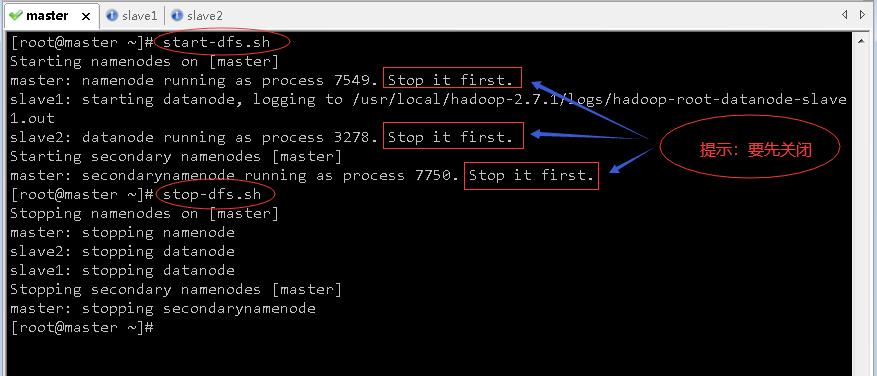

(五)启动与关闭Hadoop集群

1、在master虚拟机上启动hadoop服务

-

执行命令:

start-dfs.sh,启动hdfs服务

-

一个名称节点(namenode)——老大,在master虚拟机上;两个数据节点(datanode)——小弟,在slave1与slave2虚拟机上。

-

辅助名称节点(secondarynamenode)的地址是

0.0.0.0,这是默认的,当然可以修改,可以在hdfs-site.xml文件里配置辅助名称节点

<property>

<!--设置辅助名称节点-->

<name>dfs.namenode.secondary.http-address</name>

<value>master:50090</value>

</property>

-

存盘退出

-

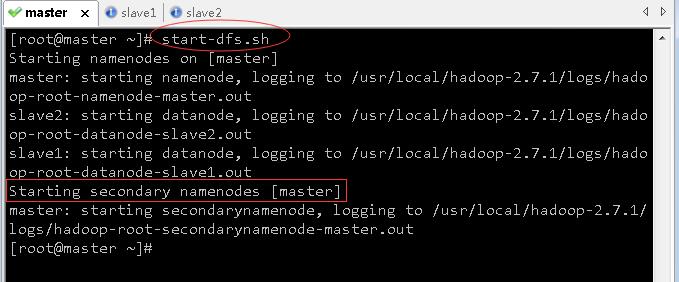

再次启动hdfs服务

-

关闭之后,再执行命令:

start-dfs.sh

-

这样就是在master虚拟机(192.168.1.103)上启动辅助名称节点(secondarynamenode)

-

此时查看三个虚拟机的进程

-

执行命令:

start-yarn.sh,启动YARN服务

-

启动了YARN守护进程;一个资源管理器(resourcemanager)在master虚拟机上,两个节点管理器(nodemanager)在slave1与slave2虚拟机上

-

执行命令

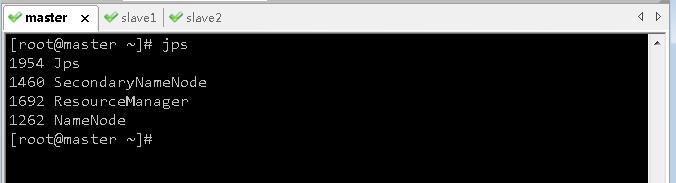

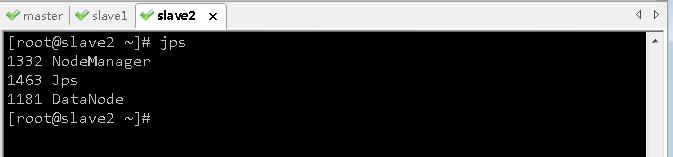

jps查看master虚拟机的进程,只有NameNode、SecondaryNameNode和ResourceManager

-

查看slave1和slave2上的进程,只有NodeManager和DataNode

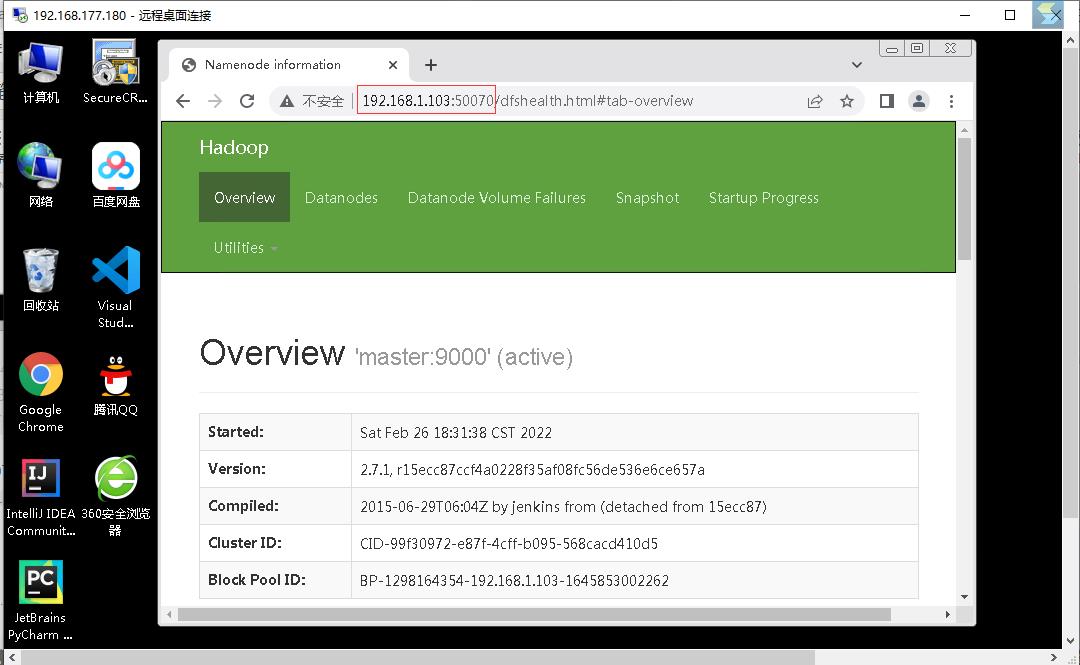

2、查看hadoop集群的WebUI界面

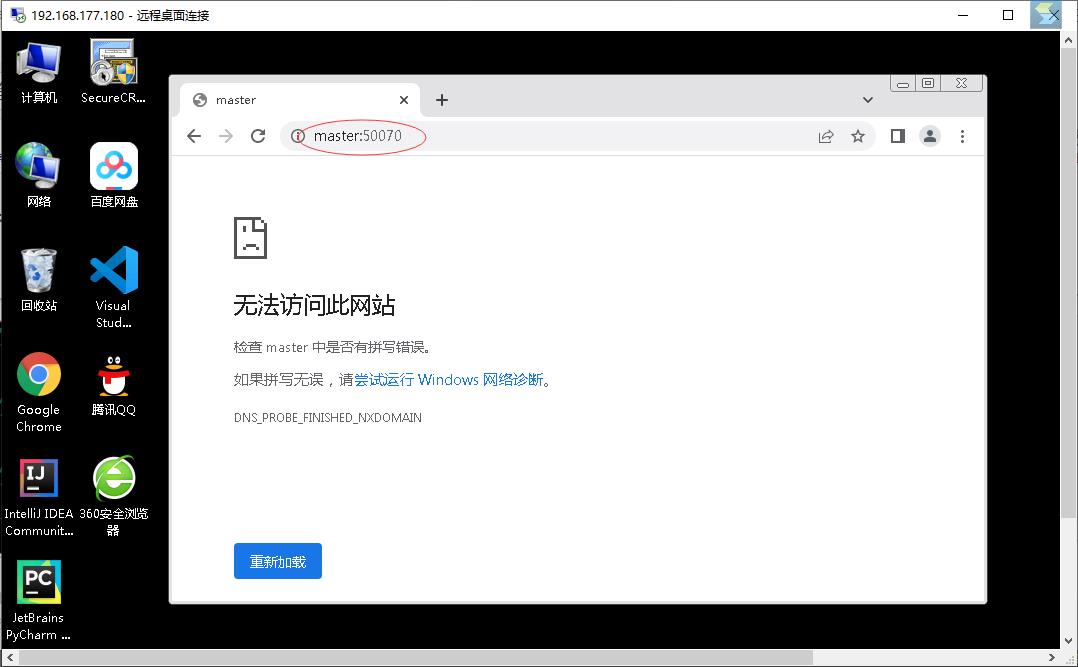

- 在hw_win7虚拟机浏览器访问

http://master:50070

- 不能通过主机名master加端口50070的方式,原因在于没有在hosts文件里IP与主机名的映射,现在可以访问

http://192.168.1.103:50070

- 修改hw_win7虚拟机上的

C:\\Windows\\System32\\drivers\\etc\\hosts文件

- 重启hadoop集群,访问

http://master:50070

- 查看数据节点信息

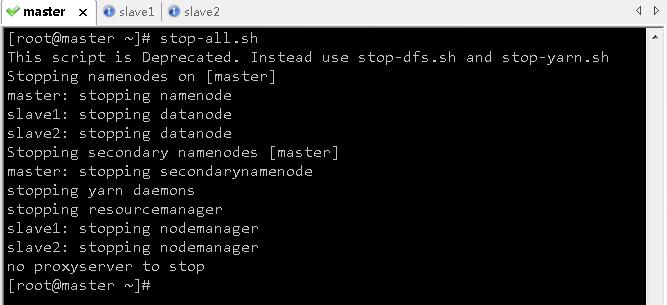

3、停止hadoop服务

- 在master虚拟机上执行命令:

stop-all.sh(相当于同时执行了stop-dfs.sh与stop-yarn.sh)

- 提示:

This script is Deprecated. Instead use stop-dfs.sh and stop-yarn.sh,说明stop-all.sh脚本已经被废弃掉了,让我们最好使用stop-dfs.sh与stop-yarn.sh。

四、配置Spark Standalone模式的集群

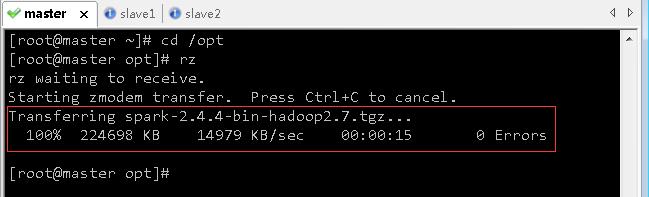

(一)在master主节点上安装配置Spark

1、上传spark安装包到master虚拟机

- 利用rz将hw_win7虚拟机上的spark安装包上传到master虚拟机/opt目录

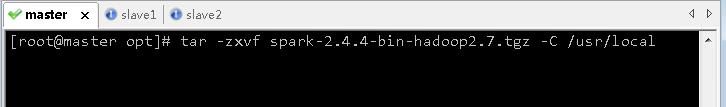

2、将spark安装包解压到master虚拟机指定目录

- 执行命令:

tar -zxvf spark-2.4.4-bin-hadoop2.7.tgz -C /usr/local

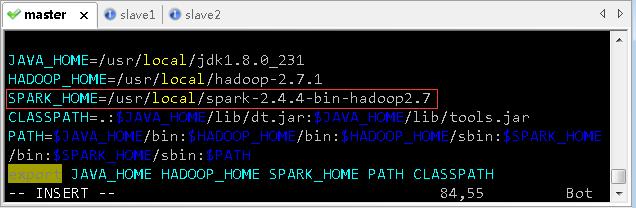

3、配置spark环境变量

- 执行命令:

vim /etc/profile

JAVA_HOME=/usr/local/jdk1.8.0_231

HADOOP_HOME=/usr/local/hadoop-2.7.1

SPARK_HOME=/usr/local/spark-2.4.4-bin-hadoop2.7

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

export JAVA_HOME HADOOP_HOME SPARK_HOME PATH CLASSPATH

- 存盘退出后,执行命令:

source /etc/profile,让配置生效

- 查看spark安装目录

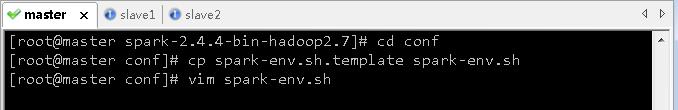

4、编辑spark环境配置文件 - spark-env.sh

- 进入spark配置目录后,执行命令:

cp spark-env.sh.template spark-env.sh与vim spark-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_231

export SPARK_MASTER_HOST=master

export SPARK_MASTER_PORT=7077

- JAVA_HOME:指定JAVA_HOME的路径。若集群中每个节点在/etc/profile文件中都配置了JAVA_HOME,则该选项可以省略,Spark集群启动时会自动读取。为了防止出错,建议此处将该选项配置上。

- SPARK_MASTER_HOST:指定集群主节点(Master)的主机名,此处为master。

- SPARK_MASTER_PORT:指定Master节点的访问端口,默认为7077。

- 存盘退出,执行命令:

source spark-env.sh,让配置生效

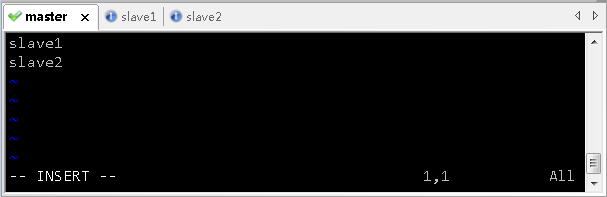

5、创建slaves文件,添加从节点

- 执行命令:

vim slaves

- 添加两个从节点的主机名

- 存盘退出

(二)在slave1从节点上安装配置Spark

1、把master虚拟机上的spark安装目录分发给slave1虚拟机

- 执行命令:

scp -r $SPARK_HOME root@slave1:$SPARK_HOME

2、将master虚拟机上环境变量配置文件分发到slave1虚拟机

- 在master虚拟机上,执行命令:

scp /etc/profile root@slave1:/etc/profile

- 在slave1虚拟机上,

以上是关于Spark基础学习笔记05:搭建Spark Standalone模式的集群的主要内容,如果未能解决你的问题,请参考以下文章