自动驾驶汽车应该如何感知世界?

Posted 车享

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了自动驾驶汽车应该如何感知世界?相关的知识,希望对你有一定的参考价值。

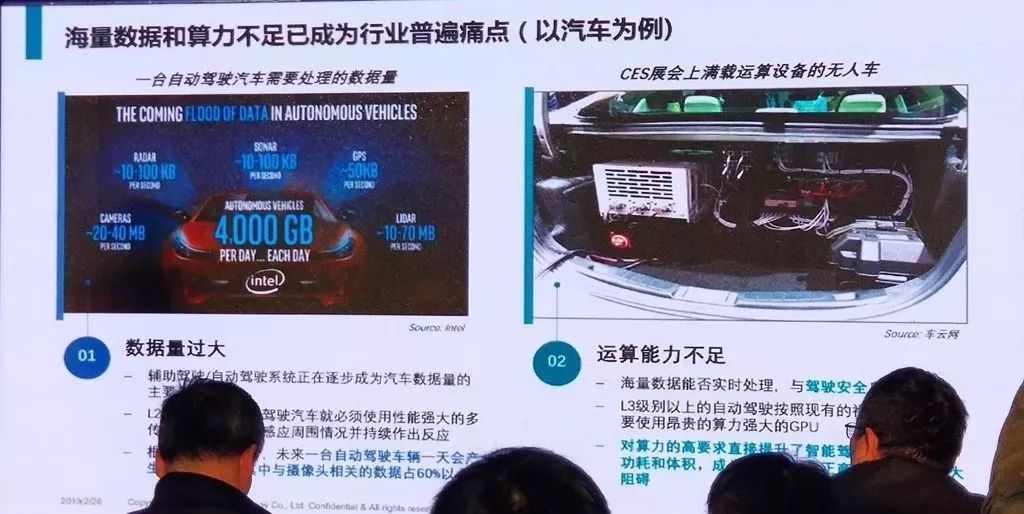

一直以来,自动驾驶所有运算都在决策层进行,芯片算力不足是高等级自动驾驶发展受制约的原因之一,那么能不能从感知层面减少数据流,降低芯片运算量呢?

大家应该知道,高等级的自动驾驶需要多种传感器共同配合,视觉传感器也是其中之一。

传统的机器视觉是怎样的?

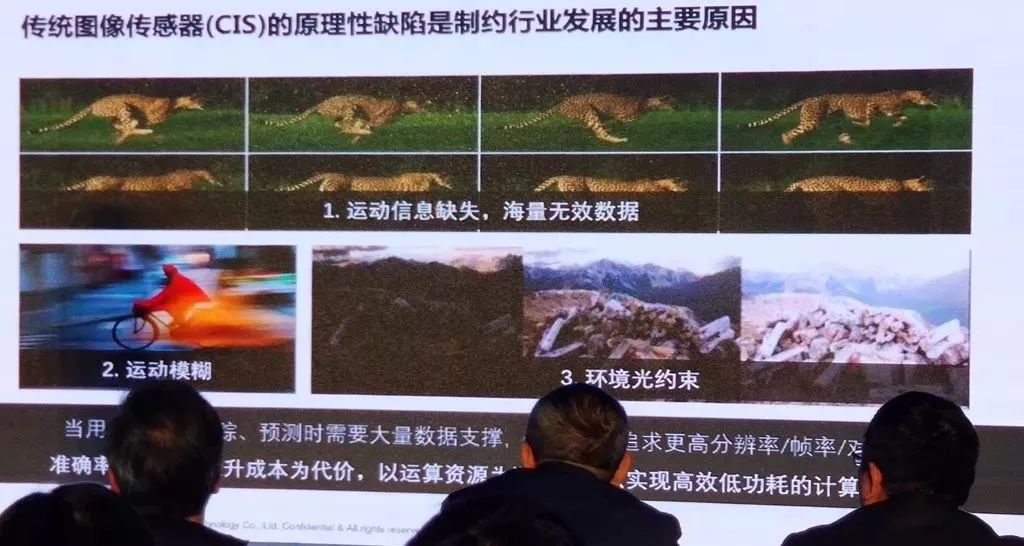

传统摄像头通过间隔曝光,电荷量根据输入光的强度发生变化,以帧率的方式采集平面图像,将捕捉到的光学信息(包括采集点的灰度和颜色)转化成数字信号传输到决策层,实现场景的还原。

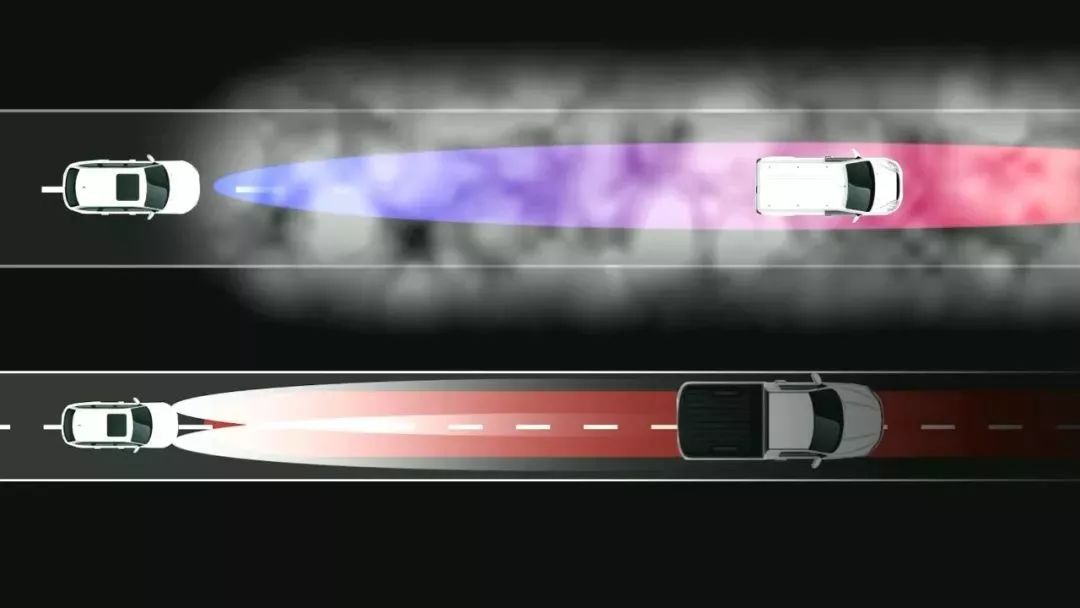

这就存在几个问题,一是数据不连续,帧的方式只记录了固定时间间隔的画面,还有大量曝光盲区时间点的物体运动信息丢失,同时快速运动场景下图像也不清晰甚至没有记录到;二是输出了大量无效冗余数据,增加芯片负担,造成计算资源浪费。

革新:让汽车的眼睛和耳朵拥有智慧

传统摄像头把 “看到”的所有画面输出到决策层,让芯片过滤筛选有用的信息,这是一种懒办法。所有有人提出了革新,那就是从感知层解决一部分数据,让汽车传感器拥有智慧,主动对信息过滤,并对有用信息加以分析后再输出。

就像古代的皇帝和大臣,作为皇帝的“耳目”,如果大臣没脑子,一股脑把所有奏折递交给皇帝,那皇帝一定会累死;而如果大臣能主动过滤一些没用的奏折,挑选出自己不能决定的那部分交给皇帝决策,那么整个国家就能高效运转。

今天我们要说的是保隆发布的一款动态视觉传感器DVS,它就是这个聪明的“大臣”。

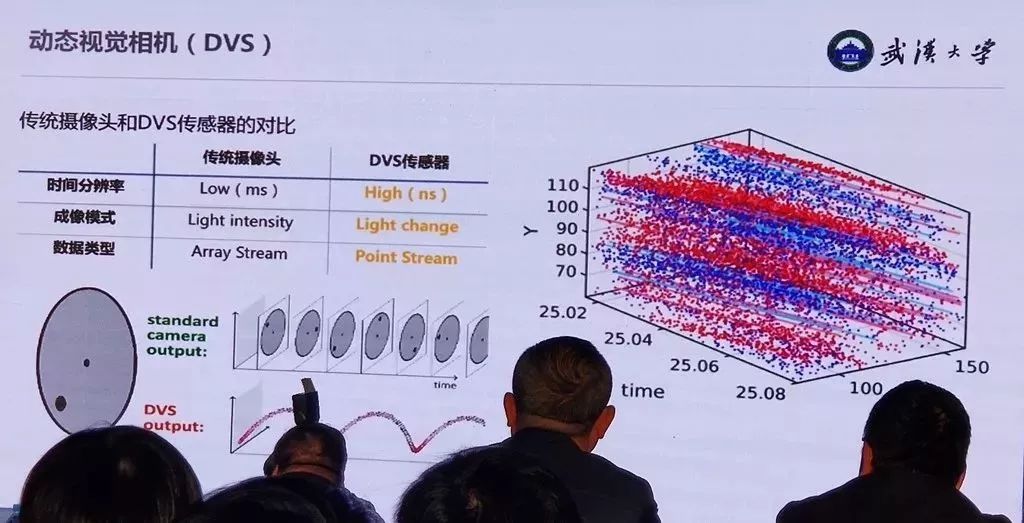

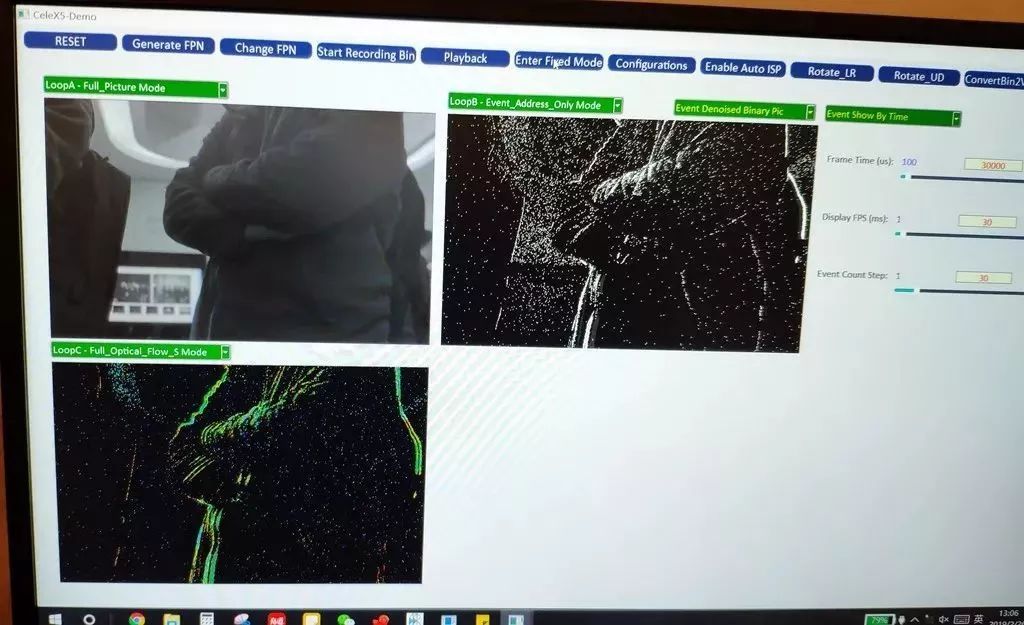

保隆动态视觉传感器集成芯仑科技的芯片技术和武汉大学的算法技术,芯片模仿人眼视神经,摒弃传统图像帧率和曝光感知的方式,采用事件驱动原理,即以像素点的方式连续单独监测光强波动,仅在有光强变化时才能激发像素点进行数据输出,产生较低的数据率。

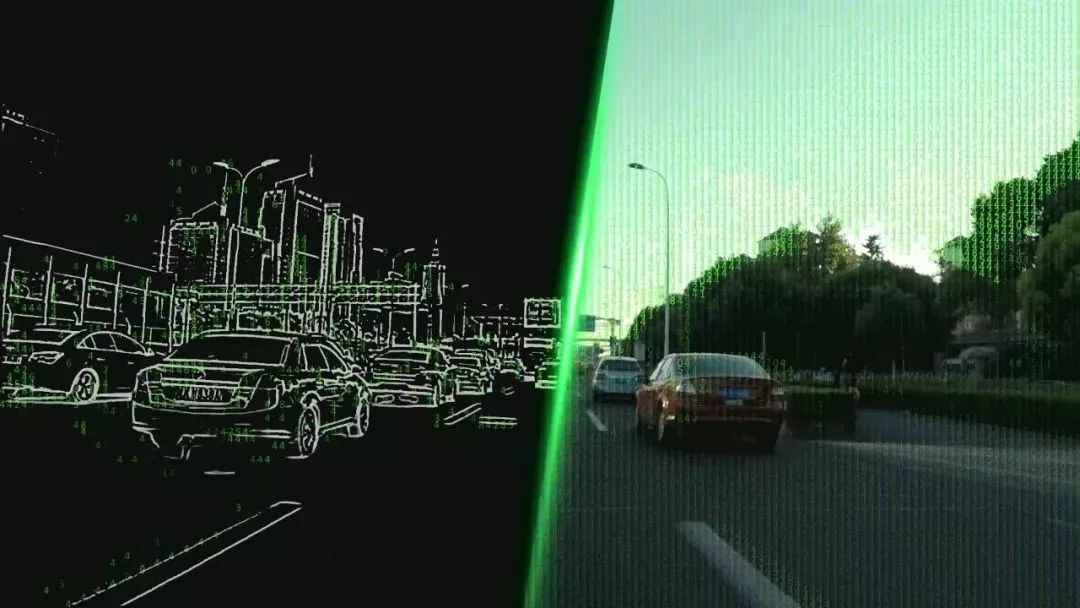

同时像素点的时间分辨率达到纳秒,相当于每秒几十万帧,能采集到更高速度的运动物体。动态范围高达140dB(普通相机一般都是60-70dB,车载要求达到120dB),让它也能在诸如隧道、大雾、等强弱光交替变化的环境条件下快速输出清晰图像,还能记录物体的运动矢量信息,从而预测物体运动趋势。

简单来说,你可以把它理解为青蛙的眼睛,对静态的物体视而不见,而对有相对运动的物体哪怕速度快过子弹,都能精准捕捉并预测轨迹。

动态视觉传感器能带来哪些优势?

据介绍,目前世界上做动态视觉传感器方案的公司并不多,包括瑞士的Inilabs、法国的Prophesee、三星(licensed IP)及保隆科技,前三者的传感器分辨率最大只到30万像素,而保隆科技目前做到了100万像素(车规级)。

同时它还拥有三种图像输出模式:

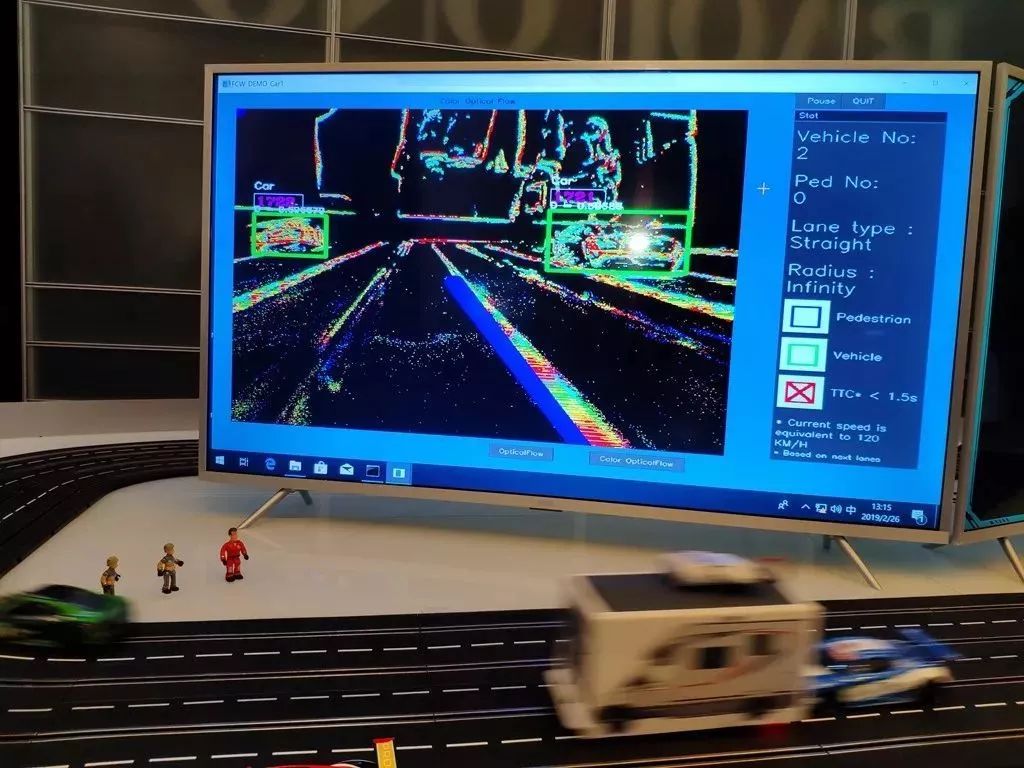

图片模式,与传统图像传感器一样的全幅图像,并兼容传统图像处理算法和硬件;

光流模式,从芯片上得到光流向量场信息,直接输出全分辨率运动矢量(方向和速度),能够对物体的运动方向和速度都有正确的预测;

动态模式,通过对自然光强变化的判定输出仿生的动态特征脉冲信号。

通过灵活运用三种数据流对算法进行优化,在很多场景下能将运算量降级上千倍。

举一个简单的应用案例就是,采用这种芯片技术的ADAS系统,跟传统的摄像头技术路径相比,其传感器从感知到信号到控制指令发出,时间可节省几百毫秒,对于一台时速120公里/小时的车辆而言,制动就能提前5米完成。

所以它不但解决了自动驾驶中算力不足的问题,还能帮助系统更快、更准、更轻松地感知外部环境,作用几乎可以代替激光雷达,而成本比激光雷达低了一个数量级,只比传统摄像头贵一些,将极大降低自动驾驶系统的成本。

法国咨询公司YOLE就将动态视觉传感器定义为L4和L5级别的自动驾驶必不可少的传感器之一。

点击“阅读原文”,进入车享的世界!

以上是关于自动驾驶汽车应该如何感知世界?的主要内容,如果未能解决你的问题,请参考以下文章