朴素贝叶斯与逻辑回归

Posted 每周一结

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了朴素贝叶斯与逻辑回归相关的知识,希望对你有一定的参考价值。

区别:直接对后验概率P(y|x)建模,使用极大似然估计法使其最大化不需要优化参数,先用极大似然估计法估计出先验概率P(y)和条件概率P(x|y),然后计算出极大后验概率P(y|x)

| 朴素贝叶斯 |

逻辑回归 |

| 生成模型 | 判别模型 |

| 对特征x和目标y的联合分布P(x,y)建模,使用极大后验概率估计法估计出最有可能的P(y|x) | 直接对后验概率P(y|x)建模,使用极大似然估计法使其最大化 |

| 不需要优化参数,先用极大似然估计法估计出先验概率P(y)和条件概率P(x|y),然后计算出极大后验概率P(y|x) |

需要优化参数,先用极大似然估计法得出损失函数,再用梯度下降法等优化参数 |

| 假设特征之间相互独立,对于不相互独立的特征,朴素贝叶斯的分类效果会差一些 | 不必假设特征之间是相互独立的,对于不相互独立的特征,逻辑回归会在训练过程中对参数自动调整 |

通常来说,小数据可以用贝叶斯,大数据推荐逻辑回归。

对比两种方法的论文:http://ai.stanford.edu/~ang/papers/nips01-discriminativegenerative.pdf

本次实例是预测收入是否超过50000刀。

使用的方法为逻辑回归

首先是对数据进行读取并做好分割。

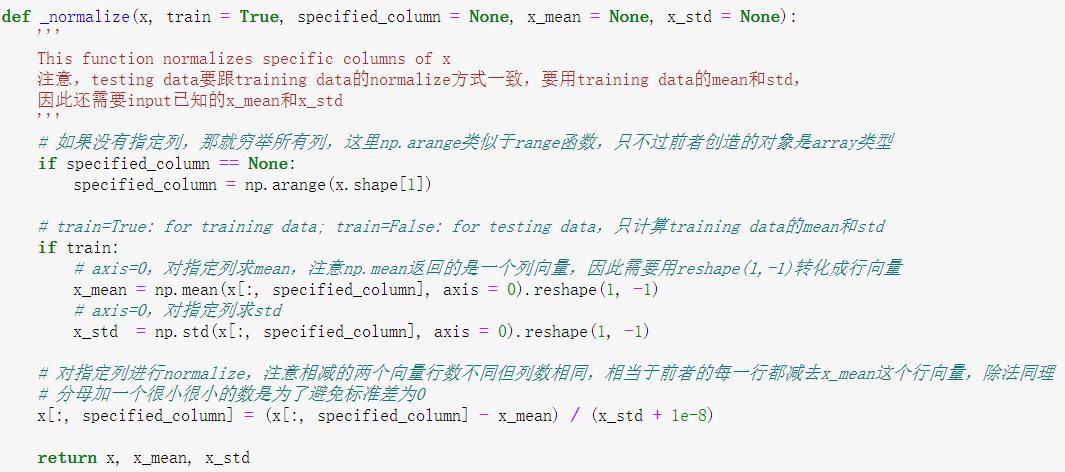

定义归一化函数。

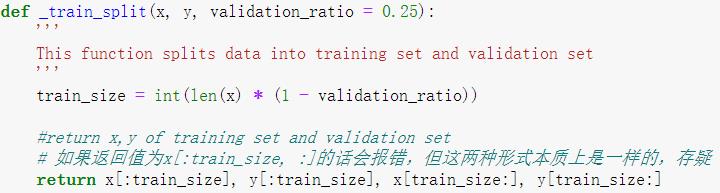

定义训练集分割函数。

归一化数据并划分训练集与测试集。

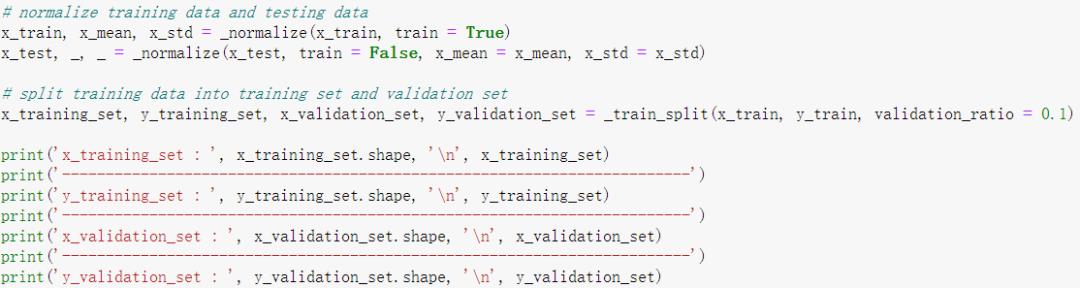

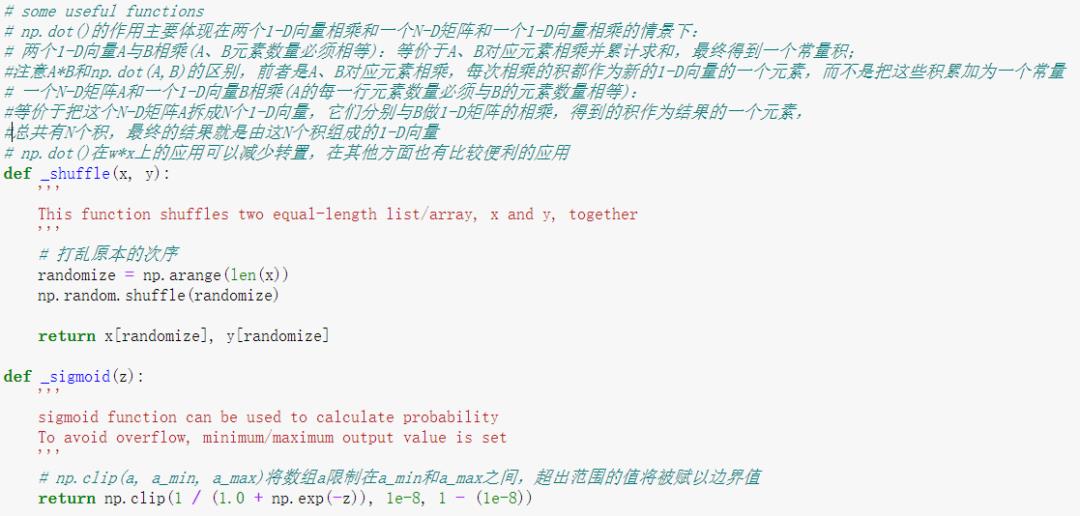

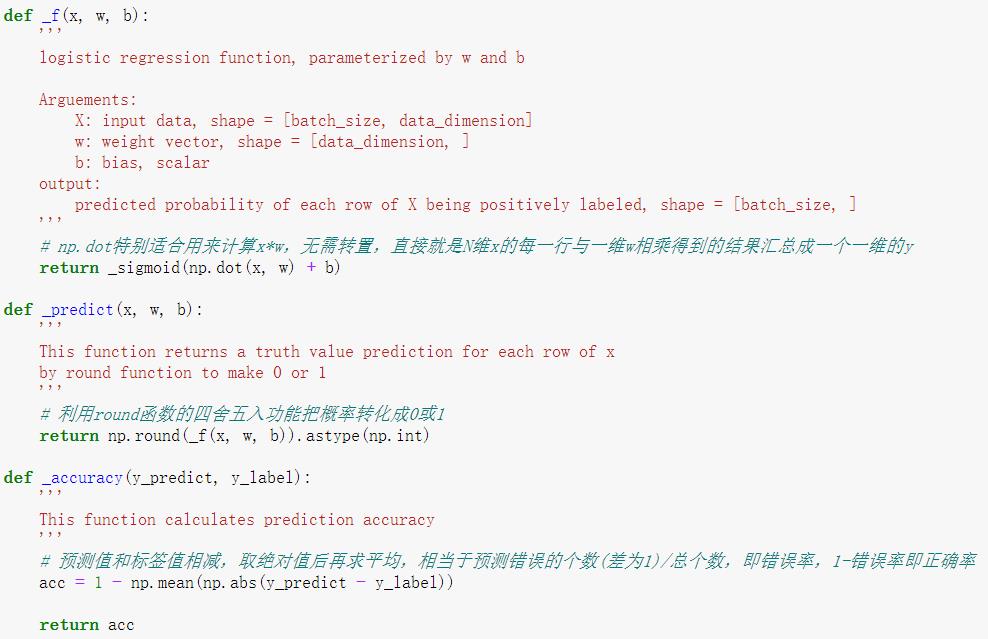

定义将来需要使用的函数,如乱序,sigmoid函数,逻辑回归方程,准确率计算。

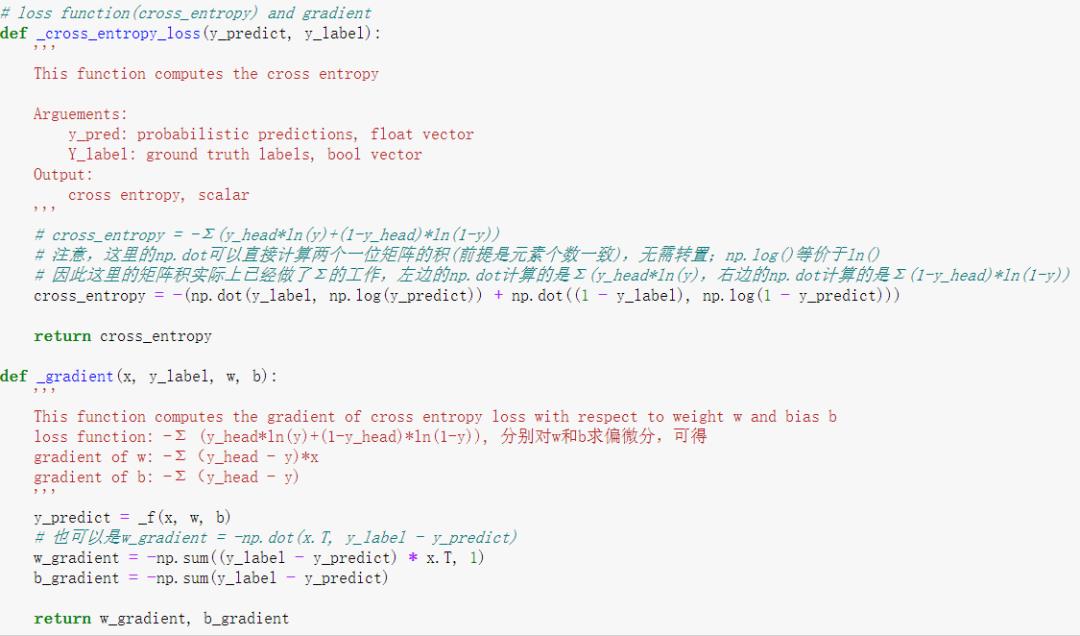

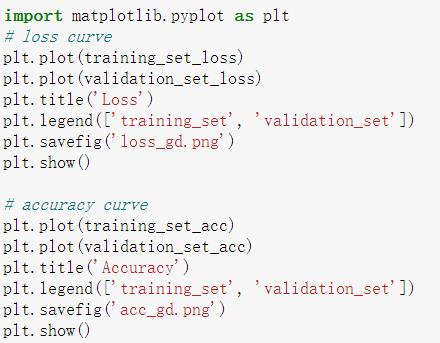

定义损失函数与梯度下降函数。

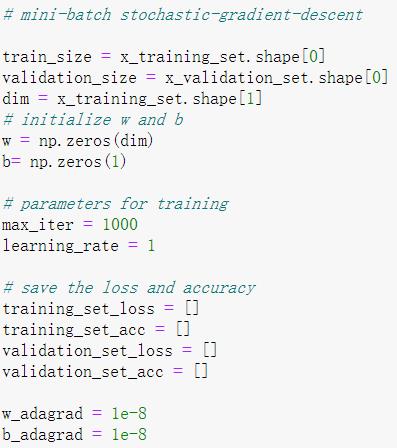

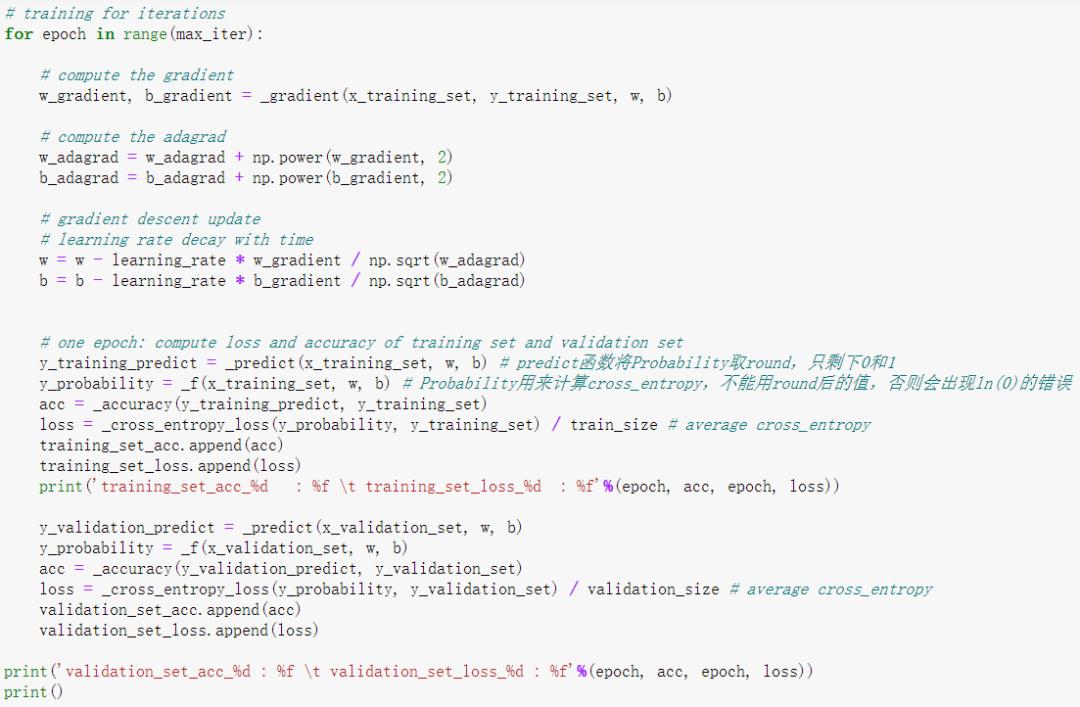

训练学习

画图比较

最终图像直观结果为

以上是关于朴素贝叶斯与逻辑回归的主要内容,如果未能解决你的问题,请参考以下文章