深度学习已经达到极限了吗?

Posted AI前线

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度学习已经达到极限了吗?相关的知识,希望对你有一定的参考价值。

更多优质内容请关注微信公众号“AI 前线”(ID:ai-front)

许多人都持这一观点:算法终将会超越人类,具有认知意识。机器可以在没有人为干预的情况下识别和学习任务,并陆陆续续地将工人替换掉。它们完全可以进行 “思考”。许多人甚至提出了是否可以拥有机器人配偶的问题。

这一观点并不是今天才有,其实早在 20 世纪 60 年代,这一论调曾被到处宣扬,人工智能先驱 Jerome Wiesner、Oliver Selfridge 和 Claude Shannon 坚信这些想法在不久的将来就会实现,你会怎么想呢?如果你对此感到惊讶,那么请你看下面的这段视频,你会觉得这段视频中透露出来的情绪似曾相识。

让我们看看 1973 年,由于人工智能夸张的、大肆的炒作,吹得天花乱坠,产生了适得其反的结果。英国议会派了 James Lighthill 去做调查英国人工智能研究情况的报告(https://en.wikipedia.org/wiki/Lighthill_report)。这份报告批评了人工智能未能实现令人激动的承诺。有趣的是,Lighthill 还指出,专业程序(或人员)如何比 “人工智能” 同行的表现更好,人工智能在现实世界没有前途。于是,英国政府撤销了所有的人工智能研究经费。(作者注:Toby Walsh(https://en.wikipedia.org/wiki/Toby_Walsh)本人纠正了我,实际情况是,20 世纪 80 年代,作为对日本第五代人工智能项目的回应,英国的人工智能研究随 Alvey 项目(https://en.wikipedia.org/wiki/Alvey)而复兴。)

在大西洋彼岸,美国国防部在人工智能研究上投入了大量资金,但后来又因为同样的问题,撤销了几乎所有人工智能研究的资助:因为人工智能的能力被人为夸大,成本高昂却没有回报,在现实世界中的价值也令人生疑。

在上世纪 80 年代,日本满腔激情在人工智能领域进行大胆的尝试,推出了第五代人工智能项目(https://en.wikipedia.org/wiki/Fifth_generation_computer)。然而,这一项目最后宣告失败,耗资高达 8.5 亿美元。

上世纪 80 年代末,人工智能进入了 “低谷”(https://en.wikipedia.org/wiki/AI_winter#The_Lighthill_report),这是计算机科学中的一个黑暗时期,人工智能研究组织和政府面临着交付失败和巨大损失。这场失败使人工智能研究停滞了数十年。

通常,这些公司是由 FOMO 驱动的,而不是由实际用例驱动的,他们担心自己会被自动化竞争对手甩在后面。(译者注:FOMO:Fear Of Missing Out,错失恐惧症。此处指一种普遍存在于公司的担忧,他们普遍认为,自己缺席的时候,其他公司可能正在获得有利可图的投资机会等等。)

到了 20 世纪 90 年代,“人工智能”变成了一个贬义词,这一状况一直延续到 21 世纪早期。那时候公众普遍认为 “人工智能根本没有用”。那些开发看似智能程序的软件公司,实际上使用的是“搜索算法”、“业务规则引擎”、“约束求解器” 和“运筹学”等来开发的。值得一提的是,这些宝贵工具确实来自人工智能研究的成果,但由于未能实现更宏伟的目标,因此它们被重新命名了。

但到了 2010 年前后,情况又开始发生了变化。公众重燃对人工智能的兴趣,图像分类竞赛吸引了媒体的眼球(http://u6.gg/gRmwd)。硅谷坐拥海量数据,足够的数据第一次使神经网络变得有用了。

到 2015 年,许多财富 500 强企业的巨额预算为人工智能研究所占据。这些公司通常是由 FOMO 驱动的,而非实际用例,他们担心自己会被自动化竞争对手甩在后面。毕竟,没有什么比让神经网络能够识别出图像中的物体(https://youtu.be/vIci3C4JkL0)更让人感到震撼了!对外行来说,下一个肯定就是天网的能力了。

但,这真的是迈向真正人工智能的一步吗?或者说历史正在重演,只不过这一次被一些成功用例所鼓舞罢了?

很长一段时间以来,我一直不喜欢 “人工智能” 这个词。它如此模糊,又如此深远,更多的是由营销人员而不是科学家来定义的。当然,市场营销和流行语对于激发积极变革和拥抱新思想来说还是有必要的(http://u6.gg/gRm34)。然而,流行语运动不可避免地带来了混淆。我的华硕新款智能手机有一个 “人工智能铃声”(AI Ringtone)的功能,可以动态调整铃声音量,使其刚好盖过环境噪声。这玩意儿我想可以用一系列的if条件语句,或者简单的线性函数就能做出来,这样做出来的东西居然也称之为 “人工智能”?那好吧,如果这也算人工智能的话。

有鉴于此,“人工智能” 的定义备受广泛争议也就不足为奇了。我喜欢 Geoffery De Smet 给出的定义(http://u6.gg/gRm4t),它指出人工智能解决方案是针对具有不确定性答案和 / 或不可避免的误差范围的问题。这将包括各种各样的工具,从机器学习到概率和搜索算法。

也可以说,人工智能的定义在不断发展,只包括突破性的发展,而过去的成功,如光学字符识别(OCR)或语言翻译,则不再被认为是 “人工智能”。因此,“人工智能” 是一个相对的术语,而不是绝对的术语。

近年来,“人工智能”经常与 “神经网络” 联系在一起,这也是本文关注的重点。当然还有其他的 “人工智能” 解决方案,从其他机器学习模型(朴素贝叶斯、支持向量机、XGBoost)到搜索算法。然而,神经网络可以说是目前最热门、最受追棒的技术。如果你想了解更多关于神经网络的知识,请观看我下面发布的视频。

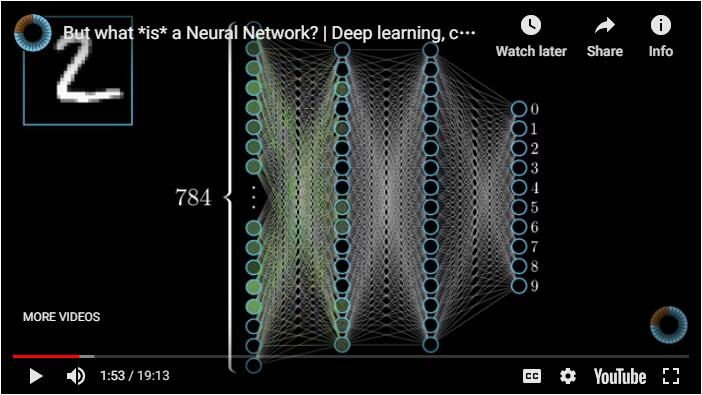

如果你想得到更为全面的解释,你可以观看 Grant Sanderson 关于神经网络的精彩视频系列:

2010 年后,人工智能炒作又重新抬头,仅仅是因为掌握了一类新的任务:分类。更具体地说,多亏了神经网络,科学家已经开发出有效的方法来分类大多数类型的数据,包括图像和自然语言。甚至自动驾驶汽车也属于分类任务,在分类任务中,周围道路的每一幅图像都转化为一组不相关联的操作(如加油、刹车、左转、右转等)。为了得到它的工作原理的简化概念,请观看这段视频教程来了解如何制作电子游戏人工智能:https://youtu.be/ZX2Hyu5WoFg

在我看来,相比纯粹的分类,自然语言处理更令人印象深刻。公众很容易相信这些算法是有感知能力的,但是,如果你仔细研究它们,你就会发现,它们依赖于语言模式,而不是有意识构建的思想。这些可能会导致一些有趣的结果,比如这些机器人会为你钓出诈骗者:

这一切都让人久久不忘,肯定有一些有用的应用程序。但是,我们真的需要降低预期,并停止夸大 “深度学习” 的能力。因为如果我们不这样做的话,我们可能会发现自己处于另一个人工智能的冬天。

康奈尔大学的 Gary Marcus 写了一篇关于深度学习局限性的有趣文章《Deep Learning: A Critical Appraisal》(https://arxiv.org/abs/1801.00631),并提出了几个发人深省的观点(在这篇文章走红之后,他还写了一篇同样有趣的后续文章《In defense of skepticism about deep learning》(https://medium.com/@GaryMarcus/in-defense-of-skepticism-about-deep-learning-6e8bfd5ae0f1))。Rodney Brooks 正在整理时间轴,并通过引用的研究跟踪他对人工智能炒作周期预测(http://rodneybrooks.com/predictions-scorecard-2019-january-01/)。

怀疑派通常分享了几个关键点。神经网络需要大量的数据,即使在今天,数据也是有限的。这也是为什么你在 YouTube 上看到的 “游戏” 人工智能的例子(如 https://youtu.be/SO7FFteErWs、https://youtu.be/ZX2Hyu5WoFg)经常需要连续几天不断地输掉游戏,直到神经网络找到一个让它获胜的模式的原因。

我们真的需要降低预期,并停止夸大 “深度学习” 的能力。如果我们不这样做的话,我们可能会发现自己处于另一个人工智能的冬天。

神经网络之所以 “深”,是因为它们在技术上有多层节点,而不是因为它对问题有什么深入的理解。这些层也使得神经网络变得让人难以理解,即使对于它的开发者来说也是如此。最重要的是,当神经网络冒险进入其他问题空间时,比如 Traveling Salesman Problem(旅行商问题)(https://youtu.be/j1s69yf4a9Y),它们的回报正在减少。这是有道理的。在搜索算法更加有效、可扩展且经济时,为什么我还要用神经网络来解决旅行商问题呢?(http://u6.gg/gQCTP)

当然,有些人希望将更多的问题空间推广到神经网络中,尽管这很有趣,但它似乎很难胜过任何专门的算法。

麻省理工学院的 Luke Hewitt 在这篇文章《The Unreasonable Reputation of Neural Networks》(http://thinkingmachines.mit.edu/blog/unreasonable-reputation-neural-networks)说得最好:

仅仅基于一项任务,单凭直觉就判断一台机器的智能程度或能力,这可不是一个好主意。20 世纪 50 年代的跳棋机器就曾让研究人员大吃一惊,当时许多人认为这是人类水平推理的巨大飞跃,但到现在我们才明白,在这类游戏中,实现人类或超人的表现要比实现人类水平的通用人工智能容易多了。事实上,即使是最优秀的人,机器也可以通过简单的启发式搜索算法轻松将其击败。在一项任务中,人类或超人的表现并不一定是在大多数任务中接近人类表现的垫脚石。

— Luke Hewitt

我认为同样值得指出的是,神经网络需要大量的硬件和能量才能进行训练。对我来说,这种感觉是不可持续的。当然,神经网络预测的效率要比它训练的要高得多。然而,我认为要实现人们对神经网络的夙愿,需要不断的训练,因此需要指数级的能量和成本。确实,计算机是越来越快,但芯片制造商能否继续维持摩尔定律呢(https://www.scientificamerican.com/article/end-of-moores-law-its-not-just-about-physics/)?

这是有道理的。在搜索算法更加有效、可扩展且经济时,为什么我还要用神经网络来解决旅行商问题呢?

正是由于这些原因,我认为,另一场人工智能的冬天即将来临。越来越多的专家和博主站出来指出这些局限性(如 http://u6.gg/gRh5H、http://u6.gg/gRh5j)。公司仍然无须斥巨资就能得到最好的 “深度学习” 和“人工智能”人才,但我认为,许多公司意识到深度学习并非他们所需,只是一个时间问题罢了。更槽糕的是,如果你的公司没有 Google 那样雄厚的研究预算,也没有博士人才,或者没有从用户那里收集的海量数据存储,你很快就会发现,你的 “深度学习” 前景实际非常有限。这是 HBO 电视剧《Silicon Valley》(WARNING:language)中最精彩的一幕:

每一次人工智能低谷来临之前,都会有科学家夸大和炒作他们创造的潜力。仅仅说他们的算法就能够很好地完成某项任务是不够的。他们的野心是让人工智能能够适应任何任务,或者至少能给人留下这样的印象。例如,AlphaZero 只不过是一种更好的国际象棋算法(http://u6.gg/gRh7T),而媒体的反应却是:“哇,我的天啊!通用人工智能来了!大家快四散逃命啊!机器人来了!” 然后,科学家不去费心纠正这些错误的报道,反而用巧妙的词汇来鼓励这一切。毕竟,降低预期无助于风投融资。但是,为什么尽管存在机器人的局限性,人工智能研究人员还是将算法人格化(译者注:人格化,anthropomorphize,见维基百科上的解释:https://en.wikipedia.org/wiki/Anthropomorphism)呢?可能还有其他原因。与其说是科学问题,不如说是哲学问题。我将留到本文最后讲述这一点。

当然,并非所有使用 “机器学习” 或“人工智能”的公司都在使用“深度学习”。一名优秀的数据科学家可能已经被雇佣来构建神经网络,但当他真正研究这一问题时,会发现反而更适合构建一个朴素贝叶斯分类器(https://youtu.be/JLSdW60t898)。对于那些已经成功应用图像识别和语言处理的公司来说,他们将会继续愉快地这样做下去。但是,我确实认为神经网络不会在远离这些问题空间取得进展。

降低预期终究无助于风投融资。

历史上的人工智能低谷对计算机科学的发展带来了毁灭性的影响。值得指出的是,今天一些有用的东西,正是发轫于那个时期的研究成果,如,搜索算法,可以在国际象棋中获胜(http://u6.gg/gRhKD);又如最小化运输成本问题(https://www.youtube.com/watch?v=j1s69yf4a9Y)。简而言之,出现的创新算法往往在某项特定任务中表现出色。

我要指出的是,对于许多类型的问题,已经有很多行之有效的解决方案了。为了避免在人工智能冬天中被淘汰的命运,你能做的最好的事情就是明确你要解决的问题,并理解其本质。然后,寻找为特定问题提供解决方案的直观路径的方法。如果要对文本消息进行分类,你可能需要使用朴素贝叶斯(https://youtu.be/JLSdW60t898);如果你想优化交通网络,可以使用离散优化(http://u6.gg/gRhRT)。无论来自同行的压力有多大,你都可以带着健康的怀疑态度来处理复杂的模型,并质疑这是否正确的方法。

如果你不认同毕达哥拉斯哲学,那么,你所能想到的最好的方法就是,让人工智能 “模拟” 人类的行为,给人一种它拥有情感和思想的错觉。

我希望本文向读者清晰阐述了这一点:对大多数问题来说,深度学习并不是正确的解决方法。不要试图为所有的问题寻找通用人工智能解决方案,因为它根本就不存在。

我想在本文中提出的最后一点是,它更具有哲学意义,而非科学性。我们的每一个想法和感觉,真的只是简单地将一堆数字以线性代数的方式相乘和相加吗?事实上,我们的大脑仅仅是一个整天做点积的神经网络,对吗?这听起来几乎很像是毕达克拉斯哲学,将我们的意识简化为一个数字矩阵(http://u6.gg/gRhVr)。也许这就是为什么如此多的科学家相信通用人工智能是有可能实现的,因为作为人类和作为一台计算机并没有什么不同。(我只是指出这一点,至于这种世界观是对还是错,不予置评。)

无论来自同行的压力有多大,你都可以带着健康的怀疑态度来处理复杂的模型,并质疑这是否正确的方法。

如果你不认同毕达哥拉斯哲学,那么,你所能想到的最好的方法就是,让人工智能 “模拟” 人类的行为,给人一种它拥有情感和思想的错觉。翻译程序并不懂汉语,但它通过寻找概率模式来 “模拟” 能够理解汉语的错觉(https://en.wikipedia.org/wiki/Chinese_room)。当你的智能手机 “识别” 出狗狗的照片,它是真的认识犬类吗?或者它看到之前曾看过的数字模式?

译者注:点积,Dot Products,是两个矢量上的函数并返回一个标量的二元运算,它的结果是欧几里得空间的标准内积。两个矢量的点积写作 a·b,也称作内积、数量积及标量积。

原文链接:

https://towardsdatascience.com/is-deep-learning-already-hitting-its-limitations-c81826082ac3

今日荐文

发展 70 年,最好的监督学习模型长啥样?

深度学习已经成为人工智能领域最热门的技术,而 TensorFlow 作为当下最流行的深度学习框架,是从事人工智能相关工作必不可少的一环。谷歌机器学习开发专家彭靖田《 TensorFlow 快速入门与实战》,带你 10 小时掌握目前最流行的深度学习框架,限时优惠 ¥99,原价 ¥129,还有5天恢复原价。点击「阅读原文」或扫描二维码,试看或者订阅!

喜欢这篇文章吗?记得点一下「好看」再走 以上是关于深度学习已经达到极限了吗?的主要内容,如果未能解决你的问题,请参考以下文章 DELM分类基于matlab麻雀搜索算法改进深度学习极限学习机数据分类含Matlab源码 2235期