MIT警告深度学习正在逼近计算极限,网友:放缓不失为一件好事

Posted 机器之心

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了MIT警告深度学习正在逼近计算极限,网友:放缓不失为一件好事相关的知识,希望对你有一定的参考价值。

深度学习需要大量数据和算力,这二者的发展是促进这一次人工智能浪潮的重要因素。但是,近期 MIT 的一项研究认为,深度学习正在逼近算力极限。

这项研究由 MIT、MIT-IBM Watson AI 实验室、延世大学安德伍德国际学院和巴西利亚大学的研究人员开展,他们发现深度学习的进展「极大地依赖」算力增长。他们认为,深度学习要想继续进步,需要更加计算高效的深度学习模型,这可以来自于对现有技术的更改,也可以是全新的方法。

论文链接:

https://arxiv.org/pdf/2007.05558.pdf

该研究作者表示:「我们发现,深度学习计算成本高昂并非偶然,而是从设计之时就注定了。灵活性可以使深度学习很好地建模不同现象并超越专家模型,但也带来了昂贵的算力成本。尽管如此,我们发现深度学习模型的实际计算负载要比理论极值扩展得更加迅速,这意味着可能出现显著改进。」

深度学习是机器学习的子领域,其算法受到大脑结构和功能的启发。这类算法——通常叫做人工神经网络,包含函数(神经元),网络层负责将信号传递给其他神经元。信号也就是网络输入数据的产物,它们在层与层之间流动,并缓慢地「调优」网络,从而调整每个连接的突触强度(权重)。神经网络最终通过提取数据集特征、识别跨样本趋势来学习执行预测。

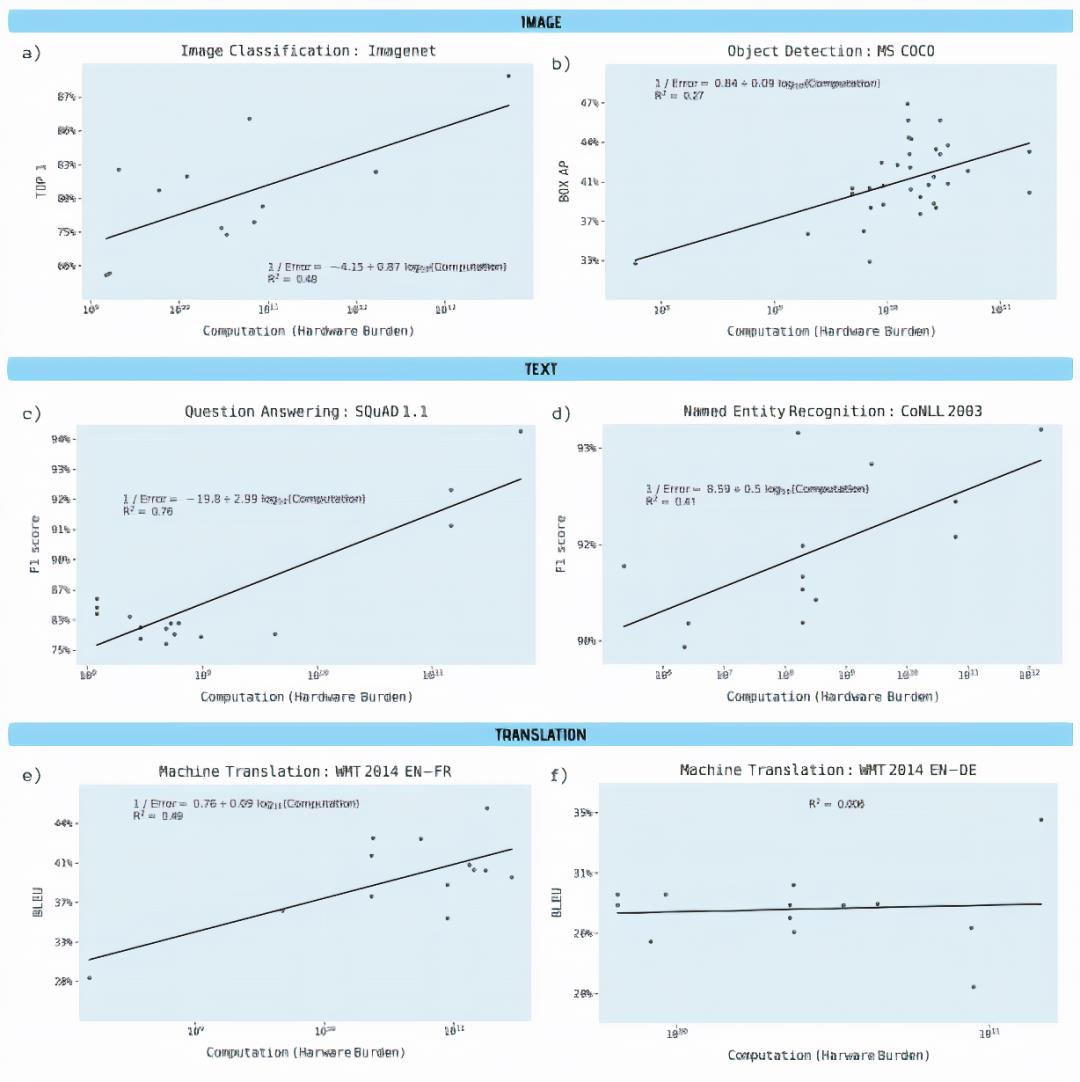

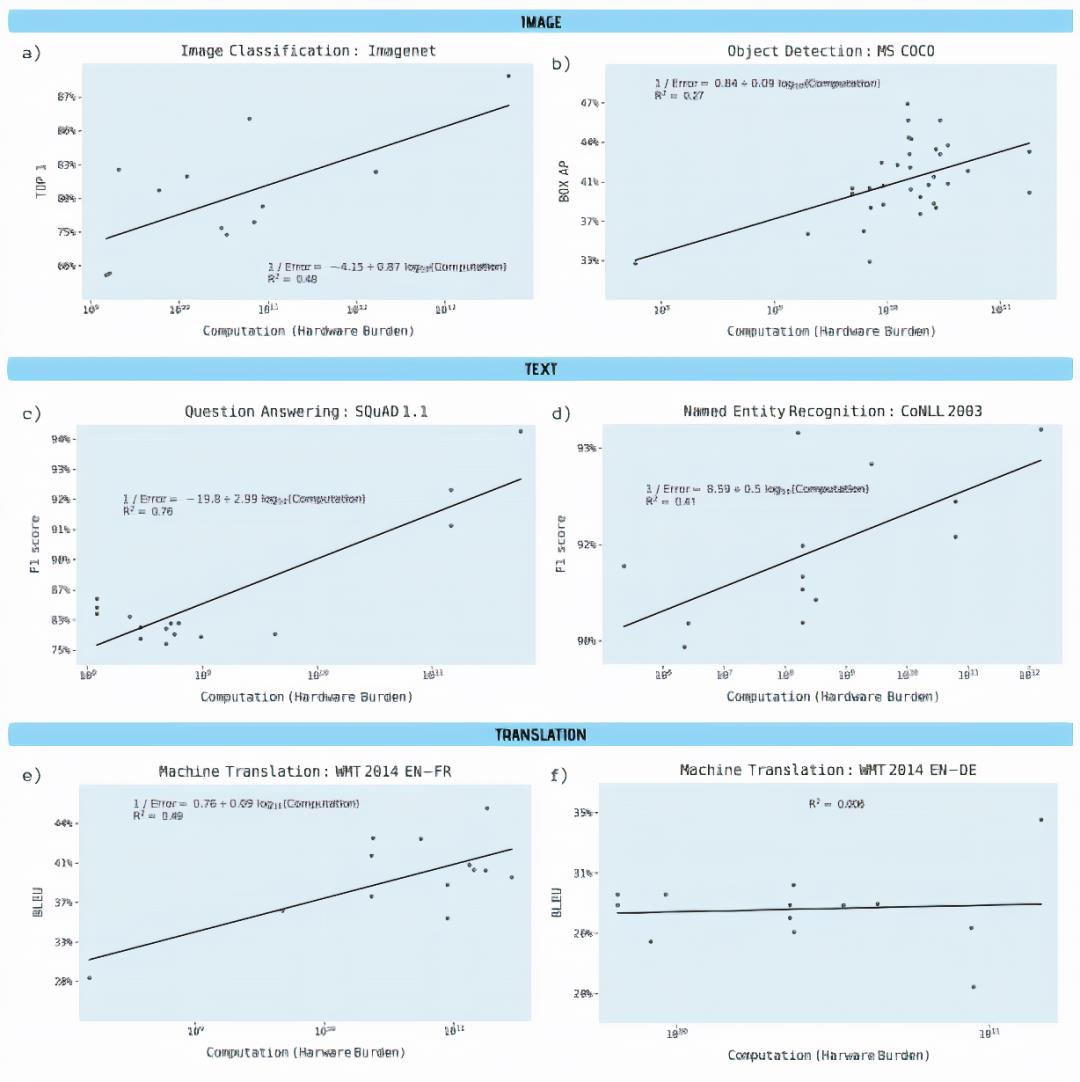

研究人员分析了 1058 篇来自 arXiv 等来源的论文,试图理解深度学习性能和计算之间的联系,尤其是图像分类、目标检测、问答、命名实体识别和机器翻译领域。

研究作者表示,在使用算力几乎相同的情况下,除了英德机器翻译任务以外,在所有基准上都出现了「具备高度统计学意义」的曲线和「强大的解释能力」。

尤其是,目标检测、命名实体识别和机器翻译在输出结果改进相对较小的情况下硬件负载出现大幅增长,算力对模型在 ImageNet 基准数据集上的图像分类准确率承担了 43% 的贡献。

研究人员估计,三年的算法改进等于算力的 10 倍增长。「我们的研究结果表明,在深度学习的多个领域中,训练模型所取得的进展依赖于所用算力的大幅增长。另一种可能性是算法改进本身需要算力的补充。」

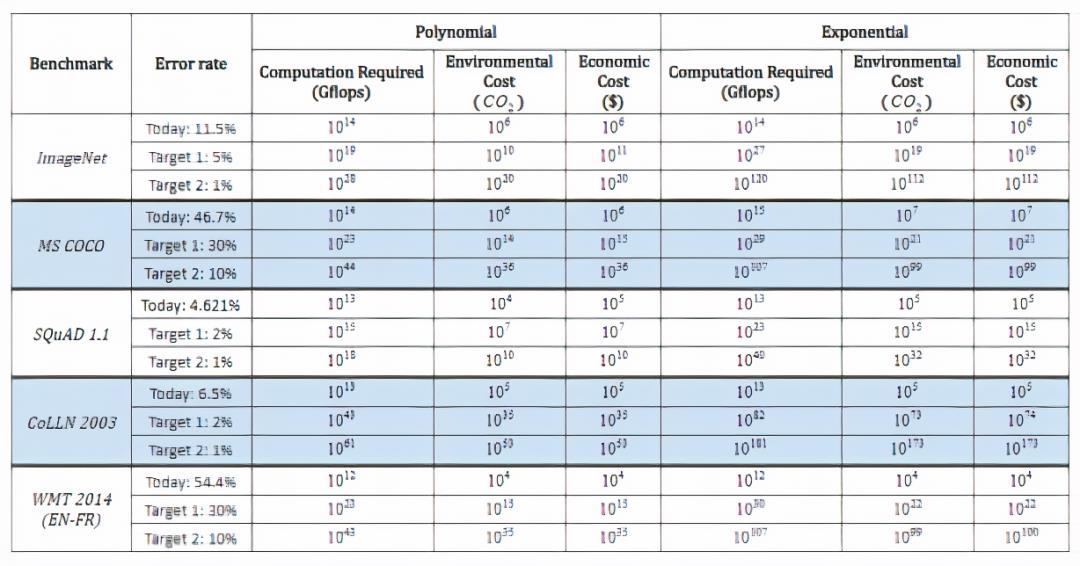

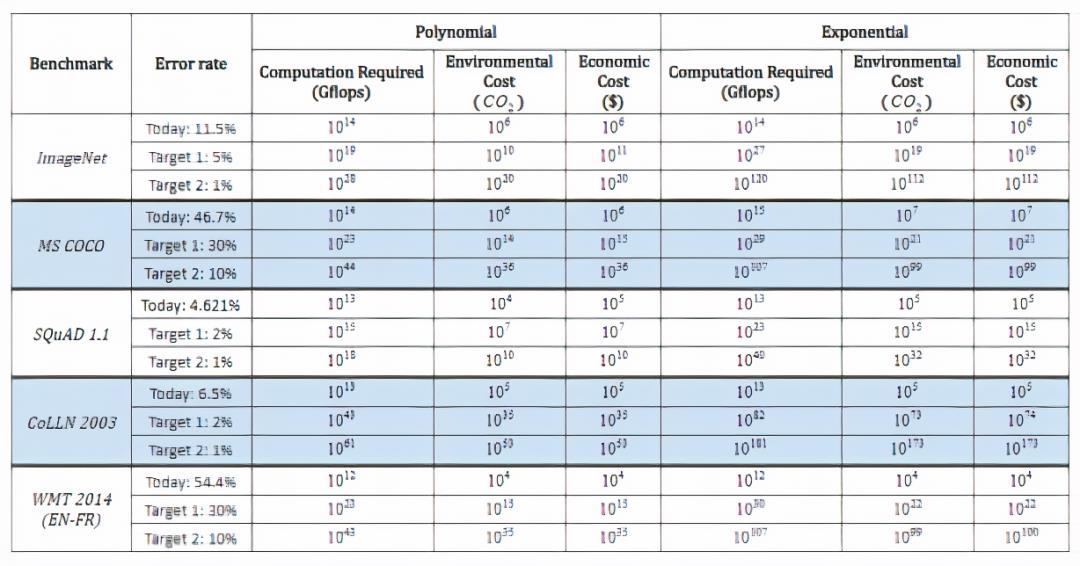

在研究过程中,研究人员还推断了模型在不同理论基准上打破记录所需的算力、经济成本和环境成本。

据最乐观的估计,降低 ImageNet 图像分类误差也需要105 倍的算力增长。

去年六月,机器之心发布的报告估计,华盛顿大学的 Grover 假新闻检测模型训练两周所需成本为 2.5 万美元。前不久发布的 OpenAI GPT-3 模型训练成本飙升到 1200 万美元,谷歌 BERT 的训练成本约为 6,912 美元。

去年六月来自美国马萨诸塞大学阿默斯特分校的研究者发现,训练和搜索特定模型所需算力会排放 62.6 万镑二氧化碳,约等于美国汽车平均一生排放量的五倍。

「我们无法预测这些目标的计算要求…… 硬件、环境成本和金钱成本将会高昂到难以承受。以更经济的方式达成目标需要更加高效的硬件和算法或其他改进。」

研究人员注意到,深度学习在算法层面上的改进有过先例。例如,谷歌 TPU、FPGA 和 ASIC 等硬件加速器的出现,以及通过网络压缩和加速技术降低计算复杂度。

研究人员还引用了神经架构搜索和元学习,它们利用优化找出擅长解决某类问题的架构,进而试图实现计算高效的方法。

OpenAI 的一项研究指出,自 2012 年以来,训练 AI 模型达到 ImageNet 图像分类任务相同性能所需要的算力每 16 个月减少 1/2。此外,谷歌 Transformer 架构超越了先前的 SOTA 模型 seq2seq(也由谷歌开发),它比 seq2seq 推出晚了三年,计算量是后者的 1/64。

研究人员在论文最后写道:「深度学习模型所需算力的爆炸式增长结束了 AI 寒冬,并为更广泛任务上的计算性能制定了新的基准。但是深度学习对于算力的巨大需求限制了以目前形式提升性能的路径,特别是在这样一个硬件性能放缓的时代。」

因此,研究人员认为,算力极限可能促使机器学习转向比深度学习计算效率更高的新技术。

这一话题以及相应论文在 reddit 等社交网站上引发热议,拥趸者有,但质疑声也很多。

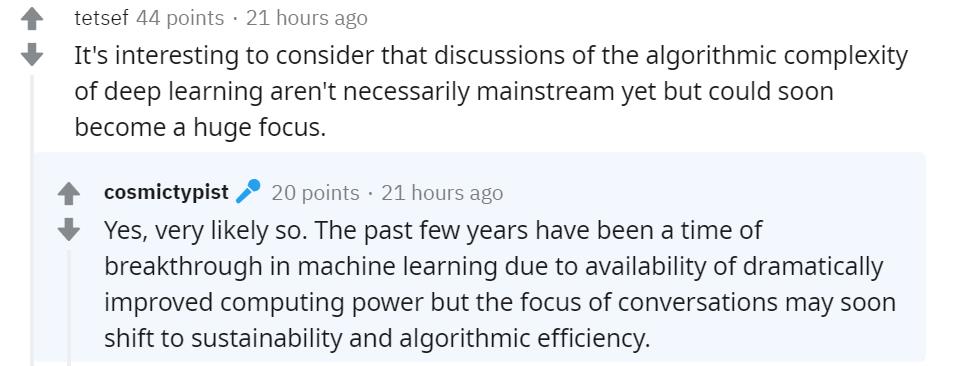

有网友表示,关于深度学习算法复杂性的讨论虽未成为当前主流,但很快会成为焦点话题。发帖者也对这种说法表示认同,并认为过去几年得益于计算能力的显著提升,机器学习领域取得了诸多突破。尽管如此,人们可能会很快关注可持续性和算法效率。

与此同时,更多的网友对研究中的一些细节问题展开了讨论。

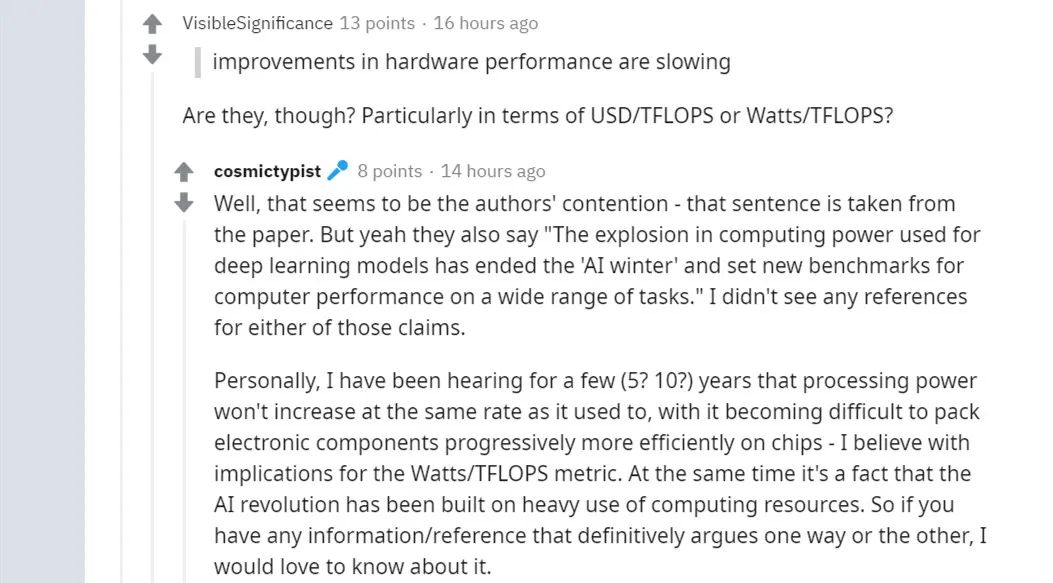

下面这位网友对论文中的「硬件性能的提升正在放缓」这一说法提出了疑问:「事实真的如此吗?特别是从 USD/TFLOPS 和 Watts/TFLOPS 的角度来看。」

发帖者也对这位网友的疑问进行了回复,他表示这似乎是作者的论点。论文作者在文中还写道:「深度学习模型所需算力的爆炸式增长结束了 AI 寒冬,并为更广泛任务上的计算性能制定了新的基准。」但遗憾的是,论文作者的这些说法并没有提供参考文献。

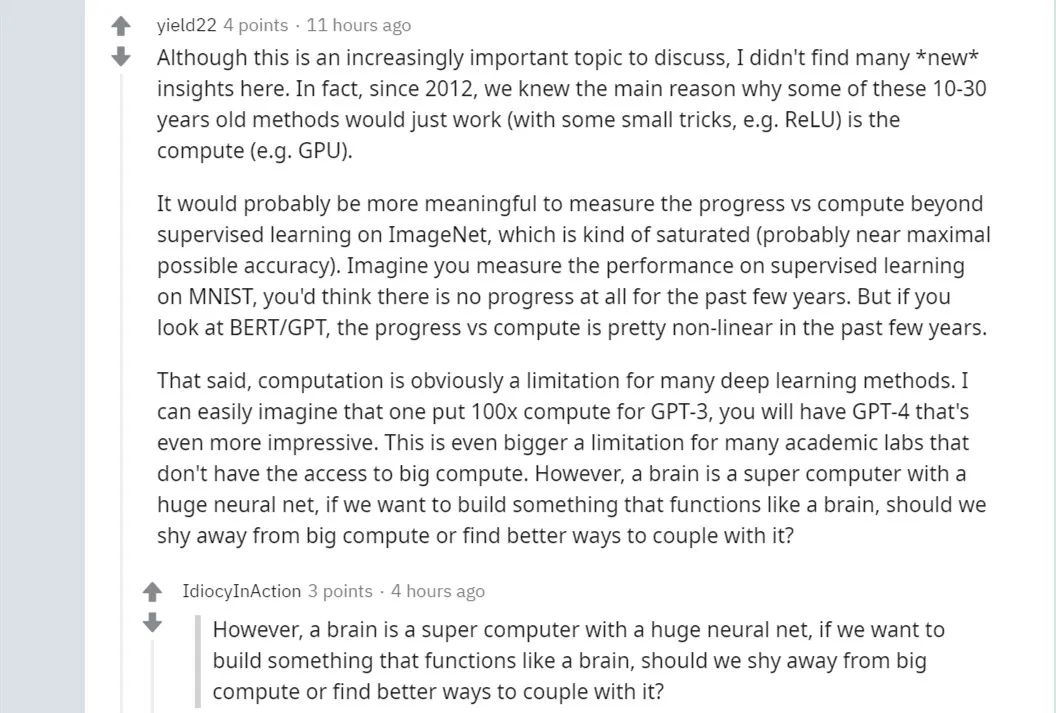

更有网友毫不客气地表示:「虽然这是一个越来越重要的讨论话题,但我并没有从这项研究中看到任何『新』见解。事实上,自 2012 年以来,我们都清楚一些历时 10-30 年之久的旧方法之所以依然能够运行,主要还是得益于算力。」

在他看来,众多深度学习方法面临的计算限制是显而易见的。可以想象到,如果有人将 GPT-3 的计算增加 100 倍,则会得到 GPT-4。现在,很多科研实验室面临着另一个更大的限制,受制于种种客观因素,它们无法获取更大的算力。

最后,有网友认为,无论是从理论基础,还是社会影响等多方面来看,机器学习领域「放缓脚步」不失为一件好事。

https://venturebeat.com/2020/07/15/mit-researchers-warn-that-deep-learning-is-approaching-computational-limits/

https://www.reddit.com/r/MachineLearning/comments/htacsz/the_computational_limits_of_deep_learning/?sort=confidence

7月23日20:00-21:00,小视科技副总裁、AI研究院院长胡建国将带来线上分享,为大家详解这一工业级静默活体检测算法,期待与广大业内开发者和爱好者共同交流。识别海报二维码,添加机器之心小助手,进群一起看直播。

以上是关于MIT警告深度学习正在逼近计算极限,网友:放缓不失为一件好事的主要内容,如果未能解决你的问题,请参考以下文章

MIT韩松团队开发全新微型深度学习技术MCUNet,实现ImageNet超70%准确率,可在物联网设备高效运行

MIT深度学习教程:一文看懂CNNRNN等7种范例(TensorFlow教程)

机器学习中的微分和矩阵

MIT自动驾驶汽车技术研究:基于大规模深度学习的驾驶员行为分析及与自动化的互动

DELM回归预测基于matlab布谷鸟算法改进深度学习极限学习机数据回归预测含Matlab源码 2249期

增量式强化学习