MIT自动驾驶汽车技术研究:基于大规模深度学习的驾驶员行为分析及与自动化的互动

Posted 智车科技

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了MIT自动驾驶汽车技术研究:基于大规模深度学习的驾驶员行为分析及与自动化的互动相关的知识,希望对你有一定的参考价值。

在MIT - AVT研究中,最先进的嵌入式系统编程、软件工程、数据处理、分布式计算、计算机视觉和深度学习技术被应用于大规模自然驾驶数据的收集和分析,旨在为深入了解快速变化的交通系统中人类和自动驾驶车辆是如何进行相互作用的,从而开辟新的领域。这项研究提出了MIT-AVT研究背后的方法论,旨在定义和启发下一代自动驾驶研究。

MIT - AVT 研究者认为,当前现实世界的挑战是人类作为自动驾驶系统各个方面的组成部分。这一挑战之所以特别困难,是因为驾驶任务具有巨大变异性,原因如下:

人类行为的潜在不确定性,表现为车辆、行人和骑自行车者之间的各种社会互动和冲突解决。

驾驶员风格、经验和其他有助于理解、信任和使用自动化的特性之间的可变性。

场景感知和理解问题的复杂性和边缘情况。

从驾驶员与方向盘的互动到轮胎与路面的接触,汽车中的每一个人在与机械系统的交互中,控制问题的欠驱动性质。

传感器中预期的和未预料到的限制和缺陷。

对软件的依赖带来了基于软件系统固有的挑战:bug、漏洞,以及小版本和大版本更新中不断变化的特性集。

当系统故障需要人工控制车辆以解决潜在的危险情况时,人类驾驶员需要识别、确认并做好控制和适应的准备。

环境条件(即天气,光照条件)对低级感知和控制任务以及参与交互的人员之间的高级互动动态产生重大影响。

社会和个人对人为和机器错误的容忍度。

作为人类,我们自然认为,从机器人学的角度来看,成功获得足够的态势感知和理解,需要多少智力,才能在一个充斥着不可预测的非理性人类的世界中航行。道路上的大多数汽车可能需要几十年才能实现完全自动驾驶。在此期间,无论是作为司机还是作为驾驶人工智能系统的主管,人类可能仍然是关键的决策者,。

在这种背景下,以人为中心的人工智能( HCAI )是计算机科学、机器人学和体验设计的一个领域,旨在实现人类和人工智能之间的更深层次整合。很可能HCAI将在技术(算法、传感器、接口和交互范例)的形成中发挥关键作用,这些技术支持驾驶员在监控AI系统中的角色,因为它在任何地方都执行基本驾驶和高阶物体和事件检测任务。

麻省理工学院的自动驾驶车辆技术( MIT - AVT )研究旨在收集和分析大规模半自主驾驶的自然数据,以便更好地描述当前技术使用的状态,了解自动化技术如何影响各种环境中的人机交互,并了解我们如何设计共享自主系统,在未来几十年里,当我们从手动控制过渡到完全自动驾驶时,这些系统可以挽救生命。这项努力的动机是需要更好地描述和理解驾驶员如何使用先进的车辆技术[ 9 ]。目标是提出、设计和构建基于这种理解的系统,这样人类和车辆AI之间的共享自主不会导致一系列意想不到的后果[ 10 ]。

“自然驾驶”是指不受严格实验设计限制的驾驶,而“自然驾驶研究”( NDS )通常是一种系统收集视频、音频、车辆遥测数据和其他传感器数据的研究,这些数据可以长时间捕捉驾驶的各个方面,从几天到几个月甚至几年不等。在这些研究中,数据是在与驾驶员通常“在野外”驾驶的自然条件紧密一致的条件下获取的。“通常情况下,司机自己的车辆装有仪表(尽可能不引人注目),每个司机都被要求像平时一样继续使用他们的车辆,数据就在车辆整个使用期间收集了。此外,使用不受任何结构化实验设计的限制。目的是提供尽可能不受测量过程影响的自然行为记录。这与在类似仪表化车辆中进行的道路试验形成对比,但是试验者在车辆中,并要求驾驶员在特定时间使用车辆中的特定技术系统在特定道路上执行特定任务。

MIT- AVT研究的是新一代的NDS,旨在发现人类驾驶员和自动驾驶技术之间真实互动的情况。目标是从通过该项目收集的大规模自然数据中获得洞察力,以帮助设计、开发和交付新的车辆系统,告知保险提供商不断变化的安全市场,并教育政府和其他非政府利益相关者如何在野外使用自动化。

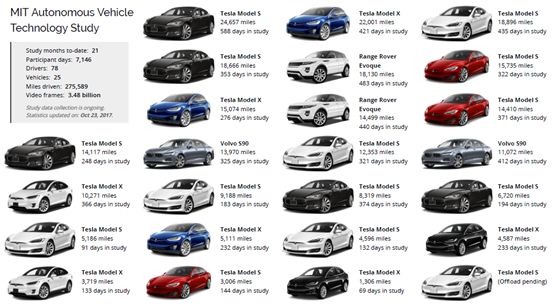

图1 :整个MIT - AVT研究和研究中各个车辆的数据集统计。

图1显示了MIT - AVT研究整体以及研究中各个车辆的关键统计数据。数据的关键措施及其解释如下:

迄今研究月数: 21

(这项研究在道路上与车辆一起积极运行的月数。)

参与日: 7146

(研究中所有车辆上活动数据记录器记录的天数。)

司机: 78人

(本研究中所有车辆上同意驾驶的司机人数。)

车辆:25

(研究中的车辆数量。)

行驶里程:275589

(行驶里程)

视频帧数:35亿

(研究中所有摄像头和车辆记录和处理的视频帧数。)

A.自然驾驶研究

MIT- AVT研究的重点是收集自然驾驶数据,并借鉴先前NDS研究的工作和经验教训,这些先前的研究旨在了解以突然减速为标志的碰撞和近碰撞时刻前后的人类行为。第二个战略性公路研究计划( SHR p2 )是这些研究中最广为人知和规模最大的[ 14 ]。与SHRP - 2和其他第一代NDS努力不同,MIT - AVT研究旨在成为下一代NDS项目的标准,该项目的重点是基于大规模计算机视觉的人类行为分析。正如先前的研究所做的那样,手动标注特定的驾驶时代已经不足以理解自主车辆技术背景下人类行为的复杂性(即驾驶员扫视或驾驶仪使用数千英里的身体位置)。

例如,对理解驾驶员行为很重要的许多度量之一是[18] (见Xi - C )的扫视区域[17]的瞬间检测。为了在不使用计算机视觉的情况下从11亿帧面部视频中准确提取这一指标,需要投资183.3万美元的人工注释[ 19 ]。这个数字假设有一个高效的标注工具,专门为手动浏览区域标注任务设计,可以利用标注任务的分布式、在线、众包。这种工具的开发是一项技术挑战,可能需要几年的持续研究和开发[ 20 ],这可能会超过人类注释时间的成本。另一个例子是驱动场景分割,对于11亿帧来说,这将需要165亿美元的不可思议的投资,[ 21],[ 19 ]。因此,从原始视频中自动或半自动提取信息至关重要,是MIT - AVT的动机、设计、研究和运营的核心。

MIT对待NDS方法的基本信念是,只有通过查看全部数据(具有揭示人类行为和情况特征的算法),我们才能开始学习“放大”哪些部分:哪些触发器和标记将导致分析这些分析代表数据中的系统性能和人类行为。此外,从数据中提取的每一个新见解都可能会完全改变我们对数据中应该查找的位置的理解。出于这个原因,我们相信理解人类和自主交通工具是如何相互作用的,需要比特定事件周围几秒甚至几分钟的时间窗口大得多。

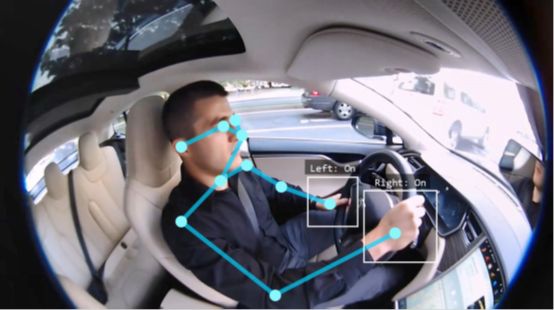

它需要查看整个行程和人类参与自动化的策略:何时、何地、多长时间打开,何时、何地关闭,何时交换控制,以及许多其他问题。处理如此庞大的数据量需要一种完全不同的数据分析方法。我们通过使用基于深度学习的计算机视觉方法来实现知识提取过程的自动化方面,这些方法用于驾驶员状态检测、驾驶员身体姿态估计、驾驶场景分割和来自仪表组视频的车辆状态检测,如图2所示,并在xIV中讨论。使用基于深度学习的自动注释的结果是,MIT - AVT可以分析共享自主环境下驾驶的长尾,这反过来又允许将复杂的观察到的交互与人类对其体验的感知相结合。这种对NDS数据集进行整体分析的创新跨学科方法提供了一个独特的机会来评估在自动驾驶环境下对人机交互的情况理解。

图2 :来自MIT - AVT摄像机的视频帧和为每个摄像机执行的计算机视觉任务的可视化(a)(b)(c)(d):

( a )驾驶员状态下的面部摄像头。

( a )驾驶员状态下的面部摄像头。

( b )用于驾驶员身体位置的驾驶室摄像机。

( c )用于驾驶场景感知的前向摄像机。

( d )用于车辆状态组合仪表摄像机。

B.深度学习应用的数据集

深度学习[27]可以通过两种方式定义:(1)机器学习的一个分支,它使用具有许多层的神经网络;或(2)机器学习的一个分支,旨在形成数据表示的层次结构,而最小的输入来自人类对层次结构的实际构成。后一个定义揭示了深度学习的关键特征,这对我们的工作非常重要,能够使用大规模数据对机器学习的任何野外应用中出现的真实世界边缘情况进行有力的概括:遮挡、光照、视角、尺度、类间变化、类内变化等[28]。

为了利用深度学习的力量从原始视频中提取人类行为,需要大规模注释数据集。然后,在这些数据集上训练的深层神经网络可以用于它们的学习表示,从而可针对驾驶环境中的特定应用进行微调。ImageNet [ 29 ]是基于WordNet [ 30 ]的图像数据集,其中100,000个同义词集各自定义了一个独特的概念。ImageNet的目标是为100,000个合集中的每一个都提供1000个带注释的图像。目前,它有21,841个带有图像的合集,总共有14,197,122个图像。这个数据集通常用于训练神经网络,用于图像分类和物体检测任务[ 31 ]。作为年度ImageNet大规模视觉识别竞赛( ILSVRC ) [32]的一部分,最佳表现的网络被突出显示。在这项工作中,术语“机器学习”、“深度学习”、“神经网络”和“计算机视觉”经常互换使用。这是因为大多数自动化知识提取任务的当前技术水平主要是基于学习的方法,这些方法依赖于深层神经网络体系结构的许多变体之一。在开发用于大规模分析我们数据集中驾驶员行为的算法时使用的其他流行数据集的例子包括:

COCO [ 33 ] : Microsoft Common object in Context ( COCO )数据集是一个大规模数据集,从两个角度解决场景理解中的对象检测任务:检测对象的非图标视图和对象的精确2D定位。第一项任务通常是指对象定位,它使用边界框来表示对象的存在。第二项任务涉及实例分割,为此也需要对象的精确遮罩。整个数据集包含80个对象类别中标记的200,000多幅图像。成功的方法[ 31]、[ 34、[ 35 ]将两项任务联合建模,同时输出对象的边界框和遮罩。

KITTI:KITTI驾驶数据集开发了立体视觉、光流、视觉里程计/ SLAM和3D物体检测的挑战性基准,这些基准是在德国中等城市卡尔斯鲁厄的农村地区和高速公路上驾驶时捕获的。总的来说,使用各种传感器模式,如高分辨率彩色和灰度立体相机、Velodyne 3D激光扫描仪和高精度GPS / IMU惯性导航系统,在10 - 100 Hz下记录了6小时的交通场景。此外,[ 38 ]还通过从原始数据集中收集400个高度动态的场景,并用半密集的场景流地面真实来增强这些场景,为3D场景流估计提出地面真实。

Cityscapes:Cityscapes数据集侧重于对城市街景的语义理解。它提供了大量不同的立体视频序列,这些视频序列记录在来自50个不同城市的街道上,具有像素级和实例级语义标签。有5,000个带有像素级注释的完全分割图像和另外20,000个具有粗略注释的部分分割图像。它的两个基准挑战导致了许多成功的语义分割方法的发展[40],[41]和实例分割[34],[42]。

CamVid:剑桥驾驶标签视频数据库(CamVid)是第一个在驾驶汽车视角下拍摄的视频中具有逐帧语义标签的数据集。数据集提供地面实况标签,将每个像素与32个语义类之一相关联。超过700个图像的手动指定的每像素语义分割使得能够研究诸如行人检测[44]和标签传播[45]之类的主题。

C.深度学习的汽车应用

驾驶领域中的感知和控制系统的设计已经从利用大规模数据收集和注释的基于学习的方法中获益,以便构建概括于现实世界操作的边缘情况的模型。利用发布的大规模注释驾驶数据集[36],[39],汽车深度学习研究旨在解决检测、估计、预测、标记、生成、控制和计划任务。如图2所示,具体任务有已经定义了诸如细粒度人脸识别,身体姿势估计,语义场景感知和驾驶状态预测。目前的努力简要总结如下:

精细人脸识别:除了经典人脸识别研究之外,精细人脸识别侧重于理解人类对人脸感知的行为,如面部表情识别[46]、[47]、眼睛注视检测[48]、[49]。在驾驶环境中,[50],[51]探索司机眼神的预测能力。[ 52 ],[ 53 ]用面部表情来检测驾驶安全和驾驶体验的情绪压力。

人体姿势估计:人体姿势的研究扩展了机器人和动作识别中许多现实世界应用的性能、能力和经验。成功的方法不同于使用深度图像( [54],通过深度神经网络[55],或者卷积网络和图形模型[56]。特别是对于驾驶,[ 57 ]使用驾驶员姿势来模拟人类驾驶行为,该姿势由骨骼数据表示,包括手腕、肘部和肩关节的位置。[ 58 ]对眼睛状态和头部姿势进行视觉分析,以监控驾驶员的警觉性。

语义场景感知:从2D图像中理解场景一直是计算机视觉中一项具有挑战性的任务,通常指的是语义图像分割。通过利用大规模数据集,如[59]、[39]、[40]、[ 41]等,利用强大的深度学习技术获得了最新的结果。因此,学术界和工业界都在积极研究自动驾驶汽车的精确驾驶场景感知[60]、[61]。

驾驶状态预测:车辆状态通常被认为是人类驾驶决策的直接例证,这也是自主驾驶的目标。就机器学习而言,从不同角度来看,它是各种任务的基本真理,如驾驶行为[ 57 ]和转向指令[ 60]、[ 61]。

随着用于这些任务的代表性数据集被发布给广泛的研究团体,驾驶员辅助、驾驶员体验和车辆性能的许多方面正越来越多地通过基于学习的方法实现自动化。MIT-AVT研究旨在成为许多此类数据集的来源,这些数据集有助于训练神经网络体系结构,为半自主和完全自主驾驶的许多模块化和集成子任务提供当前和未来的稳健解决方案。

【参考资料】

[1] A. Davies, “Oh look, more evidence humans shouldn’t be driving,” May 2015. [Online]. Available: https://www.wired.com/2015/05/oh-look-evidence-humans-shouldnt-driving/

[2] T. Vanderbilt and B. Brenner, “Traffic: Why we drive the way we do(and what it says about us) , alfred a. knopf, new york, 2008; 978-0-307-26478-7,” 2009.

[3] W. H. Organization, Global status report on road safety 2015. World Health Organization, 2015.

[4] M. Buehler, K. Iagnemma, and S. Singh, The DARPA urban challenge: autonomous vehicles in city traffic. springer, 2009, vol. 56.

[5] V. V. Dixit, S. Chand, and D. J. Nair, “Autonomous vehicles: disengagements,

accidents and reaction times,” PLoS one, vol. 11, no. 12, p. e0168054, 2016.

[6] F. M. Favar`o, N. Nader, S. O. Eurich, M. Tripp, and N. Varadaraju, “Examining

accident reports involving autonomous vehicles in california,” PLoS one, vol. 12, no. 9, p. e0184952, 2017.

[7] R. Tedrake, “Underactuated robotics: Algorithms for walking, running, swimming, flying, and manipulation (course notes for mit 6.832),” 2016.

[8] M. R. Endsley and E. O. Kiris, “The out-of-the-loop performance problem and level of control in automation,” Human factors, vol. 37, no. 2, pp. 381–394, 1995.

[9] B. Reimer, “Driver assistance systems and the transition to automated vehicles: A path to increase older adult safety and mobility?” Public Policy & Aging Report, vol. 24, no. 1, pp. 27–31, 2014.

[10] K. Barry, “Too much safety could make drivers less safe,” July 2011. [Online]. Available: https://www.wired.com/2011/07/ active-safety-systems-could-create-passive-drivers/

[11] V. L. Neale, T. A. Dingus, S. G. Klauer, J. Sudweeks, and M. Goodman, “An overview of the 100-car naturalistic study and findings,” National Highway Traffic Safety Administration, Paper, no. 05-0400, 2005.

[12] T. A. Dingus, S. G. Klauer, V. L. Neale, A. Petersen, S. E. Lee, J. Sudweeks, M. Perez, J. Hankey, D. Ramsey, S. Gupta et al., “The 100-car naturalistic driving study, phase ii-results of the 100-car field experiment,” Tech. Rep., 2006.

[13] S. G. Klauer, T. A. Dingus, V. L. Neale, J. D. Sudweeks, D. J. Ramsey et al., “The impact of driver inattention on near-crash/crash risk: An analysis using the 100-car naturalistic driving study data,” 2006.

[14] K. L. Campbell, “The shrp 2 naturalistic driving study: Addressing driver performance and behavior in traffic safety,” TR News, no. 282, 2012.

[15] T. Victor, M. Dozza, J. B¨argman, C.-N. Boda, J. Engstr¨om, C. Flannagan, J. D. Lee, and G. Markkula, “Analysis of naturalistic driving study data: Safer glances, driver inattention, and crash risk,” Tech. Rep., 2015.

[16] M. Benmimoun, F. Fahrenkrog, A. Zlocki, and L. Eckstein, “Incident detection based on vehicle can-data within the large scale field operational test (eurofot),” in 22nd Enhanced Safety of Vehicles Conference (ESV 2011), Washington, DC/USA, 2011.

[17] L. Fridman, P. Langhans, J. Lee, and B. Reimer, “Driver gaze region estimation without use of eye movement,” IEEE Intelligent Systems,

vol. 31, no. 3, pp. 49–56, 2016.

[18] L. Fridman, J. Lee, B. Reimer, and T. Victor, “Owl and lizard: patterns of head pose and eye pose in driver gaze classification,” IET Computer Vision, vol. 10, no. 4, pp. 308–313, 2016.

[19] L. Fridman, “Cost of annotation in machine learning, computer vision, and behavioral observation domains,” in Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems, Under Review, 2018.

[20] B. C. Russell, A. Torralba, K. P. Murphy, and W. T. Freeman, “Labelme: a database and web-based tool for image annotation,” International journal of computer vision, vol. 77, no. 1, pp. 157–173, 2008.

[21] M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele, “The cityscapes dataset for semantic urban scene understanding,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016, pp. 3213–3223.

[22] R. R. Knipling, “Naturalistic driving events: No harm, no foul, no validity,” in Driving Assessment 2015: International Symposium on Human Factors in Driver Assessment, Training, and Vehicle Design. Public Policy Center, University of Iowa Iowa City, 2015, pp. 196–202.

[23] ——, “Crash heterogeneity: implications for naturalistic driving studies and for understanding crash risks,” Transportation Research Record: Journal of the Transportation Research Board, no. 2663, pp. 117–125, 2017.

[24] L. Fridman, B. Jenik, and B. Reimer, “Arguing machines:Perceptioncontrol system redundancy and edge case discovery in real-world autonomous driving,” arXiv preprint arXiv:1710.04459, 2017.

[25] V. Shankar, P. Jovanis, J. Aguero-Valverde, and F. Gross, “Analysis

of naturalistic driving data: prospective view on methodological

paradigms,” Transportation Research Record: Journal of the Transportation

Research Board, no. 2061, pp. 1–8, 2008.

[26] N. Kalra and S. M. Paddock, “Driving to safety: How many miles of

driving would it take to demonstrate autonomous vehicle reliability?”

Transportation Research Part A: Policy and Practice, vol. 94, pp. 182–193, 2016.

[27] I. Goodfellow, Y. Bengio, and A. Courville, Deep learning. MIT press,

2016.

[28] R. Hartley and A. Zisserman, Multiple view geometry in computer vision.

Cambridge university press, 2003.

[29] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. Fei-Fei, “Imagenet:

A large-scale hierarchical image database,” in Computer Vision and Pattern Recognition, 2009. CVPR 2009. IEEE Conference on. IEEE, 2009, pp. 248–255.

[30] G. A. Miller, R. Beckwith, C. Fellbaum, D. Gross, and K. J. Miller, “Introduction to wordnet: An on-line lexical database,” International journal of lexicography, vol. 3, no. 4, pp. 235–244, 1990.

[31] K. He, X. Zhang, S. Ren, and J. Sun, “Deep residual learning for image

recognition,” in Proceedings of the IEEE conference on computer vision

and pattern recognition, 2016, pp. 770–778.

[32] O. Russakovsky, J. Deng, H. Su, J. Krause, S. Satheesh, S. Ma,

Z. Huang, A. Karpathy, A. Khosla, M. Bernstein et al., “Imagenet large

scale visual recognition challenge,” International Journal of Computer

Vision, vol. 115, no. 3, pp. 211–252, 2015.

[33] T.-Y. Lin, M. Maire, S. Belongie, J. Hays, P. Perona, D. Ramanan,

P. Doll´ar, and C. L. Zitnick, “Microsoft coco: Common objects in

context,” in European conference on computer vision. Springer, 2014,

pp. 740–755.

[34] K. He, G. Gkioxari, P. Dollar, and R. Girshick, “Mask r-cnn,” in The

IEEE International Conference on Computer Vision (ICCV), Oct 2017.

[35] J. Dai, H. Qi, Y. Xiong, Y. Li, G. Zhang, H. Hu, and Y.Wei, “Deformable

convolutional networks,” in The IEEE International Conference on

Computer Vision (ICCV), Oct 2017.

[36] A. Geiger, P. Lenz, C. Stiller, and R. Urtasun, “Vision meets robotics:

The kitti dataset,” International Journal of Robotics Research (IJRR),2013.

[37] A. Geiger, P. Lenz, and R. Urtasun, “Are we ready for autonomous driving? the kitti vision benchmark suite,” in Conference on Computer Vision and Pattern Recognition (CVPR), 2012.

[38] M. Menze and A. Geiger, “Object scene flow for autonomous vehicles,”

in Conference on Computer Vision and Pattern Recognition (CVPR), 2015.

[39] M. Cordts, M. Omran, S. Ramos, T. Scharw¨achter, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele, “The cityscapes dataset,”2015.

[40] H. Zhao, J. Shi, X. Qi, X. Wang, and J. Jia, “Pyramid scene parsing

network,” in The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 2017.

[41] P. Wang, P. Chen, Y. Yuan, D. Liu, Z. Huang, X. Hou, and G. Cottrell,

“Understanding convolution for semantic segmentation,” arXiv preprint

arXiv:1702.08502, 2017.

[42] S. Liu, J. Jia, S. Fidler, and R. Urtasun, “Sgn: Sequential grouping networks

for instance segmentation,” in The IEEE International Conference

on Computer Vision (ICCV), Oct 2017.

[43] G. J. Brostow, J. Fauqueur, and R. Cipolla, “Semantic object classes

in video: A high-definition ground truth database,” Pattern Recognition

Letters, vol. 30, no. 2, pp. 88–97, 2009.

[44] Y. Tian, P. Luo, X. Wang, and X. Tang, “Pedestrian detection aided by

deep learning semantic tasks,” in Proceedings of the IEEE Conference

on Computer Vision and Pattern Recognition, 2015, pp. 5079–5087.

[45] V. Badrinarayanan, F. Galasso, and R. Cipolla, “Label propagation in

video sequences,” in Computer Vision and Pattern Recognition (CVPR),

2010 IEEE Conference on. IEEE, 2010, pp. 3265–3272.

[46] P. Liu, S. Han, Z. Meng, and Y. Tong, “Facial expression recognition via

a boosted deep belief network,” in Proceedings of the IEEE Conference

on Computer Vision and Pattern Recognition, 2014, pp. 1805–1812.

[47] Z. Yu and C. Zhang, “Image based static facial expression recognition

with multiple deep network learning,” in Proceedings of the 2015 ACM

on International Conference on Multimodal Interaction. ACM, 2015,

pp. 435–442.

[48] E. A. Hoffman and J. V. Haxby, “Distinct representations of eye gaze

and identity in the distributed human neural system for face perception,”

Nature neuroscience, vol. 3, no. 1, pp. 80–84, 2000.

[49] J. Wi´sniewska, M. Rezaei, and R. Klette, “Robust eye gaze estimation,”

in International Conference on Computer Vision and Graphics.

Springer, 2014, pp. 636–644.

[50] L. Fridman, H. Toyoda, S. Seaman, B. Seppelt, L. Angell, J. Lee,

B. Mehler, and B. Reimer, “What can be predicted from six seconds of

driver glances?” in Proceedings of the 2017 CHI Conference on Human

Factors in Computing Systems. ACM, 2017, pp. 2805–2813.

[51] F. Vicente, Z. Huang, X. Xiong, F. De la Torre, W. Zhang, and D. Levi,

“Driver gaze tracking and eyes off the road detection system,” IEEE

Transactions on Intelligent Transportation Systems, vol. 16, no. 4, pp.

2014–2027, 2015.

[52] H. Gao, A. Y¨uce, and J.-P. Thiran, “Detecting emotional stress from

facial expressions for driving safety,” in Image Processing (ICIP), 2014

IEEE International Conference on. IEEE, 2014, pp. 5961–5965.

[53] I. Abdic, L. Fridman, D. McDuff, E. Marchi, B. Reimer, and B. Schuller,

“Driver frustration detection from audio and video in the wild,” in KI

2016: Advances in Artificial Intelligence: 39th Annual German Conference

on AI, Klagenfurt, Austria, September 26-30, 2016, Proceedings,

vol. 9904. Springer, 2016, p. 237.

[54] J. Shotton, T. Sharp, A. Kipman, A. Fitzgibbon, M. Finocchio, A. Blake,

M. Cook, and R. Moore, “Real-time human pose recognition in parts

from single depth images,” Communications of the ACM, vol. 56, no. 1,

pp. 116–124, 2013.

[55] A. Toshev and C. Szegedy, “Deeppose: Human pose estimation via deep

neural networks,” in Proceedings of the IEEE Conference on Computer

Vision and Pattern Recognition, 2014, pp. 1653–1660.

[56] J. J. Tompson, A. Jain, Y. LeCun, and C. Bregler, “Joint training

of a convolutional network and a graphical model for human pose

estimation,” in Advances in neural information processing systems, 2014,

pp. 1799–1807.

[57] D. Sadigh, K. Driggs-Campbell, A. Puggelli, W. Li, V. Shia, R. Bajcsy,

A. L. Sangiovanni-Vincentelli, S. S. Sastry, and S. A. Seshia, “Datadriven

probabilistic modeling and verification of human driver behavior,”

Formal Verification and Modeling in Human-Machine Systems, 2014.

[58] R. O. Mbouna, S. G. Kong, and M.-G. Chun, “Visual analysis of eye

state and head pose for driver alertness monitoring,” IEEE transactions

on intelligent transportation systems, vol. 14, no. 3, pp. 1462–1469,

2013.

[59] B. Zhou, A. Lapedriza, J. Xiao, A. Torralba, and A. Oliva, “Learning

deep features for scene recognition using places database,” in Advances

in neural information processing systems, 2014, pp. 487–495.

[60] H. Xu, Y. Gao, F. Yu, and T. Darrell, “End-to-end learning of driving

models from large-scale video datasets,” in The IEEE Conference on

Computer Vision and Pattern Recognition (CVPR), July 2017.

[61] M. Bojarski, D. Del Testa, D. Dworakowski, B. Firner, B. Flepp,

P. Goyal, L. D. Jackel, M. Monfort, U. Muller, J. Zhang et al., “End

to end learning for self-driving cars,” arXiv preprint arXiv:1604.07316,

2016.

推荐阅读

▼

▎本文为智车科技(IV_Technology)D编译,转载请注明来源。

以上是关于MIT自动驾驶汽车技术研究:基于大规模深度学习的驾驶员行为分析及与自动化的互动的主要内容,如果未能解决你的问题,请参考以下文章