何恺明上榜CVPR 2021获奖名单,4篇「最佳」是华人一作

Posted QbitAl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了何恺明上榜CVPR 2021获奖名单,4篇「最佳」是华人一作相关的知识,希望对你有一定的参考价值。

晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

CVPR 2021本周正式召开啦,作为计算机视觉领域最重要的学术会议,大会的最佳论文自然是领域学者们关注的重要风向标。

就在上周,CVPR官方公布了入围的32篇最佳论文候选名单,其中华人一作占据了16篇,国内北大、腾讯、商汤等学校机构上榜。

那么最终哪些论文摘得荣誉呢?今天凌晨,也就是大会首日,官方公布了结果:

其中最佳论文奖和最佳学生论文奖1篇,最佳学生论文提名3篇,最佳论文提名2篇。

在这7篇文章里,有4篇是华人一作,我们还看到了熟悉的大神何恺明的名字。

7篇获奖论文

最佳论文奖

GIRAFFE: Representing Scenes as Compositional Generative Neural Feature Fields

这篇论文来自德国蒂宾根大学的两位学者。

摘要:

这篇文章提出,将复合三维场景表示纳入生成模型,会导致更可控的图像合成。将场景表示为复合生成神经特征场,能使我们能够从背景中解开一个或多个对象以及单个对象的形状和外观,同时从非结构化和非定位的图像集合中学习,而无需任何额外的监督。

本文将这种场景表示与神经渲染pipeline相结合,可以生成快速逼真的图像合成模型。实验所证明的,该模型能够解开单个物体,并允许在场景中平移和旋转它们,并改变相机视角。

论文地址:

https://arxiv.org/abs/2011.12100

源代码:

https://github.com/autonomousvision/giraffe

最佳论文提名

今年何恺明获得了最佳论文提名,这篇论文就是:

Exploring Simple Siamese Representation Learning

摘要:

在本文中,作者发现,Simple Siamese网络即使不使用以下任何一种方式,也可以学习有意义的表示:(i)负样本对,(ii)大batch,(iii)动量编码器。

实验表明,坍塌解决方案确实存在于损失和结构上,但停止梯度操作在防止崩塌方面发挥着至关重要的作用。作者给出了停止梯度含义的假设,并进一步展示了验证它的概念验证实验。

“SimSiam”方法在ImageNet和下游任务上取得了有竞争力的结果。作者希望这个简单的baseline将激励人们重新思考SimSiam架构在无监督表示学习中的作用。

另外,何恺明表示,不久后将提供论文代码。

本文的第一作者是Xinlei Chen,本科毕业于浙江大学,之后在卡内基梅隆大学获得博士学位,现在与何恺明一样同在Facebook AI研究院工作。

论文地址:

https://arxiv.org/abs/2011.10566

源代码:

https://github.com/facebookresearch/simsiam

另一篇获得提名的是来自明尼苏达大学的两位学者。

Learning High Fidelity Depths of Dressed Humans by Watching Social Media Dance Videos

摘要:

学习穿戴人体几何的一个关键挑战在于,ground truth数据的可用性有限,这导致3D人体重建在应用于现实世界图像时的性能下降。

本文通过利用新的数据资源来应对这一挑战:一些社交媒体舞蹈视频,这些视频跨越了不同的外观、服装风格、表演和身份。每段视频都描绘了一个人身体和衣服的动态运动,同时缺乏3D ground truth几何。

为了利用这些视频,作者提出了一种使用局部变换的新方法,将人预测的局部几何形状从图像扭曲到另一个图像的局部几何。这种方法是端到端可训练的,从而产生高保真深度估计,预测忠实于输入真实图像的精细几何形状。实验证明,该方法在真实和渲染图像上都优于最先进的人类深度估计和人类形状恢复方法。

论文地址:

https://arxiv.org/abs/2103.03319

最佳学生论文奖

Task Programming: Learning Data Efficient Behavior Representations

作者来自加州理工和西北大学。

摘要:

要进行专业领域知识的深入分析,通常是准确注释训练集是必需的,但从领域专家那里获得这些既繁琐又耗时。这个问题在自动行为分析中非常突出。

为了减少注释工作量,本文提出了TREBA:一种基于多任务自监督学习的注释-行为分析样本高效轨迹嵌入方法。该方法中的任务可以由领域专家通过“任务编程”的过程高效地进行工程化。通过交换数据注释时间来构建少量编程任务,可以减少领域专家的总工作量。

本文在两个领域的三个数据集中给出了实验结果指出,该方法减少了多达10倍的注释负担,而不影响与SOTA方法相比的准确性。

值得一提的是,论文第一作者Jennifer J. Sun目前就读于加州理工学院,本科就读于多伦多大学,GPA是4.0。

论文地址:

https://arxiv.org/abs/2011.13917

源代码:

https://github.com/neuroethology/TREBA

最佳学生论文提名

Less is More: CLIPBERT for Video-and-Language Learning via Sparse Sampling

论文来自北卡大学教堂山分校。

这篇文章主要研究了视频问答(VQA)问题。

作者提出了一个通用框架ClipBERT,通过使用稀疏的采样,在每个训练步骤中只使用一个或几个视频中稀疏的采样短片,从而为视频和语言任务提供负担得起的端到端学习。

论文地址:

https://arxiv.org/abs/2102.06183

源代码:

https://github.com/jayleicn/ClipBERT

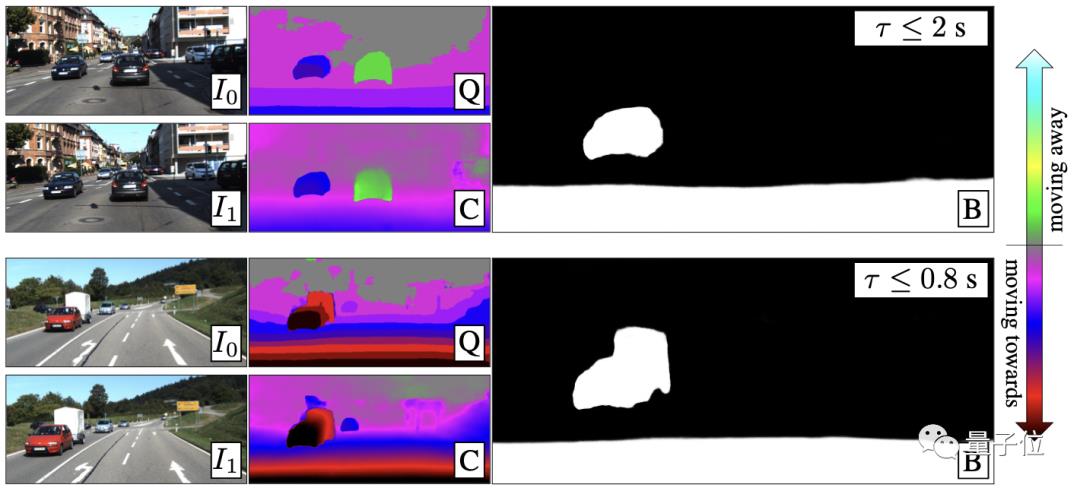

Binary TTC: A Temporal Geofence for Autonomous Navigation

论文来自英伟达和加州大学圣芭芭拉分校。

本文研究的问题与自动驾驶技术有关,即接触时间(TTC),这是物体与观察者平面碰撞的时间,是路径规划的有力工具,它可能比场景中物体的深度、速度和加速度提供信息更多。

TTC有几个优点,包括只需要一台单目、未校准的相机。然而,每个像素的回归TTC并不简单,大多数现有方法对场景进行了过度简化的假设。本文通过一系列更简单的二元分类来估计TTC来应对这一挑战。这是第一个能够以足够高的帧速率提供TTC信息的方法。

论文地址:

https://arxiv.org/abs/2101.04777

Real-Time High-Resolution Background Matting

论文来自华盛顿大学。

这篇文章提出了一种实时高分辨率替换视频背景的方法,能够在4K分辨率下以30fps运行。

主要挑战是计算高质量的阿尔法哑光,保留头发级别的细节,同时实时处理高分辨率图像。为了实现这一目标,作者使用两个神经网络;一个基网络计算低分辨率的结果,该结果再通过第二个在选择性补丁上以高分辨率运行的网络来改进。

与之前方法相比,该方法可以产生更高的质量结果,同时在速度和分辨率方面都显著提高。

该项目代码在GitHub上已经收获3.7k星。

论文地址:

https://arxiv.org/abs/2012.07810

源代码:

https://github.com/PeterL1n/BackgroundMattingV2

PAMITC奖

除了最佳论文相关奖项外,今年大会还颁发了PAMITC奖,包括Longuet-Higgins奖、年轻研究者奖以及首届Thomas Huang纪念奖。

获得Longuet-Higgins奖的两篇论文分别是:

《Real-time human pose recognition in parts from single depth image》

《Baby talk: Understanding and generating simple image descriptions》

获得年轻研究者奖的是来自FAIR的Georgia Gkioxari和来自MIT的Phillip Isola。

去年计算机视觉领域先驱学者黄煦涛去世,为了纪念他,CVPR决定从今年开始颁发Thomas Huang纪念奖。

第一届Thomas Huang纪念奖的获奖者是MIT计算机教授Antonio Torralba,今年他共有4篇论文入选CVPR。

本届CVPR简介

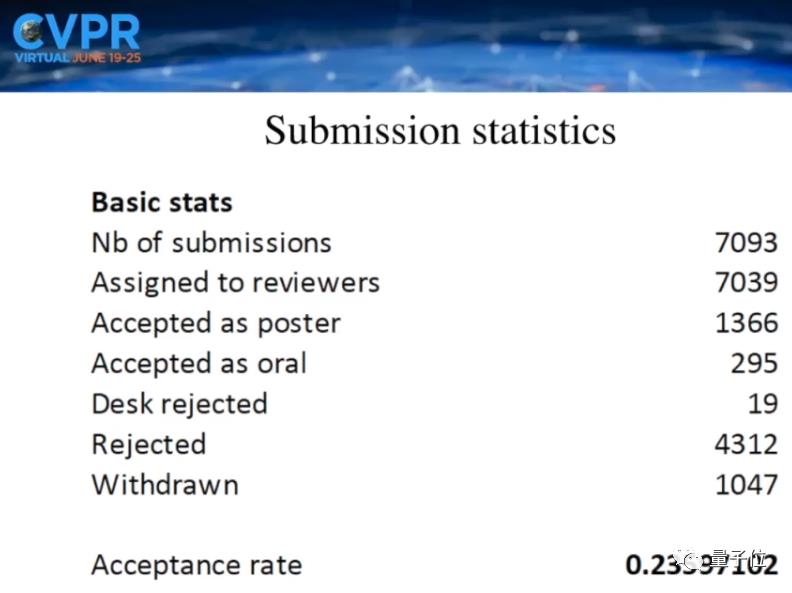

由于受新冠疫情影响,今年的CVPR仍在线上以虚拟会议形式举行。

今年CVPR共有7039篇有效投稿,接收论文1661篇。

在CVPR召开之际,各大科技公司也陆续晒出了自己成绩单,谷歌发布超过70篇,Facebook发布了52篇。

国内科技公司近年来在CVPR上发表的论文也与国外巨头看齐,如商汤发表66篇、华为诺亚方舟实验室发表30篇,旷视发表22篇,腾讯优图发表20篇,快手发表14篇。

当然,本届CVPR相关的workshop和turotial等活动还在进行,感兴趣的读者可访问下方链接持续关注~

参考链接:

http://cvpr2021.thecvf.com/node/141

http://cvpr2021.thecvf.com/node/329

以上是关于何恺明上榜CVPR 2021获奖名单,4篇「最佳」是华人一作的主要内容,如果未能解决你的问题,请参考以下文章

CVPR 2021大奖公布!何恺明获最佳论文提名,代码已开源!

何恺明时隔2年再发一作论文:为视觉大模型开路,“CVPR 2022最佳论文候选预定”...

Rethinking场景分析中的空间池化 | Strip Pooling(CVPR2020,何恺明)