数据中心硬件架构拆解分析

Posted Hardy晗狄

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了数据中心硬件架构拆解分析相关的知识,希望对你有一定的参考价值。

内容来自:全栈云技术架构,《IDC系列报告全集》 下载链接:IDC系列报告全集

IDC系列报告一:数字产业基石,关注核心IDC企业

IDC系列报告二:还原IDC行业的真实盈利能力

IDC系列报告三:数据中心中各类IT硬件占比拆分

IDC系列报告四:公募REITs政策助力,IDC如虎添翼

IDC系列报告五:流量巨头共舞,尽享景气红利

IDC系列报告六:从DCF看IDC行业的价值

本文参考<IDC系列报告三:数据中心中各类 IT硬件占比拆分>,叶脊架构更加适应超大型数据中心发展趋势,并拉动高速光模块及网络设备不断升级。

1)叶脊架构最早 Facebook 提出,由于其更加适应全球超大型数据中心发展趋势,现在广泛应用于全球各大数据中心。

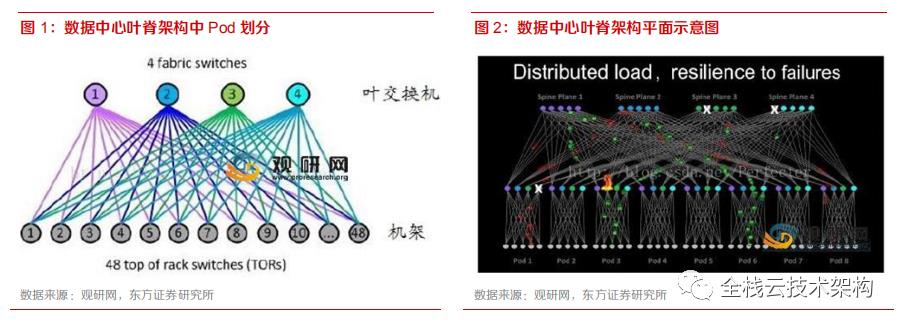

2)叶脊架构可以划分为机柜层、Leaf 层和 Spine 层,所用 IT 设备分别为,机柜层(服务器、ToR 交换机、光模块);Leaf 层(Leaf 交换机、光模块);Spine 层:(Spine交换机、光模块)。

3)叶脊架构主要以 Server 到 Server 之间互联流量为主,为了实现内部互联,如机柜间互联以及 Leaf-Spine 互联的短距高速高模块需求大幅增加。而 Server 到 Spine 交换机流量压力得到很大缓解,数据中心设计往往向上也呈现一定的收敛比。与此同时,交换机也伴随升级:端口数量越来越多,芯片转发速率越来越高。

1、初识叶脊架构

Facebook 于 2014 年提出一种新兴的网络架构,即叶脊架构(Spine-Leaf)。叶脊架构较传统网络架构相比,数据交换和吞吐能力更强,网络也更加扁平化和密集。目前已经成为全球的云计算/互联网公司,包括国内的阿里腾讯等,数据中心的主流部署方式。

为了更加清晰的拆分云计算企业的CAPEX 结构,首先我们需要了解叶脊架构的构成。以 Facebook 数据中心为例,自下而上可以划分为:机柜层、Leaf 层、Spine 层。

机柜层:机柜层是整个网络拓扑架构中最底层的结构,用于放置服务器,通常来说单机柜可以放置 20-24 台标准服务器。机柜内部的服务器互联通过机柜顶层的交换机,该交换机也被称为 ToR(Top of Rack)交换机。实际上 TOR 交换机既可以部署在机柜顶部,也可以部署在机柜的中部 (Middle of Rack)或底部 (Bottom of Rack)。通常而言,将交换机部署在机柜顶部是最有利于走线的,因此这种架构应用最多。

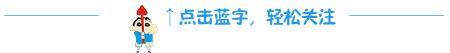

Leaf层:Leaf 层是网络架构中承上启下的一层,主要由叶交换机组成。叶交换机向下与 ToR交换机相连,向上与脊交换机相连。每台叶交换机则向下连接 48 台 ToR 交换机,这样通过叶交换机便实现了机柜之间的互联。48 台 ToR 交换机与 4 台叶交换机对应划分出的结构也被称为 Server Pods。数据中心在部署时根据需求,划分为 N 个 Server Pods, N 的数量可以从几十到几百。边缘的 Pod 又被称为 Edge 平面,负责出口流量,实现数据中心之间的互联。

Spine层:Spine 层是整个数据中心拓扑网络的顶层。为了实现全网的连通性,Facebook 设计了四个独立的骨干交换机平面(Spine plane),每个平面可以根据需求扩展脊交换机,而每个 Pod 的每一台叶交换机都会与所在平面的每一台脊交换机互联。

按照 Facebook 最初提出的叶脊架构进行估算,整个数据中心共可以容纳的服务器总数量为24*48*N 台服务器网络的彼此互联。通过设计更多的 Server Pods,则单个数据中心可以实现高达几十万台的服务器的容量。

2、叶脊架构带来 IT设备变化

叶脊架构拉动高端光模块需求。随着全球数据流量爆发式增长,建设大型的数据中心较传统的小数据中心具有显著的成本优势,为适应数据中心规模的扩大以及提升流量传输效率,原有的三层网络架构与数据中心的发展格格不入,性能出现瓶颈,在此背景下叶脊架构诞生了。

叶脊架构下,每层网络结构所用 IT 设备如下图所示:

机柜层:服务器、ToR 交换机、光模块;

Leaf 层:Leaf 交换机、光模块;

Spine 层:Spine 交换机、光模块;

叶脊架构以东西向(East-West)流量为主,如机柜间互联以及 Leaf-Spine 互联的短距高速高模块需求大幅增加,当前北美应用最为广泛的为 100G 光模块,并且随着数据流量的增加 100G 光模块正在向 400G 升级。而南北向流量压力得到很大缓解,数据中心设计往往向上也呈现一定的收敛比,南北向光模块如 ToR-Leaf 互联光模块和 Leaf-Spine 互联光模块速率并不会显著升级。与此同时,交换机也伴随升级:端口数量越来越多,芯片转发速率越来越高。

3、IT设备用量的详细拆解

以下,我们将按照前一小节所阐述的叶脊架构,对数据中心内部服务器、交换机、光模块等几类 IT基础产品的用量进行详细拆解。核心假设:

1. 高功耗单机柜满载 24 台服务器;

2. ToR 交换机上下行端口比例为 1:6;

3. Leaf 交换机上下行端口比例为 1:6;

4. Spine 交换机不考虑上行,不考虑数据中心之间互联的 Edge 交换机

5. 目前海外主流光模块方案,服务器互联采用 25G 光模块,ToR 与 Leaf 交换机、Leaf 与 Spine交换机采用 100G 光模块。

机柜层:服务器和交换机用量较为清晰,单机柜设计的服务器数量为 24 台,机柜顶放置 1 台 ToR 交换机。交换机分为下行接口和上行接口。下行即连接下层的服务器,上行即连接上层的叶交换机,中间通过两端带有光模块的 MTP/MPO 光纤连接器进行连接。光模块用量按照如下测算:

下行的测算:24(24 台服务器,一台服务器连一个光模块)+ 24(ToR 交换机 24 个下行接口)= 48 个,一般采用为 25G 连接。上行的测算:一台 ToR 交换机一般 4 个上行接口(连接 4 个叶交换机),上行接口速率为100G。

小结:按照单机柜折算,即需要 24 台服务器,1 台 ToR 交换机,48 个 25G 光模块,4 个 100G高速光模块。

Leaf层:不含服务器,只计算交换机与光模块用量。交换机用量较为清晰,一个 Pod(48 个机柜)对应 4 台叶交换机。光模块用量按照如下测算:下行的测算:

对应于 ToR 交换机的上行,一台叶交换机有 48 个下行速率为 100G 的端口,即需要 48 个 100G 的光模块。上行的测算:考虑到在 Leaf 层南北向流量较少,可以按照 1:6 的收敛比进行设计,即 8 个上行接口,Spine 平面设计 8 台脊交换机。因此单台叶交换机最多对应 6 个 100G 光模块。

小结:按照单机柜折算,即需要 4/48=0.08 台叶交换机,(48+8)*(4/48)=4.7 个 100G 高速光模块。

Spine层:按照 4 个 Spine 平面,每个平面扩展 8 个脊交换机,脊交换机总用量为 32 台;按照 64 个 Pod 平面估算,每个 Pod 平面对应 0.5 台脊交换机。光模块用量的估算,每台脊交换机下行与每个 Pod 所在平面的叶交换机相连,则要求脊交换机要有 64 个下行端口,每台脊交换机对应高速光模块用量 64 个。

小结:按照单机柜折算,即需要 0.5/48=0.01 台脊交换机,64*(0.5/48)=0.67 个 100G 高速光模块。

将以上汇总后,合计单机柜对应服务器 24 台、1 台 ToR 交换机,1/12 台叶交换机,1/96 台脊交换机、48 个 25G,28/3 个 100G 更高速光模块,具体用量如下表所示:

4、IT设备价值量的拆算

云计算基础设施各细分领域,IDC:服务器:网络设备:光模块大约为 15:72:3.3:2.6(对应16%:77%:4%:3%)的关系。对于超大型云计算数据中心,交换机所需要的型号更加高端,价值量更高。注意的是,该测算未包括光纤光缆、跨洋光缆等测算。因此平均来说,单机柜的资本开支可能更大。

但总体来说,几类常见 IT 设备间的配比关系,相对正确。按照如前一小节的拆解,单机柜的投资金额可以划分为如下几个部分:

IDC及机柜 CAPEX:根据项目以及建设地理位置不同,单机柜投资金额在 12-18 万之间,按照平均 15 万进行估算,其中投资包含了土地、建筑、机柜、温控系统、供电系统(柴发、蓄电池)等等。该项投资一般情况由 IDC 企业支出,特殊情况下如阿里定制化模式,土地支出及所有权不属于 IDC 企业。定制化模式下单机柜的投资成本可能更低。

服务器:目前标准的机柜通常按照满载 24 台服务器设计,实际根据客户需求不一定按照 24台满载运行。在此估算中暂且按照 24 台满载进行估算。

交换机:ToR 交换机通常为 24 口,价格约在 2 万元左右;Leaf 交换机和 Spine 交换机会根据支持端口速率或数量的不同,价格有较为明显的差异。以某一线品牌 Leaf 交换机(48 个 10G 下行接口,6 个 100G 上行接口)为例,软硬件报价约在 4 万元左右;某一线品牌 Spine交换机(18 个 100G 下行接口)为例,软硬报价约在 30 万左右。一般来说,数据中心规模越大,要求使用的 Leaf 和 Spine 交换机的端口速率和数量越多。超大规模的数据中心使用的 Spine 交换机价格甚至在成百上千万元/台。在此 64 端口的脊交换机我们按照 100 万元进行估算。

光模块:目前数据中心主流采用 25G 端口服务器,因此服务器上行以及 ToR 交换机下行之间的端口连接采用 25G 光模块;而 ToR 交换机上行、Leaf 交换机以及 Spine 交换机采用100G 光模块,甚至升级为更高速率光模块。从通信板块的投资弹性来说:

光模块:下游应用场景中数据中心光模块价值占比量高,且受益于产品升级迭代的量价齐升;

IDC:存量机柜贡献稳定利润,增量机柜体现利润增速(增量机柜只有量的弹性);

网络设备:下游应用场景中数据中心占比较小,企业级应用较高。因此云计算基础设施领域投资弹性排序为:服务器,光模块>IDC>网络设备。

来源:全栈云技术架构

下载链接:IDC系列报告全集

转载申明:转载本号文章请注明作者和来源,本号发布文章若存在版权等问题,请留言联系处理,谢谢。

推荐阅读

更多架构相关技术知识总结请参考“架构师全店铺技术资料打包”相关电子书(37本技术资料打包汇总详情可通过“阅读原文”获取)。

全店内容持续更新,现下单“全店铺技术资料打包(全)”,后续可享全店内容更新“免费”赠阅,价格仅收198元(原总价350元)。

温馨提示:

扫描二维码关注公众号,点击阅读原文链接获取“架构师技术全店资料打包汇总(全)”电子书资料详情。

以上是关于数据中心硬件架构拆解分析的主要内容,如果未能解决你的问题,请参考以下文章