论文泛读95一石二鸟:窃取模型并从基于BERT的API推断属性

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读95一石二鸟:窃取模型并从基于BERT的API推断属性相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

论文链接:《Killing Two Birds with One Stone: Stealing Model and Inferring Attribute from BERT-based APIs》

一、摘要

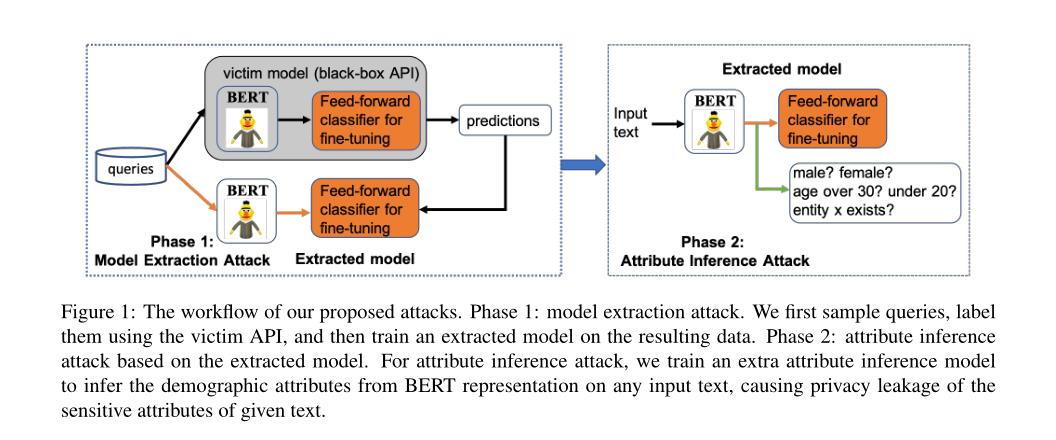

预训练模型(例如BERT,XLNET等)的进步在很大程度上改变了各种现代自然语言处理任务的预测性能。这使公司可以通过将基于BERT的微调模型封装为商业API来提供机器学习即服务(MLaaS)。但是,先前的工作发现了基于BERT的API中的一系列漏洞。例如,基于BERT的API容易受到模型提取攻击和对抗性示例可移植性攻击的攻击。然而,由于基于BERT的API的高容量,微调的模型很容易被过度学习,从提取的模型中泄漏出什么样的信息仍然是未知的和缺乏的。为了弥合这一差距,在这项工作中,我们首先提出一种有效的模型提取攻击,在这种情况下,攻击者实际上只需查询有限数量的查询就可以窃取基于BERT的API(目标/受害者模型)。我们进一步开发了一种有效的属性推理攻击,以暴露基于BERT的API使用的训练数据的敏感属性。我们在各种实际设置下对基准数据集进行的广泛实验证明了基于BERT的API的潜在漏洞。

二、结论

这项工作不仅仅是从基于BERT的应用程序接口中提取模型,我们还发现,即使在困难的情况下(例如,有限的查询预算;来自不同于受害者应用程序接口的训练数据的分布的查询;当受害者模型的架构未知时,等等)。基于典型的自然语言处理数据集和不同环境下的任务的大量实验证明了我们对基于BERT的应用程序接口攻击的有效性。我们希望我们的调查能够提供新的见解,并提高社区对构建更值得信赖的基于BERT的APIs的认识。许多进一步工作的途径都很有吸引力。更广泛地说,我们希望将我们的工作扩展到更复杂的NLP任务,并开发能够同时确保隐私、鲁棒性和准确性的防御措施。

三、model

模型:

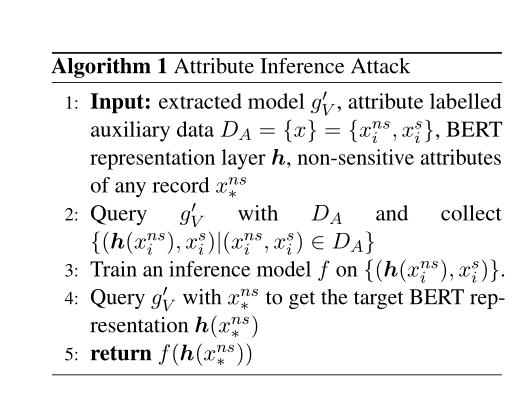

算法:

好吧…我是被标题吸引进来的,这个文章不咋感兴趣…这个标题党,他的目的达到了

以上是关于论文泛读95一石二鸟:窃取模型并从基于BERT的API推断属性的主要内容,如果未能解决你的问题,请参考以下文章

论文泛读167使用 BERT 语言模型的大规模新闻分类:Spark NLP 方法

论文泛读167使用 BERT 语言模型的大规模新闻分类:Spark NLP 方法