机器学习k近邻算法鸢尾花种类预测

Posted 赵广陆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习k近邻算法鸢尾花种类预测相关的知识,希望对你有一定的参考价值。

目录

1 再识K-近邻算法API

- sklearn.neighbors.KNeighborsClassifier(n_neighbors=5,algorithm=‘auto’)

- n_neighbors:

- int,可选(默认= 5),k_neighbors查询默认使用的邻居数

- algorithm:‘auto’,‘ball_tree’,‘kd_tree’,‘brute’

- 快速k近邻搜索算法,默认参数为auto,可以理解为算法自己决定合适的搜索算法。除此之外,用户也可以自己指定搜索算法ball_tree、kd_tree、brute方法进行搜索,

- brute是蛮力搜索,也就是线性扫描,当训练集很大时,计算非常耗时。

- kd_tree,构造kd树存储数据以便对其进行快速检索的树形数据结构,kd树也就是数据结构中的二叉树。以中值切分构造的树,每个结点是一个超矩形,在维数小于20时效率高。

- ball tree是为了克服kd树高维失效而发明的,其构造过程是以质心C和半径r分割样本空间,每个节点是一个超球体。

- 快速k近邻搜索算法,默认参数为auto,可以理解为算法自己决定合适的搜索算法。除此之外,用户也可以自己指定搜索算法ball_tree、kd_tree、brute方法进行搜索,

- n_neighbors:

2 案例:鸢尾花种类预测

2.1 数据集介绍

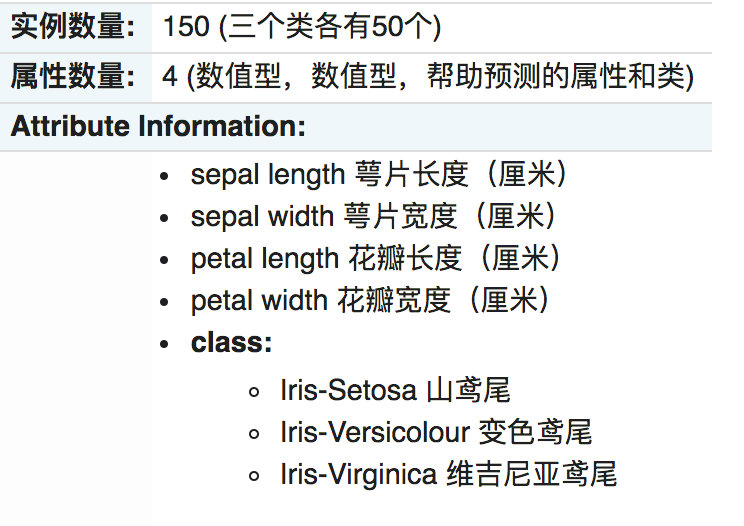

Iris数据集是常用的分类实验数据集,由Fisher, 1936收集整理。Iris也称鸢尾花卉数据集,是一类多重变量分析的数据集。关于数据集的具体介绍:

2.2 步骤分析

- 1.获取数据集

- 2.数据基本处理

- 3.特征工程

- 4.机器学习(模型训练)

- 5.模型评估

2.3 代码过程

- 导入模块

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.neighbors import KNeighborsClassifier

- 先从sklearn当中获取数据集,然后进行数据集的分割

# 1.获取数据集

iris = load_iris()

# 2.数据基本处理

# x_train,x_test,y_train,y_test为训练集特征值、测试集特征值、训练集目标值、测试集目标值

x_train, x_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size=0.2, random_state=22)

- 进行数据标准化 – 特征值的标准化

# 3、特征工程:标准化

transfer = StandardScaler()

x_train = transfer.fit_transform(x_train)

x_test = transfer.transform(x_test)

- 模型进行训练预测

# 4、机器学习(模型训练)

estimator = KNeighborsClassifier(n_neighbors=9)

estimator.fit(x_train, y_train)

# 5、模型评估

# 方法1:比对真实值和预测值

y_predict = estimator.predict(x_test)

print("预测结果为:\\n", y_predict)

print("比对真实值和预测值:\\n", y_predict == y_test)

# 方法2:直接计算准确率

score = estimator.score(x_test, y_test)

print("准确率为:\\n", score)

3 案例小结

在本案例中,具体完成内容有:

- 使用可视化加载和探索数据,以确定特征是否能将不同类别分开。

- 通过标准化数字特征并随机抽样到训练集和测试集来准备数据。

- 通过统计学,精确度度量进行构建和评估机器学习模型。

4 KNN算法总结

4.1 k近邻算法优缺点汇总

-

优点:

-

简单有效

-

重新训练的代价低

-

适合类域交叉样本

- KNN方法主要靠周围有限的邻近的样本,而不是靠判别类域的方法来确定所属类别的,因此对于类域的交叉或重叠较多的待分样本集来说,KNN方法较其他方法更为适合。

-

适合样本容量比较大的类域自动分类

- 该算法比较适用于样本容量比较大的类域的自动分类,而那些样本容量较小的类域采用这种算法比较容易产生误分。

样本量、样本个数与样本容量的关系举例 一个箱子最多能放50个苹果(样本),从中取样30个。 在这里,苹果是样本,箱子最多能放的个数(即苹果的总数)50是这个样本的样本(容)量,而所抽取的样本个数30则是样本量。

-

- 缺点:

- 惰性学习

- KNN算法是懒散学习方法(lazy learning,基本上不学习),一些积极学习的算法要快很多

- 类别评分不是规格化

- 不像一些通过概率评分的分类

- 输出可解释性不强

- 例如决策树的输出可解释性就较强

- 对不均衡的样本不擅长

- 当样本不平衡时,如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K个邻居中大容量类的样本占多数。该算法只计算“最近的”邻居样本,某一类的样本数量很大,那么或者这类样本并不接近目标样本,或者这类样本很靠近目标样本。无论怎样,数量并不能影响运行结果。可以采用权值的方法(和该样本距离小的邻居权值大)来改进。

- 计算量较大

- 目前常用的解决方法是事先对已知样本点进行剪辑,事先去除对分类作用不大的样本。

- 惰性学习

以上是关于机器学习k近邻算法鸢尾花种类预测的主要内容,如果未能解决你的问题,请参考以下文章