论文精读LaTr: Layout-Aware Transformer for Scene-Text VQA

Posted M号攻城狮

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文精读LaTr: Layout-Aware Transformer for Scene-Text VQA相关的知识,希望对你有一定的参考价值。

概述

1. 核心问题:

STVQA(Scene-Text Visual Question Answering)场景文本视觉问答,利用场景图片中的文本回答问题

(相关概念: OCR(Optical Character Recognition)图片文字识别)

需要利用多种模态的语义信息进行推理(视觉、语言、场景文本)

需要模型具有的能力:

(1)先验信息和知识

(2)利用视觉、语言、场景文本信息做推理

2. 研究背景:

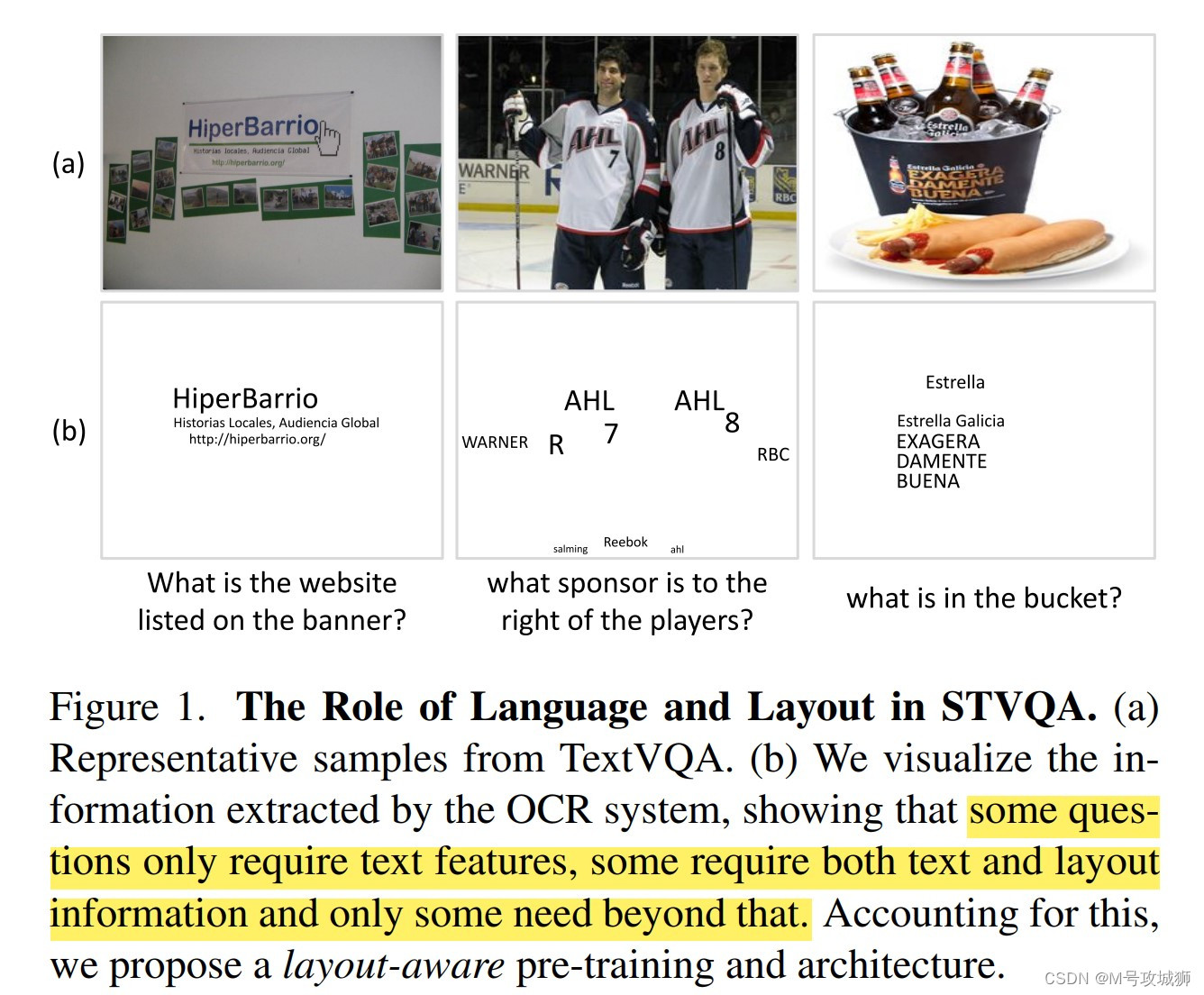

大概分为三种问题:

(1)仅仅用文本信息可以回答

(2)用文本和空间布局信息可以回答

(3)用文本、空间布局信息和视觉特征可以回答

(在当前的数据集下,大多数问题都属于前两类)

引用2020年的工作:TAP方法(text-aware pre-training)【缺陷是:获取大量带有场景文本的自然图片是困难的,并且获取到的图片中的文本比较稀疏;更重要的是,在设计预训练目标函数时没有考虑到空间布局信息和语义表征的融合】

Contributions:

(1)认识到文本和布局信息在STVQA问题中的重要性,并提出了Layout-Aware预训练的方法以及网络架构。

(2)从经验上表明文档有利于结合文本与布局信息,在文档中的预训练有利于解决STVQA,即使二者之间问题的领域不同。

(3)LaTr不需要词汇表,在训练词汇以外的情况下也表现良好(之前的方法在这方面表现很差);并且能在一定程度上克服OCR错误

(4)在多个STVQA数据集上实现SOTA

Abstract

我们提出了一种用于 场景文本视觉问答(STVQA) 的多模态架构,命名为 Layout-Aware Transformer (LaTr)

STVQA的任务要求模型在不同模态的信息下进行推理,因此,我们首先研究了每种模态的影响,并揭示语言模块的重要性,特别是结合布局信息 (layout information)。

为此,我们提出了一种只需要文本和空间信号的单一目标函数的预训练方案。我们表明,在扫描文档上应用这种预训练方案比使用自然图像有一定的优势,尽管存在域的不同。扫描文档易于获取,文本密集,具有各种布局,通过将语言和布局信息联系在一起,帮助模型学习各种空间线索。

与现有的方法相比,我们的方法采用 vocabulary-free decoding,在训练词汇以外表现出很好的泛化性。我们进一步证明了LaTr提高了对OCR错误的鲁棒性,这是STVQA中失败案例的常见原因。此外,通过利用视觉转换器,我们消除了外部对象检测器的需求。在多个数据集上,LaTr优于最先进的STVQA方法。特别是TextVQA +7.6%, ST-VQA +10.8%, OCR-VQA +4.0%(均为绝对精度数字)。

以上是关于论文精读LaTr: Layout-Aware Transformer for Scene-Text VQA的主要内容,如果未能解决你的问题,请参考以下文章