为了高性能超大规模的模型训练,这个组合“出道”了

Posted dotNET跨平台

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了为了高性能超大规模的模型训练,这个组合“出道”了相关的知识,希望对你有一定的参考价值。

点击上方蓝字

关注我们

(本文阅读时间:3分钟)

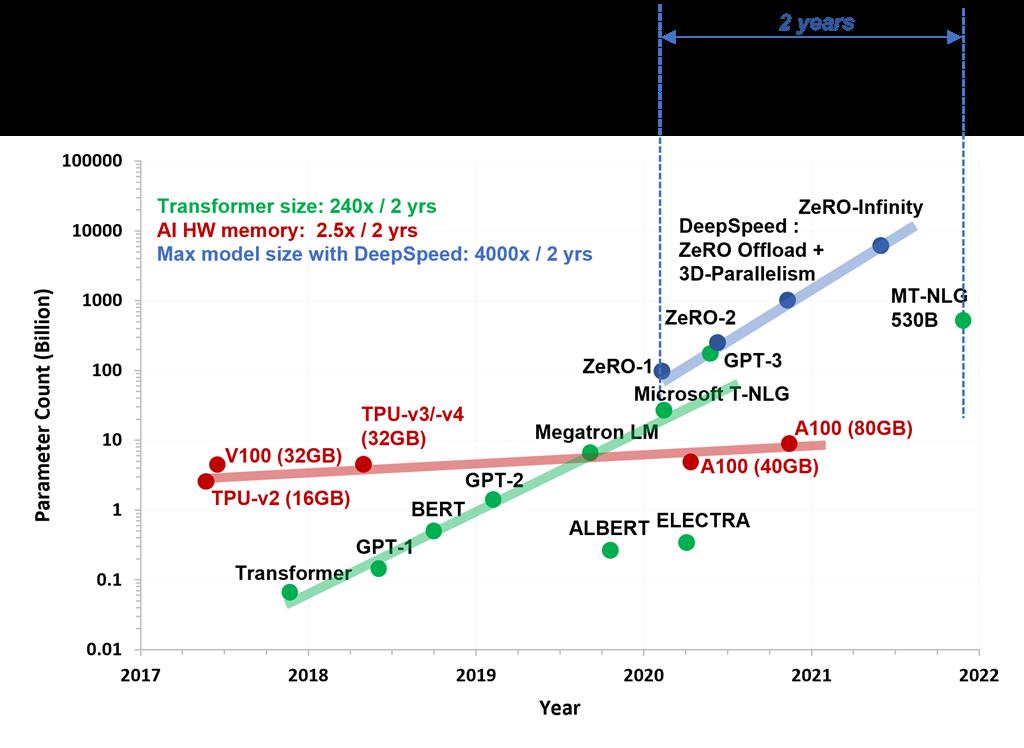

近年来,在大量数据上训练的基于 transformer 的大规模深度学习模型在多项认知任务中取得了很好的成果,并且被使用到一些新产品和功能背后,进一步增强了人类的能力。在过去五年中,这些模型的规模增长了几个数量级。从最初的 transformer 模型的几百万个参数一直到最新的 5300 亿个参数的 Megatron-Turing (MT-NLG 530B) 模型(如图所示),客户对于前所未有的大规模训练和微调大型模型的需求越来越强烈。

大模型和硬件能力全景图

Azure 机器学习 (AzureML)带来了大量由 InfiniBand 互连提供支持的最新 GPU,以应对大规模 AI 训练。我们已经在 Azure 上训练了 Megatron/Turing 和 GPT-3这些模型。以前,为了训练这些模型,用户需要设置和维护一个复杂的分布式训练基础设施,通常涉及几个手动的步骤,容易出错,从而导致在可用性和性能方面的体验不佳。

今天,我们很自豪地宣布在我们的软件堆栈中取得突破——使用 DeepSpeed 和 1024 A100 来扩展 2T 参数模型的训练,并在 1K+ GPU 规模上提供精简的用户体验。我们将通过 AzureML(包括充分优化的 PyTorch 环境)为您带来这些软件创新,它为大规模训练提供了出色的性能和易于使用的界面。

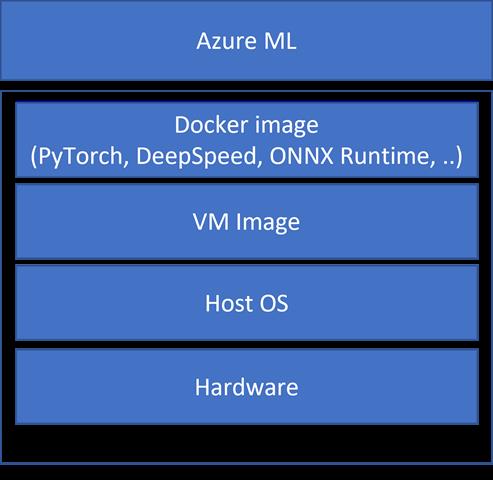

如下图所示,微软正在采用全栈优化方法,其中硬件、操作系统、VM image、Docker image(含优化后的PyTorch、DeepSpeed、ONNX 运行时和其他Python包)、面向用户的Azure ML APIs都已经过优化、集成和测试,具有出色的性能和可扩展性。

微软针对 Azure 上可扩展分布式训练的全栈优化

这个优化的堆栈使我们能够使用DeepSpeed on Azure有效地扩展大型模型的训练。与其他云场商发布的数据相比,我们支持 2 倍大的模型大小(2 万亿 vs. 1 万亿参数),扩展到 2 倍的 GPU(1024 vs. 512),以及高达 1.8 倍的计算吞吐量/GPU(150 TFLOPs vs. 81 TFLOPs)。

如果您想更深入地了解性能数据,以及Azure 和 DeepSpeed 如何使您轻松、高效地大规模训练万亿参数模型,请扫码或点击最下方“阅读原文”。原博客文末有丰富的相关资源!

长按识别二维码

点击「阅读原文」前往原博客~

以上是关于为了高性能超大规模的模型训练,这个组合“出道”了的主要内容,如果未能解决你的问题,请参考以下文章

阿里开源自研工业级稀疏模型高性能训练框架 PAI-HybridBackend