自注意力 self attention Transformer 多头注意力代码 Transformer 代码 动手学深度学习v2

Posted AI架构师易筋

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了自注意力 self attention Transformer 多头注意力代码 Transformer 代码 动手学深度学习v2相关的知识,希望对你有一定的参考价值。

1. 自注意力 self attention

2. 自注意力 self attention 代码实现

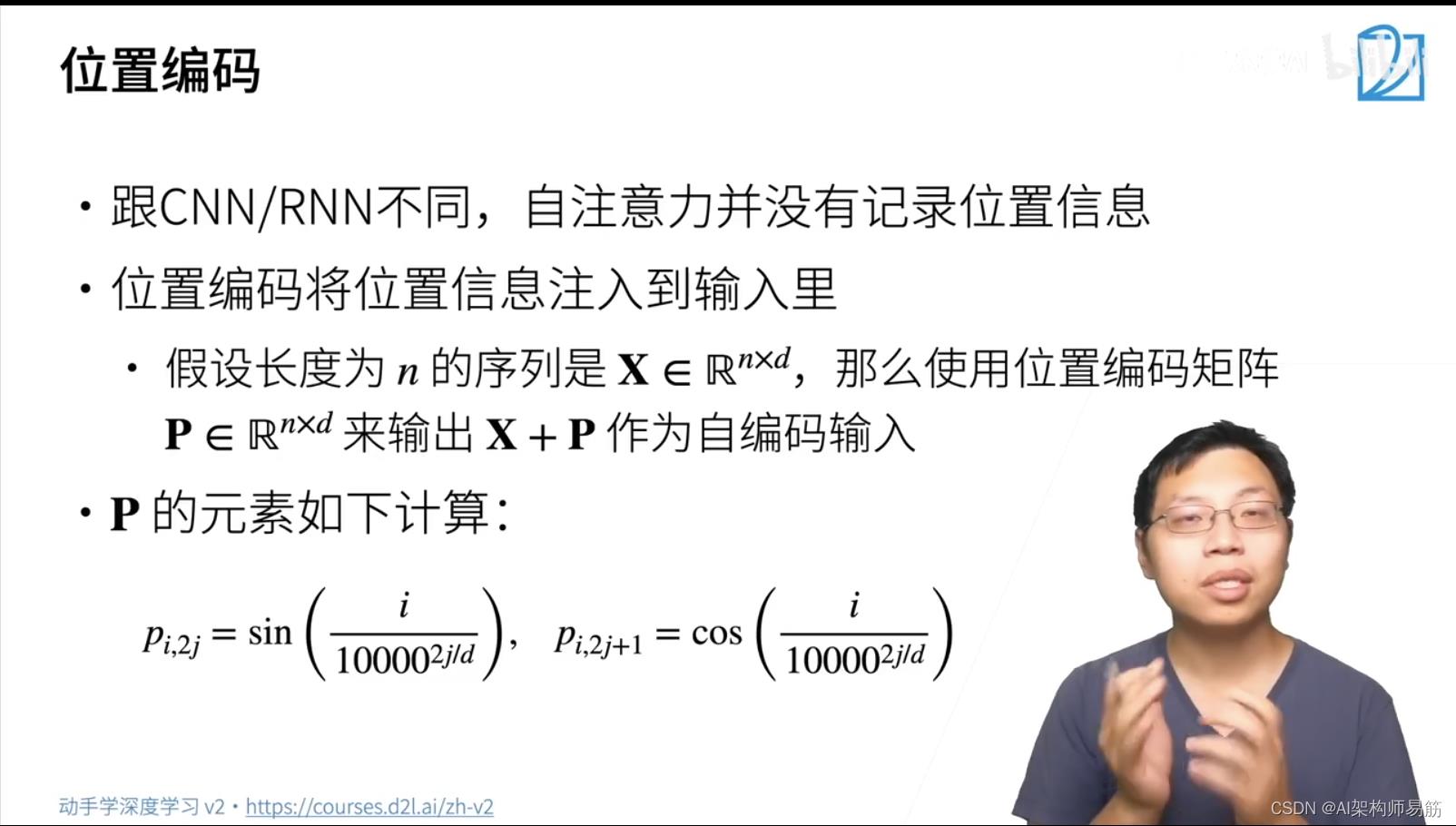

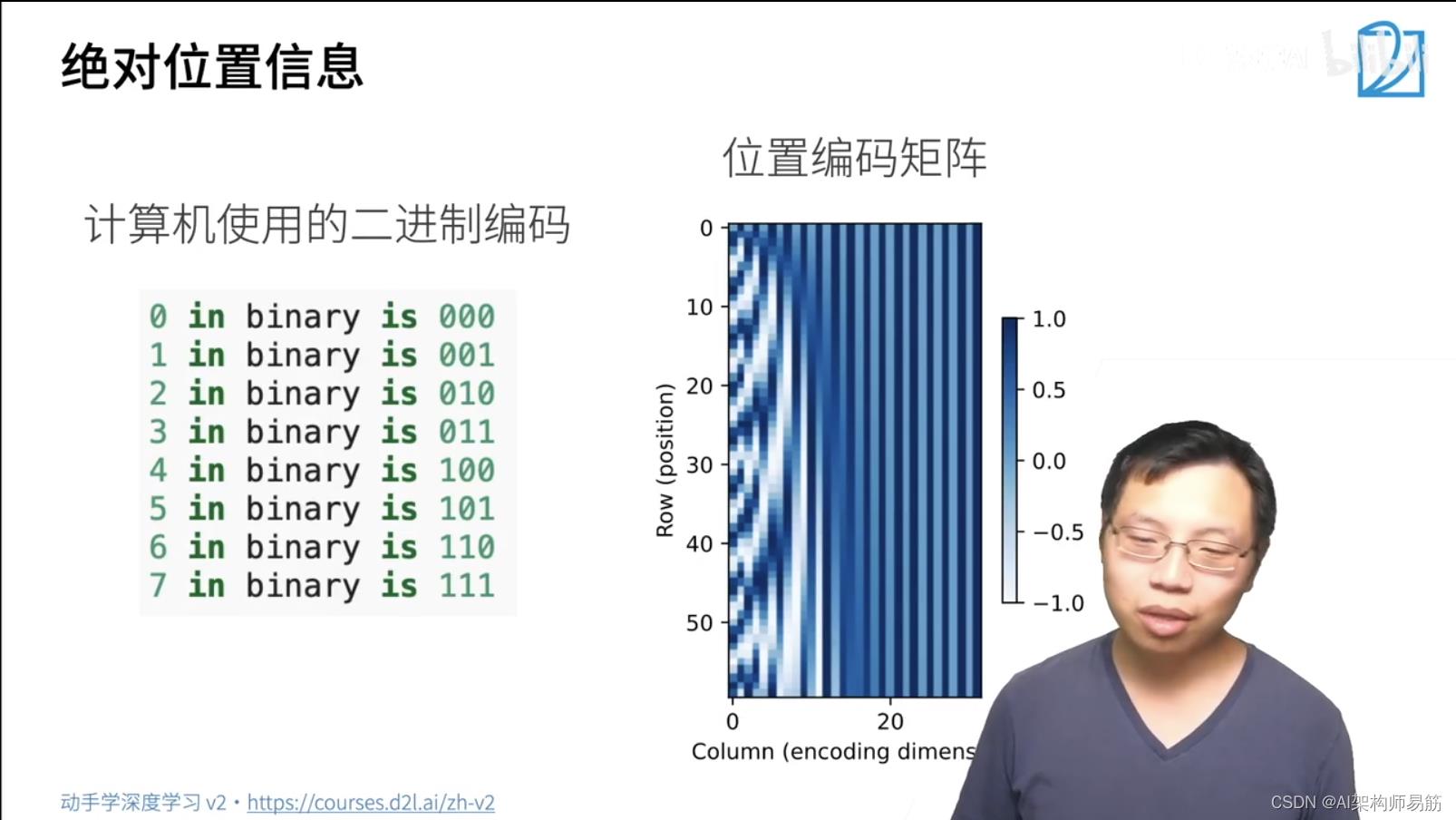

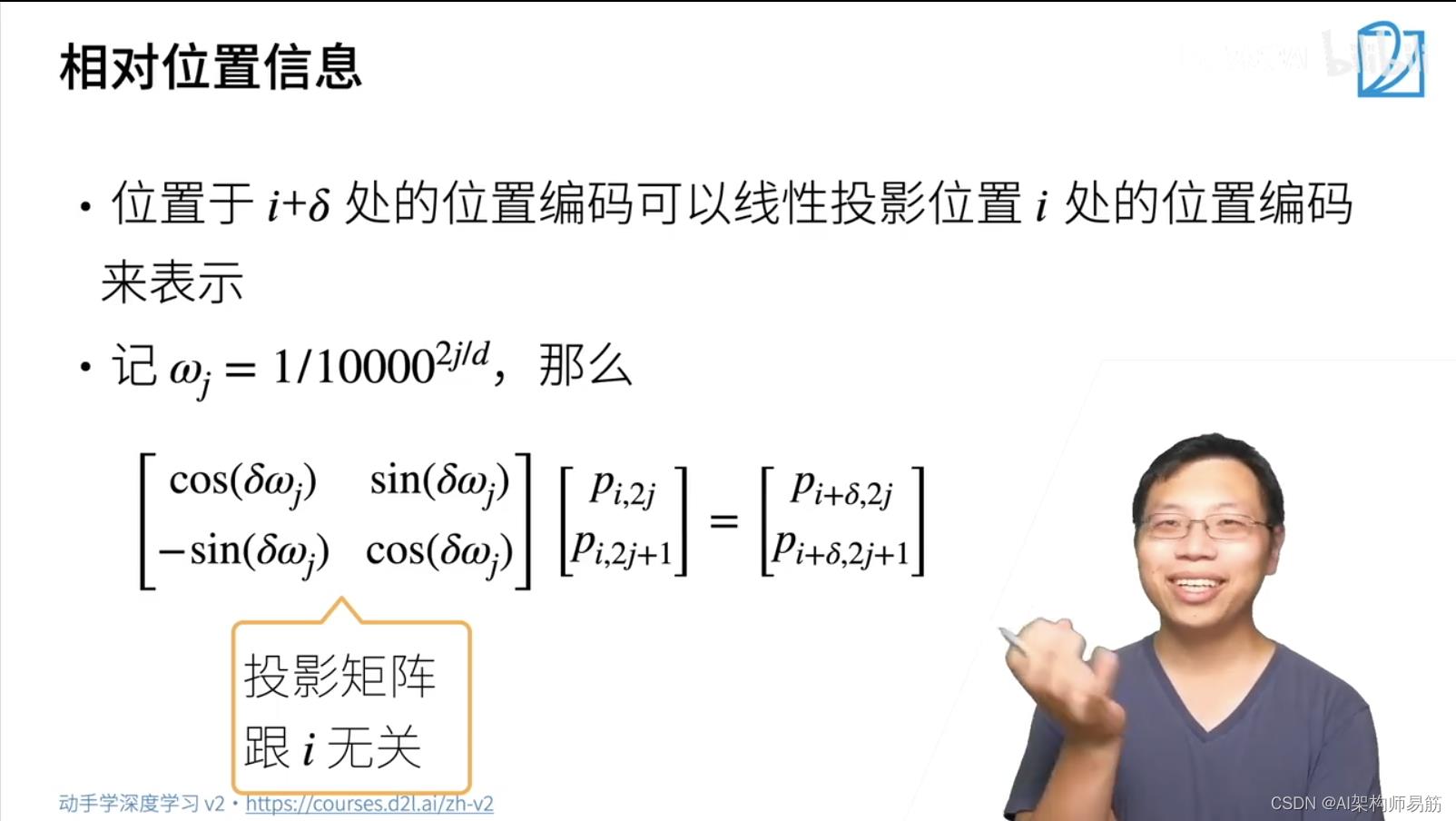

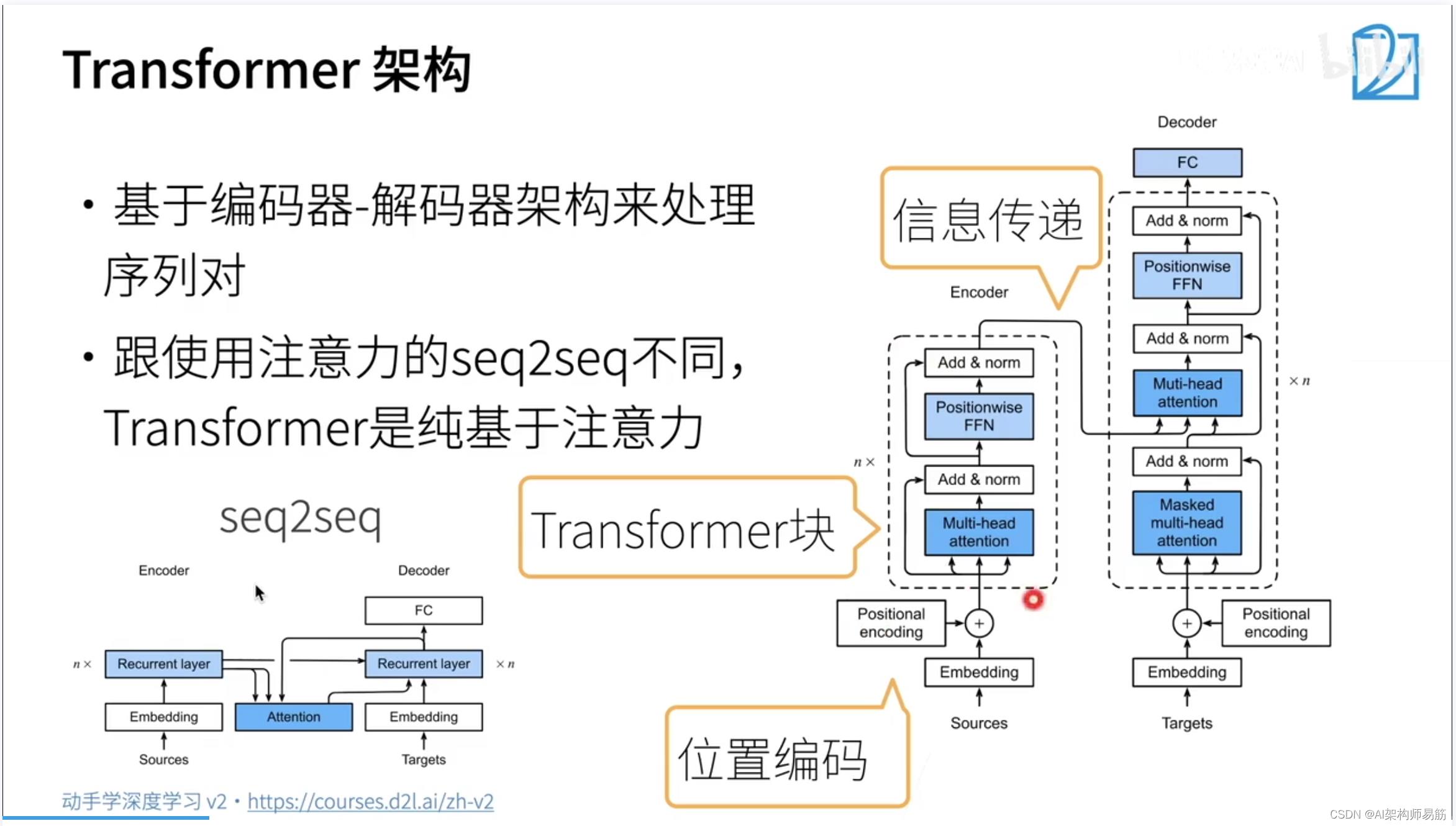

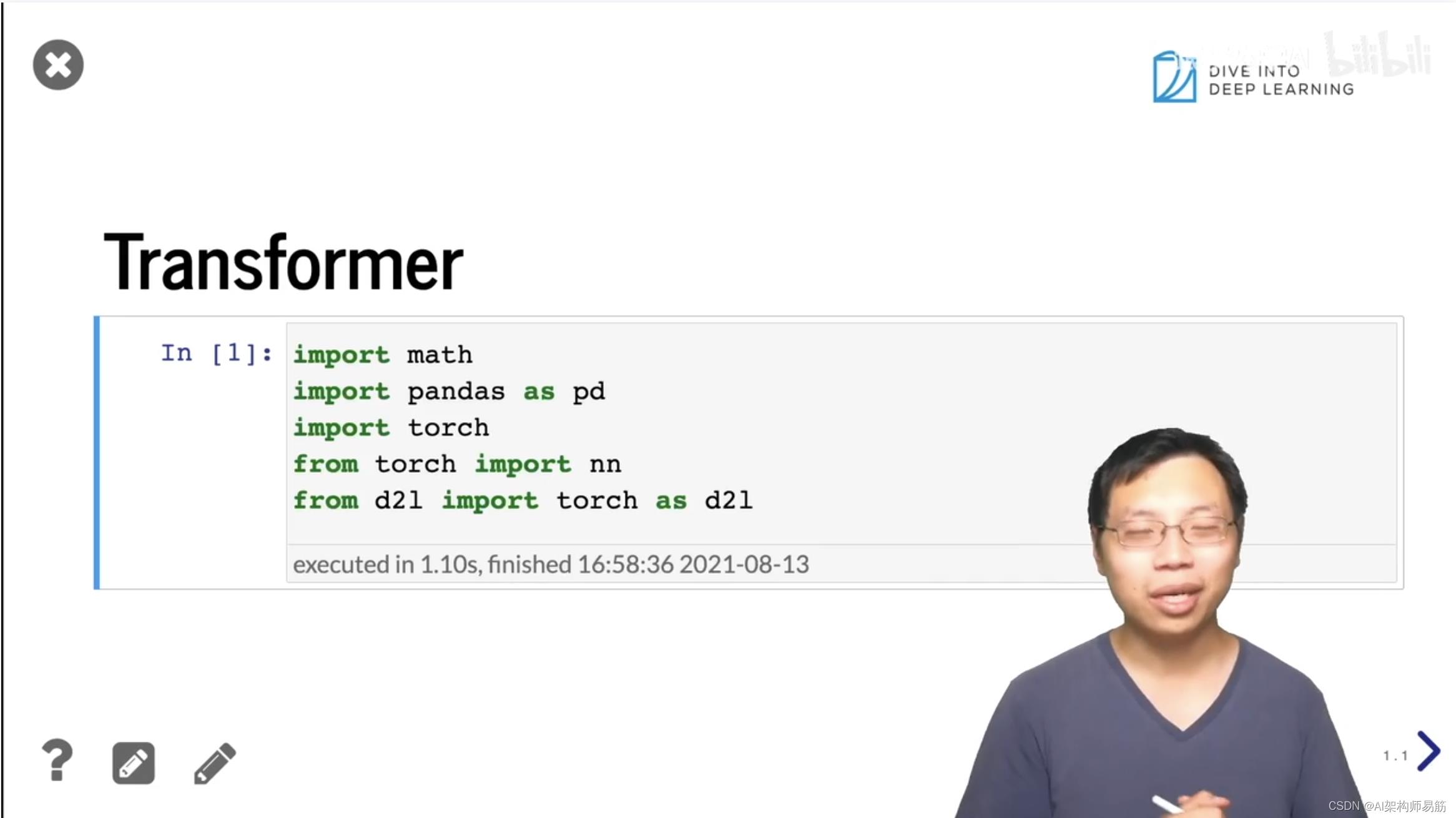

3. Transformer

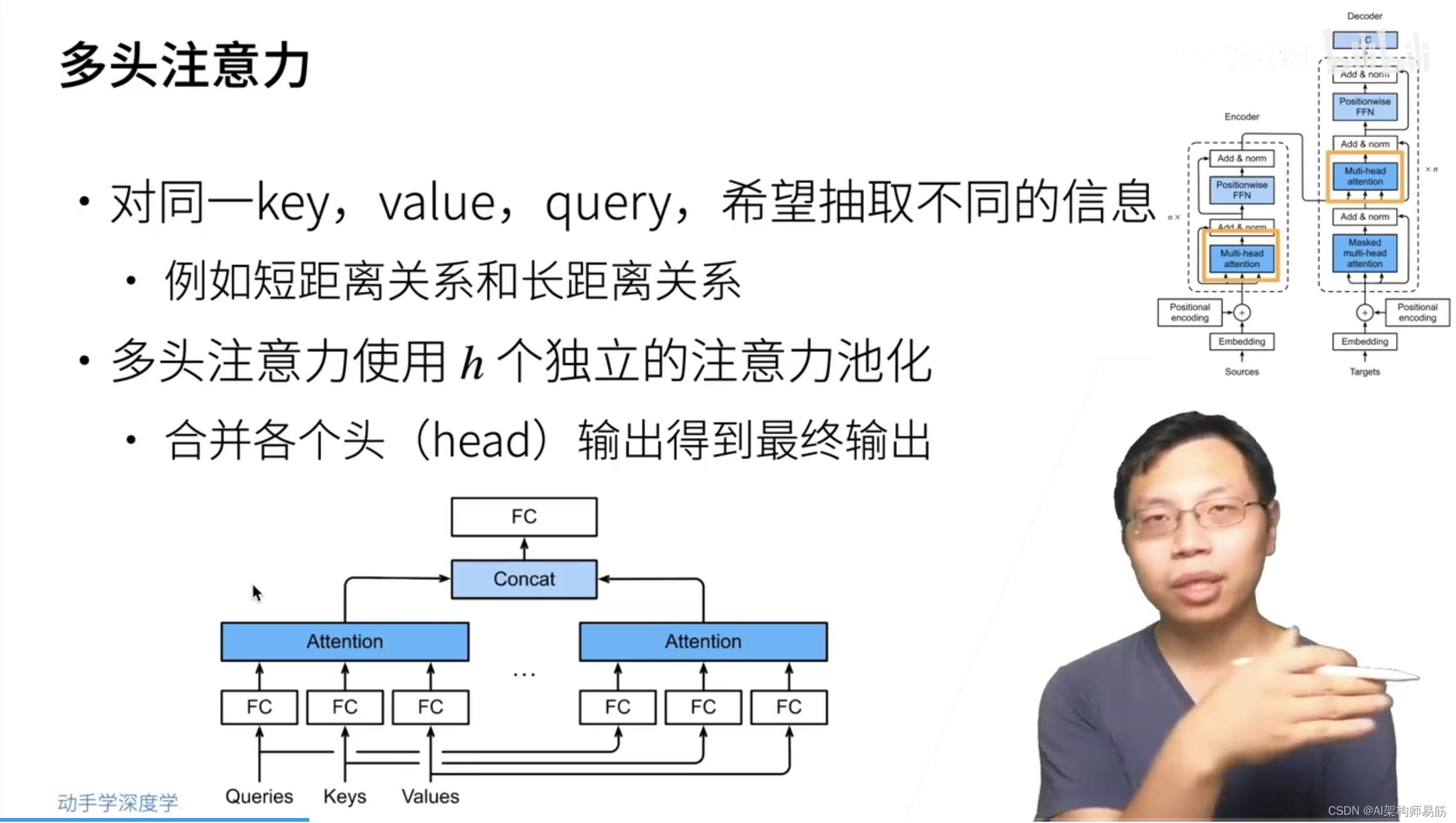

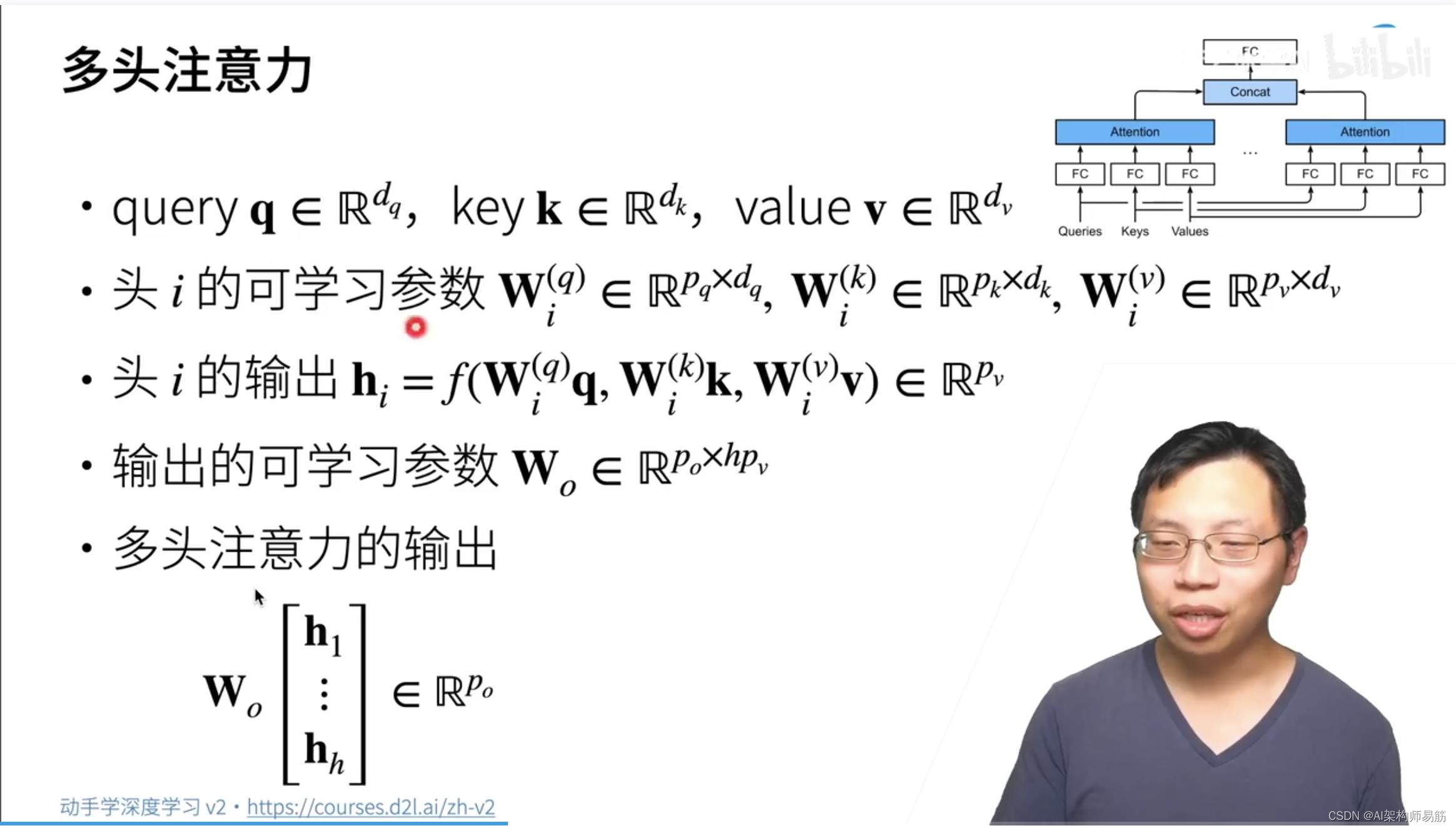

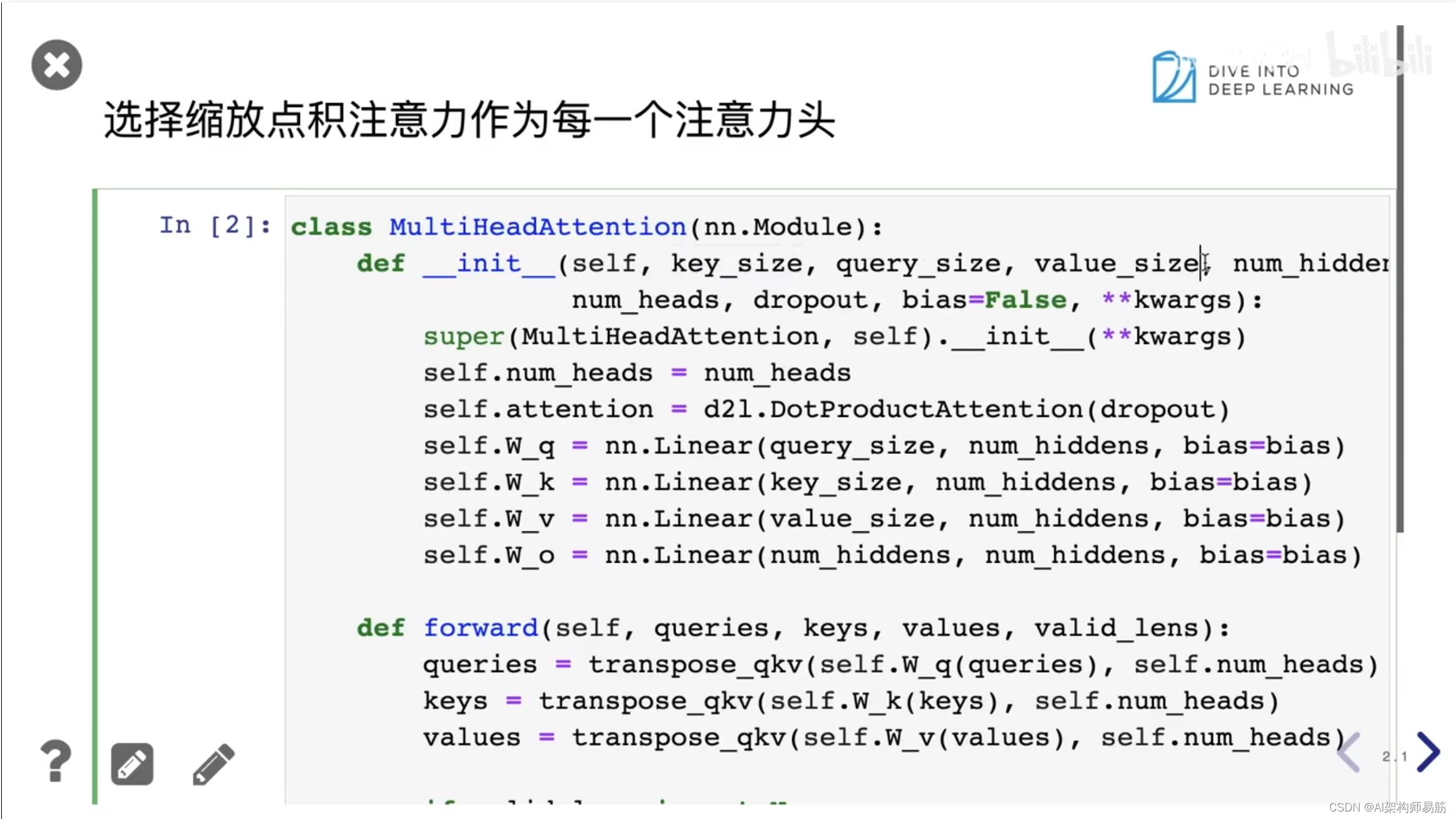

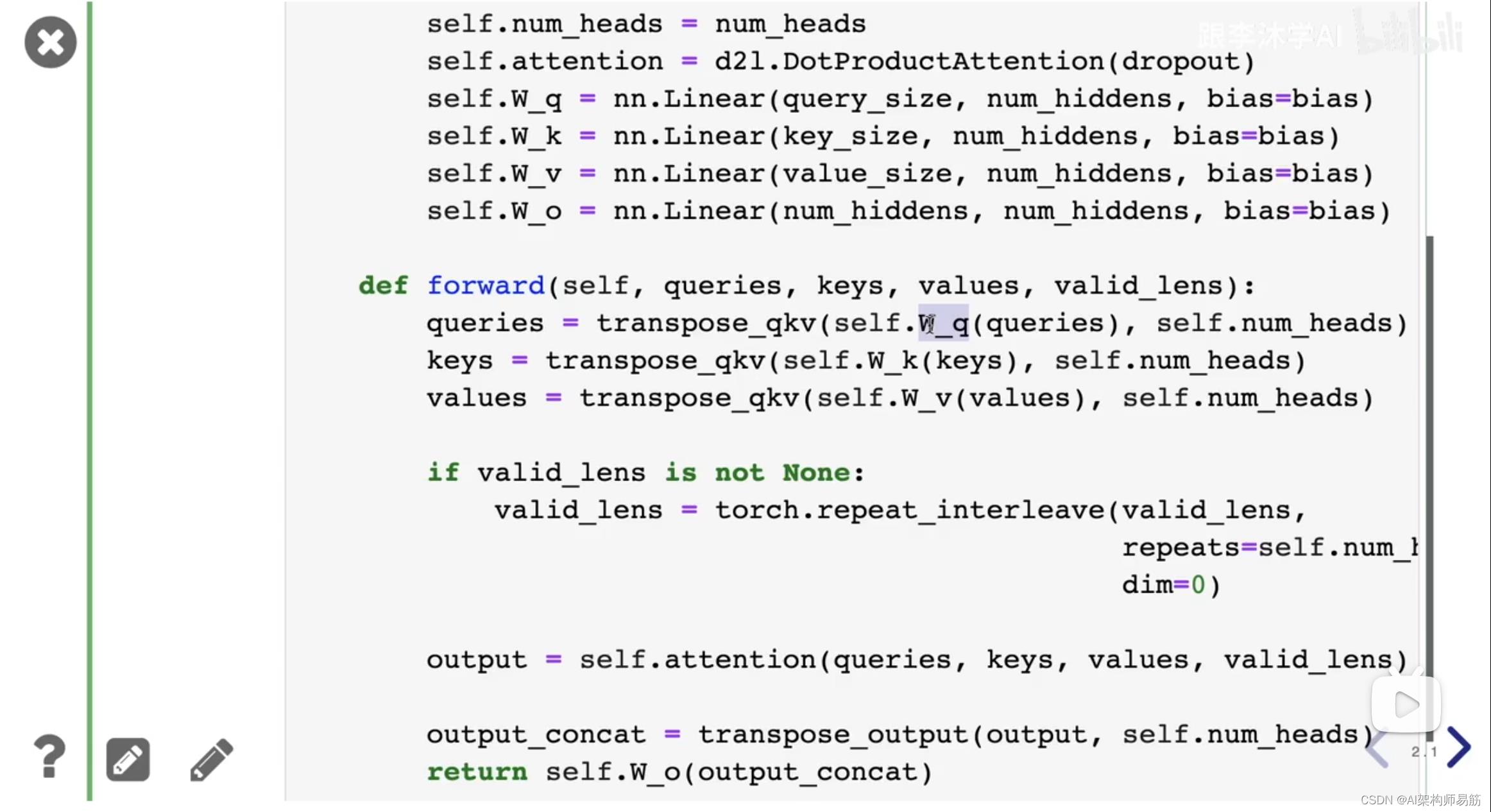

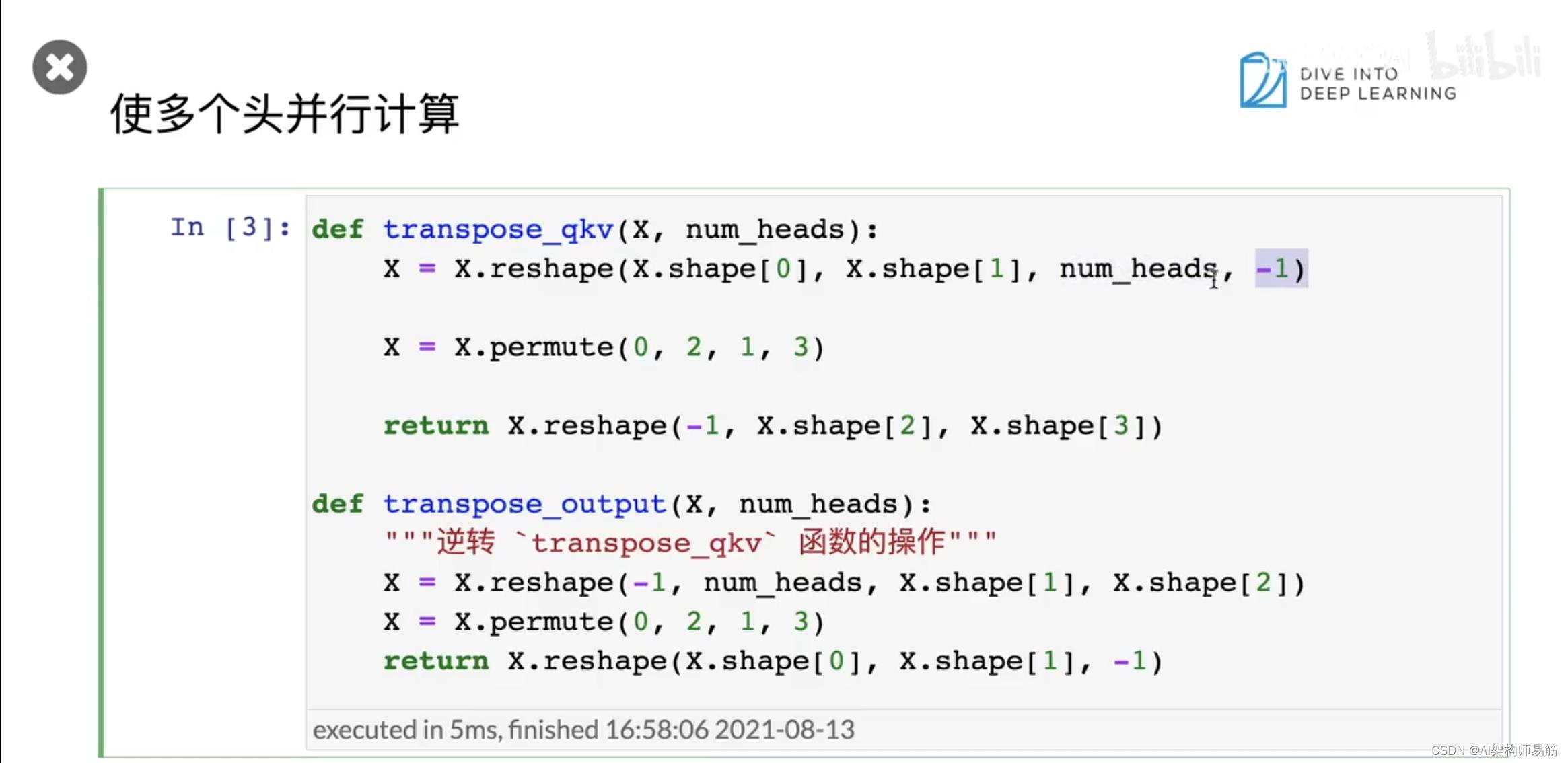

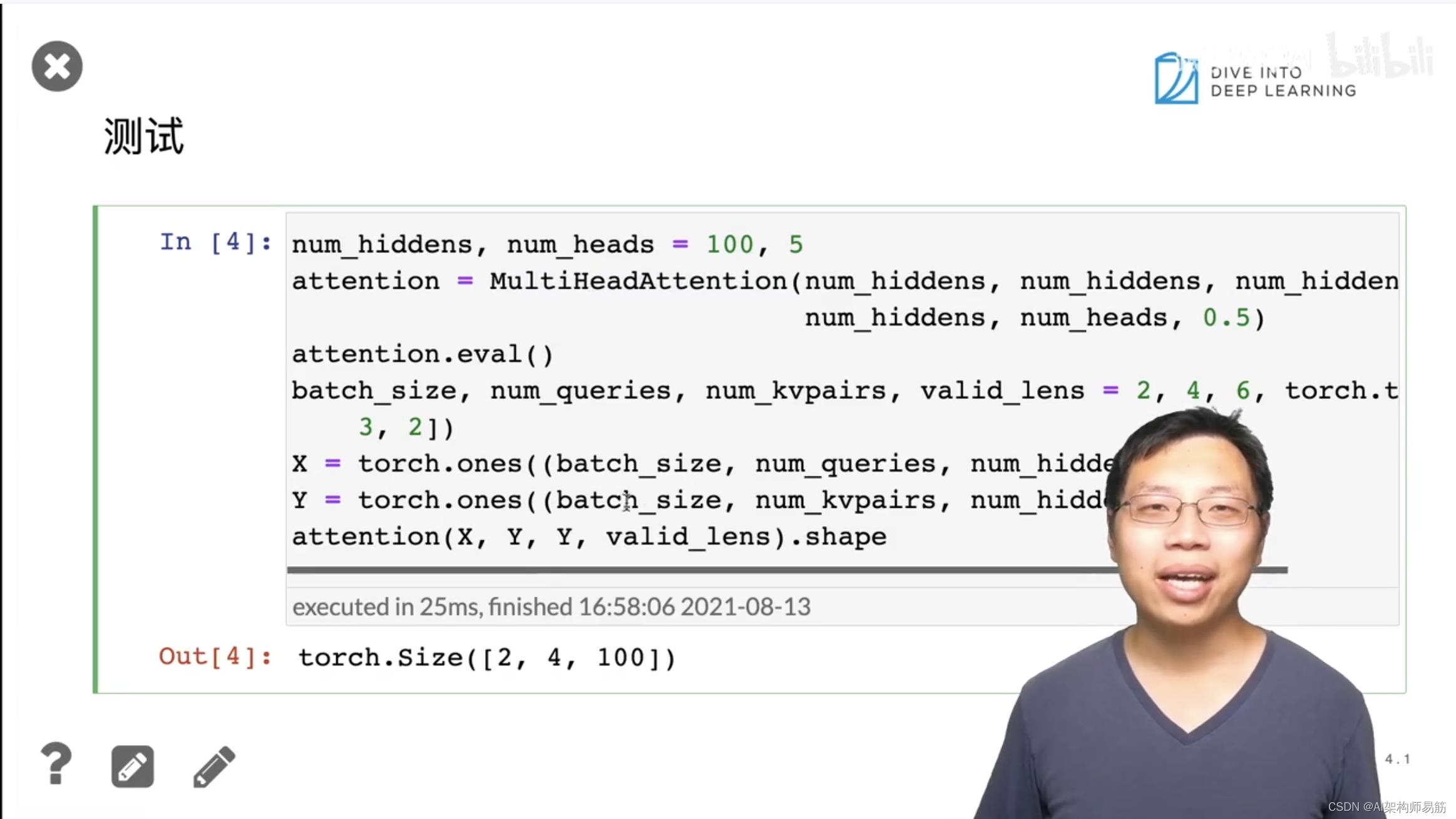

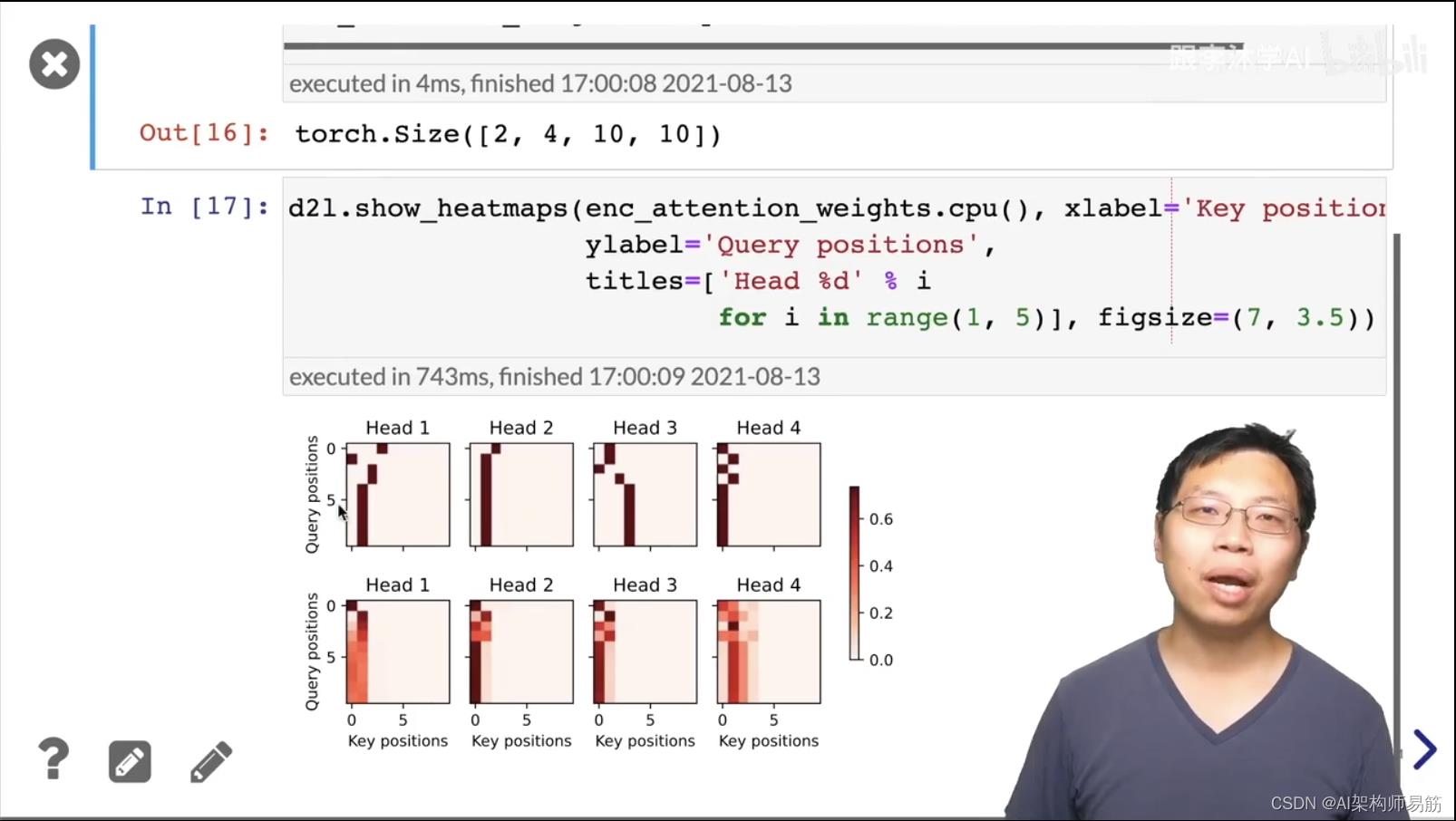

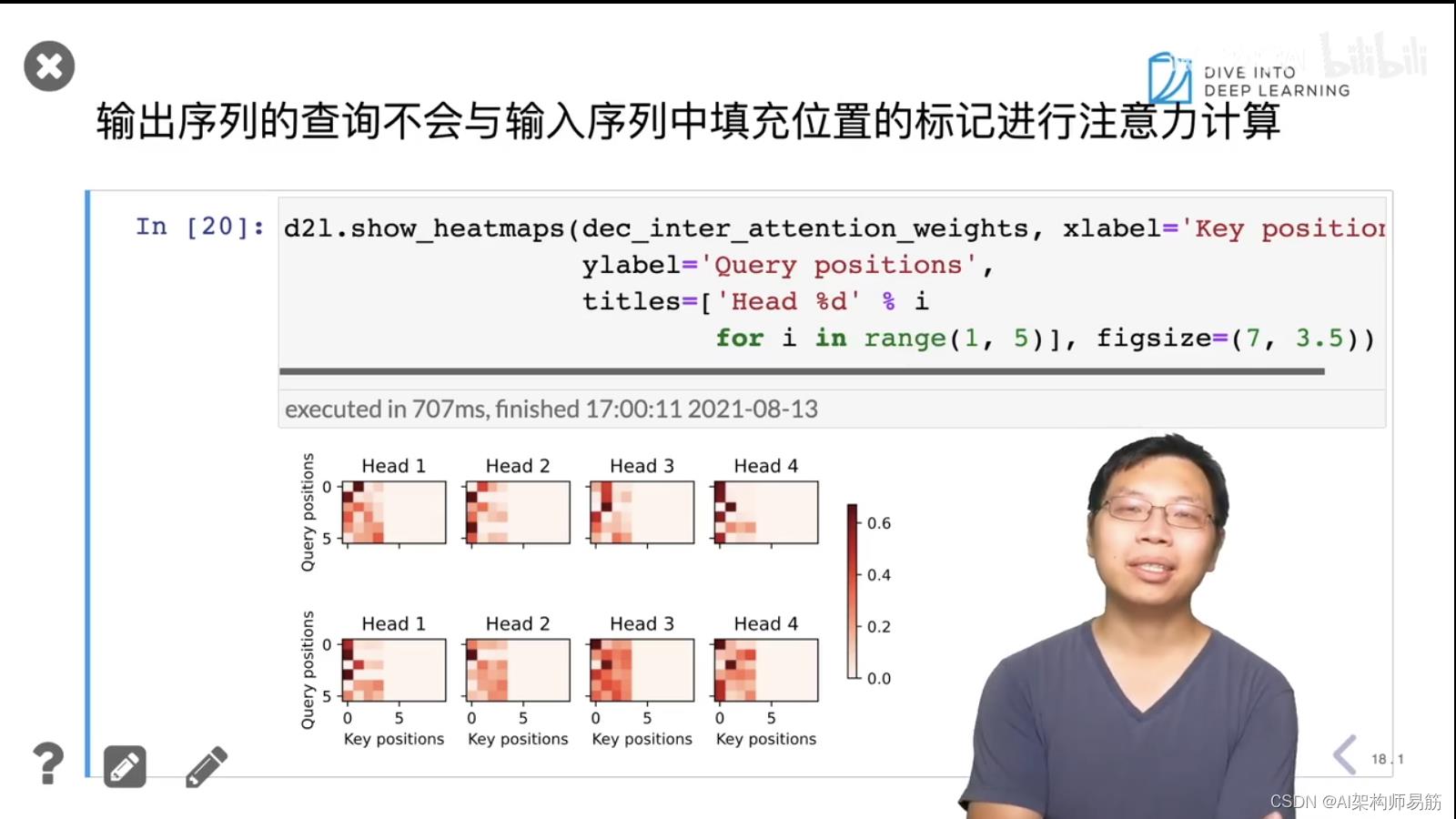

4. 多头注意力代码

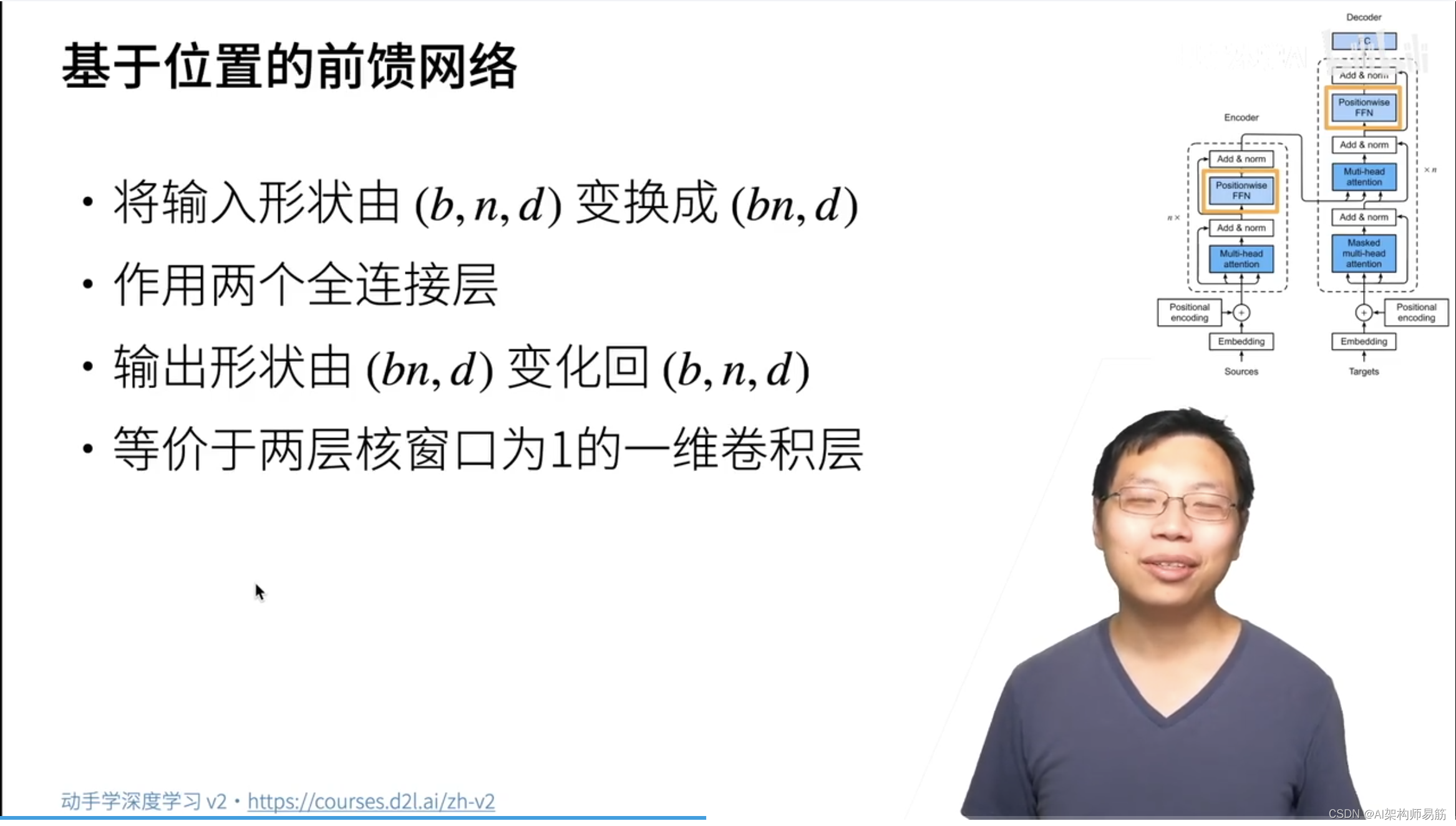

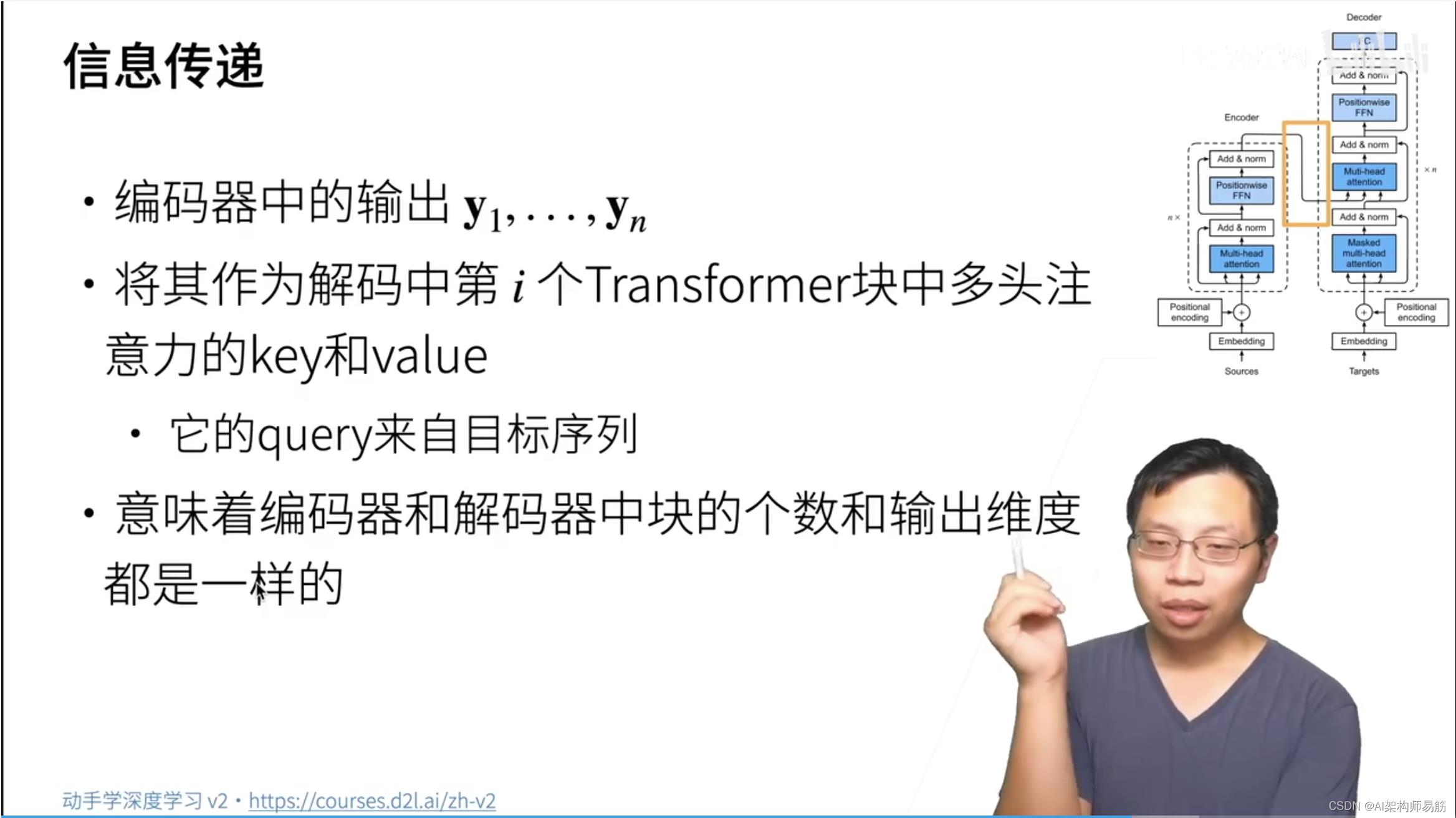

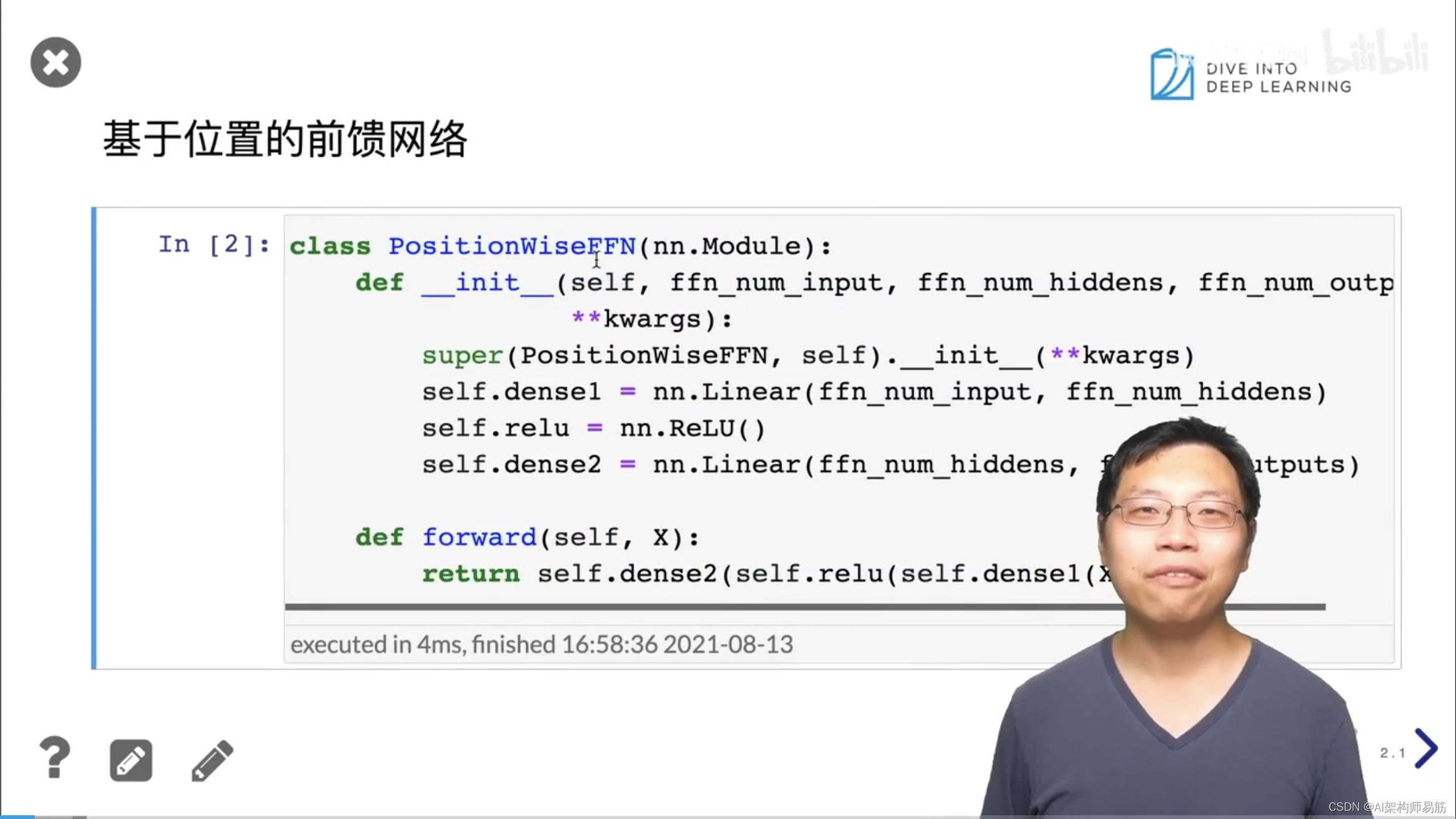

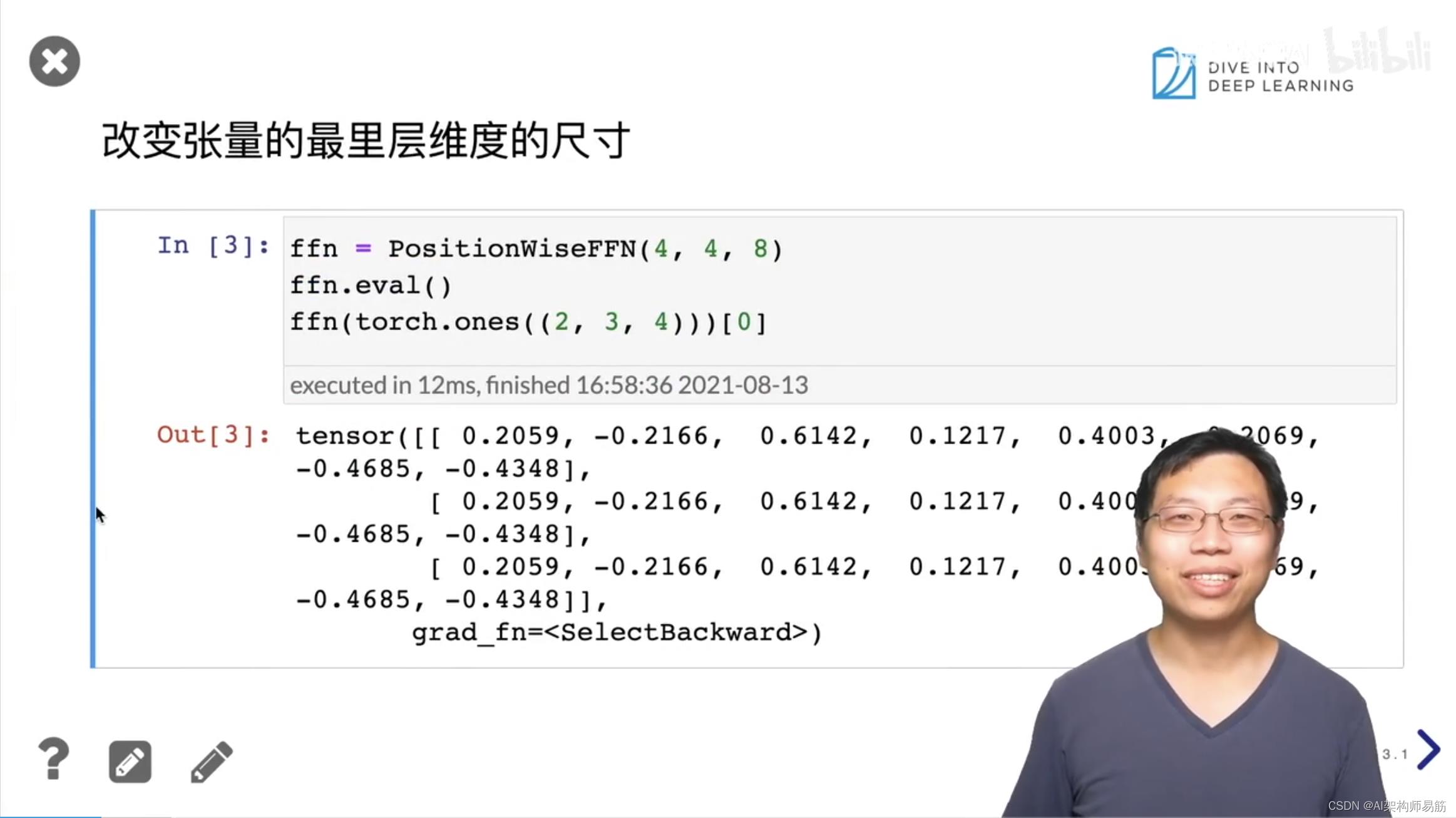

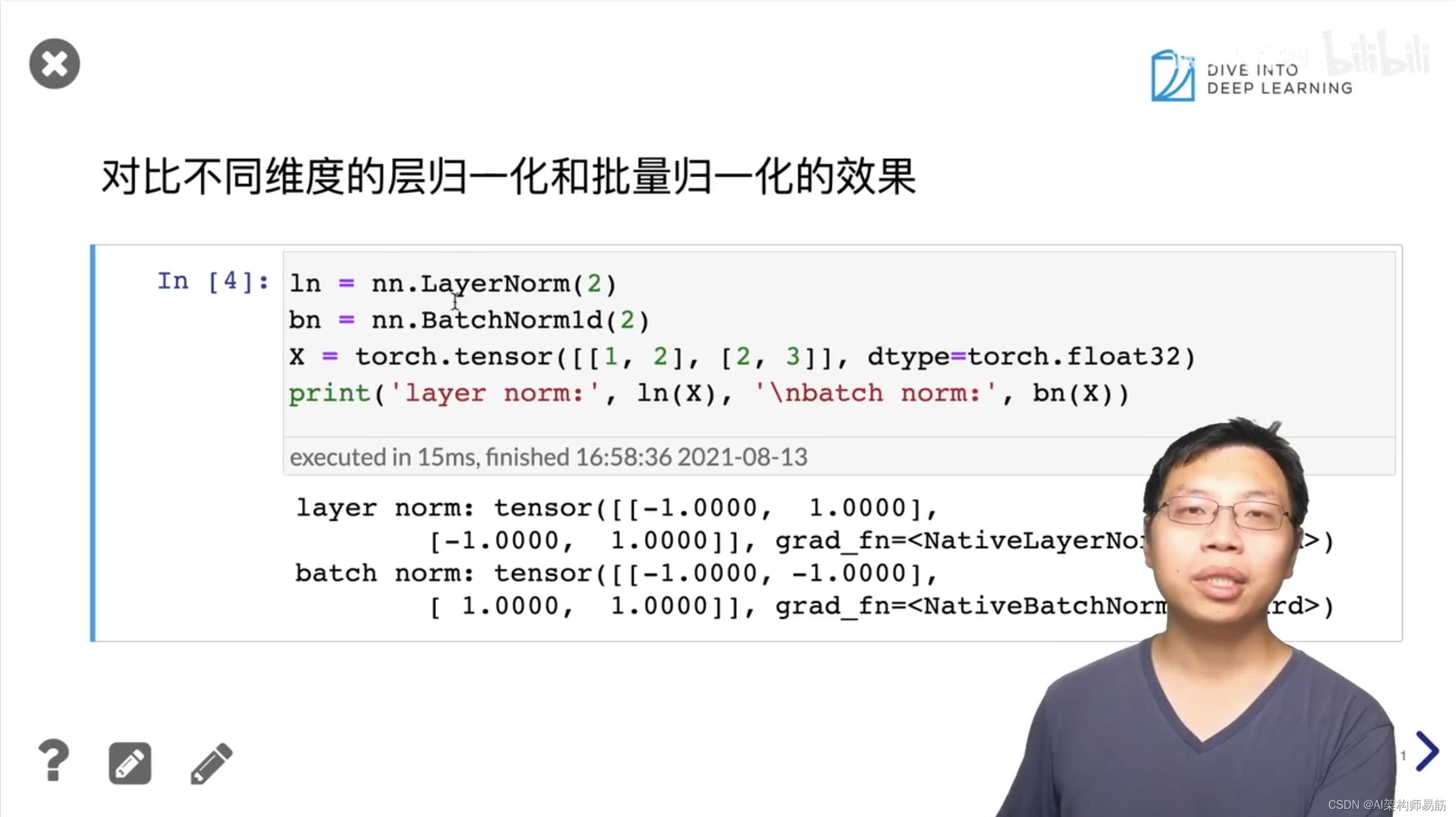

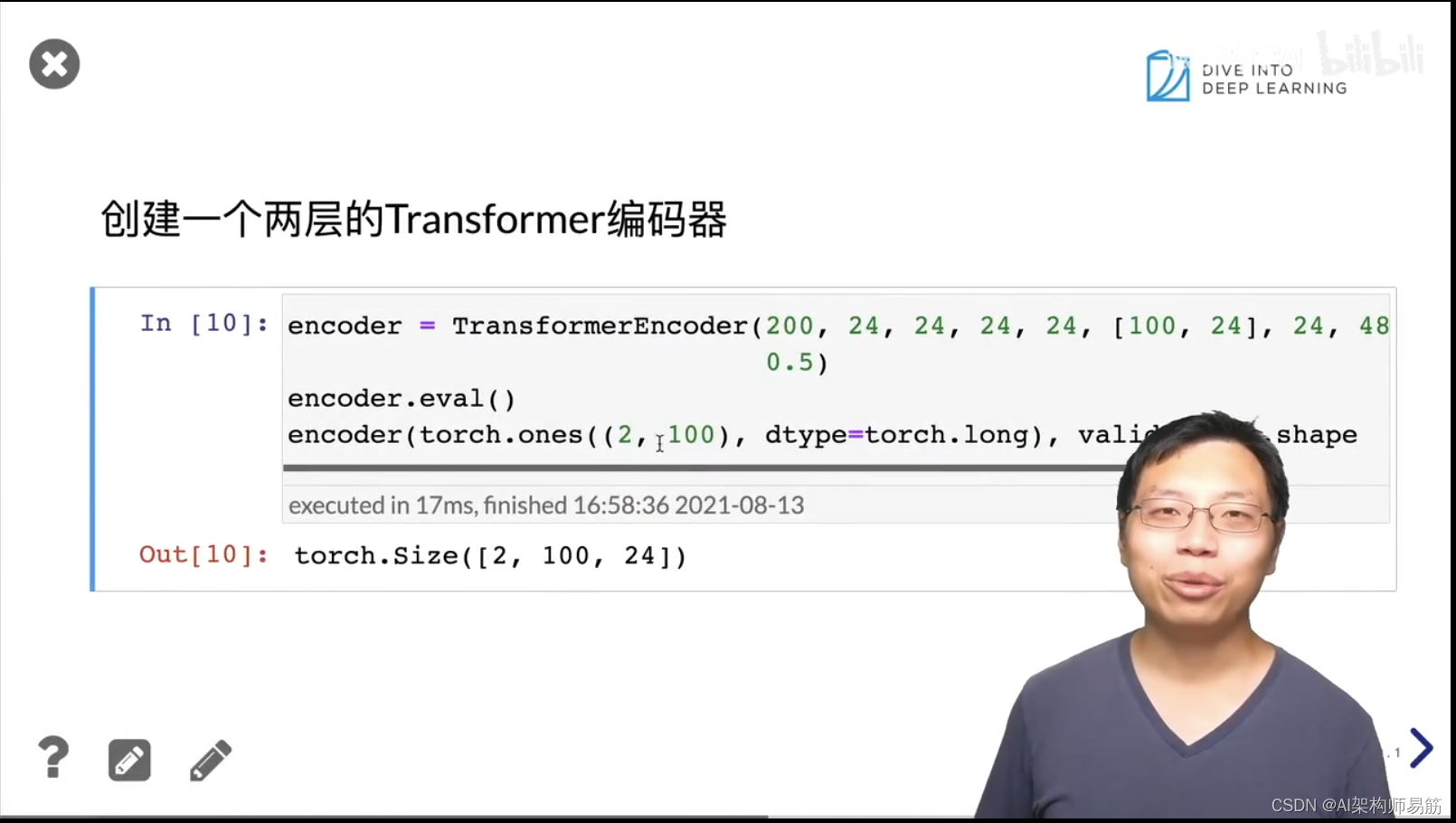

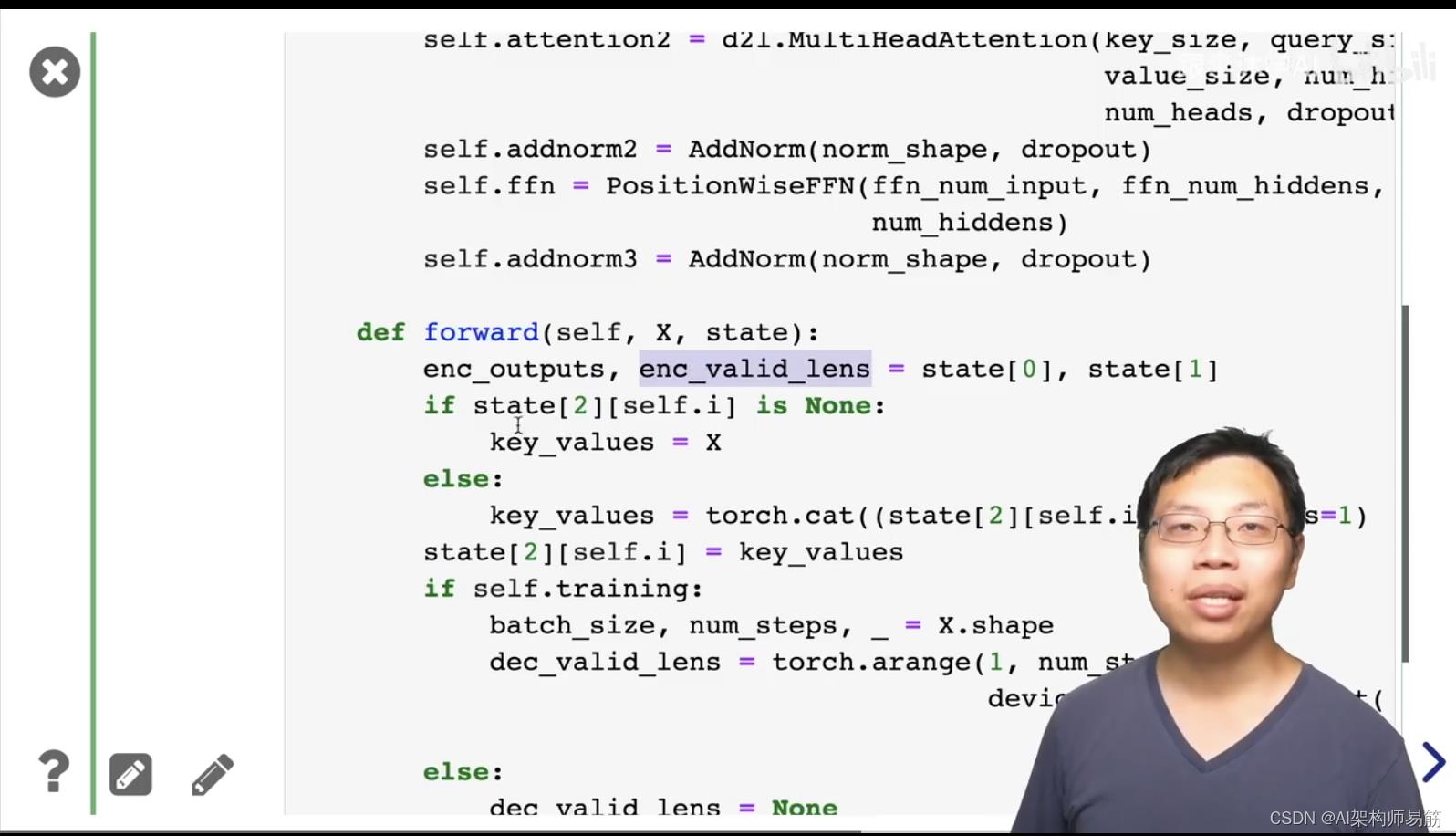

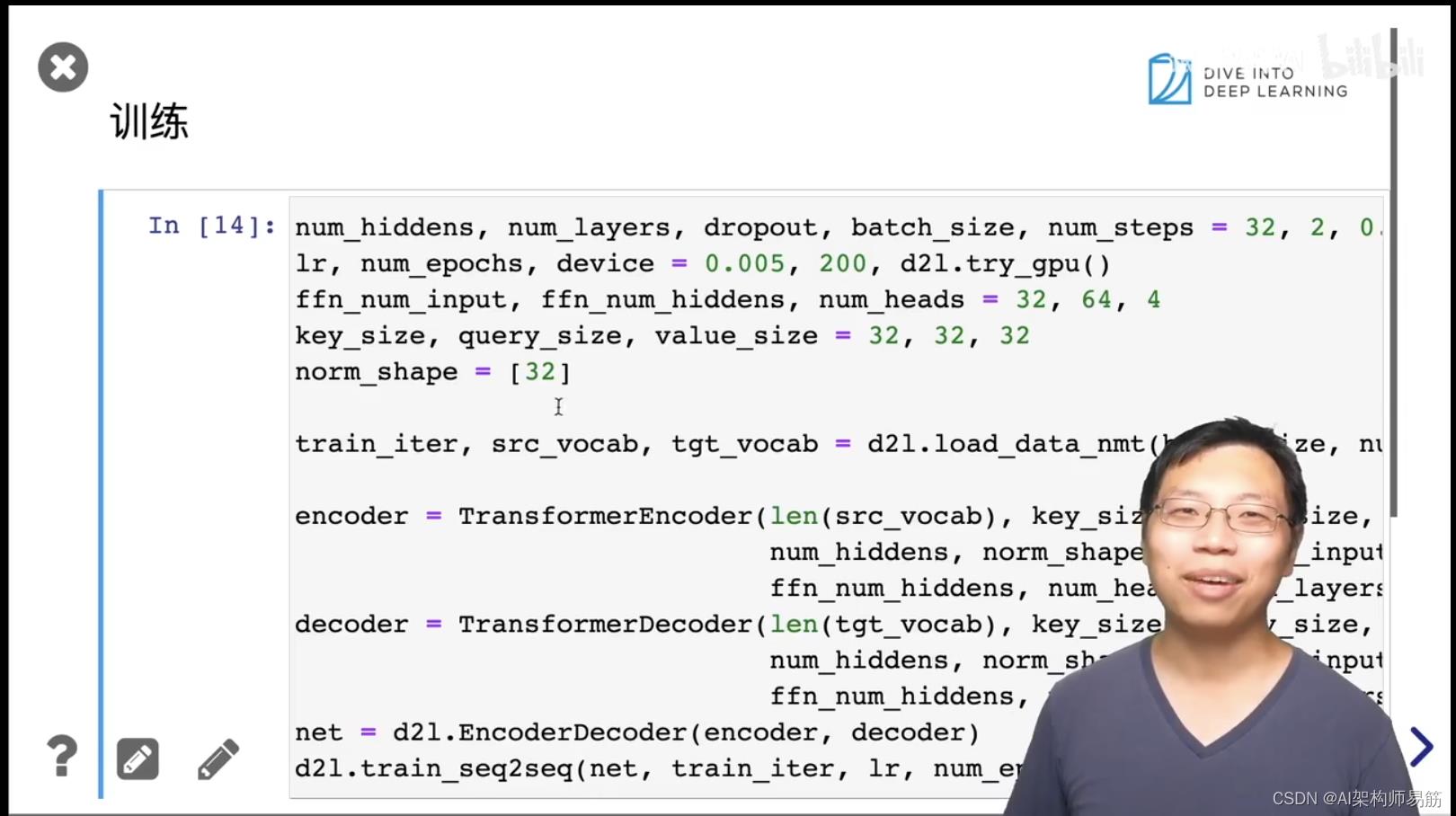

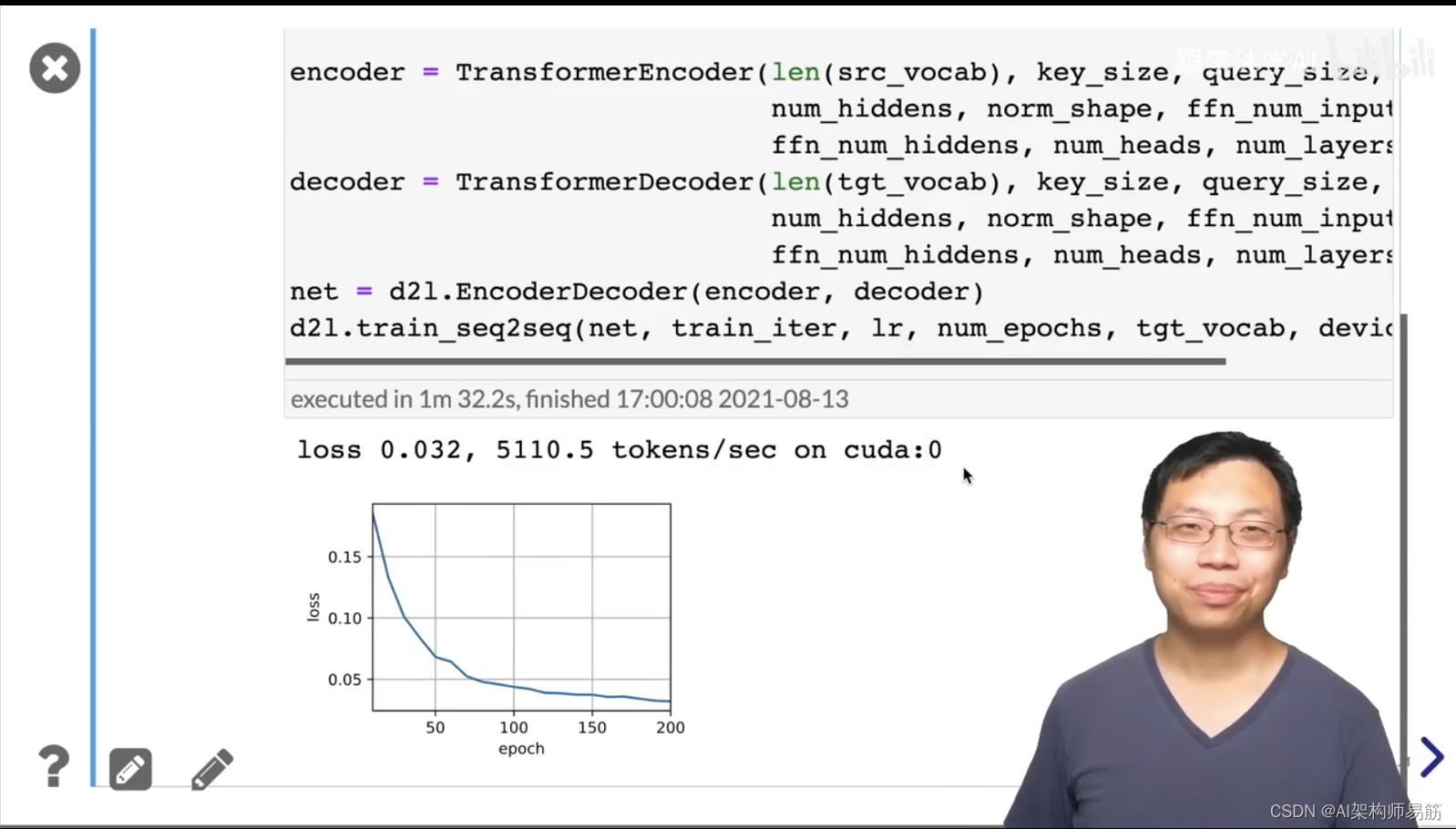

5. Transformer 代码

6.Q&A

-

- transformer 特别适合应用到芯片上。

参考

https://www.bilibili.com/video/BV19o4y1m7mo?p=1

以上是关于自注意力 self attention Transformer 多头注意力代码 Transformer 代码 动手学深度学习v2的主要内容,如果未能解决你的问题,请参考以下文章

自注意力 self attention Transformer 多头注意力代码 Transformer 代码 动手学深度学习v2

自注意力 self attention Transformer 多头注意力代码 Transformer 代码 动手学深度学习v2

读点论文Focal Self-attention for Local-Global Interactions in Vision Transformers局部和全局注意力进行交互实现新SOTA

[CVPR2021]Beyond Self-attention External Attention using Two Linear Layers for Visual Tasks