注意力机制 attention 注意力分数 动手学深度学习v2

Posted AI架构师易筋

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了注意力机制 attention 注意力分数 动手学深度学习v2相关的知识,希望对你有一定的参考价值。

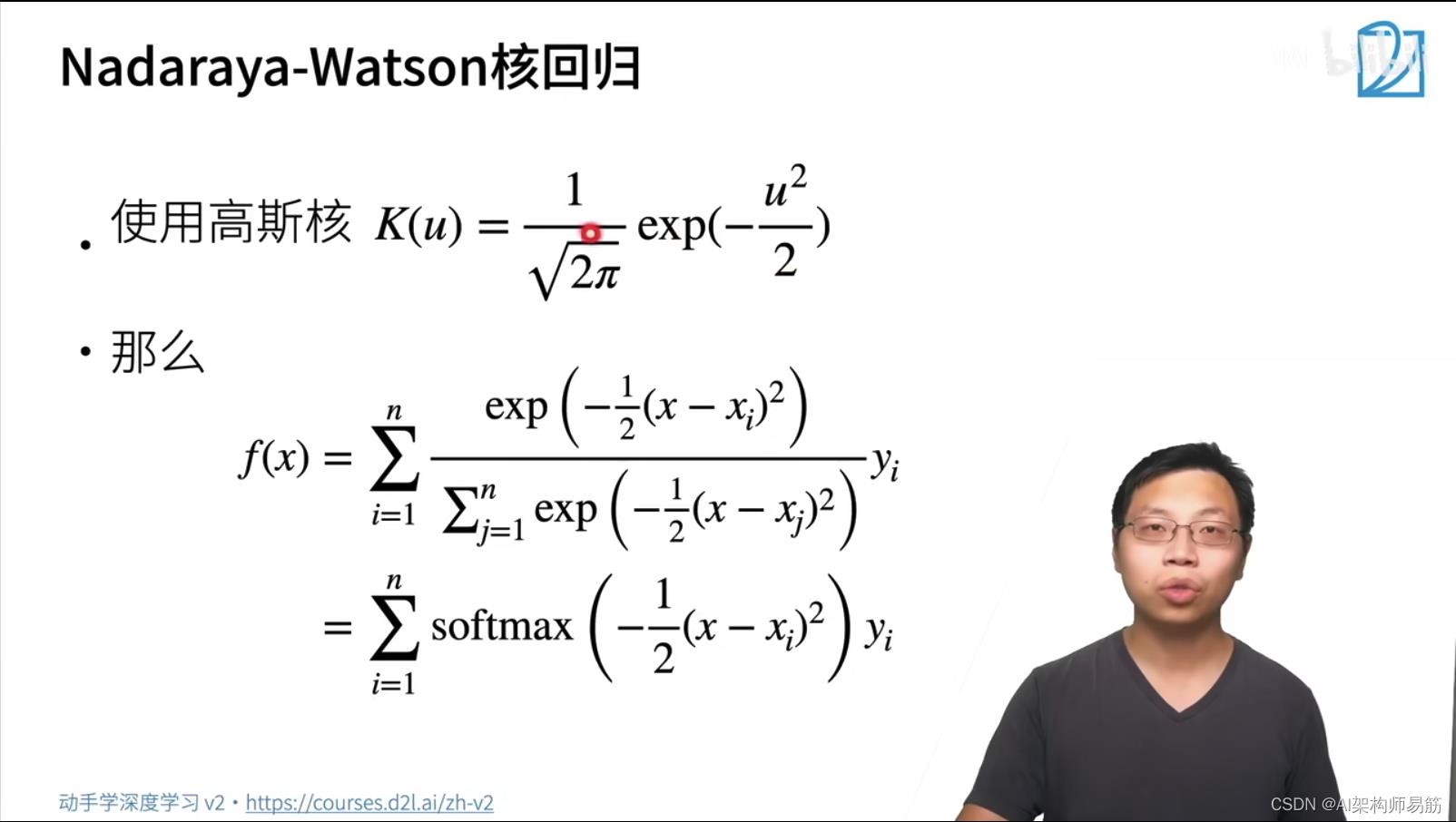

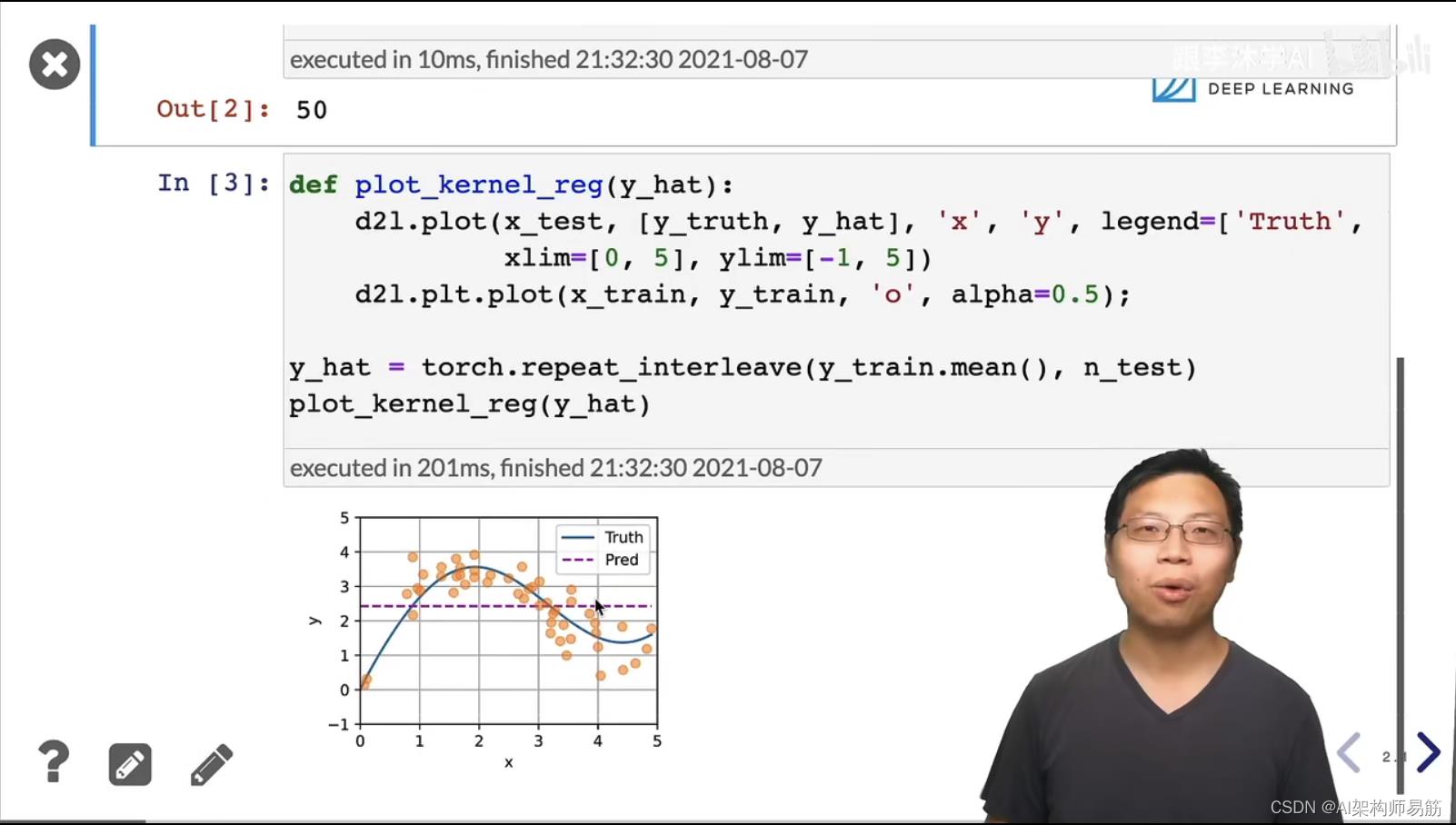

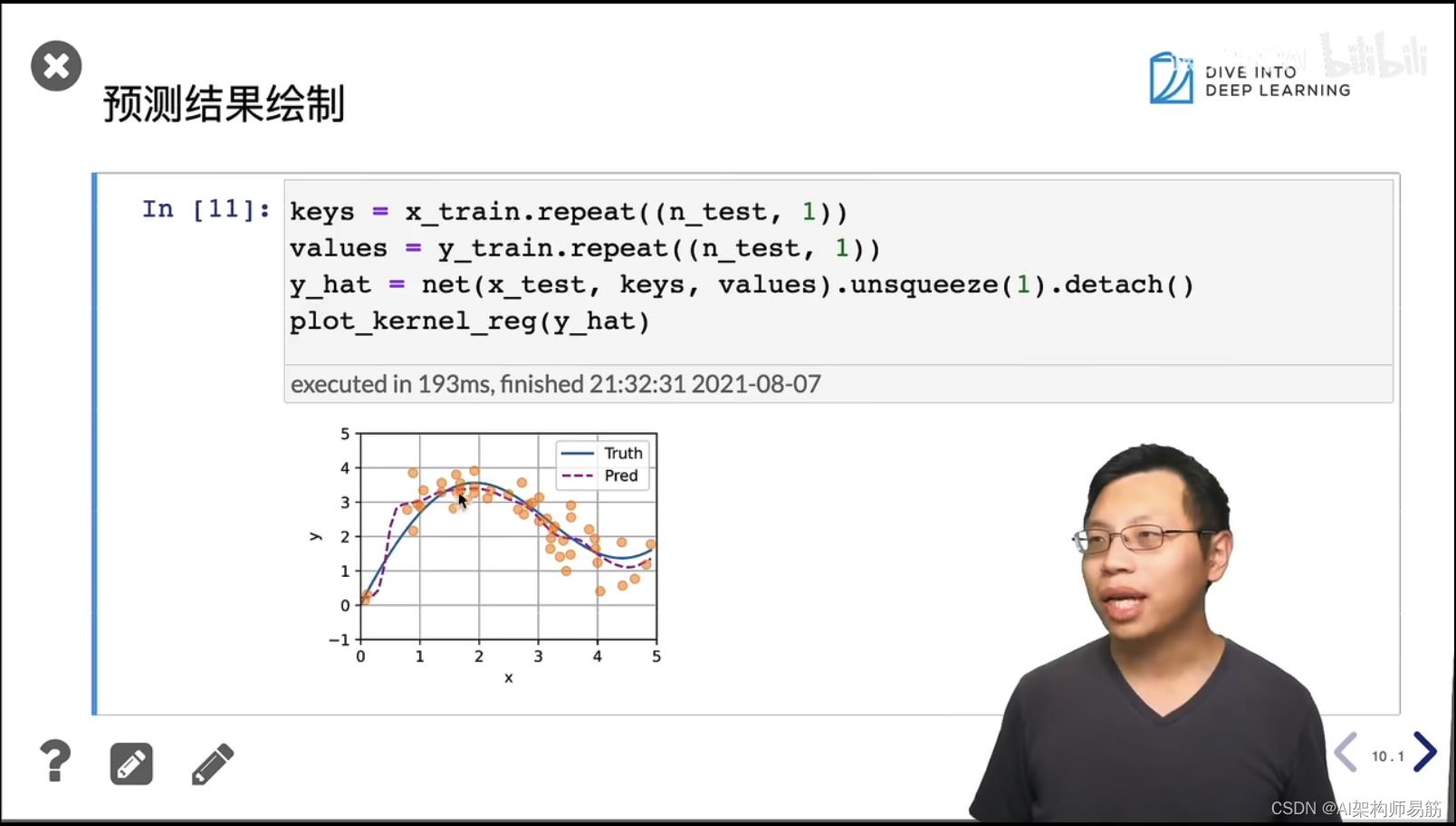

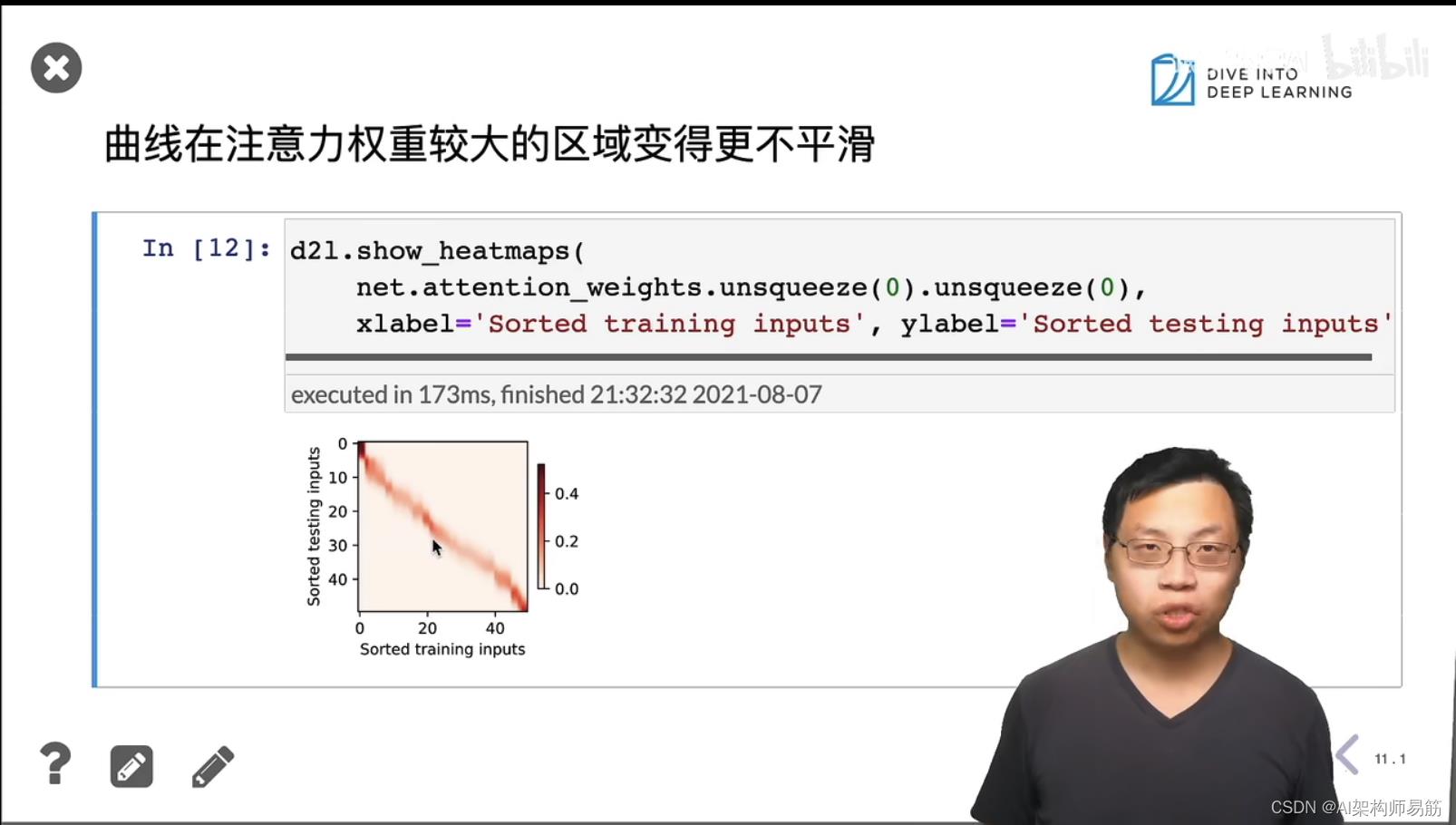

1. 注意力机制 attention

2. 注意力机制 attention 代码实现

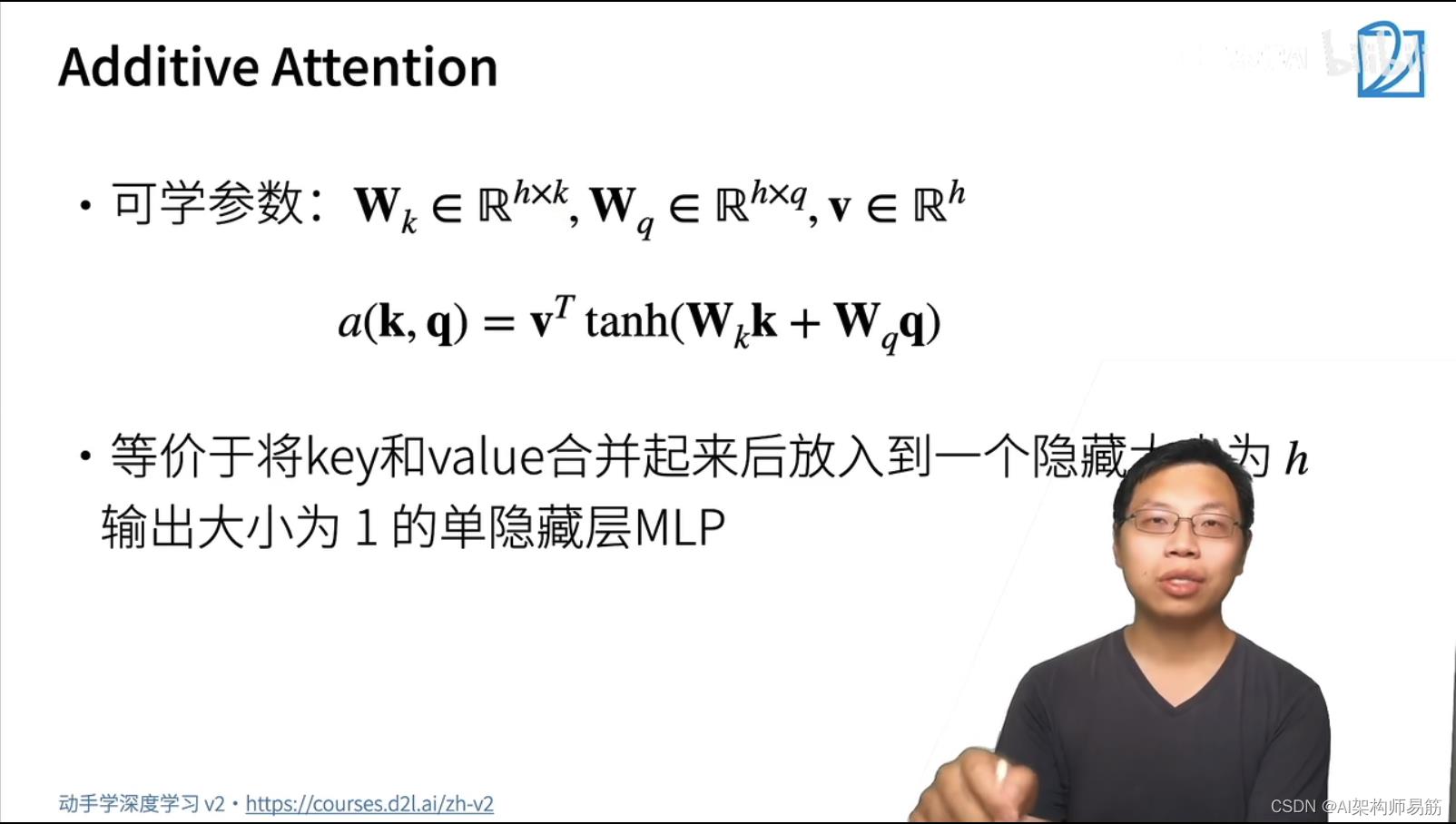

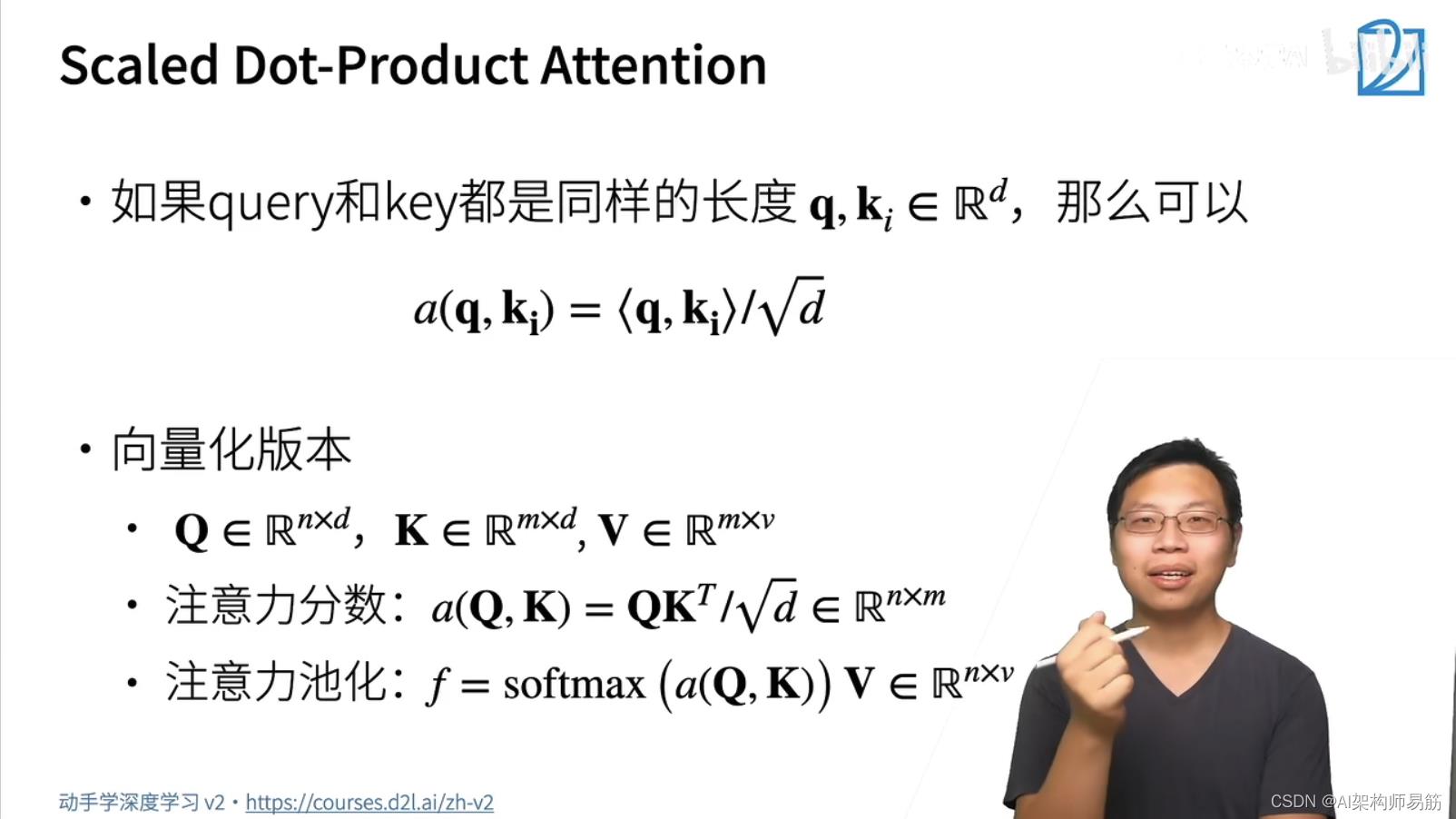

3. 注意力分数

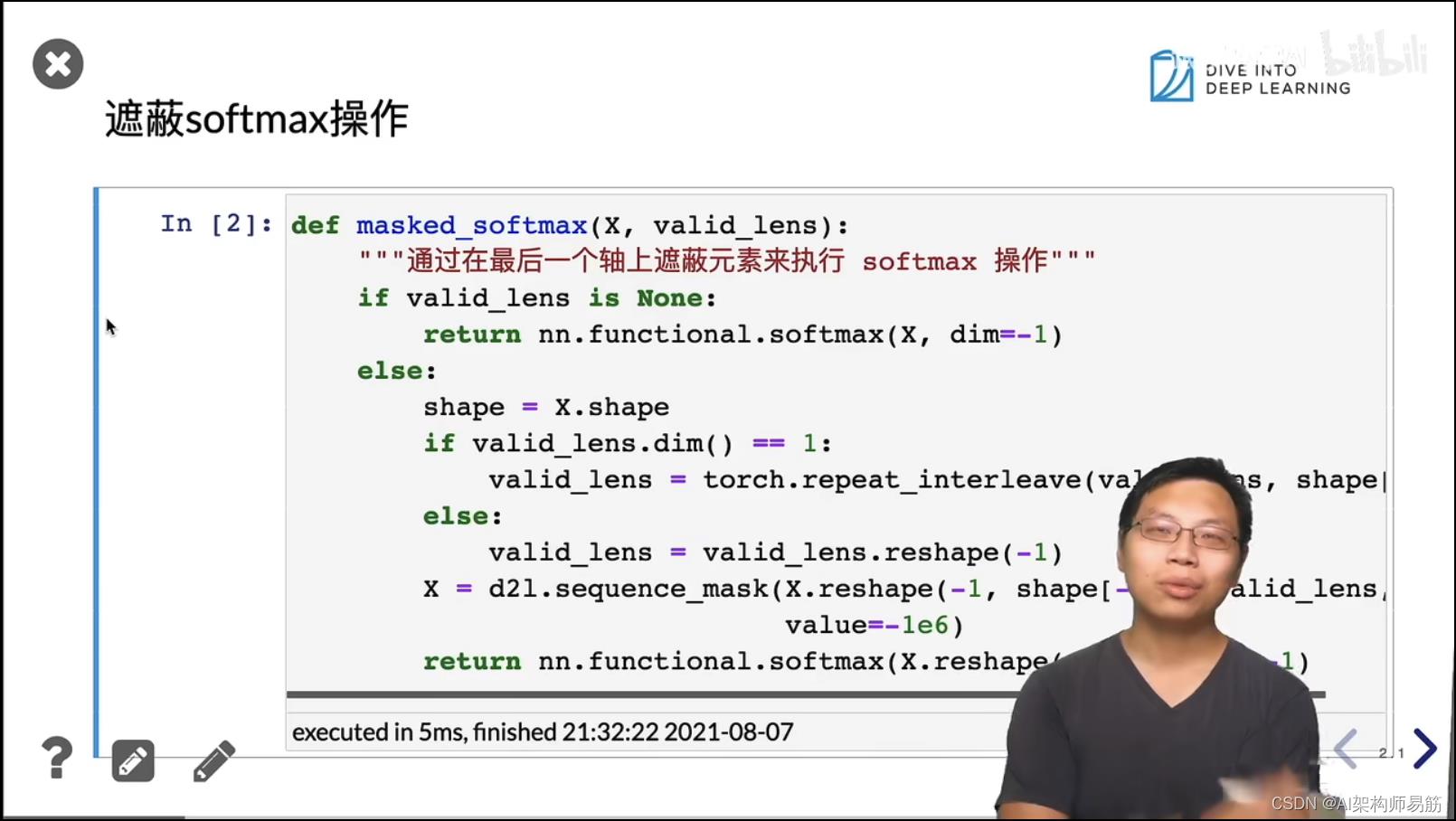

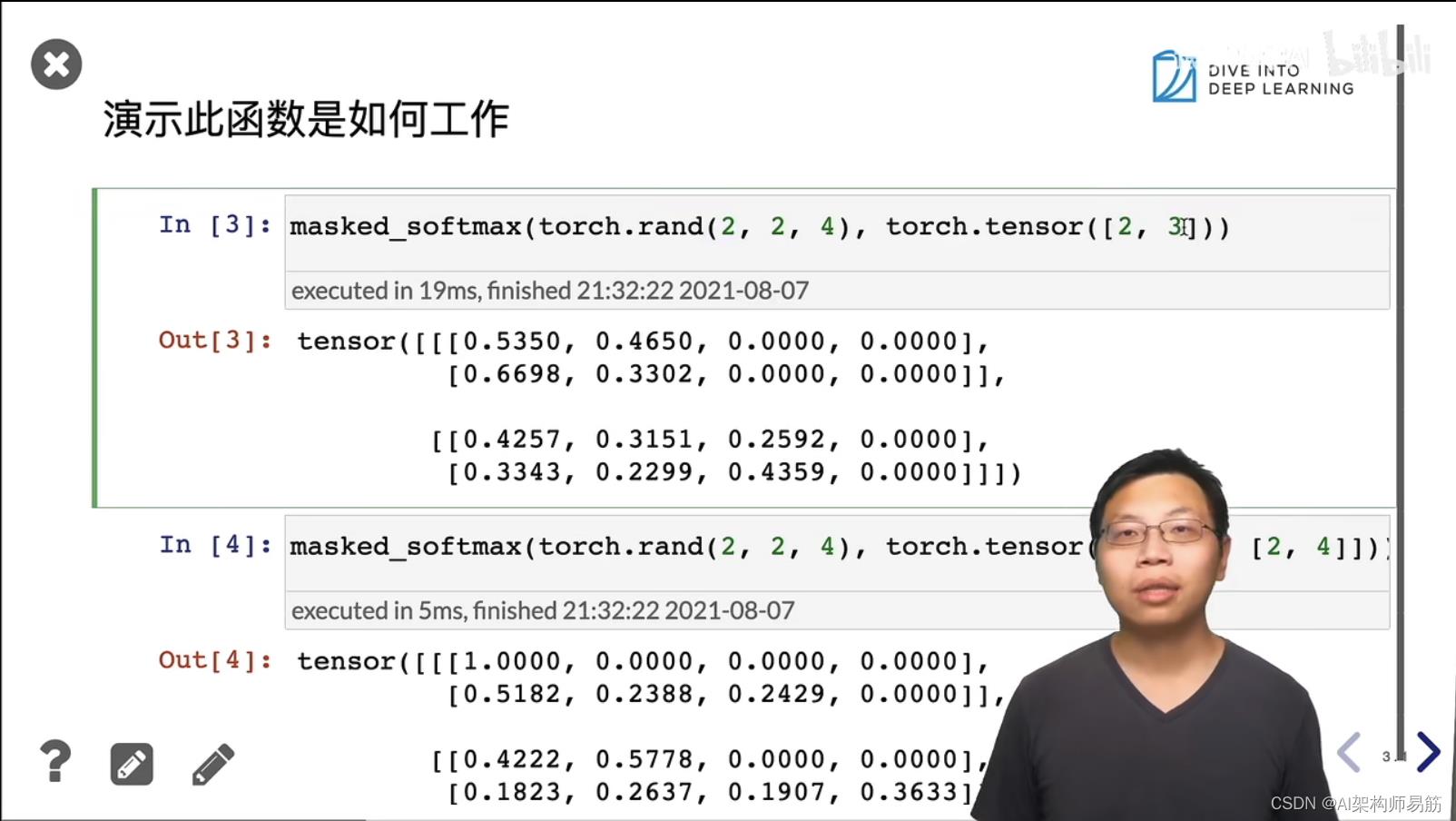

4. 注意力打分函数实现

5. Q&A

-

- masked_softmax() 把填充padding的值,求softmax的时候,padding位置的值都设置为0.

参考

https://www.bilibili.com/video/BV1264y1i7R1?p=1

创作打卡挑战赛

创作打卡挑战赛

赢取流量/现金/CSDN周边激励大奖

赢取流量/现金/CSDN周边激励大奖

以上是关于注意力机制 attention 注意力分数 动手学深度学习v2的主要内容,如果未能解决你的问题,请参考以下文章

Attention使用注意力机制的seq2seq 动手学深度学习v2

Attention使用注意力机制的seq2seq 动手学深度学习v2

自注意力 self attention Transformer 多头注意力代码 Transformer 代码 动手学深度学习v2

自注意力 self attention Transformer 多头注意力代码 Transformer 代码 动手学深度学习v2