Spark单机环境安装

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark单机环境安装相关的知识,希望对你有一定的参考价值。

1.ubantu环境下安装JDK

我的jdk安装在/home/fuqiang/java/jvm目录下,scala,spark都是在此目录下,主要是JDK环境变量的设置

$ sudo gedit /etc/profile

在文档的最末尾加上

export JAVA_HOME=/home/fuqiang/java/jvm/jdk1.7.0_79

export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH

JDK环境变量配置完毕

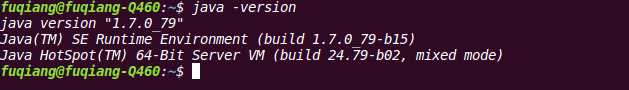

控制台输入

$ source /etc/profile

java -version 出现如下信息,则JDK环境变量配置完毕

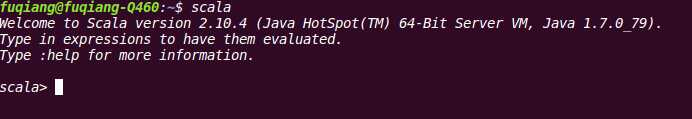

2.Scala环境配置

下载scala,并进行解压,下载的版本是scala-2.10-4

scala环境变量配置

export SCALA_HOME=/home/fuqiang/java/jvm/scala-2.10.4

在PATH中添加SCALA_HOME后结果如下:

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$SCALA_HOME/bin:$PATH

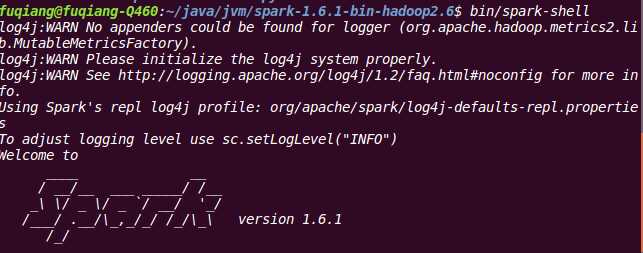

3 spark环境配置

下载spark-1.6.1-bin-hadoop2.6解压

在/etc/profile中配置环境

export SPARK_HOME=/home/fuqiang/java/jvm/spark-1.6.1-bin-hadoop2.6

在PATH中添加SPACK_HOME后结果如下:

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$SCALA_HOME/bin:$SPARK_HOME/bin:$PATH

以上是关于Spark单机环境安装的主要内容,如果未能解决你的问题,请参考以下文章