GRU

Posted 下路派出所

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了GRU相关的知识,希望对你有一定的参考价值。

GRU模型(比LSTM减少了计算量)

LSTM的模型,LSTM的重复网络模块的结构很复杂,它实现了三个门计算,即遗忘门、输入门和输出门。

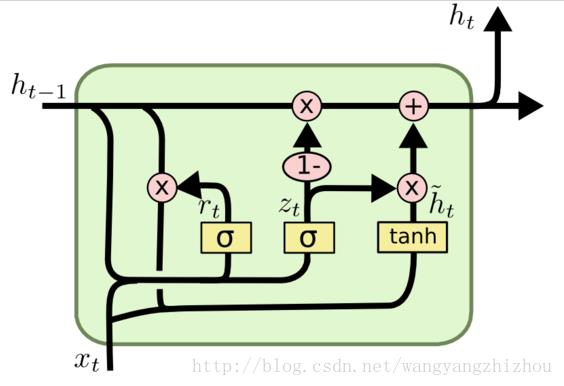

而GRU模型如下,它只有两个门了,分别为更新门和重置门,即图中的Zt和Rt。更新门用于控制前一时刻的状态信息被带入到当前状态中的程度,更新门的值越大说明前一时刻的状态信息带入越多。重置门用于控制忽略前一时刻的状态信息的程度,重置门的值越小说明忽略得越多。

1.重置门Rt的作用:多少上一时刻的信息被遗忘或者输出,更新门:多少信息被附加到上一时刻。

2.Zt的大小是根据上一时刻的状态和这一时刻的输入来决定的,它这里对两个输入有决定作用,第一个是决定当前时刻的的输入多少被附加到上一时刻的状态中去,第二个决定的是上一时刻的状态多少被保留。

3.更新们用到了“1-”,解释为:因为Zt决定了两个流,一个是上一时刻的状态流,一个是这一时刻的输入流,当Zt越大时,说明当前时刻的信息量越大,而经过“1-”以后,1-Zt的值就会很小,那么上一时刻的信息保留的就会越少

目的是为了保留比较重要的信息。

以上是关于GRU的主要内容,如果未能解决你的问题,请参考以下文章

我想为我自己创建的数据集使用 LSTM 实现 GRU。由于我是 python 新手,我不确定如何添加 GRU 层。如何添加 GRU?

pytorch 中的 torch.nn.gru 函数的输入是啥?