AI机器学习-决策树算法-概念和学习过程

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了AI机器学习-决策树算法-概念和学习过程相关的知识,希望对你有一定的参考价值。

1. 概念

决策树是通过一系列规则对数据进行分类的过程,它提供一种在什么条件下会得到什么值的类似规则的方法。决策树分为分类树和回归树两种,分类树对离散变量做决策树,回归树对连续变量做决策树。

分类决策树模型是一种描述对实例进行分类的树形结构。决策树由结点和有向边组成。结点有两种类型:内部节点和叶节点,内部节点表示一个特征或属性,叶节点表示一个类。

直观看上去,决策树分类器就像判断模块和终止块组成的流程图,终止块表示分类结果(也就是树的叶子)。判断模块表示对一个特征取值的判断(该特征有几个值,判断模块就有几个分支)。

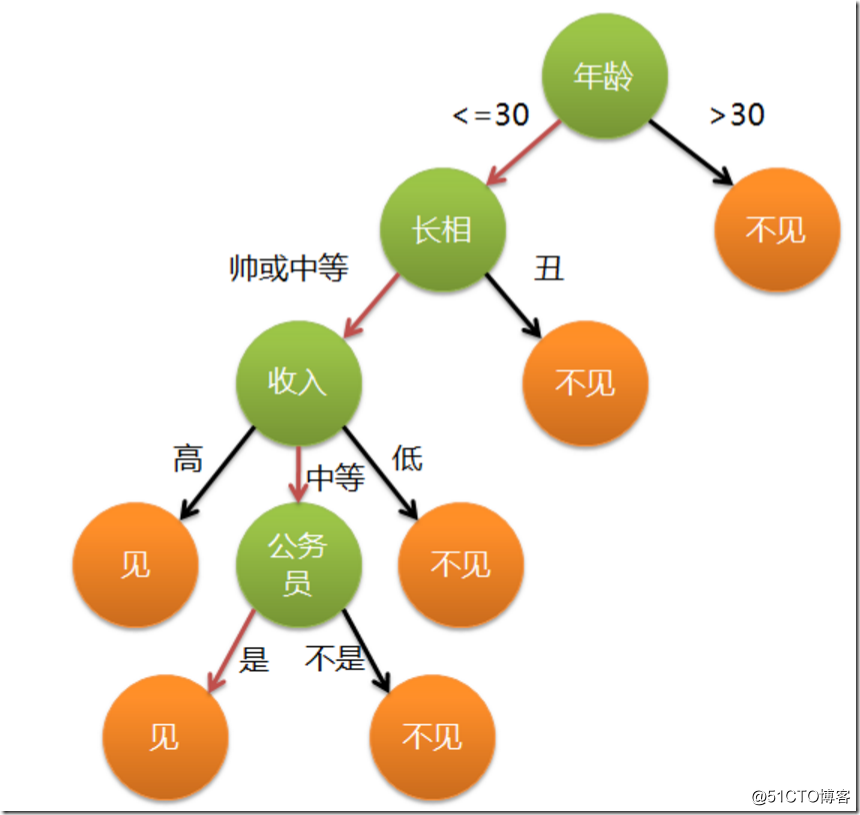

引用网上的一个栗子:

母亲:给你介绍个对象。

女儿:年纪多大了?

母亲:26。

女儿:长的帅不帅?

母亲:挺帅的。

女儿:收入高不?

母亲:不算很高,中等情况。

女儿:是公务员不?

母亲:是,在税务局上班呢。

女儿:那好,我去见见。

用决策树来表示:

作为一个码农经常会不停的敲if, else if, else,其实就已经在用到决策树的思想了。只是你有没有想过,有这么多条件,用哪个条件特征先做if,哪个条件特征后做if比较优呢?怎么准确的定量选择这个标准就是决策树机器学习算法的关键了。

2. 决策树的学习过程

一棵决策树的生成过程主要分为以下3个部分:

特征选择:

特征选择是指从训练数据中众多的特征中选择一个特征作为当前节点的分裂标准,如何选择特征有着很多不同量化评估标准标准,从而衍生出不同的决策树算法。

1、 为什么要做特征选择

在有限的样本数目下,用大量的特征来设计分类器计算开销太大而且分类性能差。

2、 特征选择的确切含义

将高维空间的样本通过映射或者是变换的方式转换到低维空间,达到降维的目的,然后通过特征选取删选掉冗余和不相关的特征来进一步降维。

3、 特征选取的原则

获取尽可能小的特征子集,不显著降低分类精度、不影响类分布以及特征子集应具有稳定适应性强等特点

决策树生成:

根据选择的特征评估标准,从上至下递归地生成子节点,直到数据集不可分则停止决策树停止生长。 树结构来说,递归结构是最容易理解的方式。

剪枝:

由于决策树算法的特性,容易使得对特征的学习过度细分,从而出现分类不准的情况,比如,把某一个特殊特特征当做类别的判断标准,从而把不具有某特殊属性的数据划分到此类别之外。这种情况叫过拟合,英文叫overfitting直译就是过度匹配,也就是匹配太细化,有点过了。要解决这个问题,就要把决策树进行简化,把一些太细化的特性去掉,反应在树形结构上就是去掉一些分支,术语叫剪枝。剪枝技术有预剪枝和后剪枝两种。

更多文章关注微信公众号“挨踢学霸”

以上是关于AI机器学习-决策树算法-概念和学习过程的主要内容,如果未能解决你的问题,请参考以下文章