爬虫基本原理

Posted 娄先生

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了爬虫基本原理相关的知识,希望对你有一定的参考价值。

目录

一、爬虫的定义

一、爬虫的定义

基本上网:

浏览器提交请求->下载网页代码->解析/渲染成页面。

爬 虫:

模拟浏览器发送请求->下载网页代码->只提取有用的数据->存放于数据库或文件中

两者区别:

我们只是爬取对我们有用的数据

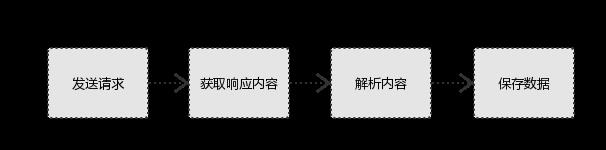

二、爬虫的流程

#1、发起请求 使用http库向目标站点发起请求,即发送一个Request Request包含:请求头、请求体等 #2、获取响应内容 如果服务器能正常响应,则会得到一个Response Response包含:html,json,图片,视频等 #3、解析内容 解析html数据:正则表达式,第三方解析库如Beautifulsoup,pyquery等 解析json数据:json模块 解析二进制数据:以b的方式写入文件 #4、保存数据 数据库 文

三、请求

3.1 请求的定义

Request:用户将自己的信息(浏览器信息,ip,地址,cookie,请求内容等等)

通过浏览器(socket client)

发送给服务器(socket server)

3.2请求的组成部分

#1、请求方式: 常用的请求方式:GET,POST 其他请求方式:HEAD,PUT,DELETE,OPTHONS ps:用浏览器演示get与post的区别,(用登录演示post) post与get请求最终都会拼接成这种形式:k1=xxx&k2=yyy&k3=zzz post请求的参数放在请求体内: 可用浏览器查看,存放于form data内 get请求的参数直接放在url后 #2、请求url url全称统一资源定位符,如一个网页文档,一张图片 一个视频等都可以用url唯一来确定 url编码 https://www.baidu.com/s?wd=图片 图片会被编码(看示例代码) 网页的加载过程是: 加载一个网页,通常都是先加载document文档, 在解析document文档的时候,遇到链接,则针对超链接发起下载图片的请求 #3、请求头 User-agent:告诉它这是浏览器发过来的请求(请求头中如果没有user-agent客户端配置,服务端可能将你当做一个非法用户)务必加上 host cookies:cookie用来保存登录信息 Referer:上次的请求页面,有些网站直接去post的话,会被限制,因为没有带上上次请求的页面地址 一般做爬虫都会加上请求头 #4、请求体 如果是get方式,请求体没有内容 如果是post方式,请求体是format data

四、响应

#1、响应状态 200:代表成功 301:代表跳转 404:文件不存在 403:权限 502:服务器错误 #2、Respone header Location:跳转 set-cookie:可能有多个,是来告诉浏览器,把cookie保存下来 #3、preview就是网页源代码 最主要的部分,包含了请求资源的内容 如网页html,图片 二进制数据等

以上是关于爬虫基本原理的主要内容,如果未能解决你的问题,请参考以下文章