中文词频统计

Posted 肥牛

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了中文词频统计相关的知识,希望对你有一定的参考价值。

中文分词

- 下载一中文长篇小说,并转换成UTF-8编码。

- 使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

- 排除一些无意义词、合并同一词。

- 对词频统计结果做简单的解读。

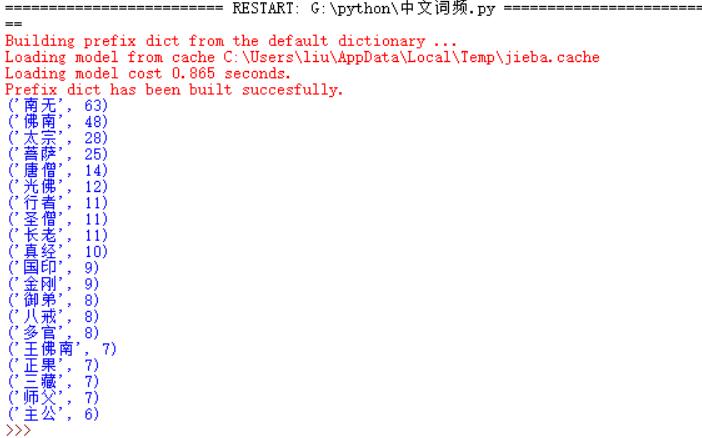

import jieba book=open(\'F:\\\\xiyouji.txt\',\'r\',encoding=\'utf-8\') #读入待分析的字符串 str=book.read() book.close() for i in \',。!、 \\n “ ” ;\': str=str.replace(i,\'\') words=jieba.cut(str) word=set(words) #计数字典 dic={} for i in word: if len(i)>1: dic[i]=str.count(i) str=list(dic.items()) #排序 str.sort(key=lambda x:x[1],reverse=True) for i in range(20): print(str[i])

从词频统计结果出来可以看出此小说是西游记,主要人物有唐僧,八戒等,讲述他们取西经的过程。

以上是关于中文词频统计的主要内容,如果未能解决你的问题,请参考以下文章