随机梯度下降(stochastic gradient descent),批梯度下降(batch gradient descent),正规方程组(The normal equations)

Posted imageSet

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了随机梯度下降(stochastic gradient descent),批梯度下降(batch gradient descent),正规方程组(The normal equations)相关的知识,希望对你有一定的参考价值。

对于一个线性回归问题有

为了使得预测值h更加接近实际值y,定义

J越小,预测更加可信,可以通过对梯度的迭代来逼近极值

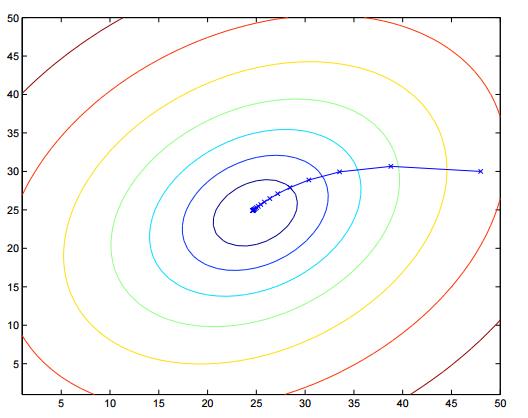

批梯度下降(batch gradient descent)(the entire training set before taking a single step)

随机梯度下降(stochastic gradient descent)(gets θ “close” to the minimum much faster than batch gradient descent)

这里可以看到更详细的解释http://www.cnblogs.com/czdbest/p/5763451.html

也可以通过求J的梯度等于0向量来确定极值

来自吴恩达机器学习

以上是关于随机梯度下降(stochastic gradient descent),批梯度下降(batch gradient descent),正规方程组(The normal equations)的主要内容,如果未能解决你的问题,请参考以下文章

随机梯度下降法(Stochastic gradient descent, SGD)

随机梯度下降(Stochastic gradient descent)和 批量梯度下降(Batch gradient descent )的公式对比

随机梯度下降收敛(Stochastic gradient descent convergence)

随机梯度下降(stochastic gradient descent),批梯度下降(batch gradient descent),正规方程组(The normal equations)

随机梯度下降(Stochastic gradient descent)和 批量梯度下降(Batch gradient descent )的公式对比实现对比

随机梯度下降(Stochastic gradient descent)和 批量梯度下降(Batch gradient descent )的公式对比实现对比[转]