『科学计算_理论』最大似然估计

Posted 叠加态的猫

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了『科学计算_理论』最大似然估计相关的知识,希望对你有一定的参考价值。

一、先验条件

通俗来讲,最大似然估计,就是利用已知的样本结果,反推最有可能(最大概率)导致这样结果的参数值。

重要的假设是所有采样满足独立同分布。

二、最大似然法

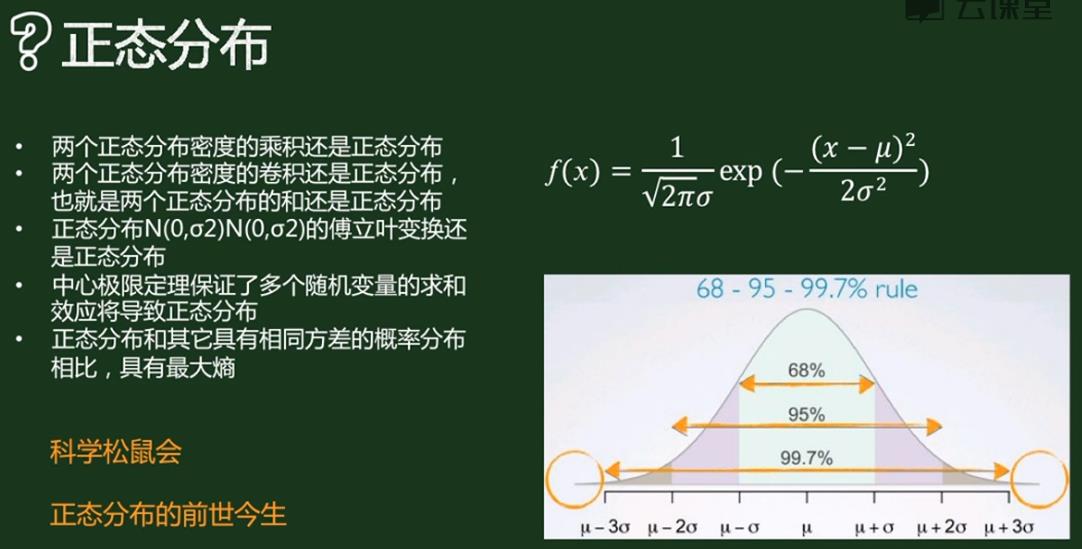

假如我们有一组连续变量的采样值(x1,x2,…,xn),我们知道这组数据服从正态分布(最大似然法特点,我们已知模型,求解的是模型的具体参数),标准差已知。请问这个正态分布的期望值为多少时,产生这个已有数据的概率最大?

P(Data | M) = ?

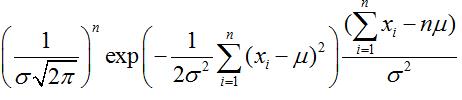

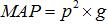

根据公式

![]()

可得:

对μ求导可得

,

,

则最大似然估计的结果为μ=(x1+x2+…+xn)/n

由上可知最大似然估计的一般求解过程:

(1) 写出似然函数;

(2) 对似然函数取对数,并整理(目的是化似然函数的连乘为连加,简化运算);

(3) 求导数 ;

(4) 解似然方程

注意:最大似然估计只考虑某个模型能产生某个给定观察序列的概率,而未考虑该模型本身的概率,这点与贝叶斯估计有所区别。

最大似然法和最小二乘法

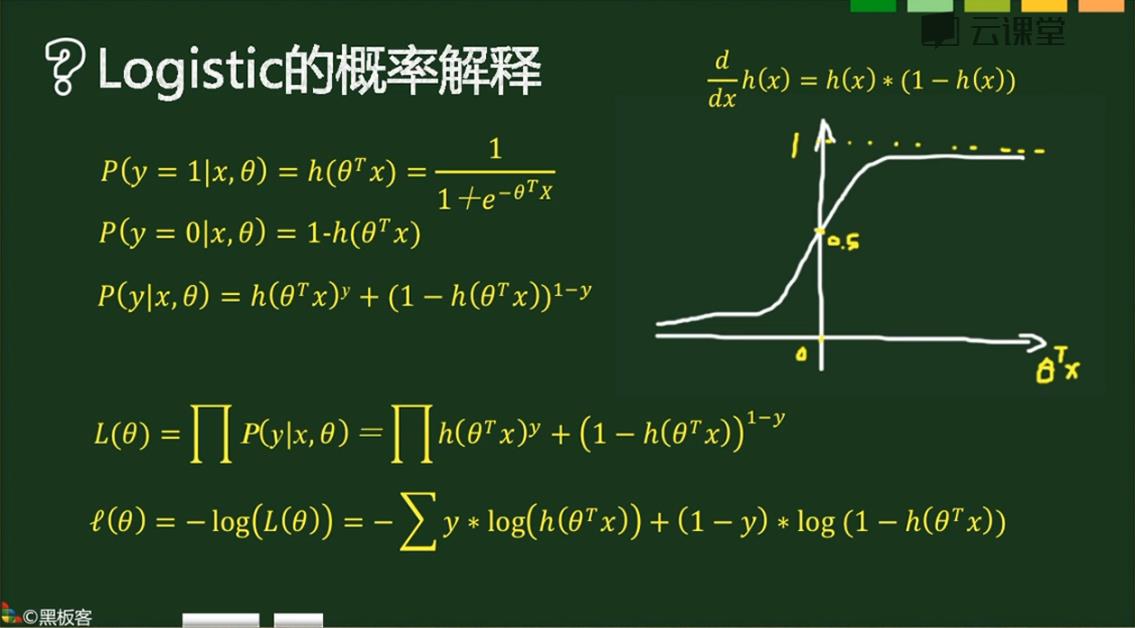

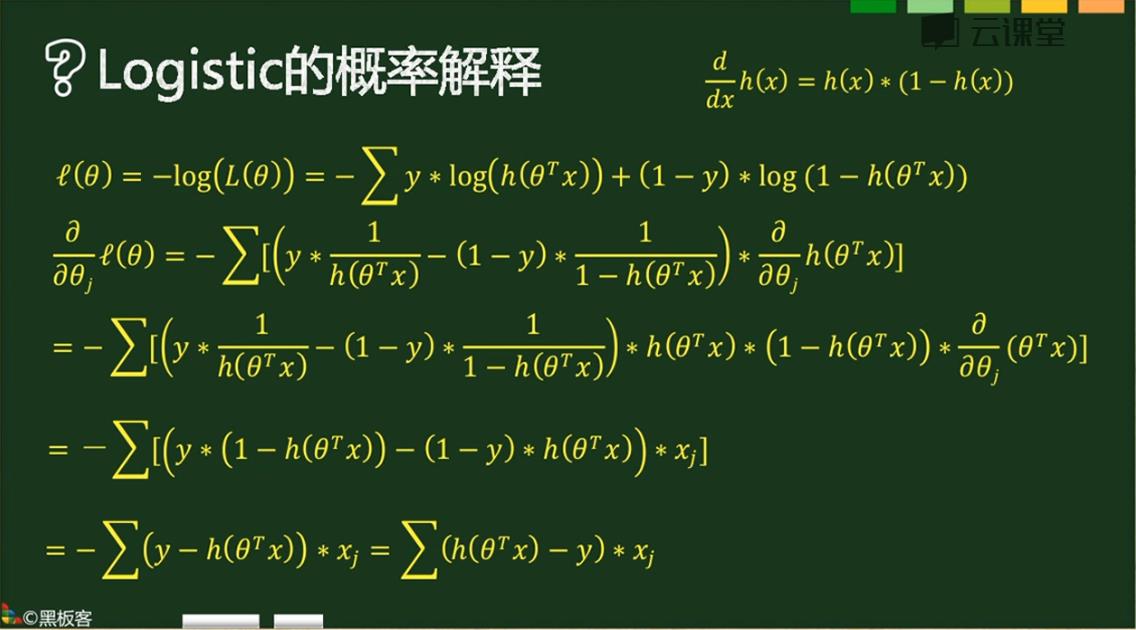

最大似然法和Logistic回归

这是个二分类模型,意义是在该参数系统下y=1的概率,补集是y=0的概率。

最后希望最小化(绝对值最小化)的形式如上,和最小二乘法有点类似。

三、最大后验概率

最大后验估计是根据经验数据获得对难以观察的量的点估计。

与最大似然估计类似,但是最大的不同时,最大后验估计的融入了要估计量的先验分布在其中。故最大后验估计可以看做规则化的最大似然估计。

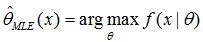

首先,我们回顾上篇文章中的最大似然估计,假设x为独立同分布的采样,θ为模型参数,f为我们所使用的模型。那么最大似然估计可以表示为:

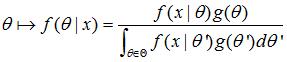

现在,假设θ的先验分布为g。通过贝叶斯理论,对于θ的后验分布如下式所示:

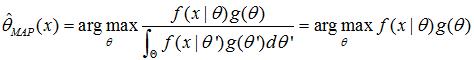

最后验分布的目标为:

注:最大后验估计可以看做贝叶斯估计的一种特定形式。

举例来说:

假设有五个袋子,各袋中都有无限量的饼干(樱桃口味或柠檬口味),已知五个袋子中两种口味的比例分别是

樱桃 100%

樱桃 75% + 柠檬 25%

樱桃 50% + 柠檬 50%

樱桃 25% + 柠檬 75%

柠檬 100%

如果只有如上所述条件,那问从同一个袋子中连续拿到2个柠檬饼干,那么这个袋子最有可能是上述五个的哪一个?

我们首先采用最大似然估计来解这个问题,写出似然函数。假设从袋子中能拿出柠檬饼干的概率为p(我们通过这个概率p来确定是从哪个袋子中拿出来的),则似然函数可以写作

由于p的取值是一个离散值,即上面描述中的0,25%,50%,75%,1。我们只需要评估一下这五个值哪个值使得似然函数最大即可,得到为袋子5。这里便是最大似然估计的结果。

上述最大似然估计有一个问题,就是没有考虑到模型本身的概率分布,下面我们扩展这个饼干的问题。

假设拿到袋子1或5的机率都是0.1,拿到2或4的机率都是0.2,拿到3的机率是0.4,那同样上述问题的答案呢?这个时候就变MAP了。我们根据公式

写出我们的MAP函数。

根据题意的描述可知,p的取值分别为0,25%,50%,75%,1,g的取值分别为0.1,0.2,0.4,0.2,0.1.分别计算出MAP函数的结果为:0,0.0125,0.125,0.28125,0.1.由上可知,通过MAP估计可得结果是从第四个袋子中取得的最高。

上述都是离散的变量,那么连续的变量呢?假设 为独立同分布的

为独立同分布的 ,μ有一个先验的概率分布为

,μ有一个先验的概率分布为 。那么我们想根据

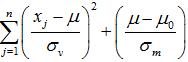

。那么我们想根据 来找到μ的最大后验概率。根据前面的描述,写出MAP函数为:

来找到μ的最大后验概率。根据前面的描述,写出MAP函数为:

此时我们在两边取对数可知。所求上式的最大值可以等同于求

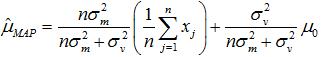

的最小值。求导可得所求的μ为

以上便是对于连续变量的MAP求解的过程。

在MAP中我们应注意的是:

MAP与MLE最大区别是MAP中加入了模型参数本身的概率分布,或者说,MLE中认为模型参数本身的概率的是均匀的,即该概率为一个固定值,而MAP给出了不同的划定。

参考:

以上是关于『科学计算_理论』最大似然估计的主要内容,如果未能解决你的问题,请参考以下文章