AI Gossip

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了AI Gossip相关的知识,希望对你有一定的参考价值。

本文作者:七牛云人工智能实验室-林亦宁

原文地址:https://zhuanlan.zhihu.com/p/26168331

什么是智能

根据传统的观点,智能来源于语言。只是问题在于,人类的语言不是世界上第一种语言。《人类简史》提到,青猴就有不同的语言来表达不同的意思。比如“老鹰来了”和“狮子来了”就是两种表达接近而含义不同的声音。研究人员把“老鹰来了”放在一群青猴听,猴子们立刻停下各种动作,恐惧地望着天空。而播放“狮子来了”,猴子就纷纷往树上爬(科学家们都是没有同情心的家伙)。看到了吧,猴子对语言有明确的反应,它们能灵巧地运用不同的语言或者音节表达不同的意思,并能准确地相互传递。

所以说,如果人类的智能在于语言的话,那么人的语言有什么优越性呢?还是这本书提到了,使得人类语言与众不同的,不是描述“老鹰来了”,“狮子来了”这类周围世界信息的能力,而是描述人类社会信息的能力。这是什么能力呢?

八卦!八卦的能力对于人类进行社会协作至关重要,可以说是在残酷世界里人类部落生存和繁衍的关键。为什么呢?因为八卦的能力能够告诉我们这个部落里谁和谁关系亲密,谁讨厌谁,哪个人靠谱,谁的老婆不能睡。据说在7万年前,我们的祖先能够靠这种技能八卦数个小时之久。千万不能小看八卦能力,这个能力是使得人类部落的规模能够扩大的关键因素。据说我们的祖先智人在 10 万年前走出东非大草原跟尼安德特人打了一架,然后被干回了东非老家。可能是智商比不过别人,也可能是块头没人家大,或者纯粹是人家有主场优势... 然而再过了 3 万年,不知道为什么掌握了“八卦”这一核心科技,再次出征亚欧大陆,就把其它邻居表亲都干没了。

为什么呢?因为八卦使得智人的协作能力和部落规模扩大了数倍。相当于本来大家都是差不多大的小公司,每天出门大家大眼瞪小眼,谁也奈何不了谁,反正市场也大,老死不相往来。然后突然有一天某小公司来了个哥们,读过MBA,管理能力比人家强大了一截;然后他开始蹭蹭蹭地搞兼并收购,一下兼并了自己国内的数十家公司,然后轻松进入全球市场,轻松打垮国际小公司。这是一种维度打击。OK,那么通过八卦搞兼并,能够把公司扩张到什么规模呢?社会学家的研究表明靠八卦能力能够维持的关系规模大约是150 人。这点到了今天也基本没有改变。比如我们七牛,在 100 多号人的时候,管理轻描淡写,招到靠谱的人做靠谱的事,其乐融融天天向上;而现在到了 500 多人的时候,CEO 就开始研究管理了,简直比写代码还有趣呢!

显然,150 个人的部落距离今天我们人类社会的风貌还是相去甚远。如果停留在这个层次,今天的地球可能是无数个小部落,可能跟我们今天看到的猩猩们的社会没有太本质的区别。而今天这样形成一个个的国家,民族,还需要智能或者语言的第三个层级的飞跃,就是传达关于虚构概念的信息。也许这才是人与其它物种的最大的区别,人类是这个星球上唯一会相信虚构概念的物种。事实上构成我们今天社会稳定、推动世界发展的都是人类共同定义的一些虚构的概念,宗教、国家、公司、金钱、道德... 我们对这些非物质的概念深信不疑,建立起大量陌生人之间的合作关系;建立起了国家,建立了宗教;我们组建起数十万人的公司,我们兴起数百万人的战争,都是因为我们坚信这些虚拟的概念,我们能相互传达和理解这些虚拟概念。

什么是人工智能

官方有个说法,人工智能是一个发展中的学科。其实潜台词是,没有非常精确的对人工智能的描述。这个问题,搬个板凳看神仙吵架也是蛮有意思的。

图灵测试

首先看被称为“人工智能之父”的图灵怎么看这个问题。图灵获得这个称号的很大的原因在于写了一篇论文《计算机器与智能》。在开篇的“Can Machine Think?”里,他提出了著名的图灵测试:如果在一个回答游戏中,机器能够骗过问问题的人,使得对方觉得回答问题的是人而不是机器,那么就认定这个机器是有智能的。

所以图灵也不乐意正面回答这个问题,他也是从一个实验结果来判断说是不是有智能。在图灵那一时代的人看来,人类的智能最伟大的能力在于对抽象符号的处理。比如“听”和“说”,就是我们用恰当的语法规则对被称为“词”的概念符号的处理。视觉,我们是用概念符号代表物体以及物体的位置、名称和其它属性。像能下棋的AlphaGo就跟好理解了,处理的无非是棋子代表的不同属性和位置的概念符号... 而计算机,我们恰好正是发明它来处理抽象符号的!所以将智能的能力简化为抽象符号的处理(也就是计算)之后,就可以套入图灵机的理论了:人工智能,无非也就是一台图灵完备的机器就能干的事,对吧?所以,不必研究人脑,让我们研究算法吧!

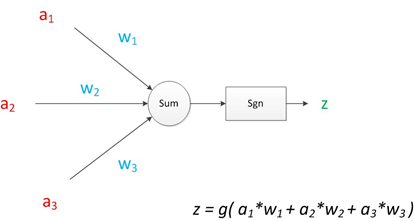

神经元的数学模型

这个理论在今天看来不太靠谱,因为今天我们仍然为了深度学习对大脑的模拟而疯狂。但是当时却是另一幅光景。Warren McCulloch 和 Walter Pitts 在 1943年 提出的神经元的数学模型,更是给这个思路提供了理论依据。该模型认为,大脑的神经元的工作方式跟数字电路中的逻辑门是一样的。如图,就是一个多输入线性加权,然后通过一个符号函数输出 0 或 1。这个基本单元跟逻辑门是一样的。这个模型现在已经被广泛接受,我好像没看到过有人针对这个问题提出过有说服力的质疑。

而我们知道,不论是 CPU 还是内存,现在计算机的所有芯片恰好也是这样的逻辑门构成的。所以你看,人脑和计算机底层的工作方式是一致的,它们的工作内容也是一样的 - 处理抽象符号。这下就更多的人觉得没有必要研究大脑了!他们觉得应该把精力放在设计更好的算法和理论的研究证明上。人脑有除了理性之外还有太多太多的主观情感,本质上就是个混沌系统。研究混沌系统,对人工智能毫无意义啊!

中文屋实验

自然这个问题也有唱反调的。1980年代,UC Berkley 的著名哲学教授 John Searle 专门设计了一个“中文屋实验”来打脸图灵测试。

实验是这样的:让一个只懂英语的人坐在一个房间里,手头有纸笔还有一本指令手册,介绍如何处理汉字。这里的处理只涉及复制、删除、插入、重排等语法指令,而并不描述任何汉字的含义。外面的中文通向里面递进中文写成的问题,里头的人按手册的说明,将中文符号组合到一起写到纸上,并最后按指令将纸条递出去。最后别人再问中文通:这个人会不会中文?答曰“懂!”

而实际上,屋里的人(CPU),不懂中文;指令手册(人工智能软件),只是一堆正则,没有任何汉字的含义,也不懂中文。在整个过程中我们看不到计算机的智能和理解力,但是这个组合通过了图灵测试,对吧?

John Searle 的意思的,无论怎么设计这个程序,计算机都不可能具有理解力,也就不可能具有智能。他说“我也不知道智能是什么,但不论智能是什么,计算机都不具备”。

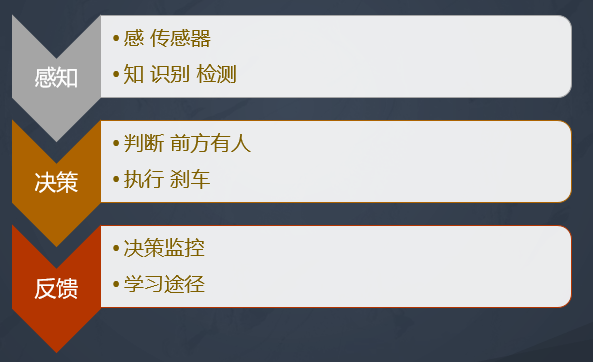

人工智能的三个层次

以上是关于“什么是人工智能”的几个重要思考,观点南辕北辙,此之谓“发展中的学科”。就跟天朝的南海钓鱼岛等等问题一样。吵吵吵到最后,结论只能是“搁置争议,共同开发”。这个问题还有有很大的哲学属性。多思辨有好处,但囿于争论就没有意义。我们从业人员,可以做一些更加实际的工作。比如给人工智能问题分分层级:

最底层的层次是“感知”,又可以细分为“感”和“知”两个层面。所谓“感”,就是将外部输入转换为大脑能够接受的信息;如果用计算机的语言来说,就是传感器。视觉的传感器是摄像头,听觉的传感器是麦克风,触觉的传感器可以是压力感应器等等。计算机能接受的传感器信号是整数或浮点数,不论是摄像头还是麦克风,最终是要通过模数信号转换形成一串无聊的数字才能被计算机所接受;大脑也是一样,不论是视觉信号还是听觉触觉,都需要转换成生物电信号进入神经元,才能被感知。而所谓“知”,对计算机来说就已经比较费劲了。看到一个脸知道它是脸,看山是山看水是水,这个叫做“知”;听到一串声音,能辨认出它是“梦幻曲”,还是情人在喊你,这也是“知”;摸到一个圆圆的东西,知道它是鸡蛋,这也是“知”。你一定已经发现,这里的“知”,已经包含了基本的鉴别、判断、语音到文字的转换等过程。

第二个层次是“决策”。决策是在已知信息的基础上进行更高层次的判断。比如你走在街上,看到有个人向你跑来,你预测他的轨迹并不与你相交,不会撞上你;再看他体型瘦小,速度不快,哪怕要撞上你也有足够的时间和能力反应并自保;走近了看到此人手捧鲜花,眼神放光,于是你判断他是沉浸在欢愉的爱情之中,断不会对你造成生理上的威胁。在不到一秒钟的时间内,你已经根据“感知”层得到的各种信息,做出了三次以上的判断,并且这个判断,决定了你的行为,是避让?还是迎上?或者忽略这个人。

第三个层次是“反馈”。为什么反馈是一个独立的层次?反馈有两个重要的作用,一方面它是构成有执行能力的人工智能系统的重要独立环节。对于机器人系统来说,可以认为反馈就是执行机构的监控系统。无人驾驶的汽车执行刹车指令时,它需要反馈系统来传达刹车是否成功。另一方面,反馈也是学习的重要手段:通过学习,达到人工智能,或者说达到某种程度的智能,靠的就是反馈,这是它凌驾于感知和决策之上的原因。我们人脑学习所有知识也都是通过“预测 - 反馈”的路径进行的。走进房间,看到我这个人,你脑子里会先浮现出这个人的样子,然后再与你看到的验证。眼睛是眼睛,鼻子是鼻子,哦这是我认识的那个人。如果长眼睛的位置长了两个鼻子,那你一定会惊觉,然后你脑子里一些原本并不活跃的神经元开始变得活跃起来,开始学习遇到的新情况。我们脑子进行“预测 - 反馈”的频率比你能意识到的要多的多,多到无时不在进行,这与我们所感受到的和我们传统的概念不一样。我们的大脑通过感受到的事物与预测的模式之间的匹配来学习。我们靠预测去泛化,用反馈来收敛。这是人脑学习的原理,也是我们设计人工智能的重要方式。

人工智能的发展

篇幅太长,譬如朝露。聊今天最后一个八卦,我们谈一点历史。

达特茅斯会议

如果要谈人工智能的起点,一般都会提到1956年的达特茅斯会议,这个会议现在公认为是人工智能的研究起点。原因有二。一是会议的召集者麦卡锡给这个活动起了个名字叫“人工智能夏季研讨会(Summer Research Project on Artificial Intelligence)”。这是“Artificial Intelligence”这个词第一次出现在大众的视野中。二是当时参会的好多年轻人,后来都成了人工智能界的泰山北斗。简单介绍六位重量级人物:

麦卡锡是会议的召集者,当时是达特茅斯学院数学系的助理教授。后来发明了LISP语言。

明斯基,当时是普林斯顿的数学博士,论辈分麦卡锡是他的师叔。他的博士论文做的是神经网络,他设计了第一台能够自我学习的人工神经网络计算机,他建立了MIT的人工智能实验室,他还发明了头戴式显示器(VR头盔)。他是公认的人工智能奠基人之一。他有个比他小一岁但是比他早4年博士毕业的师兄更加出名,就是因为“博弈论”获得诺贝尔经济学奖的纳什。对!就是“美丽心灵”电影的主人公纳什。

塞弗里奇是模式识别的奠基人,写了第一个可工作的AI程序。他是维纳(就是我们上学时候学的控制论里的那个维纳滤波的维纳)最喜欢的学生,他跟提出神经元数学模型的Warren McCulloch是同事。

克劳德 香农,信息论的创始人。这种和爱因斯坦、图灵一个级别的大神应该不用多加介绍了,我们今天生活的手机、互联网全都是他创立的信息论的功劳。他参会的时候已经是贝尔实验室的大佬了,当时麦卡锡和明斯基都曾经在贝尔实验室当香农的小弟。就跟今天我们开什么会都想花大价钱请Hinton,Yann LeCun来当重磅嘉(花)宾(瓶)一个道理。

纽厄尔和西蒙(Herbert Simon)他们创立了卡内基梅隆大学(CMU)的人工智能实验室。搞计算机和搞机器人的都知道这个江湖地位了。他们俩开创了人工智能的符号流派。所谓符号主义是人工智能的一个重要流派,它的核心思想是用逻辑推理的法则,从公式定义出发推演整个理论系统。他们希望人工智能能像经典力学领域的牛顿三定律一样优雅,用三个公式解决经典力学的一切问题;能像电磁场领域的麦克斯韦方程组一样优雅,用四个公式解释电磁场领域的一切问题。只能说,“天行有常,不为尧存,不为桀亡”。这个世界的发展还是跟他们的想象不一样,今天我们热衷神经网络,这个流派已经没有太多声音了。

顺便提一句,人工智能的另外两个流派直到今天仍然非常重要:分别是行为主义和连接主义。行为主义起源于控制论,鼻祖就是那个维纳。控制论以前主要研究的是导弹的飞行轨迹控制、化学过程控制这类复杂的多变量复杂系统的优化问题。当它把魔爪伸入人工智能领域时,主要研究如何模拟人和控制过程中的智能行为。人工智能领域中的机器人控制领域就是它的大本营。也就是人工智能三个层次中的“执行”部分。

也幸好行为主义的主要战场是“执行”层,所以在今天神经网络大行其道的时候还能保留一小块阵地而未沦陷。不像符号主义基本上已经溃不成军了。没错,最后一个也就是今天最重要的一个流派,就是连接主义。各位看官一定已经猜出来了,连接主义流派的领衔主演就是今天的当红炸子鸡 - 深度神经网络。

当当当,主角正式登场。

有位著名的爱唱歌的老板的歌是怎么唱的来着,“怎么大风越狠,我心越荡。。。”

你看深度神经网络今天风光无限,但是这半个多世纪可不是这样走来的。看过了世事沉浮,或许你会对深度神经网络的未来有那么一丝担忧。为什么古人要“以史为镜”,因为历史能给你提供辽阔的视角:眼看他起高楼,眼看他宴宾客,眼看他楼塌了。

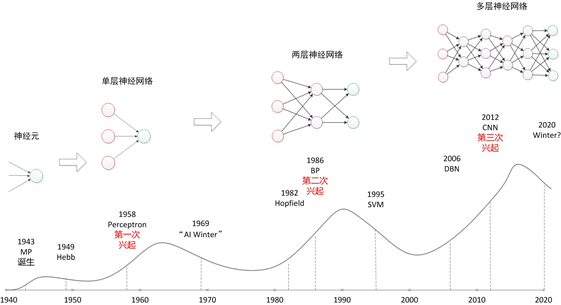

简单地说,开始是Warren McCulloch和Walter Pitts提出了神经元的数学模型。

然后一个叫 Rosenblatt 的年轻科学家提出了一个叫“感知器”的两层神经网络,并演示了一下这个网络能学习识别简单的图像。1950年代的人民像今天的人民一样单纯善良,纷纷觉得神经网络好强大(AlphaGo好强大),智能的时代来到了,人类马上要被机器取代了!于是企业和军方都大力资助人工智能项目,第一次高潮来到了!

这其实也不难理解,1950年代是冷战刚开始的时候,美苏双方好多好多核弹头对着对方。我们的星球随时可能毁灭几十遍。所以军方对科技的狂热是我们今天难以想象的。但是实际上从我们今天的角度看,这个感知器只能做简单的线性分类任务。于是大量人力财力投入了几年之后仍然没什么进展。终于耿直的明斯基看不下去了,站出来说“你们别闹了,别不把钱当钱了”。1969年,他写了一本书叫《Preceptron》,他用数学证明了感知器连简单的异或问题都解决不了。大家纷纷表示不忿,但是无力反驳,纷纷转向其它领域,比如生化人... 这是第一次人工智能也是神经网络的第一次寒潮。

然后到了1986年,深度学习的鼻祖 Hinton 出马了。他提出了两层神经网络就能解决异或问题,而且提出了反向传播算法来解决了网络的计算。然后大家惊喜地发现,一层的感知器不够牛逼但是二层的神经网络很牛逼啊,可以逼近各种函数,还可以做图像识别自动驾驶呢!Magnificent!于是大家又开心地进入了这一领域。金钱、人才、美女都再次投入了这一领域。

但是很快大家发现了新的问题,网络一大,很难训练很难优化啊...直到鄙人上大学那会,介绍神经网络的定语还是“调参困难”。

恰好这时,另一位大神 Vapnik 提出了一种叫做支持向量机(SVM)的算法,老先生对神经网络深恶痛绝,声称发明SVM就是为了干死神经网络的(一言不合就发明新算法,好任性)。这种方法的自动学习能力确实要比当时的神经网络好,于是机器学习类的算法迅速成为主流。神经网络再次进入低谷。但是这次,人工智能仍然以自己的节奏前行着。

历史的车轮滚滚向前,到了 2006 年,深度学习的鼻祖 Hinton 憋了20年,憋出了一个大招 - 深度置信网络(你不用管置信不置信,它就是神经网络)。不是调参困难吗?他提出了两个方法降低训练难度,一个是预训练加微调,一个是逐层优化。有了这两个宝贝,网络层数可以大幅增加,两层增加到两百层,不在话下!然后Hinton还玩了个小心思,他怕“神经网络”招人恨(到底怎么得罪人了),被拒稿,起了个名字叫深度学习(大神当年也是小媳妇~~~)。

虽然这篇文章发在了Science上,但是仍然没有引起大家的重视。老人家生气了,带着学生搞语音,还搞 CNN,亲力亲为参加 ImageNet 竞赛。2012年的时候(为什么是12年,因为06年没有ImageNet,哈哈哈),他们的参赛结果直接超越第二名10个百分点以上(74% vs 85%)。这下大家不淡定了。纷纷开始研究为啥你的算法这么牛逼啊。加上这个时候大家纷纷玩开源,老人家也赶时髦,开源了一把。结果人家说“你的程序里有bug”。一看真的有bug,问题是有即使bug,效果还比人家好10个点。算法鲁棒性好成这样,这让人如何是好...

再后来的故事大家都知道了,无非是yesterday once more啦~ 人工智能的时代来到了啦,人类马上要被机器取代了啦,AI科学家的年薪赶上C罗梅西了啦...

结语

聊了好长的八卦。学术圈的八卦其实也挺多(这还是笔者做了滤波,放开了还能再聊一天一夜)。我们看学术圈的八卦就像小时候看希腊神话的感觉一样。小时候看希腊神话感觉这些神跟中国神话中的神仙们干的简直不是同一份职业!中国神话中的神仙都是脸谱化的,好的坏的,泾渭分明。而希腊神话里的神,有偷看姑娘洗澡的,有搞大人家肚子的,有偷汉子的,还有无照驾驶开车失控摔死自己的...反正就没有一个正常的。直到长大了我才开始慢慢体会了这叫人本主义...

我们看学术圈大神们的感觉也是一样,抛开头脑发达与否不谈,他们的生活也是鸡零狗碎,跟那些A睡了B的老婆,C嫁了D再离婚改嫁E最后跟F上床等摇滚乐队故事没什么区别。他们的青春时代正是摇滚乐,抽大麻,反越战,要做爱不要作战。所以说,有时决定你能走多远的,不是你生活的苟且与琐碎,而是你是否志存高远,能不能持续追求你的兴趣所在。也许你对今天自己做的事情并不满意,但如果你以宏大的时间跨度去看,只要志存高远,思路清晰,脚踏实地,或许你就成为了某个领域的奠基人!

本文出自 “七牛” 博客,请务必保留此出处http://7741292.blog.51cto.com/7731292/1913325

以上是关于AI Gossip的主要内容,如果未能解决你的问题,请参考以下文章

AI 最新突破集锦 AI的瓶颈和进展 AI控制核聚变 AI预测蛋白质3D结构 Alpha Fold2 AI证明数学公式 自动驾驶 AI替代的硬件

AI 最新突破集锦 AI的瓶颈和进展 AI控制核聚变 AI预测蛋白质3D结构 Alpha Fold2 AI证明数学公式 自动驾驶 AI替代的硬件