Spark2x on yarn日志配置详解

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark2x on yarn日志配置详解相关的知识,希望对你有一定的参考价值。

参考技术A Spark on Yarn的日志配置分为两类:接下为大家逐一介绍。

在client模式下,Spark分为三部分,分别是

driver,application master以及executor,这种模式通常使用在测试环境中。

基于以上的讲解,来看一下其日志的配置:

在cluster模式下,Spark分为两部分,分别是

driver和executor,通常应用在生产环境。

基于以上的讲解,来看一下其日志的配置:

在client模式下,driver日志配置模板为:

这里使用控制台输出可以在driver更加方便的查看日志。

其它日志配置

这里建议使用appender,从而防止日志过大把磁盘撑爆。

Spark on YARN配置日志Web UI

本文转载自FlyingMcdull,点击底部获取原文。

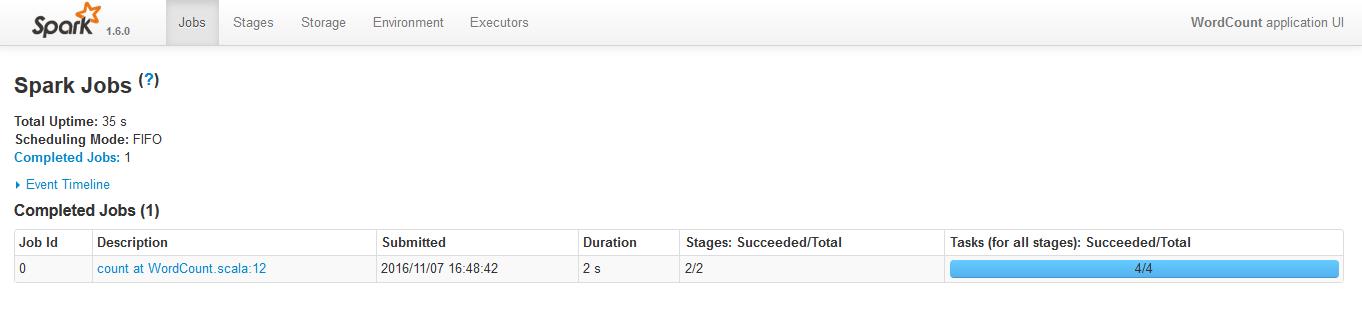

Spark部署在YARN之后,从Standalone模式下的Spark Web UI直接无法看到执行过的application日志,不利于性能分析。本文记录如何配置history UI。

修改spark-defaults.conf

修改$SPARK_HOME/conf/spark-default.conf

spark.eventLog.enabled true

spark.eventLog.compress true

spark.eventLog.dir file:///home/path/to/eventLog

spark.yarn.historyServer.address master:18080

这样点击History就可以跳转到Spark的Web UI查看相应的日志

修改sparn-env.sh

export SPARK_HISTORY_OPTS="-Dspark.history.ui.port=18080 -Dspark.history.retainedApplications=3 -Dspark.history.fs.logDirectory=file:///home/path/to/eventLog"

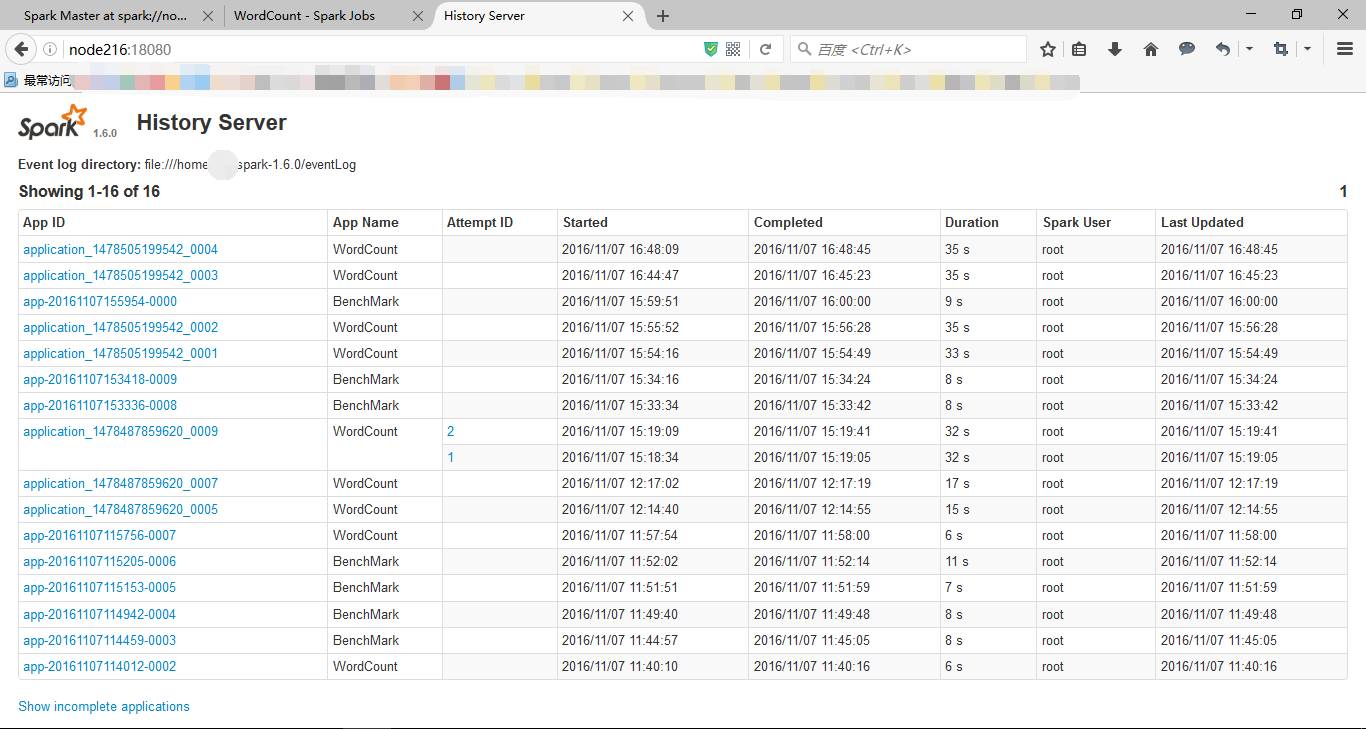

ui.port端口号需要和spark-defaults.conf保持一致,retainedApplications表示在historyServer上显示的最大application数量,如果超过这个数量,旧的application信息将会删除。fs.logDirectory日志目录和spark-defaults.conf保持一致。

启动Spark History Server

在spark目录下

./sbin/start-history-server.sh

成功后,打开http://master:18080,就可以看到相应的日志记录列表,进去之后也可以转到Spark Web UI上。

【长按识别立即关注】

品读之后,愿有所获。

以上是关于Spark2x on yarn日志配置详解的主要内容,如果未能解决你的问题,请参考以下文章

Hadoop入门——配置历史服务器及日志的聚集(图文详解步骤2021)